どの企業にも「隠れビッグデータ」は必ずある、CTCとシスコが提供する現実解とは

多くの国内企業において、ビッグデータに関する認識は高まり、焦点は「具体的に何をどうするのか」に移ってきた。そうした時期にタイミング良く、CTCがCisco UCSを採用した「ビッグデータパッケージ」の提供を開始した。CTCは自社の検証施設で自らが体験してきたCisco UCSの使い勝手を生かし、ユーザー企業がデータ活用に専念できるような環境を提供しようとしている。

伊藤忠テクノソリューションズ(CTC)を、いまだにITインフラのインテグレーションを提供する企業だと思っている人がいるかもしれない。それは間違いではないが、金融業や製造業などの業種に特化したソリューションや、コンタクトセンター、マーケティング支援などの業務別ソリューションも、インフラ同様に長年にわたって提供してきた。

データウエアハウスおよびBI(Business Intelligence)に関しても、顧客企業それぞれの状況やニーズを踏まえ、「だれが」「どんな情報を」「どのように」活用するのが最適解なのか、そのためにはどういった製品をどういう構成で組み合わせ、どのように設定して使えばいいのかを、包括的に提案し、数多くの実績を築き上げてきた。CTCの最大の強みは、顧客それぞれに合ったソリューションを、マルチベンダーで提案できることにある。

日々接する顧客の間では、2014年以来Hadoopへの関心が急速に高まってきた。CTCはこれを受けて、シスコのビッグデータソリューションを採用、両社の共同サポートによるビッグデータパッケージの提供を開始した。

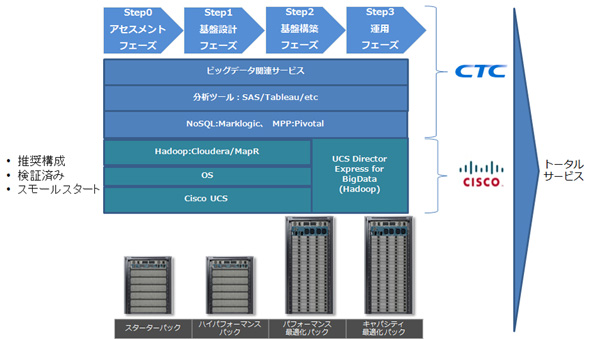

このビッグデータパッケージは、シスコが2015年4月に発表したビッグデータソリューションに基づいている。シスコは、インテルXeon®プロセッサーを搭載した同社のサーバー、「Cisco Unified Computing System(Cisco UCS)」を、Cloudera、Hortonworks、MapRの、3つの商用Hadoopディストリビューションと組み合わせた事前検証を実施。これに基づいて推奨構成を公開している。また、Cisco UCSの管理ツールである「Cisco UCS Director」をHadoopのために最適化した「Cisco UCS Director Express for Big Data」を提供、Hadoopクラスタの管理を、サーバーの管理と一括して行えるようにしている。

これらに加え、シスコはCloudera、Hortonworks、MapRとの再販契約を締結。顧客の導入前の実証作業(PoC)から、導入後の技術サポートまで、積極的に関与できる体制を築いている。

CTCは同社のビッグデータパッケージで、Cisco UCS+Hadoopディストリビューションに、NoSQLやMPPデータベース、さらにはSASやTableau Softwareなどの解析ツール/BIツールなどを顧客のニーズに応じて組み合わせた環境を構築、さらに関連サービスを提供する。

CTCはなぜ、ビッグデータでシスコと組むのか

CTCがビッグデータでシスコと組み、ビッグデータパッケージを提供する理由について、CTC 製品・保守事業推進本部 ITインフラ技術推進第2部 ビッグデータ基盤技術推進課の瓜田幸代氏は、次のように語る。

「ビッグデータは従来のデータウエアハウスにも増して、分析対象となるデータがどのように増加するかが読みにくいという特性があります。このためお客様は往々にして、サイジングやキャパシティプランニングの部分での壁に、まず直面します。しかし私たちは、お客様が『ビジネスに直結するデータ分析のやり方とは何か』に集中できるようにしたいと考えています。Cisco UCSは、スモールスタートした後、ニーズに応じて台数を増やすことが容易ですし、大規模になっても運用が楽です。ビッグデータのようなスケールアウト環境を必要とする用途に特に適していることから、シスコとの相互協力で、このパッケージを開発しました」

ビッグデータは「今、そこにある」

「ビッグデータ」というと、「まずデータを集めなければ」という発想になりがちだが、Hadoopは、既存のデータの管理にも大きな効果を発揮する。瓜田氏が、今回のビッグデータパッケージの重要な用途の一つと考えているのは、データウエアハウスの「オフローディング」だ。

これは、データウエアハウス専用アプライアンスで管理されてきたデータの一部を、Hadoopに移行することを指す。例えばデータ量の増大で、高額なデータウエアハウス専用アプライアンスを追加調達しなければならなくなったなら、その代わりに、直近のデータだけをデータウエアハウス専用アプライアンスに残し、それ以前のデータはHadoopに移行することで、コスト効率を大幅に向上できる。データベース専用アプライアンスのリプレースの時期は、Hadoop移行を考える大きなきっかけになる。従来のデータウエアハウスのデータ管理にHadoopを生かすことで、コスト低減を図りながら、Hadoop運用のノウハウを蓄積することが可能だ。

瓜田氏は、データウエアハウス専用アプライアンスで管理されてきたデータ以外にも、社内に「隠れたビッグデータ」が存在することは多いと指摘する。例えば過去のデータをテープに保存し、データセンターに保管しているが、これを活用するために、担当者がその都度データセンターへの入館申請を行わねばならず、時間と労力のロスが発生しているケースがあるという。

さらに多くの企業では、情報が業務システム単位で個別に管理され、サイロ化されている。本来ならば、これらを統合的に活用できる基盤を構築することで、価値が生まれるケースが多い。ただでさえ、情報システム部の担当者は事業部からの大量のレポート作成のためのデータ抽出依頼を抱え、これに応えるために時間が掛かり過ぎて、負荷が高くなる事例が、あちらこちらで発生している。Hadoopで各種のデータを管理して、これを情報システム部などのデータ分析担当者のみならず、事業部側の一部が直接活用するデータ分析基盤として機能させられる可能性は、多くの企業にある。

1年以上前は、Hadoopがオープンソース・ソフトウエアであることから、そのメリットは理解していても、採用には二の足を踏む企業が多かった。だが、2014年に商用ディストリビューション各社の国内体制が整い、さらにCTCやシスコなどの企業向けソリューション提供企業が力を入れるようになったことで、一般企業における導入ハードルは、大きく低減した。

CTCがいち早く立ち上げたビッグデータ検証施設の中身

CTCがビッグデータに早くから力を入れてきた証拠の一つに、「Big Data Processing Lab(BPL)」がある、これは、CTCの総合検証施設「テクニカルソリューションセンター(TSC)」内に設置された、ビジネスアナリティクス関連の検証に特化した施設だ。TSCでの年間の案件検証は約1200件、製品検証は約1000件に上るという。

BPLは2012年に開設された。これに関わったCTC 製品・保守事業推進本部 テクニカルソリューションセンター TSC企画課 主任 日野ひとみ氏は、当時社内でも、「ビッグデータ」の取組みを始めていたが、手探りの状況であったという。だが、このBPLの重要性が理解される日が必ず来ると考え、企画を強く推進したと話す。

BPLでは、Hadoopクラスタを展開し、これを基盤とした各種製品の製品検証および導入検証を行ってきた。これまで一般的なIAサーバーを利用してきたが、最近ではCisco UCSの比重が高まっているという。

日野氏によると、当初は「Hadoopといえばディスク容量」と考え、大容量ディスクを搭載した一般的なIAサーバーをインフラとして構築・運用した。だが、実際に運用して各種の検証を重ねているうちに、ネットワークの安定稼働と性能の重要性が、明確に認識されるようになってきたという。

そこでBPLのネットワーク環境に、シスコのスイッチを採用し、活用してきた。その後、ビッグデータでCisco UCSを推進できないかという話が持ち上がり、「運用管理が楽ならネットワークとサーバーを揃えるのが提案で有利かもしれない」という理由でCisco UCS と各種分析ツールでの検証を行った。

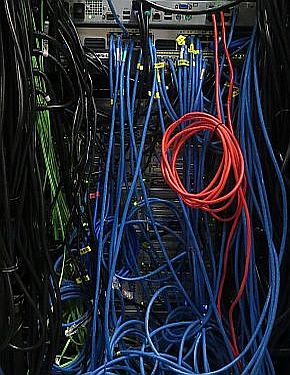

検証の結果、一般的なサーバーとの違いがよく分かったという。Cisco UCSは、下の写真で分かるように、配線が非常にシンプルだ。このことが端的に示しているように、Cisco UCSでは、MAC/IPアドレスからBIOSのバージョンまで、多様なサーバー関連の設定を、「サービスプロファイル」というファイルで管理。これを多数のサーバーに、一度に設定できる。いったん構築したサーバーファームに、さらにサーバーを追加する場合にも、同一のサービスプロファイルを適用すればいい。

左がCisco UCSの背面写真。電源ケーブル以外のケーブリングは非常にシンプルで、すっきりしている。右は一般的なIAサーバーの背面。ネットワークケーブルがスパゲッティ状態になっていることがよく分かる

左がCisco UCSの背面写真。電源ケーブル以外のケーブリングは非常にシンプルで、すっきりしている。右は一般的なIAサーバーの背面。ネットワークケーブルがスパゲッティ状態になっていることがよく分かるこうした機能は、一般企業でも便利だろうが、BPLのように多数の検証を日常的に実施しているところでは、メリットが特に際立ってくる。サーバーの台数を次々に変えて検証する作業も、一つの検証を終えて別の検証に移る際の環境の再構築も、短時間で済ませられるからだ。

BPLは現在、関連サービスを含めると、計8ラックの規模で運営されている。この検証施設の最大の特徴は、Hadoop、ETL、データウエアハウス、BIツールなど、企業がビッグデータで必要とする全てのコンポーネントを、まとめて検証できることにある。

もう一つの特徴は、リモートアクセスで検証ができること。BPLは東京にあるが、他の都市のユーザー企業でも、東京のユーザー企業と同じように遠隔操作で作業が行える。東京のユーザー企業でも、検証施設に缶詰めになることなく、オフィスから検証の状況をモニターでき、効率がいい。

CTCでは、2015年度になってビッグデータ案件が急増しており、BPLの稼働率は8割を超えているという。日野氏は、Cisco UCSを使ったビッグデータパッケージができたことで、BPLで検証したものと同一の構成を、顧客に納入できるようになったことの意味は大きいと話している。

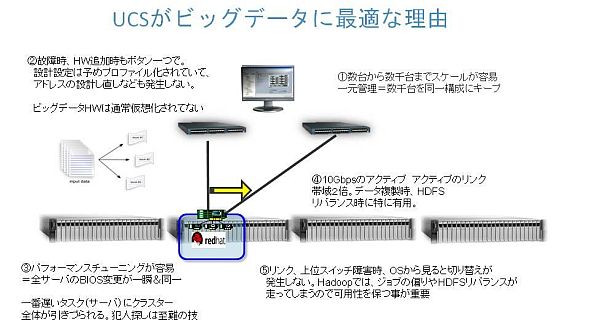

UCSがビッグデータに最適な理由

Cisco UCSは、HadoopやNoSQLデータベースなどのスケールアウト型ソフトウエアを使うのに最適なサーバー製品だ。

前述のように、サーバーの各種設定はサービスプロファイルを適用するだけでいいので、サーバーの故障時の入れ替えや、後からの追加は簡単だ。このため、ビッグデータへの取り組みを小規模で始め、メリットが明確化した段階で基盤を拡張するといったこともできる。予想に反して利用規模が拡大した場合にも、無駄なく即座に対応できる。

また、Cisco UCSでは、各サーバーから上位スイッチに対して、10Gbpsのリンクをアクティブ―アクティブで張れる。つまり、Hadoopノードと上位スイッチ(および他のサーバー)との接続は、20Gbpsということになる。こうした潤沢な帯域幅は、データ複製やHDFSにおけるデータ平準化機能の実行時に、大きな効果をもたらす。

上位スイッチのうち1台に障害が発生した場合も、OSやアプリケーションに認識されるような通信断は発生しない。これは、例えば上述のHDFSによるデータ平準化機能が無駄に働いて性能を下げる結果になることを防ぐという点で、現実の運用では重要な意味を持つ。

CTCは、こうしたCisco UCSの特徴を生かし、顧客がビッグデータで「何をアウトプットとし、これを出すために何をすべきか」を考えることに専念できるようにしたいという。そして同社は、自らの提供する幅広い選択肢とこれまでに蓄積したノウハウを通じ、顧客が最短距離で取り組みを進められるように支援していきたいという。

なお、シスコでは期間限定で、上記のような特徴にあふれるサーバー製品、Cisco UCSを特別価格で提供する「SmartPlay Select」というキャンペーンを実施している。詳しくは「もはやサーバーの新標準、Cisco UCSがさらに買いやすくなってどうしよう?」をお読みいただきたい。

Copyright © ITmedia, Inc. All Rights Reserved.

提供:シスコシステムズ合同会社

アイティメディア営業企画/制作:@IT 編集部/掲載内容有効期限:2015年11月4日