GPU不要? インテルの最新Xeon 6で進化する、CPUのAI処理能力:5年で最大14倍の性能向上

AI技術の急速な発展を受けて、ユーザー企業が自社のビジネスにAIを活用する動きが加速している。それに伴いAIワークロードは急増し、企業にコストや運用の負荷が掛かっている。その解決策が、インテルの最新プロセッサ「インテル® Xeon® 6 プロセッサー」Pコア搭載モデルだ。

AI(人工知能)技術が急速な発展を遂げたことで、AIワークロード(AI技術を組み込んだシステムや関連タスク)が急増し、それを処理するためのインフラ整備も急ピッチで進められている。

その中心となっているのは、AIワークロード処理に特化した専用アクセラレータとしての性格を強めているGPUだ。しかし現時点では、GPUの導入には膨大なリソースが必要となる。AI用のプロセッサとして位置付けられるGPUのハイエンドモデルは、消費電力が1000ワットを超え、価格は数百万円以上かかるなど、かつてのPC用グラフィックボードとは比較にならないほど高性能かつ高価なシステムになっている。給電能力はもちろん、性能を最大限引き出すには水冷方式で冷却しなければならず、運用には専用のファシリティが必要になるため既存のデータセンターへの導入障壁は高い。

一方、大半のユーザー企業が求めているのは、独自LLM(大規模言語モデル)の開発ができるような大掛かりな開発環境ではない。社内データを利用してカスタマイズしたAIモデルを使うといった、比較的小規模なAIワークロードが中心だ。そこでGPUではなくCPUでAIを処理したいというニーズが高まっている。このニーズに応えるため、インテルは新世代のサーバ向けプロセッサ「インテル® Xeon® 6 プロセッサー」(以下、Xeon® 6)のPコア搭載モデルを発表した。

最新世代 Xeon® 6 プロセッサーとは何か

インテルはXeon® 6で新しい製品戦略を展開している。同一世代で、演算性能を重視したPコア(Performance-cores)と電力効率を高めたEコア(Efficient-cores)の2種類を用意して、幅広いワークロードを最適化するというものだ。

現在のプロセッサにはワークロードに応じた最適化の必要性が高まっているが、Xeon® 6はワークロードの特性に応じて異なるコアを使い分ける形で適用範囲を広げている。

先行して市場に投入されたEコア搭載モデルは電力効率を追求した設計で、軽い負荷の処理が大量に発生するクラウドコンピューティング向けに位置づけられる。新たに発売されたPコアは、前世代の第5世代 インテル® Xeon® スケーラブル・プロセッサーの直接的な後継であり、「生成AI」などのAIワークロードやハイパフォーマンスコンピューティング(HPC)分野など、高い演算処理性能が求められる用途に最適化している。

利用できるワークロードの幅を広げるため、Xeon® 6はPコア搭載モデルとEコア搭載モデルのそれぞれに、「6700シリーズ」と「6900シリーズ」の2種類のラインアップを用意した。違いは、プロセッサの物理的なサイズと最大消費電力量だ。EコアとPコアのプラットフォームは共通化しているため、同じマザーボードやBIOSを使用してプロセッサだけを差し替えることが可能だ。これはハードウェアベンダーの負担軽減につながり、エンドユーザーにとってもコスト低減や納期短縮といったメリットにつながるものと期待できる。

実は、AIワークロード処理に使われるGPUサーバでも、その多くはホストCPUとしてXeon®シリーズが使われている。システムの根幹を支えるデータ転送性能や信頼性、可用性、保守性といった運用メリットまで、その実力はユーザーに高く評価、信頼され、市場で多く導入されている。

Pコアが企業のAI活用を変える

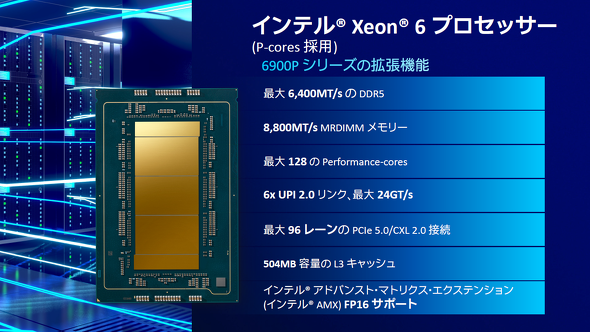

Xeon® 6 Pコア搭載モデルの主な特徴は以下の通りだ。

- 最大128コア構成

- 6x UPI 2.0リンク、最大24GT/sの転送レート

- 最大6400MT/secのDDR5メモリ(12チャネル)

- 最大8800MT/secのMRDIMM(マルチプレックスランクDIMM)メモリ(12チャネル)

- 最大96レーンのPCIe 5.0/CXL 2.0(Type 1,2,3に対応)

- 504MBのL3キャッシュを搭載

- 「インテル® AMX」(Advanced Matrix Extensions)で半精度浮動小数FP16をサポート

インテル IA技術本部 部長の渡邉恭助氏は「前世代の第5世代 インテル® Xeon® スケーラブル・プロセッサーは最大64コアまでだったため、コア数が倍になっています。コア自体の性能も上がっており、パフォーマンスが大幅に向上しました」と紹介する。特に、複数のランクに同時アクセスすることでアクセス効率、性能を高めたMRDIMMメモリは業界でもいち早く実装しており、大量のデータ転送が発生するAIワークロードを効率的に処理する。

インテル® AMXはAIワークロード処理のために搭載した、CPU内蔵のハードウェアアクセラレータだ。各コアの内部に実装されており、コア数が前世代モデルから倍増したことでAMXの処理能力も倍増した。Pコア搭載のAMXはFP16に対応しているため、より幅広い種類のAI演算を効率的に処理できるようになった。

通常、AMXのような最新のハードウェア機能を活用するには、プログラムコードにAMXを利用するように記述するなどソフトウェア側での対応が不可欠だ。しかしXeon® 6は基本的にユーザー企業がいちいちコードを修正する必要はない。

「Xeon® 6は『PyTorch』や『TensorFlow』といった基本的な機械学習用のライブラリがあらかじめ最適化されているため、特に操作せずともこれらを用いたAIワークロードを効率的に処理できます」

最適化されていないライブラリを利用する場合でも、インテルが提供する「oneAPI」というクロスアーキテクチャプログラミング環境を利用することで、コードを大幅に修正することなくAMXを利用可能だ。

oneAPIで利用できる「インテル oneAPI AIアナリティクス・ツールキット」経由でAMX向けに最適化されたライブラリを無料で利用できる。このライブラリはコーディングの知識がない担当者であっても、数ステップの操作でインストールできるようになっている。

渡邉氏は「インテル製CPUでAIワークロードを処理する際、AMXを利用するだけで処理性能が2倍以上向上することもあります」と紹介する。

前世代と第6世代Xeon®でパフォーマンスを比較した結果

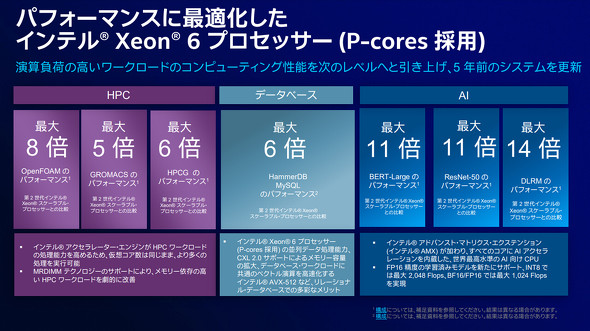

インテルはXeon® 6のPコアのパフォーマンスを、2019年に発表された「第2世代インテル® Xeon® スケーラブル・プロセッサー」と比較している。

ベンチマークテストの結果を見ると、主要なワークロードで5倍、最大で14倍という性能向上を果たしている。HPCやデータベースといった従来型のワークロードに関しては5〜8倍の値だが、AMXの効果が発揮されるAI関連ワークロードは11〜14倍と大幅に伸びていることが分かる。

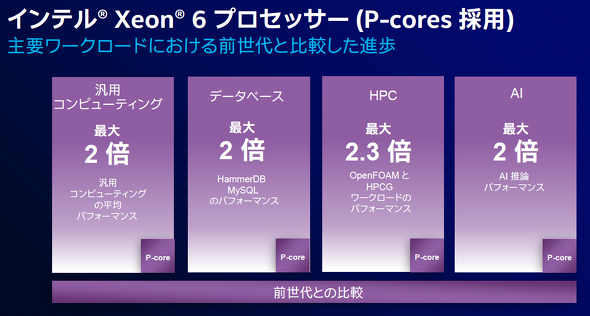

さらに前世代の第5世代 インテル® Xeon® スケーラブル・プロセッサーとも処理性能を比較しており、主要ワークロードにおけるAI推論のパフォーマンスは最大で2倍になっている。

AIワークロードに関しては、「CPU対GPU」といったキャッチーな対立構造に基づいてGPUばかりに注目する傾向があるが、実はGPUもCPUもそれぞれに進化を続けているのが実態だ。GPUはかつてのスーパーコンピュータ以上の先鋭的なシステムになっている一方で、CPUもAIアクセラレータを内蔵する形で大幅なパフォーマンスアップを果たしている。CPUかGPUかが問題なのではなく、自社の用途に見合った性能を達成できるシステムはどのようなものなのかを見極め、適切な選択肢を選び取ることが重要だ。

「実際にユーザーの方々とお話しすると、AIを活用して業務を自動化したいけれどもGPUは価格や電力消費、入手しにくいことなどが懸念となって手を出せないという声をよく聞きます。最近のCPUはさまざまなAIワークロードを処理できることを知ってもらいたいですね」と渡邉氏は話す。

Xeon® 6のPコア搭載モデルは、AIワークロードに対応する高速化機能が盛り込まれた結果、一般企業の利用の中心となるような軽いワークロードに関しては十分な性能を発揮する。

消費電力量が低く抑えられるため、カーボンフットプリントの削減といった、SDGsの達成をはじめとした社会的責任を果たす上でも有利になると考えられる。もちろん、ベースとしてXeon® 6を活用した上で、さらにGPUを組み合わせて処理能力向上を図ることもできる。同じタイミングでインテルが発表したAIアクセラレータ「Gaudi 3」と組み合わせて、高効率かつハイパフォーマンスのAIワークロード処理を実現することも可能だ。

企業におけるAI活用は急速なブームとなっているが、実際にどのような効果が見込めるか、実績を踏まえてベストなコスト効率を見極めるためにはもう少し時間が必要だろう。今後の状況の変化に合わせて柔軟に対応できるようにするためにも、既存のインフラで無理なく運用でき、十分な処理性能を得られるXeon® 6が現時点で有力な選択肢の一つであることは間違いない。

関連リンク

- Pコア(Performance-cores)搭載インテル® Xeon® 6 プロセッサー

- インテル® Xeon® プロセッサーとは?

- インテル発行のメールニュース「Bit Feed」(毎月配信)

ぜひBit Feedに登録して、インテルからの最新情報をご確認ください。

Copyright © ITmedia, Inc. All Rights Reserved.

提供:インテル株式会社

アイティメディア営業企画/制作:@IT 編集部/掲載内容有効期限:2024年12月16日

インテル 渡邉恭助氏

インテル 渡邉恭助氏