従来のバッチでは難しいリアルタイムデータ処理が「効率化の先」にもたらすもの――その基盤の在り方とは:データの品質と鮮度はAI、ビジネスにも影響

ビジネス環境の変化が激しい今、データ活用にも「リアルタイム性」が重視される一方で、その基盤を構築できていない企業は多い。そもそも“新鮮な”データはどういった用途だとビジネス価値向上につながるのか、従来のバッチ処理だけでは具体的に何が問題になるのか。またリアルタイム処理のための基盤にはどのような機能が必要なのか、その基盤にはどのような効能があるのか、リアルタイムデータ処理に詳しい有識者に聞いた。

社会全体でデジタル化が進み、ビジネスがITを通じて展開されている。多くの企業がデータを活用してビジネス価値を向上させており、データ活用が競争力を大きく左右する。だが、データはありさえすれば、どのようなものでもよいわけではない。ビジネス環境の変化が激しい今、新たに重視されるのはデータの「リアルタイム性」や「鮮度」だ。

リアルタイムデータを活用したビジネスの成功例は、数多く存在する。米国の大手小売りチェーンはオムニチャネル戦略の一環として、オンラインで注文された商品を最寄りの店舗から配送するサービスを開始した。しかし当時は定期的なバッチ処理でデータを活用しており、「オンラインでは在庫があるのに、実は店舗に在庫がない」といった問題が頻発。顧客に約束した配送時間を守れない事態が続いた。この問題を解決したのがリアルタイムデータも重視した在庫管理システムだった。ECサイトと店舗の情報を常に同期することで、正確な在庫情報を提供できるようになった。

サイバーセキュリティの現場でも、リアルタイムなデータを基にした迅速な対応が期待されている。例えばSIEM(Security Information and Event Management)は、ログデータをリアルタイムに分析できることが望ましい。しかしクラウド化や分散化が進んだ現在はセキュリティログが膨大になり、分析のパフォーマンスや精度が劣化して、対応コストも増大している。分析対象に応じてリアルタイムかつ適切にデータをSIEMに提供できる仕組みが必要だ。

リアルタイムデータプラットフォームを提供するConfluent Japanの清水亮夫氏は次のように語る。「特にモバイルアプリケーションの普及により、利用者はリアルタイムでのデータ反映を“当たり前”と捉えるようになりました。最新のデータが反映されるまでに1日かかるようなシステムでは不満を感じます。これは消費者だけでなく、企業で働く従業員も同様です」

消費者として最新のサービスを体験している従業員が、社内では旧態依然のシステムに甘んじるのは矛盾している。企業のITにも同様のリアルタイム性を期待して、より良く働きたい、生産性を向上させたいと考えるのは当然だ。「データの鮮度」は、もはやビジネス価値を向上させる重要な要素になったと捉えてよいだろう。

従来のバッチ処理やサイロ化された基盤が引き起こすデータ活用の課題

一方で、データのリアルタイム活用ができていない企業は多い。要因の一つは、既存システムでデータ処理の主流となっている「バッチ処理」にある。

バッチ処理とは、一定期間データを蓄積し、使うために必要な処理を決められた時間に一括で施す手法だ。夜間や早朝などに1日分のデータをまとめて分析処理してレポートを生成するなど、長年にわたって企業のシステムを支えてきた。

スピードがビジネスに不可欠な現代において、バッチ処理だけでは大きな課題が顕在化する。データの鮮度が落ちてしまう「劣化」の問題は、特に複数のバッチ処理が連鎖する「バッチチェーン」などで顕著に表れる。

あるカード会社の例を見てみよう。顧客がオンラインでクレジットカードの発行を申請すると、与信審査や本人確認、ブランドサービス、印刷、配送といった複数の工程を経る。バッチ処理は、各工程でデータをいったん蓄積し、決まった時間に処理して次の工程へ送る。つまり、朝の発行申請は夜間バッチを経て翌日の工程、また次の工程と繰り返し、最終的なカード発行までに顧客の期待以上の時間がかかる。

企業のデータ活用において、データ基盤のサイロ化も大きな問題だ。従来は部門ごとにデータ資産がサイロ化し、そのビジネス価値は閉じ込められる状態となる。システム間をポイントツーポイントで接続し、必要に応じてデータをやりとりする設計が一般的だった。

「データ資産をどんどんつなげたいというビジネスニーズに応えて、従来の仕組みのままでクラウドサービスとの連携を進めると、メンテナンスしきれないぐらい複雑になってしまいます。結果として、データの一貫性やガバナンスの確保を困難にし、何が新鮮で信頼できるデータかが分からなくなってしまうのです」

こうしたデータ品質の問題は、今後AI(人工知能)の活用が本格化する上で、より深刻な問題になり得る。AIシステムは、学習データや推論時に投入するデータの品質がアウトプットの信頼性を左右するからだ。

この点を象徴する事例が、カナダの航空会社で発生した。同社のAIチャットbotが顧客に誤った情報を提供し、最終的に法廷で企業側の責任が認められたのだ。「AIチャットbotでも従業員と同等の責任を負うべきだ」とされ、企業に損害賠償が命じられた。

清水氏は、この事例の教訓を次のように語る。「古いデータや品質の低いデータを基にしたままでは、AIは精度の高い回答はできません。データの品質と鮮度はAIサービスの精度、それを提供する企業の信頼性に直結します」

日本企業のチャットbotの機能は、こうしたリスクを恐れるあまり旧世代の単純な応答型FAQにとどまってしまうケースが散見される。企業がデータをビジネスの競争力の源泉とするには、根本的な発想転換が求められる。

データの一貫性と品質、そして鮮度を保つためのデータ基盤とは

こうしたデータ管理、活用の課題を根本から解決する考え方が「データストリーミング」だ。これは従来の「データをためてから、後で使う」という発想から「データを流しながら、今使う」発想への転換を意味する。

データストリーミングは、データが生成された瞬間にそれを1件ずつ処理し、リアルタイムに後続のシステムに流す。カード発行の例は、顧客が申し込みボタンを押した瞬間に与信審査が開始され、その結果を受けて即座に次の本人確認プロセスが実行される。各工程でデータをため込むことなく、ストリーミングで一連の処理が完了する。

清水氏はこの違いについて、「従来のバッチ処理が『船で大量の荷物を一度に運ぶ』ようなものだとすれば、データストリーミングは『パイプラインで荷物を次々に送り続ける』イメージです。一件一件をリアルタイムで処理するので、遅延はほとんど発生しません。Confluentのデータストリーミングプラットフォームを導入したカード会社は、ごく短時間で印刷や発行までできるようになり、顧客が待つ時間は少なくなりました」と説明する。

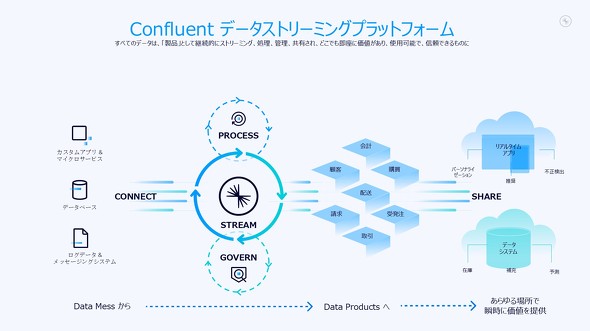

Confluentのデータストリーミングプラットフォームは、4つの核となる機能で構成されている。データを流れとして捉える「ストリーム」、さまざまなシステムとの接続を統一管理する「コネクト」、利用目的に応じてデータを変換する「プロセス」、データの一貫性と品質、セキュリティを管理する「ガバナンス」だ。

これらの機能により、複雑なポイントツーポイント接続を解消し、1つのデータソースから複数の用途に最適化したデータを迅速に生成できる。同じ顧客行動データでも、分析用にはエンリッチされた詳細なデータを、機械学習用には特定属性を抽出、加工した最適なデータを、それぞれリアルタイムで提供する。

Confluentの製品には、オンプレミスの「Confluent Platform」とクラウドサービスの「Confluent Cloud」が用意されており、環境や用途に合わせて自由に組み合わせるハイブリッド構成にも対応する。機密性の高い基幹データはオンプレミスで処理し、加工済みの安全なデータのみをクラウド分析プラットフォームにリアルタイムで送信するといった柔軟な運用が可能だ。データサイロの解消にも貢献できる。

Confluent製品の大きな特長は、「Apache Kafka」「Apache Flink」といったオープンソース技術をベースとしている点にもある。オープンソースなので多様なユースケースの知見やノウハウが蓄積されており、ユーザー企業はベンダーロックインのリスクなく、最新技術のメリットを享受できる。データストリーミングプラットフォームのKafkaの技術開発で中心的な役割を果たしているConfluentは、その市場をけん引してきたと言えるだろう。

データを“ためる”から“流す”へ――「効率化の先」に進むために

データストリーミングプラットフォームの価値は、生成AI時代の本格到来とともにさらに高まっている。Confluentは現在、AI技術との連携強化に積極的だ。

リアルタイムで流れるデータをLLM(大規模言語モデル)に送り、出力結果をすぐさま次のシステムに流すといった仕組みは、既に構築している。この技術を用いれば、顧客からのアンケート回答をリアルタイムで感情分析し、ネガティブな反応を即座に検知して担当部門に報告するといった応用が可能だ。エージェンティックAI分野での新製品も発表しており、Confluentのデータストリーミング技術と最先端のAI技術とのさらなる融合が期待できる。

「日本企業はデータの蓄積は得意ですが、それを活用しきれていないケースが多かったのではないでしょうか。データストリーミングプラットフォームを活用することで、蓄積したデータを迅速にビジネス価値につなげられます。特にAI活用を推進して高い効果を得たいのであれば、鮮度と信頼性の高いデータを供給できる仕組みは必須です。

“ためる”から“流す”への変革は、単なる技術改善や効率化ではなく、データ活用における根本的な発想転換を促します。プロセスの変革や新たなビジネスモデルの確立に成功した企業は増えていますし、新鮮なデータで生成AIを精度高く活用できれば、そのような企業はもっと増えるのではないでしょうか」

関連記事

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

提供:Confluent Japan合同会社

アイティメディア営業企画/制作:@IT 編集部/掲載内容有効期限:2025年11月11日

Confluent Japanの清水亮夫氏(シニア ソリューションズ エンジニア)

Confluent Japanの清水亮夫氏(シニア ソリューションズ エンジニア)

「大規模なAIエージェント」の課題解決を支援する「Streaming Agents」を提供開始

「大規模なAIエージェント」の課題解決を支援する「Streaming Agents」を提供開始