「ビジネスの改善フィードバックループを作るには“分析の共有基盤”が不可欠」、米HP:分析プラットフォーム「Haven」が示唆する有効な分析体制の作り方

“ビッグデータ活用”という言葉がここ数年で企業、社会に浸透するとともに、そのためのテクノロジも着実に進展している。だが成功事例はいまだ多いとは言えないのが現実だ。分析を収益・ブランド向上に変えるための一つのアプローチを米HPに聞いた。

2011年ごろから注目を集めている「ビッグデータ」活用。ここ数年で企業の取り組みと、それを支えるテクノロジが共に進展し、国内でもさまざな成功事例が生まれつつある。ただ、社内外に散在する多様なフォーマットのデータをどう一元的に分析するか、分析結果からいかに意味を読み取り価値につなげるか、という点ではいまだ課題が多いのが現実だ。

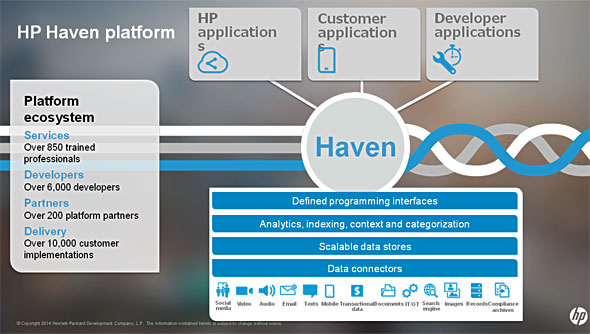

こうした問題に複数のベンダーが対応している中、日本ヒューレット・パッカード(以下、日本HP)も2013年にビッグデータ分析のための統合プラットフォーム「HP Haven」(以下、Haven)を発表している。Havenは、オープンソースの「Hadoop/HDFS」、非構造化データ分析の「Autonomy IDOL」、カラム型DBの「Vertica」、イベントやログ分析のArcSightを中心とした「Enterprise Security」、アプリケーション群「nApps」の頭文字を組み合わせたもの。多数のコネクターにより700以上のデータソースにアクセスできることを特徴とし、さまざまなシステムから収集したあらゆるフォーマットのデータを統合的に分析できるプラットフォーム製品となっている。

米HPによると、このHavenも発表から2年余り経った現在、さまざまな領域への適用が進んでいるという。米HPでビッグデータ、クラウド、セキュリティ・ソリューションの市場開発担当を務め、多数の事例を知る米HPソフトウェア マーケットリサーチ&ディベロップメント シニアディレクターのルイス・カー(Lewis Carr)氏に、ビッグデータ分析の現状と採るべき対策を聞いた。

課題は古いデータと新しいデータの橋渡し

編集部 日本においてもビッグデータ分析が大きなトレンドになり数年が経ちました。この間、欧米においてはどのような変化があったと見ていますか?

Carr氏 変化のスピードは、業界や業種、企業によってさまざまです。大手プロバイダーや小売りなど、ソリューションの導入が利益に直結しているような業界はスピードが速い。一方、政府官公庁のようにシステムの安定稼働を優先する業界は相対的にスピードが遅い。運用を合理化したりスリム化したりすることに重きを置く企業や業種より、「利益を出すこと」を重視する企業や業種の方が取り組みは早いようです。

例えば、10年前は存在しなかったような企業――ゲーム会社のZynga、ハイヤー配車のUber、SNSのFacebookなどは、ビッグデータの分析にとても積極的です。そもそも、これまでのデータ分析に関するDHWやBIツールなどの資産がなく、テクニカルな知見も持っていない。そのため、素早く大胆な対応がしやすい側面があるためだと思います。

編集部 データ分析に従来から取り組んできた企業はどう対応しようとしているのでしょうか。

Carr氏 大企業は大きく分けて2種類のITシステムを持っています。一つは、従来型のデータを扱う規模の大きいシステムです。例えば、ERPやCRMの分野で言うと、ピープルソフトやシーベルの製品などが該当します。もう一つは、新しいデータを扱うクラウドに対応したシステム。例えば、セールスフォース・ドットコムやワークデイなどの製品です。多くの企業は、このような古いアプリケーションを維持しながら、新しいアプリケーションへの移行に取り組んでいますが、これはなかなか難しい問題です。

ビッグデータでも同じことが起こっています。既存のDWHやデータマートを持ちつつ、Hadoopなどを使って新しいデータソースに対応していかなければなりません。「既存のデータセット」と「新しいデータセット」をどうブリッジするか――この課題に対応したのが弊社のプラットフォームであり、弊社ビジネスにとってのスイートスポットだとも考えています。

編集部 具体的にはどうブリッジしていくのですか?

Carr氏 そこがHavenの持つ優位性です。コネクターを使って、700以上のデータソースにアクセスすることができます。HadoopへのSQLアクセス、Rを使ったクエリ、テキストや動画といった非構造化データの分析、各種BIツールと連携するアプリケーション開発も可能です。

つまり、古いデータであれ、新しいデータであれ、収集から蓄積、加工、分析、利用までを一つのプラットフォーム上で統合的にサポートできるのです。これらは、非構造化データ分析ツールのAutonomy IDOL、カラム型DBのVerticaを組み合わせることで実現しています。

ビジネスとデータのフィードバックループを作る

編集部 そうしたシングルプラットフォーム上で分析を行いたいというニーズは、すでに多くの企業で強まっているのでしょうか?

Carr氏 まだ新しい動きといえるでしょう。というのも、ソーシャルデータなど、新しいタイプのデータが生成されてきたのがまだ最近だからです。また、これまではビジネスアナリストがデータ分析を行い、ビジネス部門にリポートを上げていればよかった。だが最近は、データアナリストやデータサイエンティストといった新しいスキルセットを持つ専門家が、ソーシャルデータやマシンデータを分析するようになっています。

ここで重要なのは、ビジネスの状況を元に分析のプランを作り、ビジネスにフィードバックできるようにすることです。データ分析とビジネス部門の協力関係はより強まり、いつでも質問し、いつでも答えを得て、アクションに結び付けられる環境が求められるようになっています。

シングルプラットフォームという全社共通の分析基盤で、あらゆる種類のデータを収集・蓄積・分析できれば、そうした部門間の協力関係も築きやすくなりますし、改善のフィードバックループもおのずと回しやすくなります。実際、ビッグデータを活用している企業の多くは、こうしたプラットフォームをうまく使いながら、ビジネスの現場と分析チームが協力関係を築き、新しいアクションを起こしているのです。

編集部 データのビジネスへのフィードバックという意味では、近年はビジネス部門の人間が個人レベルで簡単に使えるセルフサービスBIツールも注目されていますが。

Carr氏 クリックテックやタブローといったBIツールベンダーは、われわれにとって「可視化」の分野におけるパートナーです。可視化を十分に生かすためには、そのバックエンドにペタバイトレベルのデータを扱えるHavenのような分析プラットフォームが必要です。彼らが得意とするデータの可視化は彼らに任せ、われわれはデータを効率よく可視化できるようにするための「データの収集」「管理」「可視化のための分析」を担うという補完的な関係と考えています。

米軍撤退やスマートシティでの事例も

編集部 一方、ビッグデータ活用事例というと、マーケティング分野での購買データやソーシャルデータの分析、またシステム運用管理のログ分析などが最初に想起されますが、Havenの事例も増えつつあるのでしょうか?

Carr氏 そうですね。やはり目立つのはマーケティングや運用管理の事例です。例えば運用管理については、弊社も「HP Operations Analytics」としてソリューションを提供しています。運用管理のあらゆるデータを活用して、障害の根本原因を特定し、将来の運用パフォーマンスを改善できるよう支援するものです。構造化データか、非構造化データかを問わず、指標、イベント、トポロジ、ログファイルのデータを収集し、視覚的に表示できることが特徴です。

セキュリティについては、SIEM(Security Information and Event Management)と呼ばれるセキュリティ情報イベント管理にHavenを利用しています。具体的には、ログ収集ツール「HP ArcSight Logger」、脅威のリアルタイム分析ツール「HP ArcSight ESM」などです。もともとは、HPが開発したデータベースを使っていましたが、それをAutonomy IDOLやVerticaに置き換え、さまざまなマシンフィードから「どこに異常があるか」をリアルタイムに検知できるようにしています。

これらにとどまらないユニークな事例も出てきています。例えば、アフガニスタンからの米軍の撤退で使われたケースです。米国のオバマ大統領が2014年、アフガニスタンから米軍を撤退させることを発表した際、米HPが国防総省が利用するIT環境を提供していたこともあり、「どう安全かつ合理的に米軍を撤退することが望ましいか」のリスク分析を行ったのです。分析には、作戦内容や部隊の配置、兵たん、地理情報、気象情報など、ありとあらゆるデータが使われました。軍の各種データは、それぞれ特定のフォーマットを持ち、厳重に制限がかけられている上、非構造化データも数多くあります。それら多岐にわたるデータを統合して分析するためにHavenが用いられました。

もう一つは、ニュージーランドのオークランド交通局(Auckland Transport)の事例です。市内の幹線道路に2000台超のカメラを設置して、交通状況を監視しているのですが、交通量のデータを分析して、特定のイベント――例えば渋滞が起こるパターンを分析し、「何を優先的に行えば早期に渋滞解消ができるか」などを導き出そうとしています。このスマートシティの一環として行われている取り組みにもHavenが使われています。

共通のゴールに向けたアクションにつなげられる各部門の連携体制を

編集部 活用パターンは着実に広がっているのですね。ただこうした分析において常に指摘されるのは、分析結果を読み取り、そこから最終的に価値を引き出すのは人間だということです。実際、業務知識や現場の肌感覚など、数値化できない知見を持った人間でなければ読み取れない傾向もあると思うのですが。

Carr氏 そうですね。やはり何より重要なのはツールの機能だけに頼ってはいけないということだと考えます。分析によってチーム間の連携が進み、分析結果を有効なアクションにつなげられなければ意味がありません。このためには「関係するチーム間でどう情報を共有し、連携していくか」「さまざまなチームが持つデータのポートフォリオをどう統合していくか」を考えることが重要です。

そのためには組織の文化も変える必要があるかもしれません。ツールの導入だけではなく、外部のコンサルティング会社なども活用して、各部門が連携してビジネス課題を有効に解決できるような組織体制への変更も視野に入れるべきでしょう。

人材について言えば、全員がデータサイエンティストやデータアナリストになる必要はありませんが、現場のビジネス部門はそうしたスキルセットを持つ人材からの支援が必要です。単にデータを可視化するのではなく、「どのデータが、どういう意味を持つか」を読み取る力があって初めて可視化の価値が出てきます。

こうした取り組みに特効薬はありません。つまり、組織全体を見る人、あらゆる事象を分析する人、アプリケーションを作る人、“現場”を深く知っている業務部門の人、それぞれの連携とパートナーシップが重要なのです。そうした連携の実現、パートナーシップ構築のためのプラットフォームとなることがまさしくHavenの狙っているところです。

弊社としては、既存のデータセットも新しいタイプのデータセットも一元的に分析・共有できるこのオープンなプラットフォームの提案を通じて、有効なアクションを起こすための環境作りを支援していきたいと考えています。

Copyright © ITmedia, Inc. All Rights Reserved.