グーグルの機械学習/AIへの取り組みを支える「AIファーストデータセンター」とは:Google I/O 17で「Cloud TPU」を発表

米グーグルが開発者向けイベント「Google I/O 17」で、同社のコンシューマー向けサービスにAI/機械学習を広範に適用、これによってサービスプロダクトを相互に結び付け、システマチックに進化させていることをアピールした。その裏にはもちろん、TensorFlowとGoogle Cloud Platformがある。同社は機械学習処理を高速化する「Cloud TPU」、Androidデバイス上のAI処理のための「TensorFlow Lite」について、併せて紹介した。

米グーグルが開発者向けイベント「Google I/O 17」で、同社のコンシューマー向けサービスにAI/機械学習を広範に適用、これによってサービスプロダクトを相互に結び付け、システマチックに進化させていることをアピールした。その裏にはもちろん、TensorFlowとGoogle Cloud Platformがある。同社は機械学習処理を高速化する「Cloud TPU」、Androidデバイス上のAI処理のための「TensorFlow Lite」について、併せて紹介した。

2017年5月17日(米国時間)、「Google I/O 17」初日の基調講演で、Google CEOのSundar Pichai(スンダ―・ピチャイ)氏は「モバイルファースト」の後の流れとして「AIファースト」を推進しているとあらためて宣言。全てのサービスプロダクトでAIを活用し、それぞれのサービスを進化させていると述べた。

「モバイルファーストで、私たちは全てのプロダクトについて考え直すことになった。マルチタッチやロケーション、アイデンティティ、ペイメントなど、ユーザーとのやり取りの在り方が根本的に変化したことを考慮しなければならなくなった。同様に、AIファーストの世界では、全てのプロダクトについて再考し、機械学習とAIを適用してユーザーの問題を解決していくことになる」(Pichai氏)

基調講演では、実際に全てのサービスで、音声認識、画像認識など機械学習を生かした新機能が紹介された。

例えばパーソナルアシスタント機能付きスピーカーである「Google Home」では、人の声を聞き分ける機能が搭載されている。これによって、Google Homeに声を掛けた人のスケジュールを自動的に答えるなどが実現している。

「Google Lens」という技術では、画像認識から被写体を認識、文脈に基づいて適切な種類の情報を表示する。例えばスマートフォンのカメラを街のレストランの看板に向ければ、その店のレビューが示される。この技術はGoogle Assistant、Googleフォトをはじめとしてグーグルのプロダクトに幅広く実装されていくという。

次期スマートフォンOS「Android O」では、例えば電子メールの本文における名前や住所、電話番号を自動認識し、一部分をタップしただけで選べるようになる。さらに住所なら住所であることを理解しているため、これを1回クリックしただけでマップを呼び出すことができるようになる。

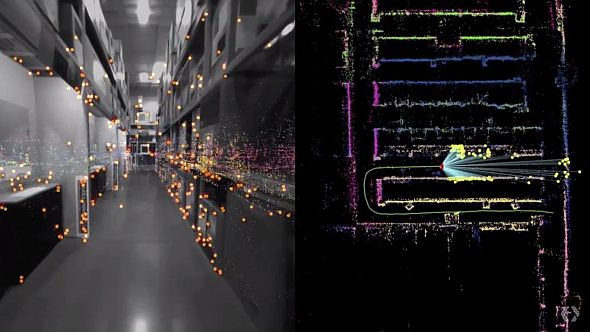

また、近い将来に一般的なスマートフォンで、「VPS(Visual Positioning Service)」が使えるようになるという。GPSでは衛星を使って端末のおおまかな位置が特定できるが、VPSは携帯電話のカメラに映る画像を使って、これをGoogleマップの店内画像および参照ポイントと照合し、正確な位置を特定する技術。

基調講演では、VPSの用途の1つとして、大型ホームセンターで、特定の商品が存在する場所へ利用者を導くなどができると紹介された。目の不自由な人たちをガイドする機能としても、利用価値は高いはずだという。VPSはGoogle Lensの中核機能の1つとして提供される。

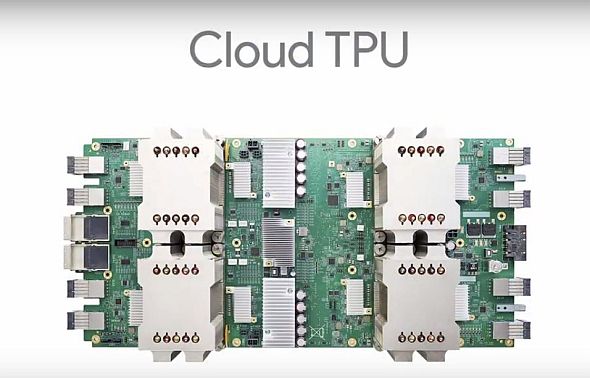

TensorFlowに特化した第2世代の高速化ASIC、「Cloud TPU」を発表

Pichai氏は、機械学習/AIへの全社的な取り組みを支えるインフラとして、「『AIファーストデータセンター』と呼べるものを構築してきた」と話し、「Cloud TPU」を発表した。

Cloud TPUの「TPU」とは、グーグルの生み出したオープンソース機械学習ライブラリTensorFlow関連の処理を高速化するためのASIC、「Tensor Processing Unit」のこと。グーグルは2016年のGoogle I/Oで、TPUについて明らかにしていた。自社開発のこのチップを、社内のあらゆるプロダクトで活用してきたという。

Cloud TPUは第2世代のTPUという位置付けだ。

「機械学習には2つの部分がある。トレーニングと推論だ。2016年の段階で、TPUは推論に最適化されていた。しかし、トレーニングの方が、膨大なコンピュータ処理を必要とする。例えば機械翻訳では、1つ1つのモデルのトレーニングに、100のGPUを1週間使い、30億の言葉を処理しなければならない」

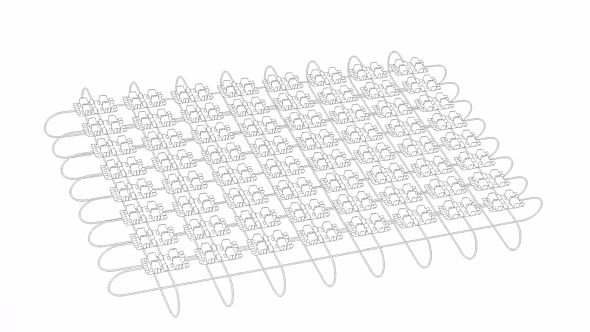

新たに発表したCloud TPUは、推論とトレーニングの双方に最適化されている。4つのチップを搭載したボードで、それぞれが180TFLOPSの処理能力を備える。64基を相互接続し、単一のスーパーコンピュータとして使えるとPichai氏は説明した。これを「TPUポッド」と呼び、各TPUポッドは11.5PFLOPS(180TFLOPS×64)の処理能力を発揮するという。

「Cloud TPU」と呼んでいるのは、クラウドを通じて提供されるTPUだからだ。Google Cloud Platform(GCP)で、即日提供開始するとPichai氏は宣言した。実際にGCPのWebページでは、アルファ版として説明されている。

Pichai氏はさらに、1000基のCloud TPUで構成する「TensorFlow Research Cloud」を、研究者に無償で提供するプログラムを開始したと発表した。審査を通過した人あるいは組織のみが利用できる。「利用者は、成果を論文、オープンソースコード、ブログポストなどの形で、世界と共有しなければならない」とされている。

GCPではCPU、エヌビディアの最新製品を含むGPU、そしてCloud TPUを提供。「これらを通じ、GCPを機械学習のための最高のクラウドにしていきたい」(Pichai氏)という。

学習することを学習する「AutoML」

一方でグーグルは、機械学習の手法についても研究・開発を重ねているとPichai氏は強調した。

「より良い機械学習モデルの開発は、非常に時間のかかる作業だ。機械学習の専門家を中心とした、少数のエンジニアおよびサイエンティストが苦労を重ねなければならない。これを、数十万人の開発者が扱えるものにしたい」(Pichai氏)

このために開発してきたのが「AutoML」。これは一種の強化学習で、「あるニューラルネットによって、複数の赤ん坊のようなニューラルネットをトレーニングして試し、最善のニューラルネットを選択する」というもの。病理学で乳房がんの発見確率を向上するなど、すでに大きな効果を収めているとする。この例では、誤検出の確率がまだ高いが、既に専門家に使ってもらっているという。特定分野における優れた能力を備えた人たちにツールとして使ってもらうことが、AIの果たすべき重要な役割の1つだからとPichai氏は説明している。

TensorFlowに関しては、Android OSの関連で「TensorFlow Lite」が発表された。これはTensorFlowの軽量版で、Android OS搭載デバイス上で動作し、ConvNetやLarge Scale Deep Neural Networkなどを通じて、音声処理、画像処理、AR関連処理などを行うことを想定している。「Neutral Network API」と呼ぶAPIを通じて、ハードウェアによる高速化が可能という。TensorFlow Liteは間もなくTensorFlowのオープンソースプロジェクトに加わる。Neutral Network APIは、2017年中に提供の予定。携帯電話などに搭載できる機械学習高速化のための特殊なDSPも、近い将来に登場するだろうという。

Copyright © ITmedia, Inc. All Rights Reserved.