AI活用を阻む「データマネジメントの問題」をどう解消するか:なぜデータを「成果」に変えられないのか?

AI活用を進めるためにデータを日々蓄積しているが、必要なデータが足りない、データのありかが分からない、すぐに使えるデータを集められないなど、AI以前の段階でつまずきAIプロジェクトが頓挫してしまうケースは多い。そうしたありがちな問題に陥らないためには具体的に何が必要なのか――データを価値に変える「データパイプライン」というコンセプトを打ち出しているNetAppに話を聞いた。

デジタルトランスフォーメーション(DX)を進める上で、最も重要な要素の一つがデータだ。データは「21世紀の石油」とも称されるように、新たな製品・サービスを生み出す“資源”になると期待されている。石油が燃料をはじめプラスチックや合成ゴム、合成繊維などに加工されて社会生活を激変させたように、データもビジネスの在り方や価値を激変させるというわけだ。

また、この「石油」という比喩は「成果物を得るまでのプロセス」を説明する際に用いられることも多い。石油を使って製品を生み出すまでには「発掘・精製・加工」といった一連のプロセスがある。同様に、データそのものに資源としての価値はあっても、そこから「成果」を生み出すためには「発掘・精製・加工」という一連のプロセスを経る必要があるのだ。

では、企業がデータを使って価値を生み出し、ビジネスの成果を獲得するためには、データにどうアプローチすればよいのだろうか?――この問いに対して「データパイプライン」というコンセプトを打ち出しているのがNetAppだ。

ストレージベンダーとして長い実績を持つ同社だが、近年はディープラーニングや機械学習といったAI技術領域へも進出し、石油精製のパイプラインのごとく、データから価値を引き出すための環境構築を支援している。

では同社が提案する環境とはどのようなものなのか。また、AIはその中でどのような役割を担っているのか。NetAppにおけるAIソリューションとAIプロダクトの担当者である、サントッシュ・ラオ氏(AI&データエンジニアリング シニアテクニカルディレクター)と、スンダー・ランガナタン氏(ONTAP Software & Systems/AI シニアプロダクトマネジャー)に、AI活用やデータ活用で日本企業が抱えがちな課題と、その解決方法、NetAppが企業に提供できる価値などを聞いた。

なぜAIの取り組みは「PoC止まり」になってしまうのか

──日本企業のAI活用は米国に比べて遅れているといわれています。日本における活用状況をどう見ていらっしゃいますか。

ラオ氏 私はむしろアジアでこそAI活用が進展していると見ています。特に製造業がAI導入に積極的で、「デジタルファクトリー」「コネクテッドファクトリー」と呼ばれる分野でさまざまな新しい取り組みが進められています。在庫管理など作業のオートメーション、ロボティクスを使ったプロセス改善などが代表例でしょう。私たちのお客さまの中にも、そうした取り組みを積極的に進めている方がたくさんいます。

──ただ、多くの取り組みがPoCで終わってしまっているという声も少なくありません。データサイエンティストなどの人材不足も指摘されています。

ラオ氏 人材不足やスキルセット不足はご指摘の通りでしょう。しかし、これは日本に限ったことではなく、世界的な傾向です。企業はデータサイエンティストの育成や雇用などに投資をしなければなりません。もちろん、それと同様にインフラへの投資も必要です。さらに「どういったデータをどう活用するのか」というデータストラテジーを持つことも求められます。

PoCで終わってしまうのは、スキルも人材もインフラも戦略も不足している中で、AIの取り組みを取りあえず始めてしまうからだと考えます。そこでわれわれは、「不足している要素を補うためのサービス」を提供することで、企業の取り組みを支援しているのです。

──中でもインフラという面では、「システムがサイロ化しているため、データの一元管理が難しい」といった問題もよく聞かれます。

ラオ氏 それも大きな問題です。さまざまなシステムからデータを収集、統合することは簡単ではありません。例えば、分析システム一つとっても、GPFS(General Parallel File System)やLustre(ラスター)などのHPC(High Performance Computing)で実績ある並列分散システムにデータが入っていることもあれば、Apache HadoopのHDFS(Hadoop Distributed File System)やNoSQLといった最近のデータ基盤を使っているケースもあるでしょう。ログなどをSplunkなどのシステムに格納し分析しているケースも多くあります。

ランガナタン氏 分析システムだけではなく、NFS(Network File System)やCIFS(Common Internet File System)などのオンプレミスのファイルシステムに非構造化データが置かれていたり、Amazon S3などのクラウド上のオブジェクトストレージにログや非構造化データがまとめて置かれていたりするケースもあります。こうした「オンプレミスとクラウドに散在する多種多様なデータ」を一元的に管理していくことが求められるわけです。データをAIで処理する以前に、データがきちんと整備されていないことも大きな課題になっていると考えます。

エッジ、コア、クラウドをシームレスに連携させることが重要

──そうした課題に対し、企業はどう取り組めばよいと思いますか。

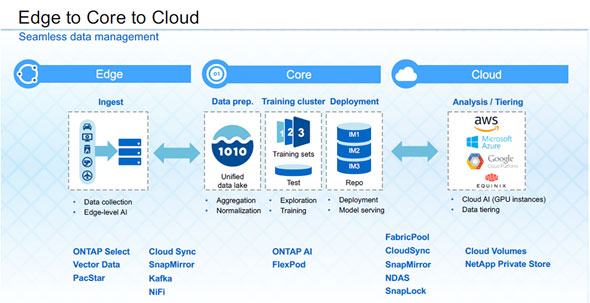

ラオ氏 NetAppが提案しているのは、データが生成される場所や処理の仕方などに応じて、3つの領域に分けてデータを管理することです。すなわちデータが生成される場所としての「エッジ」、データを準備・加工・展開する場所としての「コア」、データを階層化しAIを使って分析する場所としての「クラウド」という3つに分け、エッジ、コア、クラウドまで、シームレスなデータマネジメントができる仕組みを提案しています。

まずエッジは、さまざまなデータを収集してコアに送り出す役割を担います。必要に応じてエッジ上でAI処理を行う場合もあります。コアの役割は、データの前処理(プレパレーション)と、AI学習に向けたクラスタへの展開です。コアに統合データレイクを構築し、そこにデータを集約、正規化し、学習用セットとテストデータを作るのです。また、分析モデルに合わせて分析のためのクラスタにデプロイする役割も担います。

クラウドの役割は、AI処理です。GPUを活用して、高い性能の下、ディープラーニング、機械学習を効率的に実施します。処理しやすいようにデータを階層化して渡す仕組みとしています。

──それぞれが別の役割を担うエッジ、コア、クラウドをつなぎ、データという資源から価値を生み出すまでのパイプラインを作るわけですね。ただ一般に、そうしたパイプラインを作る場合、既存の多様なインフラとソフトウェアを組み合わせて構築することが多いと思います。貴社が提案する仕組みとの違いは何でしょうか。

ラオ氏 一つは、あらゆるデータに対して「一貫したアクセス方法」を提供できることです。データにはランダムアクセスする場合とシークエンシャルにアクセスする場合があります。また構造化/非構造化データの違いやファイルシステムの違いもあります。そうした違いがあっても、データ管理ソフトウェア「ONTAP」という1つの製品、1つの方法で全て対応することができるのです。これは、ONTAPが培ってきたマルチワークロード対応のNFS(Network File System)で実現しています。ランダム/シークエンシャル、非構造化/構造化データが混在する複雑なワークロードでも、容易にデータにアクセスでき、高いパフォーマンスで処理できるのです。

ランガナタン氏 もう一つは、データをハイブリッドクラウド環境でシームレスに利用できることです。ONTAPは物理環境だけではなく、ハイパーバイザー上で動作するSDS(Software Defined Storage)製品「ONTAP Select」としても提供しています。これは、エッジでも稼働可能です。また、クラウド上では「Cloud Volumes Service(旧ONTAP Cloud)」や「Cloud Volumes ONTAP(旧ONTAP Cloud)」というクラウドファイルサービスを提供しています。

──エッジからコア、クラウドまで、ONTAPが軸になることで、一貫したデータアクセス、データ処理が行えるわけですね

ランガナタン氏 そうですね。エッジ、コア、クラウド間でのデータ移行もシームレスに行えます。移行の際には「Data Mover」「SnapMirror」「CloudSync」「NetApp In-Place Analytics Module」といったツールを用い、データを二重にコピーする必要なく、分析のためのデータを効率良く移動できます。AWS(Amazon Web Services)やMicrosoft Azure、GCP(Google Cloud Platform)といった主要なパブリッククラウドにも対応しています。

AI活用を加速させる「ONTAP AI」

──データを使ってやりたいことがありながら、価値を生み出すまでのパイプラインが整っていない、使いにくいためにそれができない。そこでインフラの仕組み、データ管理の在り方、データの種類といった“ビジネスにとって本質的ではない部分”にまつわる問題を解消するというわけですね。

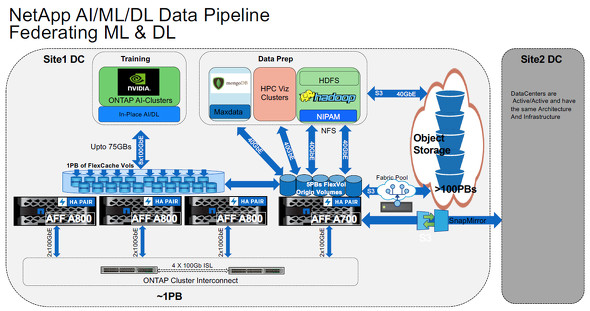

ラオ氏 はい。また、NetAppのソリューションのもう一つの特徴として、AI活用を簡単に行うためにシステムのリファレンスアーキテクチャを提供していることが挙げられます。これは、NVIDIAと共同で開発した「ONTAP AI」というソリューションで、GPUをフル活用してディープラーニングや機械学習を高速に実行します。ONTAP AIは、エッジ、コア、クラウドで構成するデータパイプラインのコアに相当し、クラウドAIにデータを送る際の前処理だけではなく、オンプレミスでのAI処理も担います。

──AIというとまずクラウドが想起されますが、データによってはガバナンス、セキュリティ面の事情からオンプレミスで処理したいケースも多いと思います。データの重要度や活用目的に最適な場所で処理できることは企業ニーズも大きいでしょうね。

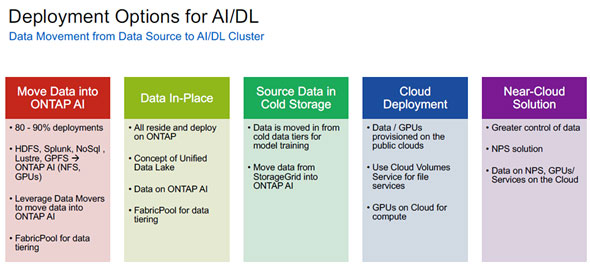

ランガナタン氏 そうですね。さまざまなデータを目的に応じた場所で処理できることはわれわれの大きな強みです。AIやディープラーニングのためのデータの展開方法にも大きく5つのパターンがあります。

1つ目は「ONTAP AI」にデータを集約するパターンです。前述のように「Data Mover」関連ツールを用いて、HadoopやNoSQL、SplunkなどからデータをONTAP AIに簡単に移行することができます。2つ目はデータ管理ソフトウェア「ONTAP」を使ったコアのユニファイドデータレイク上でデータを管理するパターン。クラウドやエッジと連携しながらさまざまなデータを高速にAI処理します。

3つ目は「コールドストレレージ内でのデータ活用」。モデルトレーニングのためにコールドデータ階層からデータを移動して活用します。この際には、「StorageGRID」というAmazon S3互換のオブジェクトストレージから「ONTAP AI」にデータを移動します。4つ目は、データとGPUをパブリッククラウド上にプロビジョニングし「Cloud Volumes Service」や「Cloud Volumes ONTAP(旧ONTAP Cloud)」を使ってアクセスするパターン。5つ目は「ニアクラウドソリューション」で、マルチハイブリッドクラウドソリューションである「NetApp Private Storage(NPS)」を活用します。いずれのパターンを用いる場合も、エッジからクラウドまでのシームレスなデータマネジメントが可能です。

PoCの小さな成功をビジネスにつなげるために

──導入事例を教えてください。

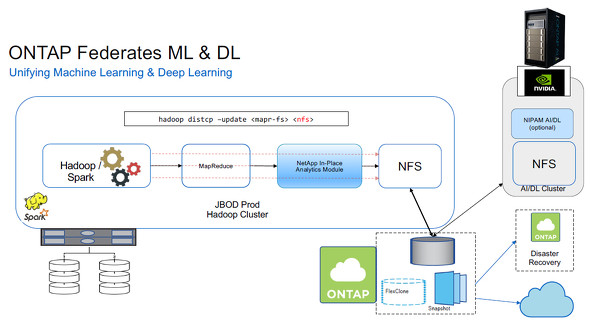

ラオ氏 米国のある金融業では、Apache Spark/Hadoopで構築した基盤をONTAPと連携させ、AI/ディープラーニング処理を効率化しています。Hadoopクラスタはコモディティハードウェアを使って構築されていましたが、GPUを使う場合と比べて処理速度に制約がありました。そこで分析データをNFSに格納してONTAPと連携させ、ONTAP AIを用いて、GPUで処理できるようにしました。NFSへの変換には「NetApp In-Place Analytics Module」を使っています。これは、既存のHadoopデータを生かしながら、GPUを使ってAI分析を高速化した良い事例です。

また、米国のある自動車メーカーでは、デジタル変革を見据えた次世代アーキテクチャを構築するために、オールフラッシュで構築したONTAPシステムにHadoopを直接デプロイしています。まずデータのプリパレーションを行い、それを「FlexCache」という論理コピーを作る機能を利用してONTAPクラスター上にでデプロイし、それに対してGPUを使ったAI処理を行っています。

ランガナタン氏 アジア太平洋地域(APAC)の事例もあります。APACのある大手自動車メーカーは、NetAppのストレージ製品「FAS」やオールフラッシュシステム「AFF(All Flash FAS)」にデータを格納し、それをNVIDIAのAI専用システム「DGX-1」で分析しています。DGX-1はONTAP AIで採用されているシステムです。TensorFlow、Caffe2、PyTorchなどのAIライブラリを活用しています。

また、APACの大手通信事業者は、AR/VR、IoT、ブロックチェーンといったAIに関わるサービスを一元的に管理するためのAIコントロールセンターを構築しました。コントロールセンターは、FASハイブリッドシステムとDGX-1を用いて構築されていて、動画や音声、画像、言語処理など多様なI/Oパターンを、パフォーマンスを犠牲にすることなく処理しています。このコントロールセンターは近年開催されたオリンピックでも活躍したそうです。

AI/ディープラーニングでNetAppが提供できる価値とは

──インフラ基盤を刷新することで、どのような成果が得られますか。

ラオ氏 このようなマルチワークロード対応やハイブリッドクラウド対応、パフォーマンス、容量効率などはTCOの削減に効果があります。DAS上に構築したHadoopクラスタから、ハイブリッドクラウドアーキテクチャを備えたNetAppシステム(AFF、StorageGRID)に移行し、TCOを625万ドルから350万ドルにまで削減できたケースもあります。

──ユースケースはグローバルで着実に増えているのですね。では最後に、実際にAIプロジェクトを進めている現場の方に向けて、一言メッセージを頂きたいのですが。

ランガナタン氏 AI活用のためのデータインフラ整備だけではなく、取り組み自体を支援できる点もNetAppの強みだと思います。NetAppでは「NetApp Excellerator」というスタートアップアクセラレータープログラムを提供しており、多様なスタートアップがAIを使ったソリューションを開発しています。そうしたパートナーのソリューションを活用することで、AIのPoCをスモールスタートし、成果を確認しながらスケールさせていくこともできるのです。ある医療系のお客さまは、15人で1日当たり150人の患者に対応していましたが、AIを活用したバーチャルアシスタントを導入したことで、1日当たり200人の患者に対応できるようになりました。

ラオ氏 やはり1つのユースケースで、まずは小さな成功を得ることがAI活用成功の近道だと思います。スキル不足や人材不足、データインフラの問題などはわれわれやパートナーのソリューションで補うことができます。まずはクラウド上でのPoCをお勧めします。ROIを測り成果を確認できたら、戦略的に社内で活用を広げていってほしいと思います。

ランガナタン氏 NetAppはスモールスタートに必要な環境から、その後の大規模環境までをトータルにサポートできます。AIを活用する上で不足している部分を支援しつつ、共に成長の過程を歩んでいきたいと思っています。

Copyright © ITmedia, Inc. All Rights Reserved.