GPUを動的に割り当てて機械学習における利用の無駄を減らす、Run:aiが日本で本格事業展開:単一GPUの分割利用も可能

機械学習におけるGPUの利用効率を高める仕組みを提供する企業、Run:aiが日本で事業展開を本格化している。GPUクラスタを動的に割り当てることで、無駄を減らせるという。小数点以下の単位での割り当ても可能だ。

機械学習におけるGPUの利用を自動化・効率化できる仕組みを提供する、Run:ai(「ラン・エーアイ」と読む)というイスラエルの企業が日本で事業の本格展開を始めた。GPUリソースをプーリングし、動的な割り当てが行えるもので、貴重なGPU資源を企業内の複数チーム間で効率的に共有できるようになるという。

Run:aiの「Run:ai Atlas Platform」(以下、Atlas)では、KubernetesにおけるNVIDIA GPUリソースのスケジューリングが行える。既に動かしているKubernetesディストリビューションにプラグインして、GPUのスケジューリングを担うことになる。Kubernetesをまだ使っていない組織は、Atlasとまとめてインストールすることもできる。ユーザーは、Jupyter Notebookなどの統合開発環境(IDE)から、インフラを意識することなく使える。

「機械学習は、コンテナ基盤で行うのが当たり前になってきた。だが、KubernetesではGPUを静的に割り当てることしかできず、利用効率が下がる。また、データサイエンスチームは、Kuberneresを直接操作したくないし、IT管理者にGPUのプロビジョニングを依頼したくもない。一方、IT管理者には、GPUの利用状況や利用率を知ることのできるツールがない」

こうした問題を解決できるのがAtlasだと、Run:aiのアジア太平洋地域ビジネス開発シニアディレクター、ニール・ルブリナー(Nir Lubliner)氏は説明する。

Atlasでは、IT管理者が単一あるいは複数のGPUをリソースプール化し、これを複数チームに割り当てるポリシーを作成し、適用できる(企業やユーザー単位の割り当ても可能で、クラウド事業者がGPUをサービスとして提供するのにも使える)。

ポリシーに基づきGPUを自動的に割り当て

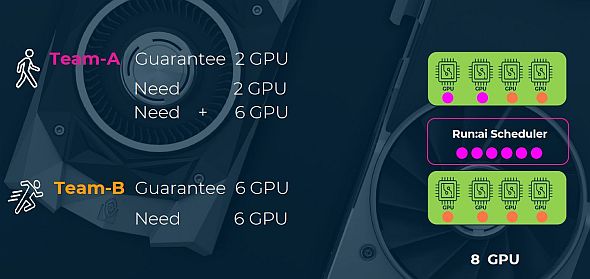

IT管理者は、各チームに対して最低限保証するGPU数(「保証クオータ」)を割り当てることができる。下の図では8基のGPUがあり、IT管理者はチームAには最低2基のGPU、チームBには最低6基のGPUを保証するポリシーを設定している。

通常の稼働状態では、2チームが2基、6基のGPUをフルに利用しているとする。だが、チームBが休暇などの理由で割り当てられたGPUを全く使わなくなった場合、チームAは必要に応じ、自動的に8基全てのGPUを使えるようになる。その後チームBが休暇から戻ると、チームBは自動的に6基のGPUリソースの利用が保証される。

これはシンプルな例だが、保証クオータを超えたGPUリソースの利用については、トレーニングや推論などのGPUの用途、各チームの重要度などに応じて、きめ細かなポリシーを作成し、適用できる。例えば大学では、博士課程のチームに学士課程のチームよりも高い優先度を与えているケースがあるという。

Atlasでは、小数点以下の単位でGPUリソースを割り当てることもできる。

「トレーニングでは多数のGPUが必要だが、コーディングやモデル構築ではそうではない。例えば20ユーザーがいるとして、用途にかかわらず各人に1基のGPUを割り当てると、20基が必要だ。一方、Run:aiでは単一のGPUを20人全員に割り当てることができる。 そうすれば、残りの19基は他の作業に活用できる」(ルブリナー氏)

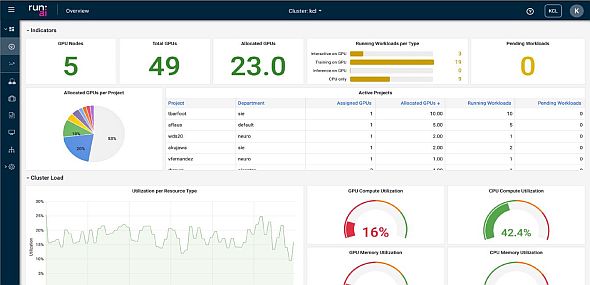

IT管理者は、下図のようなインタフェースで、GPUの利用状況を把握できる。GPUの利用率、プロジェクトごとの利用状況、余剰GPUリソース量などを確認できる。これをポリシーの最適化やチャージバックなどにも活用できるという。

Run:aiを取り扱っているマクニカクラビスカンパニーでは、顧客の製造業などで、GPUを使った機械学習への取り組みが、部門単位から全社的なものに変わり始めているという。こうした動きを支援するため、Run:aiを提案していきたいとしている。

Copyright © ITmedia, Inc. All Rights Reserved.