ハルシネーション(Hallucination)とは?:AI・機械学習の用語辞典

ハルシネーションとは、チャットAIなどが、もっともらしい誤情報(=事実とは異なる内容や、文脈と無関係な内容)を生成することを指す。AIから返答を受け取った人間が「本当かどうか」の判断に困るという問題がある。この問題を回避する方法として、独自の情報源を付与するRAGや、Webアクセスを含める機能などがある。

用語解説

生成AI/自然言語処理における「ハルシネーション(Hallucination:幻覚)」とは、もっともらしいが「事実とは異なる内容」や「文脈と無関係な内容」といった誤情報を、人工知能(AI)が生成することである。人間が現実の知覚ではなく脳内の想像で「幻覚」を見る現象と同様に、まるでAIが「幻覚」を見て出力しているみたいなので、このように呼ばれる。

このキーワードは、チャットAI「ChatGPT」などの生成AIが広く使われるようになってから注目されている。現状の生成AIは、実際にはトレーニングしていない情報をあたかも「幻聴/幻視」しているように、信頼できない出力や誤解を招く出力を生成する場合がある。

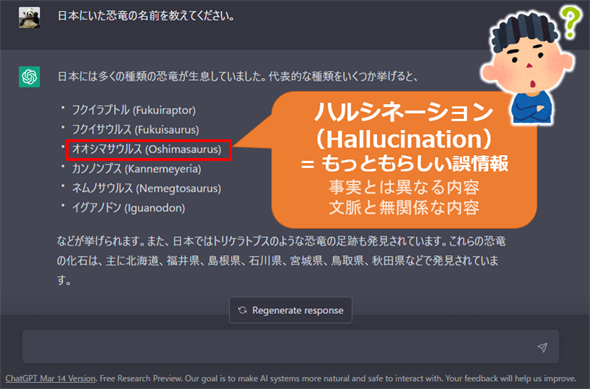

例えばChatGPTで「日本にいた恐竜の名前を教えてください」と質問したところ、自信満々に一例として「オオシマサウルス(Oshimasaurus)」が挙げられたが(図1)、これはネット検索してもヒットしないので恐らく「もっともらしい誤情報」だと思われる。このようにハルシネーションには、AIから返答を受け取った人間が「本当かどうか」の判断に困るという問題がある。

このようなハルシネーション問題をできるだけ回避するには、特定の知識や情報源(例えばナレッジベースなど)によって言語モデルの回答や生成内容を裏付けること(グラウンディングとも呼ばれる)が有効である。

その代表的な手法が、チャットAIに独自の情報源を付与するRAG(Retrieval-Augmented Generation:検索拡張生成)という仕組みだ。

また、Webアクセスを質問に含めることで「もっともらしい誤情報」を軽減しようとする機能もある。例えば「Bing検索のチャット機能」には、幾つかのサイトを検索した上で質問に回答する機能が搭載されている。

さらに、生成AI側でもハルシネーション問題に対処しようとしており、例えばOpenAIの「ChatGPT」では、知らない情報に関する質問に対しては「私が知る限り、○○については情報が得られませんでした。正確な情報をお伝えできず申し訳ありません」と返答する場合があった。GoogleのチャットAI「Gemini」では、知らない計算に関する質問に対して「私は言語モデルでしかなく、それを処理し理解する能力がないため、お役に立てません」と返答する場合があった。

ここを更新しました(2024年3月4日)

最新情報に合わせて全体を修正し、例えばRAGなどを追記しました。また、全体的に文章表現を修正して、より分かりやすくしました。

Copyright© Digital Advantage Corp. All Rights Reserved.