「当初はAisuruのDDoS攻撃を疑った」Cloudflareが世界的ネットワーク障害の原因を報告:完全復旧まで約6時間 再発防止策は?

2025年11月18日、Cloudflareは世界的な通信障害について詳細に報告し、再発防止策を表明した。

CDN(コンテンツ配信ネットワーク)を提供、運営するCloudflareは2025年11月18日(米国時間)、世界中のCloudflareユーザーのトラフィックに影響した大規模障害の詳細を報告した。同社CEOのマシュー・プリンス氏名義のブログによると、障害は同日UTC(協定世界時)11時20分(日本時間20時20分)から発生し、完全復旧のUTC17時6分(日本時間19日2時6分)まで約6時間かかったという。

以降、ブログの内容を基に、障害の原因や発生から復旧までの流れ、再発防止策を要約する。

原因はサイバー攻撃ではない

Cloudflareは大規模障害について「サイバー攻撃や悪意のあるアクターによって引き起こされたものではない」とし、データベースの権限変更によってボット管理システムで使用する「feature」(特徴量)ファイルが想定以上のサイズに肥大化したことを直接の原因として結論付けている。

Cloudflareのボット管理システムで使用する機械学習モデル

Cloudflareのボット管理システムには、ネットワークを通過する全てのリクエストに対してボットスコアを生成する機械学習モデルが含まれている。Cloudflareユーザーは、そのボットスコアを使って、どのボットがサイトにアクセスできるか、あるいはアクセスできないかを制御する。

ボット管理システムの機械学習モデルはfeatureファイルを入力として受け取る。ここで言う「feature」についてCloudflareは「リクエストが自動化されているかどうかを予測するために機械学習モデルが使用する“特徴”のセット」としている。

featureファイルは数分ごとに更新され、ネットワーク全体に公開される。これにより、新しい種類のボットやボット攻撃への対応が可能になるという。

当初は「Aisuru」ボットネットによる大規模DDoS攻撃の可能性も疑った

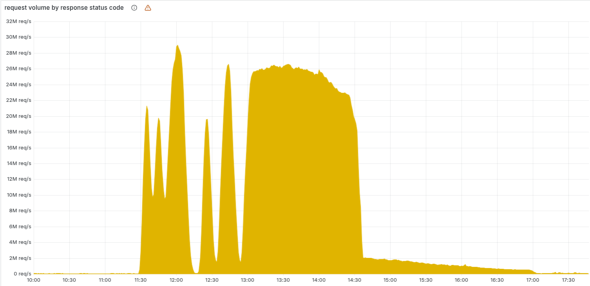

障害の始まりはUTC11時5分(日本時間20時5分)、ボット管理システムのfeatureファイルを生成する用途でも使用する「ClickHouse」データベースのアクセス権限を変更し始めたことに端を発する。セキュリティと信頼性を向上させるべくユーザーに権限を追加したことで、結果としてテーブルメタデータの取得結果に重複行が含まれるようになり、featureファイルが従来の2倍以上に膨張。ボット管理システムが使用できる機械学習の特徴量の上限である「200」を超過したことで、エラーが発生した。

11月18日UTC11時20分(日本時間20時20分)、Cloudflareのコアネットワークトラフィックの配信に重大な障害が発生し始めた。CloudflareユーザーのWebサイトにアクセスしようとしたインターネットユーザーには、Cloudflareネットワークの障害を示すステータスページが表示された。

結果として、ボット管理システムに依存する全てのトラフィックに対して、DDoS(Distributed Denial of Service)攻撃防御やユーザーのトラフィックのルーティングなどを担うプロキシシステムから「HTTP 5xx」エラーを返す状態となった。

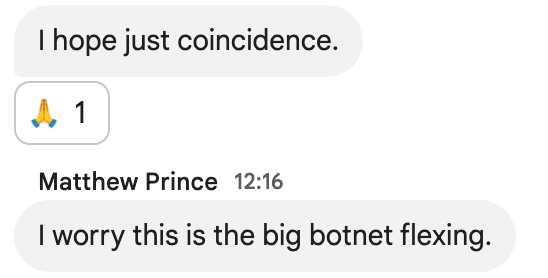

問題発生当初は最近問題になっていた「Aisuru」*ボットネットによる大規模DDoS攻撃の可能性も疑ったという。Cloudflareは社内のインシデントチャットルームの様子を次のように掲載している。

*Aisuru:2025年10月24日(米国時間)にMicrosoftが「Azure DDOS Protection」で15.72Tbps、約36億4000万パケット/秒(pps)のマルチベクトルDDoS攻撃を自動検知して軽減したと報告したことで話題になったIoTボットネット(参考)

この理由としてCloudflareは、発生当初、ClickHouseデータベースクラスタ上で実行されるクエリによって5分間隔で生成される正常/異常なfeatureファイルが混在してネットワークに配布されたため、一時的に回復するように見える挙動を繰り返したこと(その後、全て異常なfeatureファイルのみになった)、Cloudflareのインフラに依存していないステータスページも偶然、同時期にエラーを返したことを挙げている。

対応と完全復旧まで

影響はCDNやセキュリティサービス、プロキシシステムに依存する「Cloudflare Workers KV」「Cloudflare Access」「Turnstile Turnstile」「ダッシュボード」など多岐に及び、ログイン不能や認証失敗が発生した。Workers KVについてはUTC13時5分(日本時間日22時5分)に旧プロキシシステムへのバイパスを適用したことで、影響が軽減された。

CloudflareはUTC13時37分(日本時間22時37分)、ボット管理システムのfeatureファイルに原因があると確信。UTC14時24分(日本時間23時24分)に誤ったfeatureファイルの配布を停止し、直後に古いバージョンの正常ファイルをグローバルに展開した。

UTC14時30分(日本時間23時30分)にはほとんどのサービスが回復し始め、UTC17時6分(日本時間19日2時6分)に全システムが正常化した。

再発防止策

Cloudflareが表明した再発防止策は下記の通り。

- Cloudflareが生成した設定ファイルの取り込みを、ユーザー生成の入力ファイルと同じぐらい堅牢(けんろう)にする

- 機能のキルスイッチ(緊急停止装置)をグローバルで有効化する

- コアダンプやその他のエラーレポートがシステムリソースを圧迫する可能性を排除する

- 全プロキシモジュールにおけるエラー状態の障害モードを見直す

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

システム障害が発生すると「1分ごとに500万円が消える」 New Relic調査

システム障害が発生すると「1分ごとに500万円が消える」 New Relic調査

New Relicの調査で、ITシステム停止による損失コストが膨大な額に上っていることが明らかになった。AI導入の進展によって、システム運用の複雑さに拍車が掛かっている。 エンジニアは何を思い、どう対応したのか AWSがDynamoDB、EC2、NLB障害の概要を公表

エンジニアは何を思い、どう対応したのか AWSがDynamoDB、EC2、NLB障害の概要を公表

世界規模の顧客が利用する基幹リージョンである米国東部「us-east-1」が、日本時間では2025年10月20日15時48分から21日6時20分にかけて障害に見舞われた。AWSは何が原因で多段階の不具合が発生したのか、その詳細を発表した。 Datadog、無料で30以上のSaaS、13のAWSサービスの障害をリアルタイムで確認できる「Updog.ai」を公開

Datadog、無料で30以上のSaaS、13のAWSサービスの障害をリアルタイムで確認できる「Updog.ai」を公開

Datadogは、OpenAI、Zoom、GitHub、Slack、Stripeといった30以上の主要SaaSと13のAWSサービスの健全性を確認できるWebサイト「Updog.ai」を無料公開した。