シャドーAI(Shadow AI)とは?:AI・機械学習の用語辞典

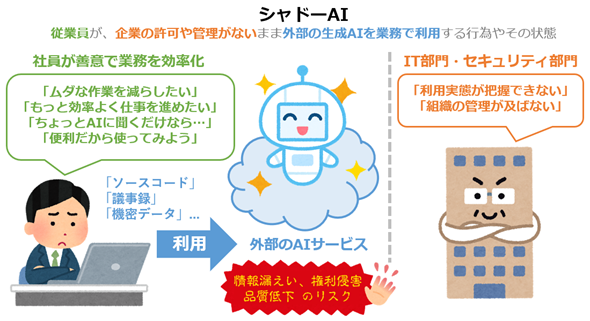

企業のIT部門やセキュリティ管理部門の許可や監視がないまま、従業員が外部の生成AIサービスを業務に利用する行為や状態。業務効率化という善意の目的でAI利用が自然と広がる一方で、情報漏えいやガバナンス上のリスクを内包する、現代的な課題として注目されている。

用語解説

シャドーAI(Shadow AI)とは、企業のIT部門やセキュリティ管理部門の許可や監視がない状態で、従業員が独自に無許可のAIツールやAIサービスを業務利用する行為、またはそれが起こっている状態を指す用語である。とりわけ近年では、会社として契約や利用承認が行われていないChatGPTやGemini、GitHub Copilotなどのクラウド型AIサービスを用い、業務上の機密データを入力したり、その生成物を会社として管理/把握できない形で業務に利用したりするケースが、シャドーAIの代表例として挙げられる(図1)。

関連用語と包含関係

シャドーAIを理解する上で、混同されやすい関連用語があるため、比較しやすいようにここで簡単に整理しておく。

- BYOD(Bring Your Own Device): 「自分自身のデバイスを持ち込む」(=従業員が私物のPCやスマートフォンなどのデバイスを業務で利用する)という行為を、従業員の視点で表現した用語である。シャドーIT(後述)と呼ばれる状態を引き起こしやすい要因の一つだが、もちろん会社が許可していれば問題のない行為でもある(※会社が許可しているか、いないかは、一般的な「BYOD」の定義に含まれないため)。

- BYOAI(Bring Your Own AI): 「自分自身のAIを持ち込む」(=従業員が会社として契約や利用承認が行われていないAIツールやAIサービスを業務で利用する)という行為を、従業員の視点で表現した用語である。シャドーAIと呼ばれる状態を引き起こす要因の一つ。個人で契約して使用するAIツール/サービスの利用を、会社が業務で利用許可を出している場合は、一般的に「BYOAI」と呼ばれない(※BYODとは、この点が違うので注意してほしい)。

- シャドーIT(Shadow IT): 無許可の私物デバイスを業務利用する行為(=前述のBYODを会社の許可を得ずに行うこと)や、無許可のITツールやITサービス(クラウドストレージやSaaS全般など)を業務利用する行為、またはそれらが起こっている状態を指す。

シャドーAIは、概念上はシャドーITの一部に位置付けられる。いずれも「組織の許可や管理の及ばないIT/AI利用」という点では共通している。しかし、その包含関係にもかかわらず、シャドーAIは、従来のシャドーITと比べて、より高いセキュリティリスクを内包していると考えられている。

その理由は、リスクの性質そのものが異なるためだ。従来のシャドーITが主に問題としてきたのは、データの「保存場所」や「通信経路」といった管理範囲の逸脱であった。一方、シャドーAIでは、業務データが外部のAIサービスに送信され、「処理」や「加工」が行われるだけでなく、場合によってはAIモデルの「学習(トレーニング)」に利用される可能性がある(※オプトアウト設定により回避可能なケースも多い)。このように、データが単に移動/保管されるだけでなく、第三者が提供するAIサービスの処理過程に組み込まれることで、企業側ではその扱いや影響範囲を把握し切れなくなる点に大きなリスクがある。

こうした違いから、シャドーAIは単なるシャドーITの延長ではなく、より深刻な影響を及ぼし得る問題として認識されつつある。

顕在化するリスクと事例

シャドーAIが引き起こすリスクは、単なる社内規定違反にとどまらない。実際には、情報漏えい、コンプライアンス違反、業務品質の低下などを通じて、組織全体に影響を及ぼす事態へと発展する可能性がある。以下では、シャドーAIに特有のリスク構造と、実際に問題となった事例を簡単に整理する。

- 学習による機密情報の流出: 多くの無料版・個人向けの生成AIでは、入力されたデータがサービス改善やモデルの再学習(トレーニング)に利用され得ることが、利用規約上で定められている。このため、業務上の機密情報を不用意に入力すると、意図しない形で外部に保存/利用されるリスクが生じる。

- <事例>: 2023年、大手半導体メーカーにおいて、エンジニアがプログラムの不具合修正のためにソースコードを入力したり、会議内容の要約を目的として生成AIに議事録データを入力したりした結果、これらの情報が外部AIサービス側に保存されるインシデントが発生した。この事例では、将来的に他の利用者への回答生成を通じて、企業の機密情報が露出する可能性が問題視された。

- 権利侵害と汚染データの混入: 生成AIが出力する文章やコード、画像には、著作権侵害の疑いがある表現や、事実誤認(ハルシネーション)を含む内容が混在する可能性がある。こうした生成物を十分な確認を行わないまま業務や製品に取り込むと、品質低下や法的リスクにつながりかねない。

- <事例>: 企業の開発現場において、会社として承認されていない生成AIや外部公開モデルを開発者が独自に利用し、生成されたコードや学習済みモデルを十分な確認を行わないまま業務システムに取り込んだ結果、ライセンス上の問題やセキュリティ上の懸念が後から顕在化するケースが報告されている。

シャドーAIには、このような潜在的リスクが存在する一方で、企業のIT部門が想定していないAIツールやAIサービスの利用は、既に急速に拡大している(参考:SIGNATE総研『【特集】「AI活用実態調査」レポート シャドーAIの利用実態について 2025年12月版』によると「約35%がシャドーAIの利用経験がある」)。結果として、シャドーAIは現代のセキュリティガバナンスにおける最大の死角となりつつある。

特に2022年から始まった生成AIブーム以降、従業員の多くは「悪意」ではなく、「業務効率化」や「品質向上」といった善意の目的でAIを利用している。従業員が求めるAIによる生産性向上に対し、企業側の提供する許可済みツールや承認プロセスが追いつかない場合、そのギャップを埋める形で、個人向けAIツールの無許可利用が広がりやすい。シャドーAIは、従業員のモラル低下ではなく、組織の提供能力と現場ニーズの不一致から生じる現象と捉えるべきだろう。

対策は「禁止」ではなく「安全に使う」方向へ

シャドーAIへの対策として、外部のAIサービスをファイアウォールで一律に遮断する「全面禁止」は、必ずしも最善策とはいえない。業務効率化を求める従業員は、私物のスマートフォンや自宅のPCを経由してでもAIを利用しようとするため、結果として利用実態が把握できなくなり、かえってリスクが見えにくくなってしまうからだ。

こうした背景から、近年のセキュリティ分野では、「使わせない」ことを目指すのではなく、「利用を前提とした上でリスク全体を抑える」という考え方が重視されるようになってきている。こうしたアプローチは、一般に「セキュアな利活用(Secure Enablement)」と呼ばれることが多い。

このようなセキュアな利活用を実現するためには、次の2つのアプローチを組み合わせた対応などが考えられる。

- 安全な代替手段の提供: データが学習に利用されない法人契約プラン(例:ChatGPT Enterprise)や、社内専用の生成AI環境を整備することで、「隠れてAIを使う必要がない状態」を作り出す。

- ガードレールの設置: クラウドサービスへのアクセス状況を可視化/制御する仕組み(例:Microsoft Defender for Cloud Appsのようなセキュリティツール)を活用し、AIサービスの利用そのものを一律に禁止するのではなく、クレジットカード番号やソースコードなど、特に機密性の高い情報を含むプロンプト送信のみを制御するといった技術的対策を講じる。

「シャドーAI」は、従業員を監視したり処罰したりするためのものではない。むしろ、組織が「生成AIの利活用」と「ガバナンス」のバランスをあらためて見直し、現実に即したルールを再構築するための出発点となる概念である。シャドーAIの存在を前提に、生成AIといかに向き合い、どう制御していくのか。その姿勢が、これからの企業には問われていくだろう。

Copyright© Digital Advantage Corp. All Rights Reserved.