「Hadoop」が抱える分析速度と運用性の課題、どう解決する? 攻めの経営戦略を実現するデータ分析基盤とは:ImpalaやHiveより120倍速い処理速度

攻めの経営戦略を進めるために、大量のデータ分析ができる「Hadoop」の導入を検討している企業は少なくない。しかし。そのほとんどで、性能やアプリケーションの保守性、運用性、コストなどの課題が浮かび上がっている。どうすれば解決できるのか。2人の専門家に聞いてみた。

昨今、IoT(Internet of Things)やデジタルトランスフォーメーションへの流れが加速する中で、企業におけるデータ活用の重要性が高まってきている。特に、増大し続ける多種多様なデータをどう分析し、経営判断やビジネス戦略にいかに活用するかが企業にとって大きな課題になりつつある。

これまでの日本企業のデータ活用は、基幹システムにある売り上げデータや経理データを集約した定形帳票を経営判断材料の1つとして使う方法がほとんど。分析に使うデータの種類も量も限られていた。

しかし昨今、競争力のある新しいサービス開発と迅速な経営判断のために、構造化データだけではなく、画像や映像などの「非構造化データ」を含めて、さまざまなデータの収集、活用を模索するようになった。そして、それらデータの因果関係を分析して、顧客の獲得や囲い込み、既存収益改善のサービス開発など、攻めの経営戦略につなげていくニーズが高まっている。

「一般企業も、こうしたデータ分析トレンドの変化に対応する必要がある」と話すのは、インサイトテクノロジー ビッグデータ・ソリューション事業部長の阿部健一氏だ。

例えば、顧客の行動データを分析して「ポイントカードAの会員には、別企業のサービスBを利用する可能性が多い」という因果関係が分かれば、サービスBでポイントカードAを使えるようにアライアンスを持つことで、それぞれのビジネスにおいて相乗効果を期待できる。

「このようなアクションは既に一部の企業では当たり前に行われているが、一般的な企業まで浸透していないのが事実である」(阿部氏)

人間の購買行動に因果関係を見いだすデータ分析の精度を上げるためには、自社データに加え、外部の行動分析につながるデータも必要になることが多い。また、それらデータに天気や気温などの外部環境変化のファクターに関するデータも加わると、大量のデータを高速に処理できる分析基盤が必要不可欠となる。ここでネックになってくるのが、新たに分析基盤を構築するのにかかるコストだ。

「一般的なリレーショナルデータベースマネジメントシステム(RDBMS)で高速な分析システムを構築した場合、データベースのライセンス費用や高価なストレージ費用など多額のインフラコストが発生する。100TBのデータを高速に分析しようとした場合、数億単位の費用がかかってしまうケースもある。また経営者としては、ROI(投資利益率)が見えない中で、分析基盤の構築に莫大(ばくだい)な投資をするのはリスクが高い。これらの要素により、多くの企業が次世代のデータ活用に踏み出せない一因といえるだろう」(阿部氏)

大量のデータを分析可能にする「Hadoop」、しかし高いハードルも……

こうした既存のデータ分析基盤の課題を解決するソリューションとして、近年注目を浴びているのが大規模分散処理フレームワーク「Apache Hadoop」(以下、Hadoop)だ。Hadoopは、大量データを扱う上で優れたスケーラビリティを備えており、クラスタ化での分散処理によって高い処理能力と可用性を担保する。また、市販のコモディティサーバによる構成ができ、IAサーバ3台からのスモールスタートが可能だ。そのため、ROIが見えにくいデータ分析基盤のPoC(Proof of Concept)として、最小限のコストで実現できる点が魅力となっている。

「Hadoopは、日本でも導入する企業が増えている。しかし、実際にデータ分析基盤として活用してみると、幾つかの課題が浮かび上がってきている」と指摘するのは、インサイトテクノロジー ビッグデータ・ソリューション事業部 マネージャーの平間大輔氏である。

「Hadoopでは、蓄積するデータ量により多量の分散サーバを利用するが、それらに対する運用面の課題がある。また、Hadoopはもともと大量データのバッチ処理をするための技術であり、分析用途に適しているとは言いにくい。実際にHadoopでデータ分析を行った場合、スピードは一般的なRDBMSよりも劣っている」(平間氏)

さらに、Hadoopでは、多くのアプリケーション開発者が標準的に使う「ANSI SQL」が使えないケースが多々ある点も活用における課題だ。Hadoopで今まで使われてきたMap Reduceは、SQLではなくJavaでプログラムを書く必要があり、Hadoop上でクエリ処理を行う「Apache Hive」(以下、Hive)や「Spark SQL」も全てがANSI SQLに準拠しているとは言いにくい。結果、既存アプリケーションを変更しないとHadoopで動かすことはできない。

これに加えて、Hadoop技術者が絶対的に不足している現状も、Hadoopをデータ分析基盤として活用する上での高いハードルとなっている。

「例えばSQLをかけるプログラマーが1000人いたらMap Reduceのプログラムをかけるプログラマーは1人位しかいないだろう。今までSQLを使っていたアプリケーション開発者がHadoopを活用する場合、新たな知識を習得しなければならない」(平間氏)

Hadoopの課題点を解決する「VectorH」

このように、ビジネスにつながるデータ活用を支えるための分析基盤には、大量のデータを低コストで処理できるHadoopのメリットを生かしながら、Hadoopの抱える分析スピードや運用性の課題を解消できるソリューションが求められている。こうしたニーズに応えるべく、インサイトテクノロジーが提供しているのが「Actian Vector in Hadoop」(以下、VectorH)だ。

「インサイトテクノロジーは、5年前からActianの総代理店となり、データウェアハウス向けデータベース(DB)製品『Actian Vector』(以下、Vector)を取り扱ってきた。Vectorは、分析に特化した高速なDBエンジンを搭載し、高レベルの分析パフォーマンスを実現する。ただし、サーバ単体で動作するDB製品であるため、スケールアウトが難しく高速処理できるデータ量は、約10TBまでに限られていた。そこで、VectorをHadoop上に展開し、容易にスケールアウトできる分析基盤として開発されたのがVectorHだ。これにより、Hadoopに格納されている大量のデータを超高速に分析処理できるようになった」(阿部氏)

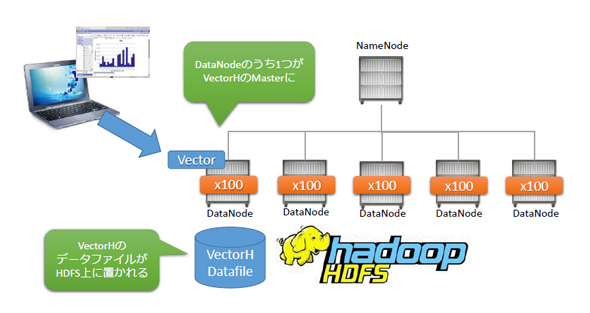

具体的な仕組みは、Hadoop上の各クラスタにVectorHの処理エンジンを組み込み、そのうちの1台にVectorH本体のSQLエンジンを配置する。併せて、VectorHのデータファイルを分散ファイルシステム「HDFS」(Hadoop Distributed File System)上に設置する。

「これによりユーザーは、Hadoopを意識することなく、一般的なRDBMSと同等の操作性で高速なデータ分析を行える。もちろん、ANSI SQLに準拠しており、Hadoop上にある大量のデータに対して、多くのプログラマーが使い慣れたSQLを使って分析を行うことも可能だ」(平間氏)

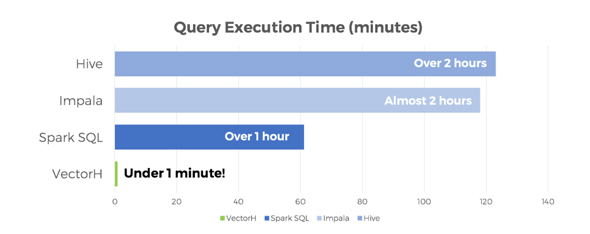

そして、VectorHの最大の特長は、Hadoopで課題となっていた分析スピードだ。

「米国TPC評議会(TPC)の認定するTPC-Hに合わせた形でActianが行ったベンチマークテストのパフォーマンス比較では、VectorHのTPC-Hベンチマークテストで使用するSQL(22個)の処理合計時間を1分とすると、Spark SQLは約60倍、『Impala』とHiveは約120倍以上かかる結果になった」(平間氏)

また、VectorHはコスト面についても活用メリットが大きい。

「VectorHは、Hadoop上にあるデータをそのまま分析に活用できる。このため、既存のHadoop環境を持っている場合、外部に新たに分析基盤を構築する必要がない。分析基盤のためのハードウェアやデータベース、インテグレーションにかかるコストを大幅に削減できる」(平間氏)

海外でもこのような分析ニーズの高まりに伴い、VectorHの導入実績も拡大しており、メーカーや流通業など、消費者向けにサービスや商品を展開している企業を中心に活用が進んでいるという。

Azure HDInsightと連携することで生まれる価値とは

インサイトテクノロジーではVectorHのさらなる導入拡大を目指し、日本マイクロソフトと協業して、クラウドサービス「Azure HDInsight」とVectorHを組み合わせたデータ分析ソリューションの提案にも力を注いでいる。阿部氏は、クラウドプラットフォームにAzure HDInsightを採用した狙いを次のように語る。

「新規でVectorHのデータ分析基盤を構築する場合、大量のIAサーバによる分散処理環境に投資する必要があり、運用、管理にかかる手間とコストが大きくなってしまう。そこで、VectorHをクラウドプラットフォーム上で展開できないかと考え、Azure HDInsightに着目した。Microsoft Azure(以下、Azure)は、非常にオープンで柔軟な思想のアーキテクチャとなっており、VectorHをクラウド展開する上で親和性の高いプラットフォームであると判断した」(阿部氏)

ユーザーは、VectorHとAzure HDInsightの連携ソリューションを活用することで、自社でサーバやストレージなどのハードウェアを用意することなく、VectorHによる超高速のデータ分析を行える。また、Azure HDInsightはフルマネージドサービスであるため、手間のかかるHadoopの導入、設計、運用管理、トラブル対応、メンテナンスなどの業務をアウトソーシングできる。これにより、CAPEX(資本的支出)をなくしOPEX(運用維持費)を大幅に低減可能だ。

この他に、日本マイクロソフトと協業するメリットについて阿部氏は、日本国内のAzureデータセンター基盤を拡張している点を挙げる。

「国内にAzureのデータセンター拠点が複数あるのは、クラウドプラットフォームとして信頼性がとても高く、安心してビジネスを行える」(阿部氏)

また阿部氏は、パートナー施策「Microsoft CSP(Cloud Solution Provider)プログラム」も協業のメリットとしている。Microsoft CSPプログラムを使うことで企業は、Microsoftのクラウドサービスを月額課金方式で再販が可能になり、自社の製品やサービスとMicrosoftのクラウドサービスをフレキシブルに組み合わせて新たな付加価値ソリューションを開発し、提供できる。

「Microsoft CSPプログラムを活用してVectorHの新たな付加価値ソリューション開発を検討したい」(阿部氏)

なお現在、Actianは、VectorHとAzure HDInsightとの統合化に取り組んでいる。現在の製品連携では、Hadoop上にデータを置いて利用する事を前提としているが、これをAzure HDInsightのAzure DataLakeに直接データを置いて分析できるよう開発を進めているという。

今後の展望について、阿部氏は次のように意欲を見せた。

「今後は、VectorHとAzure HDInsightの連携ソリューションによって、多量データを用いた高速分析を必要とするユーザーを全面的にサポートを強化していく。またユーザー企業のデータ活用をさらに促進するために、日本マイクロソフトとの協業による分析基盤構築のコンサルティングサービスなどを提供していきたい」(阿部氏)

一方、平間氏は次のように考えを述べた。

「データと、それを分析する人との距離を縮めるのがインサイトテクノロジーの使命だ。その意味で、VectorHとAzure HDInsightの連携ソリューションは、専門家でなくても、Hadoop上の生データを直接使って高速に分析が可能になる。分析結果によって、どんな未来を築くかは各企業の腕にかかっている。インサイトテクノロジーでは、その分析基盤をこれからも支え続ける」(平間氏)

なお、現在インサイトテクノロジーは、Azureを活用するパートナーのソリューションメニュー「Cloud Everywhere」を通して、データ移行ソリューションを提供している。データ移行や分析基盤の高速化について悩んでいる企業は、相談してみてはいかがだろうか。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

提供:日本マイクロソフト株式会社

アイティメディア営業企画/制作:@IT 編集部/掲載内容有効期限:2018年5月24日

インサイトテクノロジー ビッグデータ・ソリューション事業部長の阿部健一氏

インサイトテクノロジー ビッグデータ・ソリューション事業部長の阿部健一氏 インサイトテクノロジー ビッグデータ・ソリューション事業部 マネージャーの平間大輔氏

インサイトテクノロジー ビッグデータ・ソリューション事業部 マネージャーの平間大輔氏