リアルタイムに「答え」が得られるデータ分析の統合基盤を構築せよ――“DX時代のデータドリブン環境”の作り方:“データ活用の障壁”はこうすれば乗り越えられる

テクノロジーを活用して新たな価値を生み出すデジタルトランスフォーメーション(DX)。その推進は、ビジネスの核となる「データ」をどう扱い、どう活用するかがカギになる。だが、データの重要性を認識していながら、うまく活用できていない企業はいまだに多い。ではなぜデータ活用が進まないのか、何が阻害要因となっているのか――DX時代に求められるデータ活用の在り方と課題解消法を、アナリティクスにおけるデータマネジメント・ソリューション分野のリーディングカンパニーである米テラデータ・コーポレーション(以後テラデータ)のテクニカルプロダクトマネージャ、渡利洋子氏に聞いた。

DX時代の今、企業に求められている分析環境とは?

多くの企業でデジタルトランスフォーメーション(DX)の取り組みが進む中、データサイエンスやデータ活用基盤にあらためて注目が集まっている。ビッグデータがブームになった2012年ごろ、多くの企業が「Hadoop」などの新しいテクノロジーを活用したデータ処理基盤や分析基盤を採用した。だが、テラデータの分析プラットフォームソフトウェア「Teradata Vantage」のテクニカルプロダクトマーケティングマネージャである渡利洋子氏によると、「現在、その多くがRDBMSへと回帰している」そうだ。

その背景には、「ビッグデータがブームになったころのデータ分析」と、「今、DXで求められているデータ分析」とでは、企業ニーズに変化があるのだという。では、その「ニーズの変化」とは何か? 新たなニーズの実現を阻んでいるものとは何か?――

渡利氏は30年ほど前に渡米し、米インディアナ州の大学を卒業後、カーネギーメロン大学で修士号を取得。経営コンサルタントとしてデロイトに勤め、州政府の大規模な福祉システムのインプリメンテーションやビジネスインテリジェンス(BI)分野の仕事に携わった人物だ。デロイトを7年半務めた後、のちにSAPに買収されるBusiness Objectsに転職。SAPでは、SAPとBusiness Objectsを使ったアナリティクス製品を構築するプロジェクト/プロダクトマネージャーとして勤務。5年前に米テラデータ・コーポレーションに入社して以降、データベースやデータサイエンスを専門領域としている。

いわば、“エンタープライズにおける分析活動と分析環境の在り方”を知り尽くしているわけだが、グローバルで多数の企業のIT部門、業務部門と対話を重ねてきた渡利氏にとって、日本企業におけるデータ活用の課題はどう見えているのだろうか? 先の「DX時代のデータ活用に対するニーズ」も踏まえ、課題解消法を伺った。

DX時代のデータ活用を妨げる“3つの課題”とは

── 「データサイエンス」はDX推進における重要な要素として、多くの企業が注目しています。渡利さんは昨今のDXに対する企業の取り組み状況をどのように見ていますか。

渡利氏 DXはデジタル技術の活用によってビジネスプロセスやビジネスモデルを変えていくこと、または新しい事業を開拓することと理解しています。私自身、消費者として日常的にデジタルに触れています。今や、ほとんどの小売店がクーポンやポイントを使った集客、ロイヤルティープログラムなどにアプリを活用していますし、多くの銀行がアプリで預金の確認や送金ができるサービスを展開しています。米国では、UberやLyftはもはや生活の一部となっていますし、Uber Eatsによって今まで米国になかった出前も一般化しました。

こうしたデジタルセントリックな新興企業だけではなく、多くの既存企業もデジタル技術を活用して新しいビジネスモデルに挑戦しています。テラデータ社員としてこうした動きを見ていると、多くのお客さまが機械学習やAI(人工知能)を使った予測分析に興味を持つようになっていると感じます。自社の顧客にいかにより良いサービスを提供するか。そのためにデータやテクノロジーの力を使って、ビジネスチャンスを発掘したり、ビジネスプロセスを改善したりするアイデアを見つけたいと考えているのです。

── しかし、そのデータ活用につまずいている企業が多いのが現状です。データ活用の課題は何だとお考えですか。

渡利氏 よくある課題の1つとして「データを100%活用できていないこと」が挙げられます。社内にデータが存在し、アクセスできる状態でも、100%のデータを総合的に使って「答え」を引き出すことができていないのです。その背景には、さまざまなデータソース、データタイプ、データストアを総合的に管理・処理できていないことがあります。また、データ活用よりも「最新のテクノロジーの活用」に固執してしまい、「ツールを活用すること自体」に多大な時間と労力をかけてしまいがちなことも挙げられます。新しいツール、新しいアナリティクス・ソフトウェアは次から次へと出てきています。その複雑さが足かせになってしまっているのです。

2つ目の課題は「データサイエンスに長い時間がかかってしまうこと」。仮にデータサイエンスで新たなインサイトを発見できても、そこまでのプロセス――例えば予測モデルのトレーニングやスコアリングに時間がかかり過ぎてしまい、実ビジネスに適用するころにはモデルが古くなってしまうのです。

そして3つ目の課題は、テクノロジー活用が先行した結果、「データと分析を核とする“基本的なビジネスモデル”が欠落してしまうこと」です。手段としてのテクノロジーが目的化し、「データをビジネスにどう生かすか」が後回しにされているのです。

Hadoopを採用した多くの企業が利用をやめたワケ

── 確かにそうしたケースは多く聞かれます。では、なぜそうしたことが起こるのでしょうか?

渡利氏 それぞれに原因があります。1つ目の「データを100%活用できていない」原因は、アナリティクスやデータサイエンスの活用を主要ビジネス戦略目標の1つに入れていないためです。データドリブン経営に対する真の取り組みがなされていないということだと思います。

2つ目の「データサイエンスに長い時間が必要」となる原因は、アナリティクスを行うための環境にあります。多くのユースケース、データの種類とソース、言語とツールをサポートし、さまざまな種類の分析エンジンを柔軟に組み込めるアナリティクス環境はそう多くありません。新しいテクノロジーには未知の部分が多く、必要なテクノロジーを見極めるために試行錯誤を続けてしまうケースもよくあります。

また、多くのアナリティクス環境はエンタープライズ規模で実行しようとすると、パフォーマンスが低下することも多いのです。例えば数年前、多くの米国企業が従来型のデータウェアハウスを「Hadoop」に移行させました。しかし、そのほとんどは、Hadoopへの将来的な投資を停止したり、Hadoopでの分析をやめたりしています。理由は「期待したパフォーマンスを出せなかったから」です。

3つ目の「データと分析を核とする基本的なビジネスモデルが欠落する」原因は、従来のアナリティクス環境がセルフサービスの、ラボタイプの分析操作に対応していないことにあります。データサイエンスのために「データのサイロ」が生み出されてしまったり、分析のためにわざわざデータをデスクトップPCにコピーして分析したりといったことが行われています。これでは拡張性に乏しく、実行も簡単ではありません。

── つまり、現在は個人・部門レベルの分析ではなく、企業全体で大量多種のデータを組織的かつ効率的に分析するための「仕組み」が求められている。これが「ビッグデータブームのころのデータ活用」と「DX推進のためのデータ活用」に求められるものの違いというわけですね。そうした課題をテラデータはどう解決しようとしているのですか。

渡利氏 その手段となるのが分析プラットフォームソフトウェア「Teradata Vantage」(以下、Vantage)です。これは多数の企業で活用いただいてきた「Teradata Database」の後継製品であり、数多くのアップデートが施されたことで、3つのデータ活用の課題もうまく解消できるようにしています。

私はVantageのテクニカルプロダクトマーケティングマネージャとして、Vantageの価値をお客さまに説明することが仕事です。Vantageを使ったデータサイエンスを体験してもらう「Answers. World Tour」というハンズオン・イベントも複数の国で実施していますが、参加するお客さまの多くはTeradata Databaseに精通しています。そうした方々にVantageを利用してもらい、メリットを体感いただいているのですが、いつも皆さんには熱心にご質問いただくなど、非常に高い関心がうかがえます。

大規模かつリアルタイムに「答え」を得るためのアナリティクス環境

── Teradata Vantageにはどのような特長があるのでしょうか。

渡利氏 Vantageとは「パーベイシブ・データ・インテリジェンスを実現する唯一のアナリティクス・プラットフォームです」と説明しています。パーベイシブ・データ・インテリジェンスとは、「全てのデータを活用し、大規模かつリアルタイムに『答え』を得るためのアナリティクス環境」という意味です。Vantageには、前述した3つの課題を乗り越えることができます。

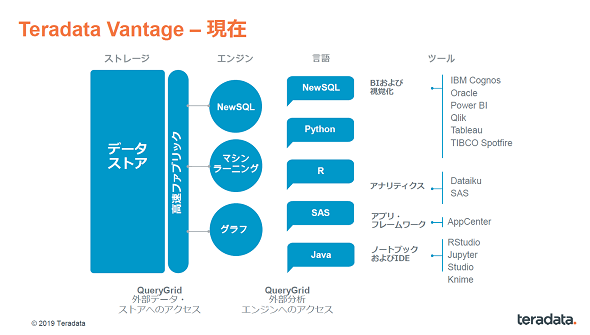

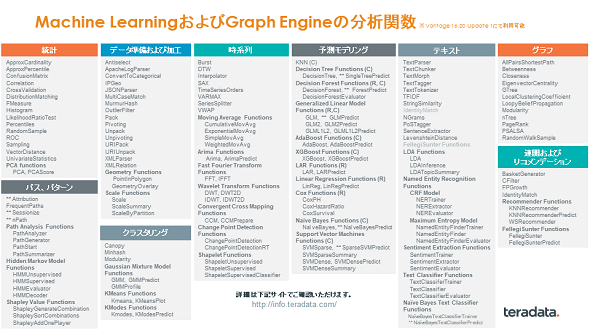

1つ目の特長は「全ての分析を1つの環境で行えること」。Teradata Databaseの分析機能を強化した「Teradata NewSQL Engine」に加え、新たにMachine Learning Engineと、データ加工から可視化まで行えるGraph Engineを1つのプラットフォームに統合し、単一のアナリティクス環境上で、180以上の事前構築済み分析関数から複数のアナリティクスをシームレスに行えるのです。

2つ目は「お好みのツールを、お好みの方法で使えること」です。使い慣れた既存の分析環境を全てVantageに置き換えてもらおうというわけではなく、Vantageをデータの格納場所および分析エンジンのプラットフォームとして使っていただくイメージです。具体的には、「Tableau」や「Qlik」といったBIツールはもちろん、「RStudio」「Jupyter」といったデータサイエンス環境にも対応しています。Vantage独自の分析機能をSQLを通さずに、RやPythonから直接実行することもできます。

3つ目は「全てのデータが分析可能なこと」です。さまざまなデータタイプ(JSON、BSON、XML、ABRO、CSVなど)と、フォーマット(構造化、非構造化)、異種混合データストア(Amazon S3、Azure Blobなど)を柔軟にサポートします。

―― なるほど。つまり、1つの統合されたシンプルな分析環境とすることで、データの多様性やデータのサイロ化、ツールの複雑性などに振り回されることなく、使い慣れたツールを使って、組織的に分析に集中することが可能になるわけですね。

渡利氏 はい。それがDXのためにデータ分析を行うエンタープライズにとって、重要な要件になると思うのです。そしてこの3つの機能を実現するために必要なのは「アジャイルなデータ基盤であること」です。これには6つの要素があります。「リニアなスケーラビリティ」「ミッションクリティカルな可用性」「クエリのパフォーマンス」「高度なインデックス」「適応オプティマイザー」「ワークロード管理」の6つです。

―― その6つは具体的にはどのようにアジリティに寄与するのですか?

渡利氏 通常のデータ基盤では、「データが増えればパフォーマンスが落ちる」という課題を抱えることが多いと思います。これに対しVantageは、ノードを足せば足すほど、容量もパフォーマンスもリニアに向上するアーキテクチャなのです。また、テラデータがアナリティクス専業企業として培ってきた40年以上にわたる知見と経験が凝縮されており、ミッションクリティカルな要求に耐える高い可用性と性能を担保しています。さらに、「適応オプティマイザー」機能により、さまざまなシステムやノードが追加された場合でも、接続先に合わせてパフォーマンスを最適化できる他、ノードが増えても、どこで何が処理されているか、適切にワークロードを管理することができるのです。

―― 最初にサイジングすることなく必要に応じてノードを足していけることは、スモールスタートして状況に応じてコスト効率良くスケールできるという点で、確かに“アジャイル”ですね。ビジネスを遅滞させることなく安定的にデータを処理できる点もエンタープライズには欠かせない要素です。

渡利氏 その意味では、データベースが巨大になるほど大量多種のデータに対して複雑なクエリを実行する場面が出てきますが、そうした状況でもスムーズにデータを扱える点もエンタープライズにとって大きなメリットになると思います。「Oracle Database」などの別システムにクエリを投げることもできる上、パフォーマンスも良好です。

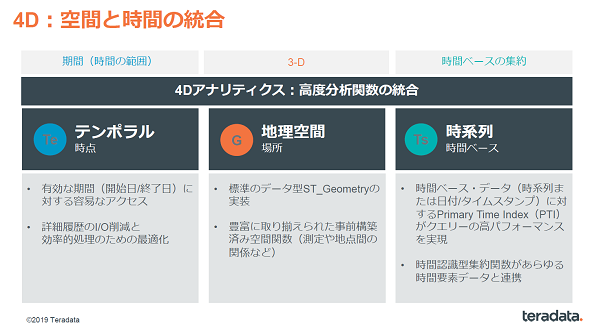

さらに「Primary Time Index」と呼ばれる新しいインデックスも利用できます。これを利用すると、時系列処理が極めて高速になり、さまざまなアナリティクスで効果を実感できます。

さらに「いま現在の情報(時点)」「地理空間(場所)の情報」「時系列の情報」を掛け合わせた「4D Analytics」――例えば、「いま現在、販売促進中の商品に対して購買意欲があり、自社のいずれかの店舗の近くに住んでいる、販促期間中に購買してくれそうな高付加価値顧客を特定したい」といった分析――が容易に高精度で行えることは大きな付加価値になると思います。

2.5億件のモデルスコアリングを22分で実行

── Vantageを使うことで、企業はどのようなデータ活用が可能になるのでしょうか。事例を教えていただけますか。

渡利氏 米最大手のモバイルプロバイダーの事例があります。同社は、SASやSPSS Modelerで顧客獲得の予測モデルを作成していましたが、そこにVantageが適用できないか検証しました。検証には具体的な基準も決められていて、例えば「データの移動/重複の抑制」「精度が64%以上」、パフォーマンスについては「100万件のモデルトレーニングが20分未満」「2億件のモデルスコアリングが30分以内」、さらに「アジャイルなモデルデリバリー」などがありました。

PoC(概念実証)で、Vantageはこれらの基準をクリアしました。精度はチューニングなしで64%、チューニングして69.8%を達成し、パフォーマンスに関しては100万件のモデルトレーニングが12分、2.5億件のモデルスコアリングが22分50秒でした。これはデータ移動や重複を極力避け、In-Databaseでモデリング/スコアリングを実施した結果です。お客さまからは「他のツールでは見たことがないパフォーマンス」との評価をいただきました。

── この企業はどのようなビジネスメリットを得たのでしょう?

渡利氏 それまで何日もかかっていた顧客獲得の予測モデルの作成を、数十分で実行できるようになりました。2.5億件のモデルスコアリングが22分50秒ということは、ほぼ米国の全人口を対象にしたモデル分析が22分50秒で実行できるということです。こうした処理を単一のアナリティクス環境で効率良く行えるようになったことにより、顧客解約率を劇的に下げることに成功したのです。

ハイブリッドも視野に入れ、「答え」の追求に集中できる環境を

── アクションを起こす「スピード」がビジネス最大の差別化要素となっている今、Vantageのパフォーマンス、効率性は確かに心強いですね。ただ日本では、IT部門などの現場スタッフがツールの有用性を認めていても、上の方に決裁を通すのが難しい傾向にあります。稟議(りんぎ)を上げる際のヒントがありましたら教えてください。

渡利氏 CIO(最高情報責任者)のような意思決定者は、自分の組織を通じて「ビジネス価値と収益の向上」に貢献することがミッションです。そのミッションに合わせて、“数字という彼らが使う言葉”に合わせてROIやビジネス価値を訴えることがポイントだと思います。

例えば、「価値を創出するまでの時間」や「価値を創出する上でのコスト削減額」などです。先の事例のように、「単一のプラットフォームで、数時間ではなく数十分以内に予測プロセス全体を実行できた」ということは、大幅な時間・コストの削減につながります。さらに4D Analyticsのような新しい予測モデルによって、かつてないほどの大規模な顧客獲得のチャンスを獲得できる可能性も高まっています。これらをうまく数字で訴えることが重要だと思います。

── 最後に、データ基盤刷新に向けて、まず何から着手すべきか、またどのようなロードマップを描いておくべきか、アドバイスをいただけますか。

渡利氏 まずは「統合されたデータとアナリティクスの基盤を構築すること」が先決です。「さまざまな言語やツール、分析エンジンごとの環境」ではなく、あらゆるデータをあらゆるユーザーに迅速に提供し、スピーディーに分析できる“統合された環境”を整備することが大切です。

その上で、ハイブリッドクラウド化を検討していきます。テラデータが最近行った調査によると、90%の企業が「2020年までにオンプレミス環境とクラウド環境の両方を活用する」と回答しており、ハイブリッドクラウドを想定することは必須になりつつあります。

Vantageは、Microsoft AzureやAmazon Web Servicesのマーケットプレースからすぐにクラウド環境に展開できます。クラウドのスケーラビリティを生かしながら、Vantageを「as-a-service」モデルによって、データ分析基盤の監視・管理、可用性の確保をテラデータに任せることができるのです。将来的にはこの「as-a-service」モデルを、オンプレミスに提供する計画もあります。

―― まずはVantageでデータ分析基盤を1つに統合することで、組織的かつ効率的に分析に取り組めるようになる。ハイブリッド環境で使えばスピードやコスト効率も追求できるようになる。さらに分析基盤の運用保守という“ビジネスにとって本質的でない部分”は全て任せることができる、というわけですね。

渡利氏 その通り。お客さまはDX時代に必要なデータドリブンな環境を実現――「答え」の追求のみに集中できるようになるのです。

◆テラデータについて

テラデータは、クラウド・アナリティクス・ソフトウェアのリーディング・プロバイダーです。データの力でビジネスや人々の生活をより良くします。テラデータは、全てのデータを大規模に活用して、リアルタイムにインテリジェンスを見つけ出します。また、アナリティクスを実現する際の課題となる、複雑性、コスト、リソース不足などを克服し、お客さまの最も困難なビジネス課題に価値ある「答え」を導き出します。この世界を、「パーベイシブ・データ・インテリジェンス」と定義し、実現していきます。

Amazonギフト券が当たる!アンケート実施中

本記事に関連して「テラデータ」と「Teradata Vantage」についてのアンケートを実施しています。回答された方から抽選で3名様にAmazonギフト券5000円分をプレゼントいたします。ぜひ下記アンケートフォームよりご回答ください。当選発表は発送をもって代えさせていただきます。

ログイン または 会員登録(無料)いただくとアンケートフォームが表示されます。オレンジ色の「アンケートに回答する」ボタンからアンケート回答をお願いいたします。

こちらのアンケートは終了しました

関連記事

- 「大量データから簡単に“答え”を引き出せる」は本当か?――テラデータに聞く、「ベンダーメッセージ、本当の話」

- クラウド、オンプレ、ハイブリッド――環境の移行に「一切左右されない」大規模データ活用基盤を実現した方法とは

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

提供:日本テラデータ株式会社

アイティメディア営業企画/制作:@IT 編集部/掲載内容有効期限:2019年9月26日

アンケート

米テラデータ・コーポレーション

米テラデータ・コーポレーション