「あらゆる環境でAIを」 インテルの“スケーラブルプロセッサ”は何が違う?:クラウドからエッジまで取り組む「AIコンティニュアム」を推進

「AI Everywhere」を掲げ、生成AIに代表されるAIの利活用を支援するさまざまなソリューションを展開するのがインテルだ。2023年12月に記者会見を開き、新たに提供を開始した「第5世代インテル Xeonスケーラブルプロセッサ」をはじめとする製品群や、今後のロードマップを明らかにした。

3つのフォーカスエリアで半導体リーダーとしての責任を果たす

生成AI(人工知能)やLLM(大規模言語モデル)など、AI関連技術の社会実装が急速に進んでいる。そうした中、インテルは「AI Everywhere」というビジョンを掲げ、企業の取り組みを支援するさまざまなAIソリューションを展開している。インテルの鈴木国正氏(代表取締役社長)は2023年12月18日に開催された記者発表会でこう述べた。

「インテルのCEO、パット・ゲルシンガーが『シリコノミー』(Siliconomy)を提唱しています。シリコン(Silicone)とエコノミー(economy)を足した造語で、『シリコンなくして経済成長なし、シリコンを理解することで経済、産業を成長させていく』といった意味です。これはインテルが半導体業界のリーダーとして社会や経済に果たす責任を表明したものでもあります。AI Everywhereは、クライアントからエッジ、データセンター、クラウドまでプラットフォームを問わず、AIを利用可能にする取り組みです」(鈴木氏)

日本は世界と比べて、AI活用やデジタル化で遅れが目立つ状況だ。インテルはこれまでも日本国内のデジタル人材育成に向けて「STEAM Lab」「AI Lab」などの教育プログラムを展開してきたが、これをさらに加速させるという。

「今後のデジタル人材育成に向けた3本の矢として『DXハイスクール』『STEAM/AI教育プログラムの充実』『自治体との連携』を進めます。取り組みを“点から線”、“線から面”へと拡大させています。インテルがフォーカスするエリアには『グローバルサプライチェーンの強靭(きょうじん)化』『ムーアの法則の継続』『AI Everywhere』の3つがあります。今後もそれぞれの取り組みを強化していきます」(鈴木氏)

2023年にインテルが発表したのは半導体設計企業Armとの協業や、半導体用ガラス基板の発表、高NA(Numerical Aperture:開口数)のEUV(Extreme Ultraviolet:極端紫外線)露光装置導入、LLMイニシアチブ、“AI Everywhere”などだ。半導体製造においては、グローバルな自社工場ネットワークやファウンドリー事業、外部ファウンドリーを活用しながら、現在量産出荷中の「Intel 7」や「Intel 4」、2023年に製造開始した「Intel 3」、2024年に製造開始予定の「Intel 20A」など、過去4年間で5つのプロセスノードを実現してきた。鈴木氏は「要素技術を多く持つ国内サプライヤー企業との連携をさらに強化していきます」と強調した。

あらゆる環境でAIを利用できる「AI Everywhere」の世界を

インテルがフォーカスする3つのエリアのうち、AIに関する重要戦略となるのが“AI Everywhere”だ。インテルの大野 誠氏(執行役員 経営戦略室長)は、次のように解説する。

「AIを『適材適所で多くのユーザーが利用できる技術』にしていきます。現在、AIに必要な学習やチューニングといったほとんどの作業をクラウドで処理していますが、今後、多様なユーザーのニーズに応えるためには、一部をユーザーに近いエッジやローカルで処理することを考える必要があります。コンピュータ処理の分散が進んでいく中でインテルは、『ヘテロジニアスで豊富な選択肢』『オープンなソフトウェア環境』『セキュリティ対策』を踏まえたソリューションを提供していきます」(大野氏)

これらのソリューションは「AIコンティニュアム」というコンセプトの基に成り立っている。ファームウェア、ソフトウェア、セキュリティのそれぞれが相互にドーナツのように連続して接続されているという発想だ。

AI Everywhereを実現するためには、ハードウェアに関する豊富な選択肢が必要だ。インテルはさまざまなユースケースに応えられるように、それぞれの演算処理に特化したCPU、GPU、FPGA、AI専用アクセラレータを提供している。もちろん、ソフトウェアについても対応している。

「ソフトウェア開発環境としての『oneAPI』は、1つのソースコードを、大幅なコード変換なく多様なハードウェアで動かすことが可能です。oneAPIのライブラリには最新のツール、最適化ソフトウェア、フレームワークが含まれます。中でも多くの実績のある『OpenVINO』はクライアント、エッジ向けに『TensorFlow』『PyTorch』といったAIフレームワークをサポートし、推論処理の最適化を図っています」(大野氏)

これらのハードウェア、ソフトウェアの能力を発揮するための土台となるのがセキュリティだ。

「データの準備からモデル構築、学習、ファインチューニング、推論というプロセスの全てを安全に機密に処理する必要があります。そのためにはさまざまな環境でデベロッパーやユーザーが安心して利用できるように堅牢(けんろう)なセキュリティ対策が必要です。コンフィデンシャルコンピューティングのための『Intel SGX』など、インテルはさまざまなセキュリティ機能を提供しています」(大野氏)

AI時代のプロセッサ「第5世代インテル Xeonスケーラブルプロセッサ」

前述したように、AIはクラウドだけでなくPCやエッジにまで拡大する見込みだ。大野氏によると、その背景には「ユーザー側の事情もある」という。

「ユーザーにとってはネットワーク環境の影響で『遠いクラウドで処理するよりもローカルで処理した方が遅延が少ない』ということもあれば、『クラウド側でAIを処理するとそれなりに費用がかかる』といった事情もあります。また、データプライバシーや法令順守に対応する必要もあります」(大野氏)

とはいえ、完全にクラウドから離れるのではなく、あくまでもバランスが重要だ。例えば大規模なLLMはクラウドで処理し、小振りな処理はローカルで処理するといった方式にすることで、「データをクラウドに送ることなく、AIサービスを開発、利用できるようになる」と大野氏は説明している。

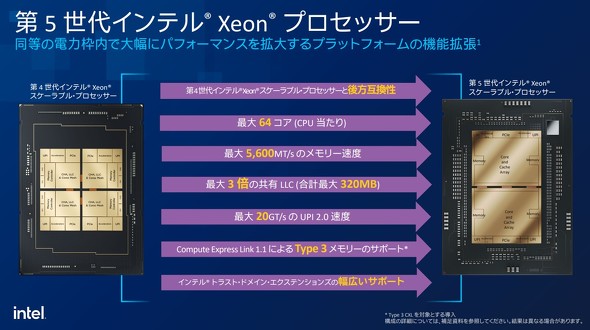

そうしたAI時代に向けた新製品としてインテルが提供するのが、第5世代の「インテル Xeonスケーラブルプロセッサ」(コード名: Emerald Rapids)だ。ワークロードに最適化されたパフォーマンスを発揮し、優れた電力効率を実現している。第4世代の「インテル Xeonスケーラブルプロセッサ」(コード名: Sapphire Rapids)と互換性(ピン互換)があり、既存システムはそのままでCPUだけを乗せ変えることが可能だ。インテルの町田奈穂氏(執行役員 技術本部長)は、こう説明する。

「CPUの最大コア数は第4世代と比べて4コア増え、64コアに。対応するメモリ速度は4800MT/sから5600MT/sへ、『Intel UPI2.0』についても、18GT/sから20GT/sへとそれぞれ向上しています。一番大きな変更点は、L3キャッシュを増加したラインアップがあることです。最大320MBと大きなLLC(Last Level Cache)を搭載しており、キャッシュサイズの大きさが鍵となるワークロードであれば、処理をかなり高速化できるでしょう。また、『Compute Express Link 1.1』によるType3デバイスをサポートします。さらに、これまで一部にしか提供していなかったセキュリティ機能の「インテル・トラスト・ドメインエクステンションズ」(TDX)が幅広いお客さまで利用できるようになりました」(町田氏)

性能面でのベンチマークとしては、AI推論パフォーマンスが、第4世代と比較して1.42倍、第3世代と比較して14倍となっている。電力効率は第4世代と比較してパッケージの消費電力当たりの性能が1.34倍に向上、アイドル時のソケット当たりの節電量は約100Wに及ぶという。

クライアント側でAI PCの展開が加速

AI推論などのパフォーマンス向上はさることながら、既存ユーザーにとっては前世代とピン互換製品という点が気になるだろう。コア数、キャッシュ容量が増加しているのに、性能と技術の改善の結果、第4世代と同じ消費電力で済む点も魅力的だ。

「CPUを乗せ変えることで高い演算能力を実感できるので、多くのお客さまに使っていただきたいと考えています。『Xeon』もAIに適した製品ですが、大規模な生成AIの学習はAI専用アクセラレータ『Gaudi』があります。2019年に発表したGaudiと2022年に発表した『Gaudi 2』はすでに生成AIモデルを開発している多くのお客さまに利用されています。特にGaudi 2については、クラウドサービス『Intel Developer Cloud』に導入済みで、すぐにクラウド上でAIの開発、評価を始めることができます。2024年には『Gaudi 3』が、2025年には次世代アクセラレータのリリースを予定しています」(町田氏)

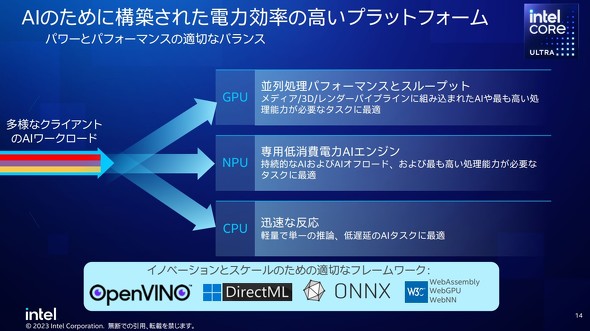

PC向けCPUとしては、「インテル Core Ultraプロセッサ」を提供している。インテル Core Ultraプロセッサは、「ニューラルプロセッシングユニット」(NPU)というインテル初の「クライアント向けオンチップAIアクセラレータ」を備えており、前世代と比べて2.5倍の電力効率を実現している。インテルの安生 健一朗氏(技術本部 部長 工学博士)は、こう解説する。

「PC製品としては初めて『3Dパッケージングテクノロジー』を採用し、インテルとしては初めてアーキテクチャの作りを変革しました。Intel 4プロセッサを採用しているため、消費電力もかなり抑えられています。NPUやGPU、CPUをフルに活用して、プラットフォーム全体でAIのワークロードを実現します。『OpenVINOフレーワーク』を使えば、ソースコードを書き換えることなく、NPU、GPU、CPUをインテリジェントに使い分けられるアプリケーションを開発可能です」(安生氏)

インテルは、「AI PCアクセラレーション・プログラム」として、2025年までに世界1億台以上のPC、100社以上のISV(独立ソフトウェアベンダー)へのAI導入を推進している。シリコノミーが進展する中で、AI Everywhereとしてあらゆる業務でAIを活用できることを目指すインテルは、クライアントやエッジ側で「AI PC」の展開を加速させる一方、データセンターやクラウド側でもXeonによるAI処理の高速化、最適化を強力に推進している。

AIを活用したい企業にとって、インテルのAI技術やAIソリューションは大きな助けになるはずだ。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

提供:インテル株式会社

アイティメディア営業企画/制作:@IT 編集部/掲載内容有効期限:2024年3月23日

インテルの鈴木国正氏

インテルの鈴木国正氏 インテルの大野 誠氏

インテルの大野 誠氏

インテルの町田奈穂氏

インテルの町田奈穂氏

インテルの安生 健一朗氏

インテルの安生 健一朗氏

第5世代インテル Xeon スケーラブル・プロセッサー搭載予定メーカー(富士通株式会社、日本ヒューレット・パッカード合同会社、日本電気株式会社)

第5世代インテル Xeon スケーラブル・プロセッサー搭載予定メーカー(富士通株式会社、日本ヒューレット・パッカード合同会社、日本電気株式会社)