日本語に強く、軽量でマルチモーダルな国産LLM「tsuzumi」の挑戦と将来ビジョン:“人間中心”のAI共生社会を目指して

ChatGPTの登場以降、世界各国で生成AI/LLM(大規模言語モデル)の開発競争が激化しているが、実はここ日本でも「国産LLM」の機運が高まっている。そんなムーヴメントをけん引する代表的な一社がNTTだ。NTT版LLM「tsuzumi」の開発をリードした、NTT人間情報研究所の西田京介氏に話を伺った。

ビッグ・テック「GAFAM」(Google、Apple、Facebook《現Meta》、Amazon.com、Microsoft)を中心に語られることの多いLLMだが、“言語による性能の違い”がしばしば取り上げられる。非英語圏、中でもここ日本においては日本語特有の難しさが顕著だ。

そうした中、2023年11月に日本語に特化した国産LLMが発表され、大きな話題になった。それが、NTTが開発したLLM「tsuzumi」だ。開発をリードした一人、NTT人間情報研究所の上席特別研究員、西田京介氏はこう話す。

「NTTでは従来、言葉を理解する研究や対話するための言語モデルの研究を進めてきていました。それでも『ChatGPT』が登場したときは、研究メンバー全員に衝撃が走りました。『これはとんでもないものが出てきた』と驚きつつ、一方では日本語処理に課題があることも分かりました」

NTTの研究開発成果と技術力を生かした、「これまでにない」LLMを

西田氏が所属するNTT人間情報研究所は「サイバー世界発展の急加速に伴う実世界とサイバー世界の新たな共生に関する革新的研究開発」に取り組んでいる。具体的には、音声情報処理、自然言語処理、行動モデリング、感性情報処理、サイバネティックス、ロボティックス、映像/3次元情報処理、AR/VR(拡張現実/仮想現実)、UI(ユーザーインタフェース)の研究開発などだ。

「私の専門は自然言語処理で、入所してからデータマイニングの研究開発に取り組んできました。2017年ごろからディープラーニングを自然言語処理に適用する機運が高まったことを受け、専門のグループを作りました。今はその成果を生かして、大規模言語モデルの研究開発を行う部署をリードしています。NTT人間情報研究所が目指す究極のゴールは、人間中心の社会にAIやICT(情報通信技術)の力を生かして社会のウェルビーイングを達成していくことです」(西田氏)

西田氏によると、tsuzumiの開発に当たっては、NTTが取り組んできた研究開発の成果を生かしながら「これまでにない」LLMの開発を目指したという。

日本語に強い――ベンチマークでも高い性能

tsuzumiの1つ目の特長について、西田氏はこう解説する。

「日本語処理性能については、NTT人間情報研究所において長年培ってきた言語処理研究の技術ナレッジを生かすことで、小さなパラメーターサイズでも各種ベンチマーク比較で高い精度が確認できています。例えば、生成AI向けのベンチマーク『Rakuda』を使った比較では、大規模なGPT-3.5と同程度の性能が出ています。また、『Japanese Vicuna QA』を使った比較では、2023年10月26日時点で国産LLMの中でトップクラスの性能を達成しました」

このような性能が出せた要因の一つは学習データにある。tsuzumiでは、オープンソースLLMの先駆け「LLaMA1」と同規模の1兆以上のトークン(単語)の学習データを使用している。また、データの種類として、金融や医療といったドメインを意識したテキストも学習データに加えている。そして何より、きれいで質の高い日本語のデータを集めることも意識したという。

「海外産LLMは学習データに、Web上から集めたノイズのあるデータで、0.1%しか日本語が入っていません。それでも、精度がある程度出ているので、質の高い日本語のデータをさらに加えることでより日本語処理性能の精度が高まるという期待がありました。NTT人間情報研究所では、以前から長きにわたって日本語のデータセットを作ってきたので、最大限に活用してtsuzumiを開発しています」(西田氏)

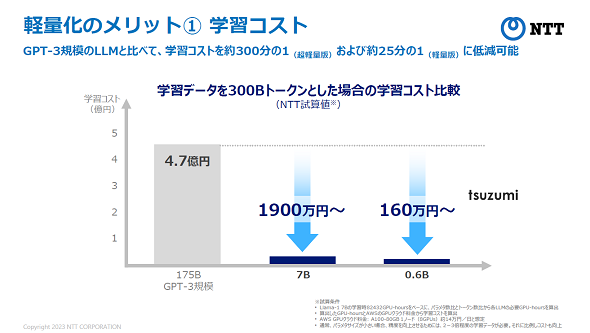

小型/軽量――GPT-3の約25分の1の学習コスト

tsuzumiのパラメーターサイズは、2023年11月時点で軽量版の70億(7B)と、超軽量版の6億(0.6B)の2種類を提供している。GPT-3のパラメーターサイズは1750億(175B)だから、その差は歴然だ。この差は学習コストに反映されるという。

GPT-3規模の学習には「約1300MWh(メガワット時)の電力が必要になる」とされている。これは原子力発電所1基1時間分の電力量に相当するが、tsuzumiなら25分の1程度で済む(7Bモデルの場合)。加えて、高額な設備投資につながる大規模なGPU(Graphics Processing Unit)リソースも少なくて済む。

「tsuzumiの軽量版は1つのGPU、しかも安価なGPUでも動作します。例えば、ゲーミングPCに搭載されているGPUでも問題ありません。超軽量版ではCPUだけで高速な推論動作が可能で、導入コストを大きく下げることができます。また、LLMは一度作って終わりではなくチューニングを続けるものですから、できるだけ小型な方が学習コストもかからず、ユーザーにとってうれしいことです」(西田氏)

チューニングの柔軟さ――ベースLLMの再学習が不要、特化型AIもカンタンに

「小型で軽量なら、お客さまの環境や扱いたいタスクに合わせてチューニングしやすくなります。また、AIに強みや個性を持たせやすくなり、特定の目的や用途に特化したAIを連携させることで巨大な一極集中型のAIモデルに対抗できるようになります」(西田氏)

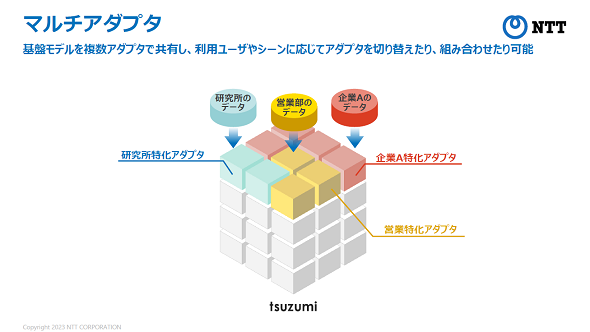

その柔軟さはチューニングの際に利用する「アダプタ」で実現するという。モデルのチューニングでは一般に「LoRA」(Low-Rank Adaptation、ローラ)チューニングという手法が用いられる。この手法を発展させ、事前学習済みモデルのパラメーターを固定したままアダプタのパラメーターのみを更新する方法を採用した。

「このアダプタチューニングによって、計算コストが高くなるベースLLMの再学習を行わずに学習でき、また『金融に強いAI』『議事録要約に強いAI』など、お客さまのニーズに合わせたチューニングが可能になります」(西田氏)

さらに2024年4月以降は、ユーザーやシーンに応じて複数のアダプタを柔軟に切り替えたり、組み合わせたりできる「マルチアダプタ」機能が導入される。これによって、企業内でも特定の組織や役職、権限に応じたきめ細かいチューニングを低コストで実現できるようになるという。

マルチモーダル――言語だけでなく、視覚や聴覚、状況なども反映

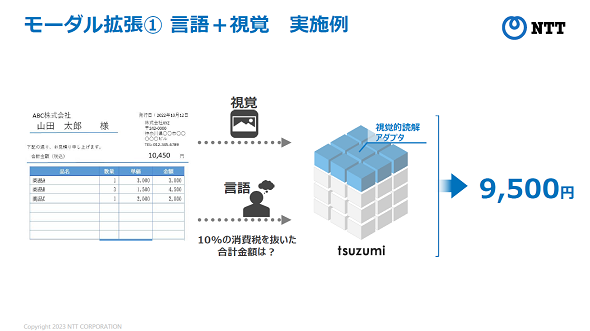

「マルチモーダル」は、マルチアダプタの技術を応用して実現するものだ。言語だけでなく、顔の表情といった視覚、音声のトーンやニュアンスなどの聴覚、ユーザーの置かれている状況などを理解できるようになる。

「以前から、視覚と言語を融合的に理解する研究に取り組んできました。例えば、業務ではPDFに書かれたテキストとグラフの情報を同時に扱いたいというケースが多い。言語と視覚を組み合わせたモーダル拡張によって、言語だけでなく、画像を提示しながらの質疑応答などが可能になります」(西田氏)

さらに今後は、さまざまなモーダルに対応する予定とのことだ。

「LLM開発は大小さまざまな企業でお互いにしのぎを削っている状況です。モーダル拡張についても学会発表や各社の研究開発活動などを含め、アカデミックとビジネス両方の知見とノウハウを取り入れることが重要です。NTTとしてどちらの土俵でも勝てる研究開発を進めていきます。また、その人材や技術もそろっていると自負しています」(西田氏)

tsuzumiは、2024年3月から商用提供が開始される予定で、既に電子カルテデータを使った医療データの分析や、コンタクトセンターにおける損害保険事故対応でのトライアルが始まっている。それぞれ京都大学医学部附属病院と東京海上日動火災保険がパートナーであり、こうした協業や共創はさらに広がっていく見込みだ。

「tsuzumi」の開発基盤として、マルチノード構成の「GPUクラスタ」を構築

このような数々の特長を持つtsuzumiだが、その開発はどのように行われたのだろうか。LLM開発には膨大な学習データを処理するためのハイエンドGPUが大量に必要となるが、NTT人間情報研究所でもtsuzumi開発基盤としてマルチノード構成の「GPUクラスタ」を構築して計算環境を整備していったという。そのインフラ面を支援したのがGPUクラスタの設計、構築に関する技術的知見と実績を持つNTTPCコミュニケーションズ(以下、NTTPC)だ。

「LLMを開発するにはたくさんのGPUが必要です。NTTPCさんにはディープラーニングの研究活動のときから相談に乗っていただいていましたが、今回もサーバ要件をはじめ、特にネットワーク構成について相談しました。クラスタ環境では、各GPUが協調して動作するためにマルチノード間をなるべく高速なインターコネクトで接続する必要があったからです。NTTPCの支援がなければtsuzumiをこれほどスムーズに開発することはできなかったでしょう」(西田氏)

tsuzumiの今後は、LLMとしての基本機能を充実させながら「ローカルで使いたい」「精度向上のためにRAG(Retrieval-Augmented Generation)を充実させたい」といったニーズに応えていく。また、IOWN(アイオン:Innovative Optical and Wireless Network)など、NTTが持つ技術と連携させ、遠隔地を結んだLLMの学習、運用などにも取り組んでいく。

NTTでは「AIコンステレーション」というキーワードを掲げている。コンステレーションは「星座」の意味だ。1つの巨大なLLMよりも、小型軽量で個性を持った複数のモデルが連携する方がよりサステナブルであり、小型LLMの集合知による社会課題解決を目指して研究開発を進めていくという。この小型LLMの連携基盤として重要な役割を担うのがIOWNだ。将来の展望について、西田氏は期待を込めてこう述べている。

「先日はロボットと連携するLLMも発表しましたし、メタバースとの連携や、リアルワールドで身体性を獲得したAIやロボットの研究も進めています。マルチモーダルや身体性をキーワードにLLMの対象領域を広げ、最終的には、人とAIが自然に暮らしながら、社会のウェルビーイングに貢献していくための研究開発に取り組んでいきます」(西田氏)

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

提供:株式会社エヌ・ティ・ティピー・シーコミュニケーションズ

アイティメディア営業企画/制作:@IT 編集部/掲載内容有効期限:2024年3月19日

NTT人間情報研究所

NTT人間情報研究所