Edge as a ServiceのGcoreに聞く、AIインフラの特性と日本市場へのビジョン:エッジAIとその実力を戦略的視点から読み解く

日本進出したGcoreが、AIインフラおよびソリューションプラットフォームの領域で新風を巻き起こそうとしている。既存パブリッククラウドでの実現を目指すものとは異なる視点で、さまざまなAI用途のイネーブラーになると断言する理由とは。

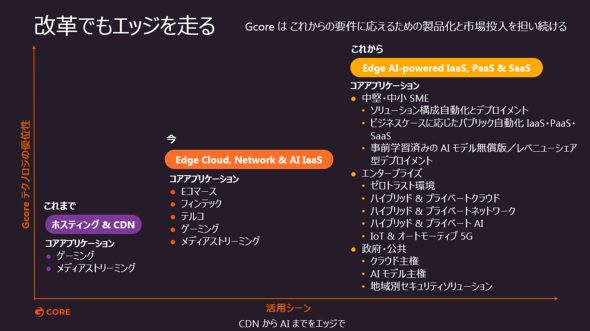

ルクセンブルク発のGcoreが日本に進出した。Edge-as-a-Serviceプロバイダーだが、「Cloud 2.0」として、AIインフラ提供者の世界におけるリーダー的存在になることが最重要目標だという。

Gcoreは、同社によると欧州でトップクラスのエッジサービスベンダーだ。約10年前にオンラインゲーム開発/運営会社Wargamingから分離独立。低遅延を武器に、CDNやストリーミング、エッジIaaS/サーバレスコンピューティング、DDoS保護をはじめとしたセキュリティなどのエッジサービスを提供している。PoP(接続拠点)は世界各地、180カ所以上にあり、拠点間をつなぐ通信バックボーンの帯域は約200Tbps。遅延はグローバル平均30ミリ秒だという。

なぜAIサービスに取り組むのか。「Cloud 2.0」とは何か。勝算はどこにあるのか。Edge Cloud&AI担当 プロダクト部門ディレクターのセヴァ・ヴェイナー(Seva Vayner)氏に、@IT編集部の三木泉が斬り込む。

三木 エッジサービスプロバイダーの間ではさまざまな形でエッジコンピューティングへの取り組みが見られますが、GcoreはAIにフォーカスしたサービスを主に推進していくということですよね。どういう経緯でAIに取り組むことになったのですか?

セヴァ・ヴェイナー氏(以下、ヴェイナー氏) 約10年前にゲームやエンターテインメントが求める低遅延への要求に応えることから始め、オンラインストアや一般企業へ顧客が広がる過程で、GPUの利用からML/AI、生成AIへとニーズが急速に変化してきたからです。2022年後半に、LLM(大規模言語モデル)の学習と推測用途に向けたインフラの提供を始めました。

当社はネットワークバックボーンを生かした「Global Intelligence Pipeline」と呼ぶエッジAIライフサイクル基盤を構築しています。顧客はGcoreのオブジェクトストレージにデータセットを格納し、GPUやIPU(Intelligence Processing Unit)を備えた強力なサーバノードを直接使えます。Managed Kubernetesのニーズにも応えています。さらに、開発者向けワークスペースやモデル構築、運用環境としてMLOpsプラットフォームを提供しています。

三木 ネットワークバックボーンを生かしているというのはどういう意味ですか?

ヴェイナー氏 学習済みのモデルがどこに置かれていたとしても、世界中のユーザーが低遅延でリアルタイムに使えるということです。LLMに対する推論リクエストがあると、LLMのコンテナワークロードがユーザーに最も近いPoPに自動配信されて稼働します。CDNと同様のスマートルーティングがなされますから、ユーザーはLLMの稼働場所の変更を意識する必要がありません。性能面では、既存のGPUやIPUに加え、推論パフォーマンスの高い「NVIDIA L40S」を世界中のPoPにデプロイしていきます。

一方で、世界のさまざまな国や地域が、データの所在に関する法規制の強化を進めています。こうした法規制を順守するため、モデルのバージョンによって稼働場所やアクセス可能な国や地域を限定することもできます。

三木 現時点でどういうユースケースがありますか?

ヴェイナー氏 例えば、あるスタートアップ企業は遺伝子解析にレントゲン写真の画像認識などを組み合わせた、健康診断サービスを行っています。ゲームやエンターテインメント、オンラインストアなどでのレコメンデーションなどもあります。MR(複合現実)やOmniverse(オムニバース)の取り組みも進み始めています。個人に関するさまざまな履歴データを関連付け、高度なレコメンデーションを行う取り組みも見られます。今後は自動運転のためのインフラをどう作るかも大きな課題になってきます。

三木 GPUリソースを提供するインフラプロバイダーはハイパースケーラーをはじめとして多数存在します。あらためて、そうした競合との違いはどこにありますか?

ヴェイナー氏 第1にネットワークバックボーンと信頼性の高いインフラを有しているという点です。世界中のどこでもLLMの学習、推論ニーズに応えられますし、データの保管場所もコントロールできます。

第2に、GPU不足の状況下でもリソースの迅速な確保が可能だという点です。例えば「NVIDIA H100」のクラスタを構築しようとすると、他の事業者ではデリバリーまで20〜30カ月と長い時間を要しますが、Gcoreでは2、3カ月でデプロイが可能です。NVIDIAとの強固なパートナーシップがあってこそ実現できることです。サーバベンダーとの関係も重要です。世界中で大量のハードウェアを調達する当社にとって、Dell Technologiesはかけがえのないパートナーです。

第3に、先ほど触れたAIライフサイクル基盤を有しているという点です。インフラ周りの面倒なことは全てGcoreが担うことで、エンジニアはAIアプリケーションの開発に集中できるようになります。

第4に、AIモデルをエッジで提供できるという点です。エッジAIは現在、そして今後に向けた非常に重要なトレンドです。Gcoreではこれに対し、ライフサイクル全体をカバーしたワンストップソリューションを提供できます。

三木 AIに取り組む企業や公共機関では、情報漏えいリスクへの懸念から、自前のコントロールできる施設でLLMを動かすことを検討しているという話をよく聞きます。PoPでは、こうした懸念に対応し切れないのではないですか?

ヴェイナー氏 確かにそれは看過できない重要なポイントです。Gcoreのサービスは、パートナーのデータセンターでも提供されるようになりました。一例として挙げると、ヨーロッパに近いコーカサス地方にある国の政府向けのITサービス事業者と提携し、このパートナーのデータセンターに導入するアプライアンスで当社のサービスを使えるようにしています。

当社は3種類のデプロイ方法を提供しています。当社がPoPで運用するクラウドインフラ、顧客のプライベートインフラ、そしてこの二者をまたぐハイブリッドソリューションです。ハイブリッドの場合、顧客は当社のPoP、プライベートインフラの双方にまたがる仮想リージョンを構成できます。

ローカルパートナーとの提携が重要

ヴェイナー氏 今、先に述べた国でのパートナーシップについて話しましたが、当社はハイパースケーラーになりたいわけではありません。私たちがグローバル展開で培ってきた技術やイノベーション、知識、ベストプラクティスをローカル市場に還元していきたいのです。ですから、大規模なインフラを展開し、多様なビジネスニーズに対応できる国内のクラウド事業者や通信事業者と連携していくことがとても重要だと考えています。

三木 そうですね。日本に先進的な技術を持ち込もうとするITベンダーは昔から多数存在していますが、必ずしも成功しない。理由としては、日本での個別のユースケースに対応するための努力が足りないことや、安心して使える環境を整備できないことが挙げられます。

ヴェイナー氏 信頼を獲得するということですよね。それは十分理解しています。その意味でもローカル事業者と組むことは不可欠だと考えています。

今後のAIインフラに求められるものとは?

三木 GcoreはAIインフラプロバイダーの世界でリーダー的な存在になりたいということですが、これについて詳しく説明してください。

ヴェイナー氏 はい。当社では、クラウドの市場成長は新たな局面を迎えると考えています。現在のパブリッククラウドサービスを「Cloud 1.0」と呼ぶとすれば、AIインフラプロバイダーは「Cloud 2.0」と呼べるものになると思います。これは従来とは異なる市場で、主要プレイヤーもCloud 1.0とは変わる可能性があります。

現時点では当社には、特にAIのエッジでの推論においては、他の追随を許さない大きな強みがあると考えています。今後、学習フェーズもさらに強化し、AIアプリケーションにおける開発者と企業の架け橋としての役割を果たしていきます。また、インフラだけにとどまることなく、産業別のソリューション展開についても計画を進めています。

もちろん、既存のメガクラウドもこの分野にシフトしてくるでしょうが、データやサービスの分散構成をどう実現するかで苦戦を強いられることになるはずです。

分散アーキテクチャは特に重要です。さまざまな企業の特定用途に対応するには、例えば70億パラメーターを持つようなLLMで推論を実行するのではなく、用途に合わせてファインチューニングし、軽量化する必要があるからです。さらに当社のアーキテクチャでは、先述したスマートルーティングによって、ユーザー企業が場所を気にすることなく、低遅延で推論に活用できるようになります。

今後必要とされるのは、現実の用途を確実に支え得る本当の意味で実践的なAI基盤とソリューションなのです。

※本稿は、TechTargetジャパンからの転載記事です。

Copyright © ITmedia, Inc. All Rights Reserved.

提供:Gcore Japan株式会社

アイティメディア営業企画/制作:@IT 編集部/掲載内容有効期限:2024年7月11日

セヴァ・ヴェイナー氏(Edge Cloud&AI担当 プロダクト部門ディレクター)

セヴァ・ヴェイナー氏(Edge Cloud&AI担当 プロダクト部門ディレクター)