日立、FPGA活用でビッグデータ分析を「最大100倍に高速化」する技術を開発:「サーバ数を確保しないと分析が進まない」課題を解消へ

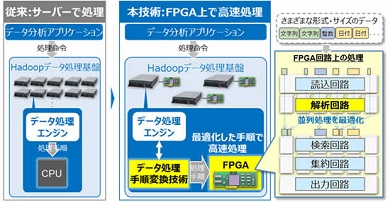

日立製作所は、FPGAを活用してHadoopによるビッグデータ分析を高速化する技術を開発した。同技術は、「FPGAに向けたデータ処理手順の最適化」や「データ形式を解析し、高速なデータ処理を行う回路の設計」によって実現した。

日立製作所(以下、日立)は2017年11月14日、FPGA(Field Programmable Gate Array)(注)を活用し、Hadoopを用いたビッグデータ分析を最大100倍に高速化する技術を開発したと発表した。同技術は、多数のサーバを使わずに高速分析を可能にするもの。「データサイエンティストが行うインタラクティブ分析」や「ビジネス現場での迅速な意思決定」「タイムリーな情報提供サービス」などを低コストで実現するという。

※注:製造後に購入者や設計者が構成を設定できる集積回路ハードウェア。

IoT(Internet of Things)センサーのデータや金融機関の口座取引記録、ソーシャルメディアの情報などの「ビッグデータ」を分析し、さまざまな業務やサービスに反映させるニーズが高まっている。こうした分析に、多くの企業がオープンソースソフトウェア(OSS)のHadoopを活用している。一方で、分析の高速化には多数のサーバを利用した分散処理が必要なため、機器の購入や維持管理のコスト増が課題になっていた。

今回、日立が開発したのは、「データ処理手順をFPGA向けに最適化する技術」と、「データの形式を解析し、FPGAで高速に処理する回路設計技術」の2つだ。

FPGA向けに処理効率を最適化

Hadoopのデータ処理エンジンは、CPUによる「ソフトウェア処理」を前提としているため、データの「取得」「検索」「演算」といったデータ処理手順を最適化している。一方、FPGAでは、ハードウェアによる「並列処理」が可能であり、Hadoopの処理手順をそのままFPGAで実行しても、FPGAの良さを生かすことはできない。

そこで日立は、Hadoopの処理手順を解析し、分散処理効率を考慮した上で、FPGAでの並列処理に適した順序に処理命令を変換する、データ処理手順変換技術を開発した。

データの形式を解析し、FPGAで高速処理

FPGAを使ったデータ処理では、従来、処理対象を「日付」や「数値」「文字」といったハードウェアで処理しやすいデータ形式に限定し、データの種類ごとに専用の処理回路を用意する必要があった。Hadoopの場合、例えば日付データでも「UNIX通日型」や「ユリウス通日型」など複数の形式を許容する。そのため、「FPGAに処理を実装する際に多くの専用処理回路が必要となり、回路規模に制限のあるFPGAを有効活用できない」という課題があった。

そこで日立では、Hadoopなどで一般的に利用される標準データフォーマット「Parquet」に対応したさまざまなデータ形式やサイズを判別する「解析回路」を開発。データ形式やサイズに応じ、複数のデータを1つの回路で処理するようにした。これにより、さまざまなデータ形式に対応しつつ、検索処理や集約処理などの回路を効率よく利用した並列処理が可能になり、データの処理速度が向上した。

金融や通信分野で実証実験へ

日立では、「新たに開発したこれらの技術を適用したHadoopでサンプルデータを分析した結果、データ処理性能を最大100倍に高速化できることを確認した」としている。これにより、高速分析に必要なサーバ数を大幅に削減し、Hadoopによるビッグデータ分析コストの低減が可能になるという。日立は今後、金融や通信などの分野で同技術の実証実験を進め、実用化を目指したい考えだ。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

第204回 人工知能がFPGAに恋する理由

第204回 人工知能がFPGAに恋する理由

最近、人工知能(AI)のアクセラレータとしてFPGAを活用する動きがある。なぜCPUやGPUに加えて、FPGAが人工知能に活用されるのだろうか。その理由を解説する。 PythonはFPGAアクセラレーションの裾野を広げるか

PythonはFPGAアクセラレーションの裾野を広げるか

FPGAによる演算処理高速化の恩恵をPythonユーザーが享受できるようにするための取り組みを、科学技術演算分野で南カリフォルニア大学が進めている。Cよりも10倍以上高速な結果が得られたケースもあるという。 今どきCPUだけで大丈夫?ビッグデータや人工知能でGPU/FPGAを使う前に知っておきたい“ハード屋”と“ソフト屋”の違い

今どきCPUだけで大丈夫?ビッグデータや人工知能でGPU/FPGAを使う前に知っておきたい“ハード屋”と“ソフト屋”の違い

ソフトウェア技術者の間でもGPUやFPGAに対する興味が高まっている。「ハードウェアの“特質”とは何か」「GPUやFPGAの性能を生かすソフトウェアは、どうあるべきか」@ITの人気連載「頭脳放談」の筆者に聞いた。