実は無関係じゃない、AI開発者も知っておきたい欧米のAI法規制・倫理と日本の現況:リリース直前、法律違反に気付くことも

AI利活用が広まる一方、法律や倫理の観点から問題提起されるケースが見受けられるようになった。企業のAIビジネス動向に詳しい弁護士の三部裕幸氏が語る、欧米の法律、AI倫理の動向と日本の現況とは。

AI(人工知能)の活用が急速に広まる一方、AIの開発やAIを活用したサービスの運用について倫理や法律の観点から問題提起されるケースが時として見受けられるようになった。Amazon.comが求職者の履歴書をスコアリングするAIを開発したところ、女性の求職者に対して不利な評価を判定してしまうことが判明し非難を呼んだことは記憶に新しい。

「AIは現在の日本の法律と相いれない部分が非常に多い。AIで何か新しい事業を始めようとすると既存の法律によって、これまでのビジネスでは生じたことのない法的障壁が出てきてしまう」

そう語るのは、欧米と日本のAI政策に詳しい渥美坂井法律事務所・外国法共同事業のパートナー弁護士である三部裕幸氏だ。三部氏は中央大学AI・データサイエンスセンターが主催した講演「文理融合の先端:AI技術と社会制度の関係」に登壇。欧米の法律、AI倫理の動向と日本の現況をテーマに語った。

三部氏はまず、昨今のAIビジネスで問題があると波紋を呼んだ事例としてイギリスの大学入試でAIを利用した際生じた問題を紹介した。

「イギリスではコロナ禍で大学受験生を1カ所にまとめて試験を実施するのはよくないと考え、従来とは異なる、高校教師の評価を基にAIが統計的に評価を標準化するプロセスを設けました。すると貧困地域に住む生徒の評価が低く評価されてしまいました」(三部氏)

その結果行きたい大学に行けない生徒が出てきてしまうなどの実害が発生し、社会的に非難を受けたという。また、一般データ保護規則(GDPR:General Data Protection Regulation)というEUの法律への違反も指摘された。

このように良かれと思って導入したAIが社会的非難を浴びたり、法律に違反したりして利用停止に追い込まれる事例は少なくない。今後AI利活用が広がる中でどうすれば問題を避けられるのだろうか。三部氏はAIを活用したビジネスを進める上で押さえておきたいポイントを2つ挙げる。

欧米が進めるAIの法制化、倫理のルール化

1つ目が、「欧米がAIの法制化、倫理のルール化を進めている」ことだ。前述の事例は欧米で既に問題視されているものだ。その関係で、欧米ではAIについて法律を作る、あるいは倫理をルール化する動きが出ているという。三部氏は「その欧米の動きに追従する形で、遅かれ早かれ日本でもAIに関するルールが整備されることになると予測されます。欧米の動きが日本にどのように影響するかを念頭に置かないとまずいことになる」と語り、欧米における法整備の状況は日本と決して無関係ではないと指摘する。

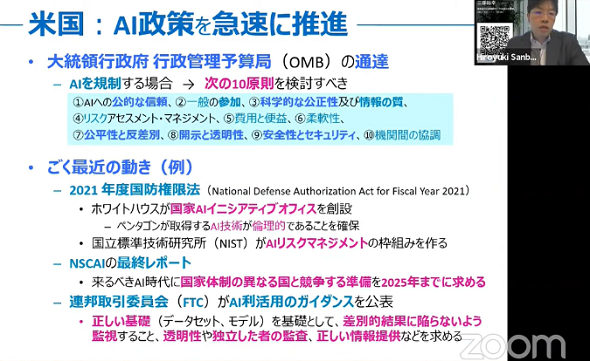

では、欧米ではどのような動きが出ているのか。三部氏はまず、アメリカのAI政策について解説した。

米国のAI政策――近年急速に法律を整備

米国はAI政策の整備に向けた動きを近年急速に進めているという。「具体的にそれが現れだしたのはトランプ大統領が任期を務めていた2019年ごろからです。バイデン氏が大統領になってからもその動きは変わらず、2021年の2月にバイデン大統領は『AIにルールが必要』と明言しています」(三部氏)

大統領の発言だけではなく、2020年に大統領府行政管理予算局が通達した「AI規制10原則」や、2021年に制定した国防権限法に記載された「ホワイトハウスが国家AIイニシアチブオフィスを創設する」「AIリスクマネジメントの枠組みを作る」という記述など、効力を持った法規制が進みつつある。

「米国というのは規制のない自由な取引を推進していく国だ、と認識されることが多かったのですが、その米国もAIの法律づくりに乗り出してきています」(三部氏)

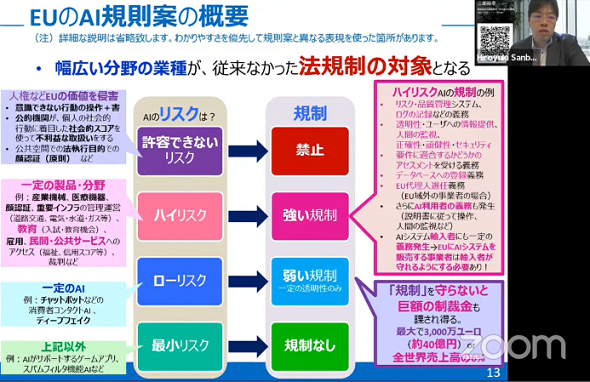

EUのAI政策――AI作成側、利用側双方への規制

次に三部氏はEUの状況について解説した。EUは法律と倫理の両面の具体化が進んでいるという。

このうち倫理については、2019年に公表された「信頼できるAIのための倫理ガイドライン」が重要だ。このガイドラインは「人間の自律」「安全性」「プライバシー」「透明性」「公平性」「幸福」「アカウントビリティー」からなる7つの原則を軸にさまざまな提言をしている。提言の中に企業がAIを活用する際のガバナンスについても言及しており、三部氏によると「EU圏内の企業や大学ではこれを受けて社内体制を整備し、AIのリスクマネジメントを実施する企業が目立つ」という。

法律の面では、2021年4月、「AI規制案」が公表された。「規則」という名称だが、EU全体に直接適用されるEUの法律案だ。三部氏は「AI規則案の発想は、懸念されるリスクのタイプを事前に考慮し、それに応じて規制内容を変えるというリスクベースアプローチ」だと述べる。リスク別に、許容できないほど高いリスクがあると判断されたものに対しては禁止、ハイリスクと判断されるものに対しては強い規制……という具合で分野ごとにリスクと規制の軽重を定義している。また、AIを作る側だけではなく、利用する側にも一定の義務を定めている。

「ここで重要なのは、AIを輸入する側にも一定の義務が発生するということです。輸入する側というのは、EUにいる人たちです。日本からAI商品やサービスを輸出する企業は、輸入者が義務を守れるようAI規制案にのっとったAIにしないとEUに向けたビジネスを展開できないということです。EU圏内の企業や研究機関などと取引がある日本の方々にはこれが直撃します」(三部氏)

AI規制案に違反した企業には最大で約40億円(3000万ユーロ)もしくは全世界売上高の6%の制裁金が科されてしまう。EU圏内の企業と取引をする予定のある企業は、日本企業であっても考慮に入れる必要がある。

「EUの法はAIの法と倫理両面の具体化に着手しています。それを欧州委員会という、いわばEUの内閣ともいうべき強大な権限を持つ機関がパワフルに進めているというのがEUの特徴です」(三部氏)

今の日本の法律にはAIを想定して作られたものはほとんどない

欧米のAI法規制について見てきたが、気になるのは日本の動向だ。三部氏は「欧米が意識するポイントについて、国策としての法制化・ルール化の動きはまだありませんが、先述の欧米の動きをみて、遅かれ早かれ日本も追従するのではないかと思います」と語り、日本のAIに関する法規制の動きを予想した。

「もし日本が欧米のAI法規制に追従しなかったとしても、欧米と同様の価値観を守るための規制や対処の動きは既に起きています。従って、欧米が守ろうとしているものを日本の企業や研究機関なども守らないと、日本のAIビジネスやAIの研究開発は欧米から受け入れられなくなり、国内でも立ち行かなくなってしまうでしょう」(三部氏)

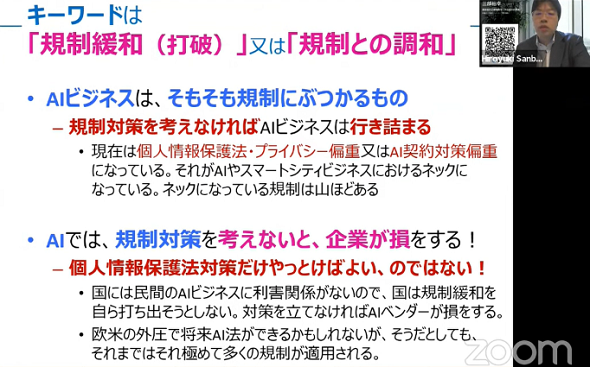

現在の法律と相いれないAI、どうすべきか

AIを活用したビジネスを進める上で押さえておきたいポイントの2つ目は、「AIは、現在の法律と相いれない部分が多い」ことだという。「日本に存在する法律の中でAIを想定して作られたものはほとんどない」(三部氏)ため、AIを想定していない既存の法律によって、AIを使ったビジネスができない、あるいはAIをうまく使うことが難しいという場面が出てきてしまう。

「AIは帰納的で人間の判断能力を超えることもする一方で、人類の歴史と価値観を理解することができません。AIは法律の想定外のこと、法律の背景にある価値観に合わないことをしてしまうことがあります。そのため、既にある日本の法律とAIが衝突に衝突し、法律に違反してしまうという問題が発生します」(三部氏)

日本の法律とAIが衝突してしまった際は、「規制」と「倫理」両方の観点から対策すべきだと三部氏は主張する。

中でも規制対策には3つの方向性があるという。

1つ目は、規制を守ること。2つ目は、そのままだと規制を守れない場合に技術をうまく工夫することで規制がかからないようにする、規制の技術的回避。これらが不可能な場合、3つ目の規制緩和を求めることも視野に入れる必要があるという。

AIを使ったビジネスをする際には、法律などによって開発、運用に規制がかかるかどうかに気を付けながら進めるべきだと三部氏は語る。AIを開発・利用する会社に法律や倫理の観点でアドバイスしている三部氏は、法規制を考慮せずにAIを開発したとある企業では、リリース直前に法規制などに問題がないかを確認したところ、法律への抵触が判明したケースがあったという。

「AIを開発する企業から相談を受けた際、私は問題ありと判断した場合、『法律に違反・抵触する可能性がある』、あるいは『法律には違反・抵触しないかもしれないけれど、所管官庁が問題点ありと指摘するかもしれないから先に話を聞いておく方がよい』と助言してきました。AIの研究開発や事業化を担当する企業の部門の方は『まさか、大丈夫でしょう』と、問題があるという認識が無かったのですが、その企業の方とともに官庁と協議したところ、やはり既存の制度に違反しかねないという指摘を受け、規制対策を企業と一緒に練ってきました」(三部氏)

AIビジネスとはそもそも規制にぶつかるものだと三部氏は語る。AIは求められる機能を提供するための学習をしているが、人間の価値観や歴史、法律を前提として判断することができない。また、前述の通りAIを想定して作られた法律は2021年の現在、ほとんどない。既にある規制との兼ね合いを、AIビジネスの構想段階から検討することが必要になる。

「個人情報保護法や契約に関する対策をしている企業は多いのですが、それだけでは不十分です。ビジネスを円滑に進め、企業が損をしないようにするためにも、AIビジネスをする際の法律との抵触・衝突などを視野に入れつつ、ビジネスの検討段階からAIの開発と同時進行で規制対策を検討することが大切です」(三部氏)

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

アカウンタビリティ(Accountability、説明責任)とは?

アカウンタビリティ(Accountability、説明責任)とは?

用語「アカウンタビリティ(Accountability)」について説明。ガバナンスと倫理の観点で、AIシステムの設計/実装の情報開示から結果/決定の説明までを行い、利害関係者に納得してもらう責任を指す。簡単に言うと、「AIシステムの挙動に対して、誰が/何が、責任を持つのか」を明らかにすること。 2021年の「AI/機械学習」はこうなる! 5大予測

2021年の「AI/機械学習」はこうなる! 5大予測

2020年は、自然言語処理(NLP)のTransformer技術に基づくBERT/GPT-3や、画像生成のディープフェイクが大注目となる一方で、倫理に関する問題がさまざまな方面でくすぶり続けた。2021年の「AI/機械学習」界わいはどう変わっていくのか? 幾つかの情報源を参考に、5個の予測を行う。 AI/機械学習の品質保証が抱える課題に開発者はどう対応すべきか

AI/機械学習の品質保証が抱える課題に開発者はどう対応すべきか

@ITは2019年11月19日、「@IT ソフトウェア品質向上セミナー 2019 冬〜不確実性が高まるDX時代のソフトウェアテスト/品質保証はどうあるべきか」を開催した。本稿では、AIプロダクト品質保証コンソーシアム 副運営委員長の石川冬樹氏の基調講演「『うちのAI大丈夫?』と言われた開発現場が慌てないための指針〜AIプロダクトと非AIプロダクト、テスト/品質保証の違いと共通点とは」の模様を要約してお伝えする。