信頼の置けるAIを実現するには:Gartner Insights Pickup(221)

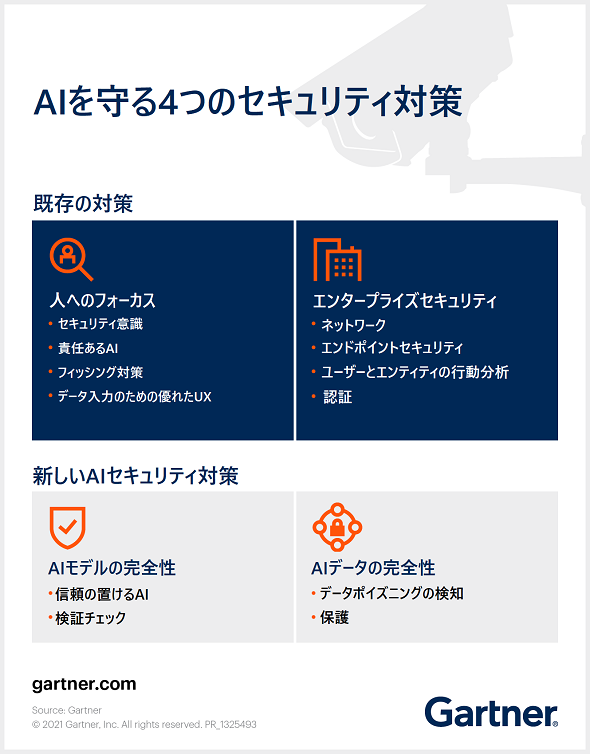

企業におけるAIを守り、AIが信頼の置けるものとして認識されるようにするために、新しいリスク軽減策を実施する必要がある。

ガートナーの米国本社発のオフィシャルサイト「Smarter with Gartner」と、ガートナー アナリストらのブログサイト「Gartner Blog Network」から、@IT編集部が独自の視点で“読むべき記事”をピックアップして翻訳。グローバルのITトレンドを先取りし「今、何が起きているのか、起きようとしているのか」を展望する。

抑圧的な政権は、市民を管理し、反対意見を抑え込む人工知能(AI)システムに精力的に取り組んでいる。この取り組みが成功すれば、政治的な抗議活動は街頭に出る前に鎮圧され、記憶の中にしか存在しなくなってしまうだろう。

それほど劇的ではないものの、企業におけるAIにも重大なリスクがある。例えば、次のような問題が起こる恐れがある。「AIによる不正確な信用評価のせいで、消費者が融資を受けられなくなる」「自動運転車のAIモデルが攻撃され、致命的な事故につながる」「データポイズニングの結果、銀行の住宅ローンの承認プロセスで特定の消費者層に不利なバイアスがかかる」

Gartnerの調査によると、AIを導入している企業はAI実装の最大の障壁として、セキュリティとプライバシーを挙げている。AIのセキュリティ脅威は新しいものではないが、企業ユーザーは十分に対処していない。

「ビジネス上の信頼が、エンタープライズAIの成功の鍵を握る」と、Gartnerのアナリストでディスティングイッシュト バイスプレジデントの、アビバ・リタン(Avivah Litan)氏は語る。

「だが、企業を適切に保護するセキュリティとプライバシーの基準やツールは、まだ整備の途上にある。そのため、ほとんどの企業は、脅威防御については主に自前の対策に頼らなければならなかった」(リタン氏)

新手の脅威の登場で新しい対応が必要に

一般的なソフトウェアに対する攻撃の大部分は、AIにも適用できる。これは、悪意あるハッカーによる被害を軽減するセキュリティおよびリスク管理ソリューションが、善良なユーザーがAI環境で犯したミスによる被害も軽減するということだ。また、機密データの漏えいやバイアスを防ぐソリューションは、バイアスがかかったモデルトレーニングによるAI倫理の問題を防ぐのにも役立つ。

AIを巡る新しい脅威には、さまざまなものがある。データポイズニングによって、意図的に、あるいはAIのトレーニング段階やAIモデルの実行中におけるミスによって“汚染された”データが、結果を操作する恐れがある。クエリ攻撃がAIモデルのロジックを決定したり、そのルールを変更したりする可能性もある。トレーニングデータやAIモデル自体が盗まれることもあり得る。

Gartnerは、脅威を軽減しAI投資を保護するための既存の対策に加えて、リスク管理の新しい二本柱を導入することを推奨している。

今すぐに取り組むべきAIセキュリティ

既存のシステムに新たにセキュリティを組み込むのは、最初からシステムにセキュリティを作り込むよりもはるかにコストが高くつく。このことはAIシステムにも当てはまる。

「不可避の侵害や情報漏えい、ミスによる被害が、自社のビジネスや評判、業績を損なうまで、手をこまねいていてはならない」と、リタン氏はアドバイスする。

「最初からセキュリティを考慮したシステムを作ることで、AIモデルの良好なパフォーマンスを維持し、データを確実に保護するとともに、モデルのバイアスや非倫理的な行為、誤った意思決定をなくす“責任あるAI”のサポートが可能になる」(リタン氏)

出典:How to Make AI Trustworthy(Smarter with Gartner)

筆者 Susan Moore

Director, Public Relations

Copyright © ITmedia, Inc. All Rights Reserved.