RLHF(人間のフィードバックによる強化学習)とは?:AI・機械学習の用語辞典

用語「RLHF」について説明。人間のフィードバックを使ってAIモデルを強化学習する手法を指す。OpenAIのChatGPT/InstructGPTでは、人間の価値基準に沿うように、言語モデルをRLHFでファインチューニング(微調整)している。

用語解説

RLHF(Reinforcement Learning from Human Feedback)とは、「人間のフィードバックからの強化学習」という名前の通り、人間の価値基準に沿うように、人間のフィードバックを使ってAI(言語)モデルを強化学習で微調整(ファインチューニング)する手法である。なお強化学習とは、フィードバック(報酬や罰)に基づいて学習する方法のことだ。

RLHFは、OpenAIのChatGPTやInstructGPTのモデルを訓練(トレーニング)するために使われている中心的な技術ということで注目されている。RLHFの特長は、人間の好みや意図といった「人間の価値基準」がAIモデルに反映されるため、AIモデルの出力がより安全・無害で有用なものとなることである。RLHFが採用されていなかったGPT-3モデルでは、倫理的に問題のある内容や、差別的で有害な内容、真実でない情報、単純に役に立たない情報などが出力される可能性がより高かったが、これがRLHFにより改善している。

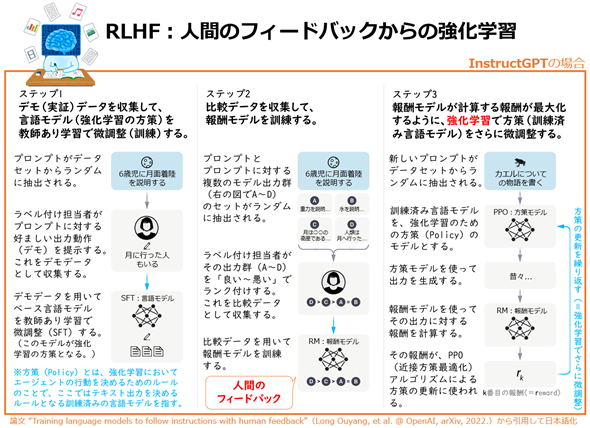

図1 RLHF(Reinforcement Learning from Human Feedback)のイメージ

引用論文“Training language models to follow instructions with human feedback”(Long Ouyang, et al. @ OpenAI, arXiv, 2022.)図内にある略語の意味は以下の通り。

- SFT(Supervised Fine-Tuning:教師あり微調整)とは、教師あり学習によりファインチューニング(微調整)する手法のこと。

- RM(Reward Model:報酬モデル)とは、 強化学習でのフィードバックとして使われる報酬や罰(ペナルティー)を計算するためのモデルのこと。

- PPO(Proximal Policy Optimization:近接方策最適化)とは、2017年7月にOpenAIが発表した(論文、OpenAIの公式サイト)、強化学習の訓練アルゴリズムの一つ。広く使われており、例えば「AIの強化学習の基礎を学ぼう:AWS DeepRacer入門」の記事で紹介したAWS DeepRacerでも使われている。

本稿で説明しているRLHFは、OpenAIが2022年3月に公開した論文『Training language models to follow instructions with human feedback』に基づいた内容(InstructGPTでのRLHF)となっている。ただしRLHF自体はそれ以前からあり、実際に、この「InstructGPTでのRLHF」は、2017年2月に公開された論文『Deep reinforcement learning from human preferences』(OpenAIの公式サイト)や、2020年9月に公開された論文『Learning to summarize from human feedback』(OpenAIの公式サイト)などを踏襲している(詳しくは元論文を参照してほしい)。また、ChatGPTでのRLHFもほぼ同様の仕組みとなっている。

図1は強化学習の知識がないと理解しづらいかもしれない。本稿の目的である用語を知るだけであれば、図1に示されているRLHFの仕組みを厳密に理解する必要はないだろう。用語の意味だけを押さえたい人は、図1に赤字で示した「人間のフィードバック」と「強化学習」が使われていることだけ確認してほしい。より厳密に理解したい場合は、ブログ記事「話題爆発中のAI『ChatGPT』の仕組みにせまる! - Qiita」がお勧めだ(筆者がネット検索して探した中では、最も詳しく解説しつつも分かりやすいと感じた)。

図1では「ベース言語モデル」と記載したが、これは「GPT-3モデル」のことである。なおInstructGPTは、1つのモデルではなくさまざまなバリエーションが作成されており、初稿の時点(2023年6月時点)ではGPT-3.5ベースのtext-davinci-003という名前のInstructGPTモデルがAPI利用者向けに公開されていた。2024年1月以降、InstructGPTモデルの機能は新しいモデルに統合され、GPT-4 TurboやGPT-4、GPT-3.5 Turboなどのより広範な機能を持つモデルが提供されるようになっている(最新のモデルについてはOpenAI公式のAPIリファレンスを参照してほしい)。ちなみにOpenAIは、プロンプト(テキスト)の指示(Instruction)への応答テキスト生成に最適化したAIを「InstructGPT」と呼び、チャット(Chat)用に最適化したAIを「ChatGPT」と呼んでいた。

ここを更新しました(2024年4月8日)

2024年4月8日:記事タイトルから英語表記を削除しました。また、InstructGPTモデルとしてGPT-3.5ベースのtext-davinci-003を紹介していましたが、2024年1月の時点で廃止(deprecation)されたため、最新情報に書き直しました。

Copyright© Digital Advantage Corp. All Rights Reserved.