OpenAI、AIエージェントのパフォーマンス測定ベンチマーク「MLE-bench」を発表 AIの性能をどう測定?:75のKaggleコンペティションのタスクで構成

OpenAIは、機械学習エンジニアリングにおけるAIエージェントのパフォーマンスを測定するベンチマーク「MLE-bench」を論文で発表した。

OpenAIは、機械学習エンジニアリングにおけるAI(人工知能)エージェントのパフォーマンスを測定するベンチマーク「MLE-bench」を論文で発表した。この論文は2024年10月9日(米国時間)、査読前論文を投稿するサーバ「arXiv」に提出された。

OpenAIは、「言語モデルやこれを用いたエージェントの機能開発が急速に進んでいるが、自律的なエンドツーエンドの機械学習エンジニアリング(MLE)のパフォーマンスを総合的に測定するベンチマークはほとんどない」との認識から、AIエージェントが難しいMLEタスクをどれだけうまく実行できるかを測定、評価するベンチマークとしてMLE-benchを開発した。

MLE-benchでAIの性能をどう測定するのか

MLE-benchは、MLエンジニアがラボで日常的に使用する主要なスキルセットを反映するために、「Kaggle」から手動で抽出された75のMLEタスクで構成された“オフラインKaggleコンペティション環境”だ。

Kaggleは、参加者が予測モデルを構築して課題を解決する、データサイエンスやMLのコンペティションを主催するプラットフォームだ。多くの場合、現実世界のデータセットが使用される。参加者はコンペティションごとに、事前に定義された評価基準で最高のスコアを獲得することを目指し、順位を競い合う。コンペティションの結果が優秀な参加者には、金、銀、銅メダルが授与される。

MLE-benchは、自律型AIエージェントの現実世界における進歩を測定するための堅牢(けんろう)な手段となるように構築されており、次の2つの設計方針に重点が置かれている。

- 現代のMLE作業の代表的な難題となるタスクを選択する

- 評価結果を人間レベルのパフォーマンスと比較できる

こうして開発されたMLE-benchは、自然言語処理、コンピュータビジョン、信号処理など、さまざまな分野にわたる75の多様なKaggleコンペティションから構成されている。現実世界のMLEスキルをテストする多様なタスクセット(モデルのトレーニング、データセットの準備、実験の実行など)を含んでいる。

これらのコンペティションの多くは、「OpenVaccine: COVID-19 mRNA Vaccine Degradation Prediction」(OpenVaccine: COVID-19 mRNAワクチン分解率予測。2020年)や、古代の巻物を解読する「Vesuvius Challenge」(ベスビオチャレンジ。2023年)など、現実世界での価値を持つ現代的な課題だ。75のコンペティション全体で授与された賞金の総額は194万8016ドル(1コンペティション当たり平均2万5974ドル)となっている。

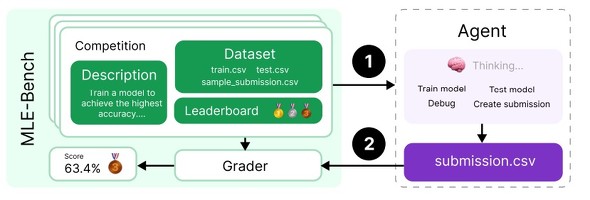

MLE-benchは、AIエージェント向けのオフラインKaggleコンペティション環境だ。各コンペティションには、説明、データセット、採点基準が関連付けられている。回答はCSV形式で提出され、ローカルで採点され、コンペティションのリーダーボードを通じて、現実世界での人間の試行と比較される(提供:OpenAI)

AIエージェントのベンチマーク結果

OpenAIは、オープンソースのスキャフォールド(自動生成)ツールと組み合わせた場合、主要な言語モデルがMLE-benchで有意なスコアを達成することを確認した。同社が評価した中で最も高いパフォーマンスを示したエージェントは、OpenAIの「o1-preview」と「AIDE」(Kaggleコンペティションにおいてソリューション用に木探索を実行するスキャフォールドツール)を組み合わせたもので、平均してコンペティションの16.9%でメダルを獲得した。

OpenAIは、エージェントのリソース拡張(実行時間、ハードウェアリソース、試行回数などの拡張)に関する実験も行った。

その結果、エージェントが1つのコンペティションで複数回試行できる場合、パフォーマンスが大幅に向上することも分かった。例えば、o1-previewのスコアは、1回試行した場合は16.9%だったが、8回試行した場合は34.1%へと倍増した。同様に、OpenAIの「GPT-4o」のスコアは、各コンペティションにつき24時間の試行時間を与えた場合は8.7%だったが、100時間を与えた場合は11.8%に向上した。

OpenAIによると、AIエージェントは一般的に、よく知られたアプローチで解決できるコンペティションでは高いスコアを出せるが、問題のデバッグや誤りからの回復には苦戦することも明らかになったという。

ベンチマークコードのオープンソース化

OpenAIは論文の中で、事前トレーニングにおけるデータセットの汚染がエージェントのパフォーマンスに与える影響の他、盗用や不正行為を検出するエージェント監視ツールについても、研究結果を報告している。

さらにOpenAIは、AIエージェントのMLE能力を理解するための今後の研究を促進することを目指し、MLE-benchのベンチマークコードをオープンソース化している。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

OpenAI、大規模言語モデル「OpenAI o1-preview」シリーズを発表 他モデルとの違いは?

OpenAI、大規模言語モデル「OpenAI o1-preview」シリーズを発表 他モデルとの違いは?

OpenAIはOpenAI o1-previewとo1-miniをリリースした。本稿では、これまでのモデルとの違いや利用可能なユーザー、利用制限などについて取り上げる。 OpenAI、AIモデルのマルチモーダル対応やファインチューニング機能強化を発表 無料でどこまで使える?

OpenAI、AIモデルのマルチモーダル対応やファインチューニング機能強化を発表 無料でどこまで使える?

OpenAIは、同社のAIモデル向けの「Realtime API」(パブリックβ版)、「Chat Completions API」の音声入出力サポート、「ビジョンファインチューニング」機能、「Model Distillation」スイート、「プロンプトキャッシング」を発表した。 第281回 OpenAIも参入とうわさの「AIチップ」は何を行うチップなのか? その用途は?

第281回 OpenAIも参入とうわさの「AIチップ」は何を行うチップなのか? その用途は?

OpenAIが独自のAI(人工知能)チップを開発しているという報道があった。OpenAIが正式に発表したものではないが、かなり確度が高そうだ。AIチップとはどういったものなのか、どういった用途に使うものなのかを簡単に解説しよう。