ネット広告のデータ分析プロジェクトはどのように行われるのか:経営を左右するデータ分析入門(終)

広告宣伝費を各宣伝媒体へのコスト配分を調整することで効率化したいという事業部の課題に対してデータ分析のプロジェクトはどう進められるものなのか。筆者の経験を基に紹介する。

これまで、連載第1回「4W1Hで分かる、ビジネスに本当に役立つデータ分析とは、どんなものか」、第2回「事例で分かるデータ分析プロジェクトの進め方の基本」を通じて、「データ分析そのもの」の中身、「データ分析プロジェクト」の中身を紹介してきました。今回は、データ分析プロジェクトのケーススタディを紹介します。

紹介に当たり、筆者の立ち位置をあらためて説明しておきます。筆者はリクルートテクノロジーズに所属しており、リクルートグループの事業会社に関連する各種のデータ分析を行っています。連載1回目の「Where」でいうと、筆者は少し特殊で、外部組織と事業会社内の中間的なところにおり、グループ内の各企業に対して、データ分析での課題解決をサポートしています。

「活用側に遠からず近からず」の距離感は、実は非常にデータ分析を進めやすいと、個人的には感じています。なお、今回紹介するケースは、読者の理解を妨げない形で、一部事実を変えていますが、ご了承ください。

企画概要――課題と背景

事業側の課題

広告宣伝費は、毎月数億円規模の支出であり、事業側としては大きなコストの一つである。これを、各宣伝媒体へのコスト配分を調整することで、効率化したい。

ここでの宣伝媒体とは、テレビなどのマス広告媒体やリスティング広告、ディスプレー広告などのネット集客媒体などを示します。

分析上の課題(事業側の課題から落とし込んだ、分析でクリアすべき課題)

効率の良い広告媒体に重点的に配分していくのは、極めて当たり前のことですが、実際は簡単ではありません。これを課題として切り分けると、大きく以下の2点でした。

【1】各広告宣伝媒体の「真のCPA」を見つけること

ネット広告であれば、各媒体の集客効率はCPA(Cost Per Acquisition、顧客獲得単価)などで計算できます。ただし、それをそのまま信じることは、通常は問題があります。具体的にいうと、「集客コスト÷コンバージョン数」で計算されたCPAは、以下のような要因が一切考慮されていません。

- 投下コストを増やしても、同じCPAが獲得できるのか?

- 景気や季節性の影響を受けていないのか?

- サイト改変の影響を受けていないのか?

- サイト上のコンテンツの影響を受けていないのか?

- 他の集客施策と同時に行われていることによる効果(相乗効果)はないのか?

- コスト効果が来期以降、残存することはないのか?(ストック効果)

統計モデルを用いると、これらの要因を総合的に考慮した上での「真のCPA」に近い値を求めることができます。

ちなみに、今回のケースにとどまらず、何らかの活動の結果得られた数値は、基本的には“うのみ”にしないことが重要です。特に、今回のCPAやCTR(Click Through Rate、クリック率)など、「何かを何かで割った値」は、「分母の数値だけが分子に影響を与える(他の要因は一切影響しない)」という強い仮定からの指標なので、安易に信じるのは危険な場合もあります。

【2】【1】をクリアした上で、「最適な」コスト配分を導くこと

上記の通り、真のCPAは単純な数値ではなく、統計モデルによって表現されます。これは、言い換えると「CPAは、さまざまな要因によって変動する」ことを仮定しています。

このモデルを、「数値的最適化」という数学的な手法に流し込むことで、何らかの目標に対して、機械的に最適化できるようになります。このケースでは、「目標のコンバージョン数を獲得するための、最も安い広告宣伝費の配分」を求めることができるようになります。

分析アプローチ(分析上の課題設定)

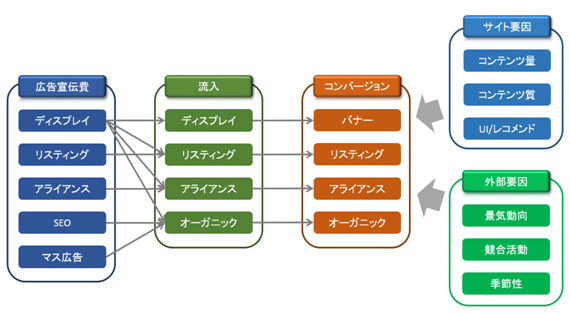

各媒体に広告宣伝費を掛けると、自社サイトへの流入が発生し、そのうち一部がコンバージョンになることが仮定されます。われわれのプロジェクトでは、この流れを統計モデルで表現することで、「可視化や予測、配分の最適化が可能になる」と考えました。

まず統計モデルを作成する手法として、リクルートテクノロジーズが技術として保有している「状態空間モデル」を用いました。また「数値的最適化」についても同様に、独自開発したモジュールを使用することにしました(後者は、厳密いうとデータ分析ではなく、エンジニアリングの領域です)。

ちなみに、このようなアプローチはデータ分析と“なじみ”が良い(定量化しやすい)ことから、過去から多く実践されています。ただ、実際はそう簡単ではなく、高い分析技術と実務(広告宣伝)に対する十分な理解が必要です。

一方で、今回のスコープ以外にも、いろいろなアプローチが考えられます。例えば、「クリエイティブを効果の高いものにする」「広告主と交渉し、広告単価を下げる」「広告効果の高い媒体を新たに探す」などがあります。しかし、これらのアプローチは定量化が難しく、データ分析とはあまりなじみません。

アウトプット

本プロジェクトのアウトプットとしては、「各施策の効果が、どれくらいであったか」「モデルの精度は、どの程度であったか」などをまとめたリポートと、作成したモデルから、最適な広告宣伝費配分を算出するためのツール、以上の2点としました。

今回のケースに限らず、実務で使うことを考えると、アウトプットとしてはリポートだけではなく、簡単なものでもよいので、ツールも作った方がよいと考えています。

期待された成果

過去の実績などから、広告宣伝費を数%削減できることが期待されました。これは、例えば「年間10億円の広告宣伝費を投下していた」として、期待された成果は「年間で数千万円のコスト削減」ということになります。

成果の大きさは、モデルがどの程度精度が高いか、現在の施策がどの程度効率的であるかに依存します。極端にいうと、現在の施策が非常に効率的である場合は、データ分析を行っても、高い成果を得ることは難しくなります。

このような背景のため、プロジェクト前に成果目標は設定しませんでした。それに代わり、「本プロジェクトのアウトプットを使って最適な広告宣伝費の配分を算出し、それを実際の施策とする」という「実験」を行い、そこで成果を測定することにしました。

スケジュール

モデルの作成と最適化ツールの作成に数カ月、その後上記の実験を行い、その結果によって運用を続けていくかを判断します。続ける場合は、その規模感を判断し、さらに数カ月かけてモデルの精度を上げるというスケジューリングで進めました。

座組み

コミュニケーション(2〜3名)

分析側から2名(筆者含む)、事業側で2名のメンバーで、プロジェクトのコントロールを行いました。このうち分析側は、分析作業計画の作成や、作業の進捗(しんちょく)管理、品質管理を担当し、事業側は意思決定者への説明・合意形成を担当しました。

このような座組みにより、分析側のユニットと事業側のユニットがそれぞれ効果的に作業を進め、かつ両ユニットがしっかり連携できる体制を目指しました。

サイエンス/エンジニアリング(2〜3名)

ここは、分析側組織のメンバーが担当します。このプロジェクトでは、サイエンス担当(アナリスト)がエンジニアリングを兼ねました。扱うデータがそれほど多種でなく、データ量もそれほど多くない場合は、このようにサイエンスとエンジニアリングをまとめることも有効です。

事業側

広告宣伝費をコントロールする部署の担当者と、その上司(意思決定者)が担当しました。分析時の事業側からの知見インプットと、実際の施策接続などの役割を担ってもらいました。

会議体

会議体としては、以下のようなものを設定しました。データ分析というと、「個別作業であり、あまりコミュニケーションを取らずに進める」ようなイメージがあるかもしれません。しかし実際はそれとは大きく異なり、諸所で多くのコミュニケーションが行われながら、プロジェクトが進んでいきます。

- 分析現場会議

分析作業やデータ処理作業などの分析にまつわる作業について、確認・議論する場。必要に応じて実施 - 分析側全体会議

分析結果や分析アプローチを、分析側全体として確認・議論する場。週1回実施 - 全体会議

分析側が分析結果を報告し、それに対して事業側からコメントをもらい、次の進め方について議論する場。週1回実施 - 事業内会議

分析結果を施策に活用するに当たって、具体的な接続方法などを議論する場。必要に応じて実施

分析作業

分析作業1:デ―タ収集・データマート作成

データを入手し、その内容を確認しながら、データマートを作成していきました。

今回、使用したデータは、広告宣伝費データ、自社サービスサイトへの流入数データ、コンバージョン数データ、景況感を表すマクロ経済データなどです。データ量はそれほど多くないですが、種類が非常に多く、またデータソースも異なります。

それぞれのデータについて定義を確認し、不整合がないか突き合わせを行いました。また、時系列で集計したデータを眺めて、数値がはねている部分や挙動がおかしい部分については、事業担当者に確認し、一つ一つ処理していきました。

分析作業2:基礎集計・仮説出し

整理したデータを集計し、また相関分析など簡単な分析にかけて、仮説を作成していきました。仮説はまず分析側で素案を作成し、それを事業側に提示し、実務の観点から感覚に合うかどうかなど、コメントをもらいながら仮説を練り上げていきました。

今回の仮説は、以下のような図(イメージ)で表現されました。この時点で、作成するモデルがある程度決まりますので、ここでスケジュールを再調整しました。

分析作業3:分析作業

ある程度仮説が整理されたところで、分析作業に入りました。分析側でモデルを作成し、それを毎週の全体会議で事業側に提示し、事業観点で議論を行い、それを基に仮説を修正し、分析側でモデルをブラッシュアップするというプロセスを何度か繰り返していきました。

なかなか精度が出にくいモデルもありましたが、試行錯誤を経て、誤差が数パーセント程度である精度の高いモデルを多く作成でき、そのモデルで算出される広告宣伝費の効果は、おおむね事業担当者の感覚に合うものとなりました。

上記の通り、モデルは、統計的な妥当性と実務担当者の肌感覚を合わせて、ブラッシュアップしていきます。ここはバランスが大事で、事業側の肌感覚に依存し過ぎると、肌感覚にモデルを合わせる形になり、分析の意味がなくなります。

さらに悪い場合は、事業側が持っているかもしれない「思い込み」に引きずられてしまい、間違った結論を導いてしまうリスクがあります。逆に、統計的な妥当性に依存し過ぎると、現実感のないモデルになってしまいます。ここをうまく進めるためには、お互い「ハラオチ」するまでしっかり話し合うしかないと筆者は考えています。

もう少し具体的にいうと、事業側は分析側のアウトプットに対して、自身の肌感覚との差異をコメントします。一方、分析側は、事業側のコメントに対して「なぜ、そう感じるのか」という質問をして、得られた返答から再度モデルを作成します。そこで得られた分析結果が、事業側の肌感覚を表現できている場合はそれで終了します。表現されていない場合、事業側はその理由を分析側から聞き、下記のどちらかを選択します。

【A】:そのモデルを受け入れて、自身の感覚も修正する

【B】:そのモデルを拒否して、新しい仮説を出して再度モデルを作成してもらう

【B】を選択した場合は、このプロセスをもう一度繰り返します。

このようなコミュニケーションを行うためにも、週1回という高い頻度での全体会議が必要だと考えています。

モデル完成後は、作成したモデルを使って実験を行い、ある程度効率的になるということが分かったため、精度を向上するための「モデル磨き」と、モデルを使った運用を続けていくことを決めました。これについては、別の機会で紹介できればと思います。

最後に

今回は、データ分析の実際の例について、一連の流れを紹介しました。データ分析がどんなものか、何となくつかんでいただけたら幸いです。また、今までの連載も併せて読むと、データ分析についての理解がより深まると思いますので、ぜひそちらもご覧ください。

Special Thanks to 広告宣伝費プロジェクトのメンバーの皆さん

著者紹介

青柳憲治

リクルートテクノロジーズ ITソリューション統括部 ビッグデータ部 ビッグデータ1G

筑波大学大学院ビジネス科学研究科企業科学専攻(博士後期課程)

大学卒業後、マーケティング・コンサルティング企業に入社。約8年間、広告効果分析を中心としたマーケティング関連データの分析業務に携わる。

2012年1月よりリクルート入社。リクルートグループ全体のマーケティングの高度化を目指してデータ解析チームを立ち上げ、現在に至る。

また業務の傍ら、筑波大学大学院ビジネス科学研究科(博士前期課程)・同大学院企業科学専攻(博士後期課程)に所属し、先端的な統計解析手法を用いた計量マーケティングをテーマとして研究に取り組む。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

ITエンジニアがデータサイエンティストを目指すには?

ITエンジニアがデータサイエンティストを目指すには?

それぞれの専門分野を生かした「データサイエンスチーム」を結成すればデータ活用への道は短縮できる。そのとき、ITエンジニアはどんな知識があればいい? データサイエンティストとして活動する筆者が必須スキル「だけ」に絞って伝授します。 Rは統計解析のブッシュナイフだ

Rは統計解析のブッシュナイフだ

今ほど統計解析が必要とされる時代はありません。オープンソースの統計処理言語・環境の「R」を使って実践的な統計解析のテクニックとリテラシーを習得しましょう! 読者にとってRは、世に溢れるデータの密林を切り開くための“ブッシュナイフ”となることでしょう(編集部) いまさら聞けないHadoopとテキストマイニング入門

いまさら聞けないHadoopとテキストマイニング入門

Hadoopとは何かを解説し、実際にHadoopを使って大規模データを対象にしたテキストマイニングを行います。テキストマイニングを行うサンプルプログラムの作成を通じて、Hadoopの使い方や、どのように活用できるのかを解説します 並列分散処理の常識をHadoopファミリから学ぶ

並列分散処理の常識をHadoopファミリから学ぶ

Hadoopをはじめ、Java言語を使って構築されることが多い「ビッグデータ」処理のためのフレームワーク/ライブラリを紹介しながら、大量データを活用するための技術の常識を身に付けていく連載 ビジネスインテリジェンスとは何か

ビジネスインテリジェンスとは何か

ビジネスインテリジェンス(BI)の概要を解説した記事が多くのメディアで取り上げられるようになり、その基本的な理解は深まったと思われる。このような現状を踏まえ、本連載ではさらに一歩踏み込んだ内容として、データ分析の手法や注意点に焦点を絞った実践的な解説を展開する。(編集部)