Googleが機械学習/AI活用で見せた「これまでとは違った景色」、トップ7:Google I/O 2018

Googleは「Google I/O 2018」で、同社サービスにおける機械学習/AIの活用によって、人々の生活を大きく変えられる可能性を示した。紹介された多数の新機能の中から、筆者の独断でトップ7を紹介する。

Googleは2018年5月8日(米国時間)、米カリフォルニア州マウンテンビューで開幕した同社の開発者向けイベント「Google I/O 2018」で、同社サービスにおける機械学習/AIの活用が本格化し、人々の生活を大きく変えようとしていることを示した。

2017年のGoogle I/Oで、Googleは「AIファースト」をうたい、同社のサービスプロダクト全般に機械学習/AIを取り入れていくと宣言するとともに、幾つかの例を提示した。今回のイベント初日の基調講演では、「サービスプロダクトのAI対応」という表現では収まらないような、斬新な機能が多数紹介された。

本記事では、機械学習/AIの実社会への適用という観点から、基調講演で紹介された多数の新機能の中から、筆者の独断でトップ7を紹介する。

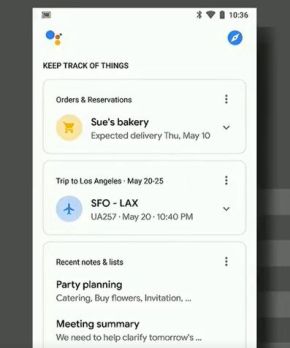

第7位 スマホのGoogle Assistantがアシスタントらしくなる

Google Assistantは、Android OSの機能、iOSのアプリ、Google Homeのエンジンといった形で提供されているパーソナルアシスタント機能。

その音声はこれまで1種類だけだったが、新たに6種が追加される。さらに音声合成に適用する機械学習の進化で、イントネーションをはじめとした話し方が、従来よりはるかに自然なものになる。

スマートフォン版は、元々検索結果を画面に表示するようになっているが、ビジュアル機能が大きく改善される。

まず、Google Nowの発展形ともいえるような、ユーザーの1日を要約した画面が新設される。予定、やるべきことリスト、宅配便の到着予定などの情報がまとめて表示されるという。

また、Google Assistantの画面を離れることなく、連携している家電を直接コントロールできる機能も搭載するという。

第6位 「Google Mapで方角が分からなくなる現象」とさよなら

Google Mapの経路案内機能を使う際に、自分の向いている方角と地図上の方角の関係が分からなくなることがある、任意の方向に少し歩いてみて、Google Map上でどう動いたかを確かめることになる。こうした煩わしさを解消する機能が搭載される。

自分の向いている方向にスマートフォンのカメラを向けると、現実の風景に重なる形で、Google Mapの経路案内がAR(Augmented Reality)的に表示される。このため、どちらの方向に行けばいいかがすぐ分かる。GPS(Global Positioning System)に加えて、画像と端末の位置関係で方角を割り出す技術を適用したのだという。同社はこれを「VPS(Visual Positioning System)」と呼んでいる。

第5位 Google Newsが「立体的」に進化

Google CEOのスンダー・ピチャイ氏は、「ニュースを生み出す業界にとって難しい時代になってきている。クオリティージャーナリズムを評価し、ビジネス的にも支援する手段が必要だ」と話した。そこで紹介したのがGoogle Newsの改革。ニュースの紹介方法を立体化するとともに、良質の記事にスポットライトが当たることによる好循環を生み出そうとしている。

Google Newsは便利だが、基本的には多数のネットユーザーが読んでいるニュースのキーワードを拾い上げ、「詳細」など多少のアクセントを付けて、そのキーワードを含む記事をリストするもの。ユーザーは好みのキーワードを登録して関連ニュースをフォローできるものの、平面的なサービスである感じは否めない。

担当者によると、Google Newsの改革には「ユーザーが自身の興味のあるトピックを追えるようにする」「1つのニューストピックをさまざまな角度から理解できるようにする」「好みのニュース媒体を購読しやすくする」という3本の柱がある。

具体的には、「For You(あなたのためページ)」というタブが新設され、各ユーザーが日常的に情報を収集しているトピックを自動的に学習、記事を表示する。

記事紹介の方法も立体的になる。1つ1つのトピックについて全方位的に紹介、背景や徐となる立場の意見が把握できるようにするという。

「For You」のトップでは、「ユーザーが興味を持ちそうな記事」「トレンドになっている記事」などのセクションが表示される。

また、それぞれのトピックに1ページを割り当て、「時系列的に展開を追う」「分析」「ファクトチェック」「よくある質問」などを分類して表示する。文字による記事に加えて、YouTubeなどの関連動画コンテンツも自動的に挟み込む。

Google Newsの改革では少なくとも、ニュースを読んで、理解を深めるために検索をするようなことが減ることを目指している。

一方、Googleは各種ニュース媒体と提携し、好みの媒体の有料購読がほぼワンクリックでできるようにしていくという。

第4位 「取り残されることを楽しめるように」

ピチャイ氏は、「FOMO(Fear of Missing Out)」(取り残されることへの恐怖)から、多くの人々はスマートフォンから離れられなくなり、重要なことに集中できなくなっていて、これが生活への悪影響をもたらしていると話した。そこで、「JOMO(Joy of Missing Out)」(取り残されることの楽しみ)を味わえるような体験を提供するという。

関連して、「ダッシュボード」では、スマートフォンの各サービスにユーザーが費やしている時間や通知の数、ユーザーがスマートフォンをアンロックした回数を可視化して示す。これにより、ユーザー自身が自分の行動を振り返りやすくなる。

また、YouTubeでは、長時間連続視聴し過ぎている際には、自動的に「休むべきではないか」と提案する機能も搭載する。同じくYouTubeなどの利用については、就寝前に視聴し始めて眠れなくなるという現象を防ぐため、設定時間を過ぎると自動的に画面がモノクロへ移行するといった機能も搭載するという。

新Android OS「Android P」では、「Do Not Disturb(邪魔をしないで)」というモードを新設。ソーシャルネットワークなどの通知を一時停止する。Androidフォンを裏返しにして(画面を下に)置くだけでで、このモードを自動的に有効化できる選択肢も、ユーザーに提供するという。

第3位 Google Mapで、「後悔しないレストラン選択」を目指す

Webでレストランを検索して訪ね、後悔することがある。人気であっても、自分にとっていいかどうかは分からない。こうした悩みに応え、Google Mapでは「Your Match」という機能を提供する。

過去にユーザーが書き込んだレストランのレビューをはじめとした行動履歴から、好みを細かく分析し、ユーザーがピックアップしたレストランのそれぞれが、そのユーザーにどれだけマッチしているかをパーセンテージで表示する。

一方、「Shortlist」という機能では、友人などと行くレストランの候補をドラッグ&ドロップでリスト化し、他のユーザーと共有し、即座に投票ができるようになる。

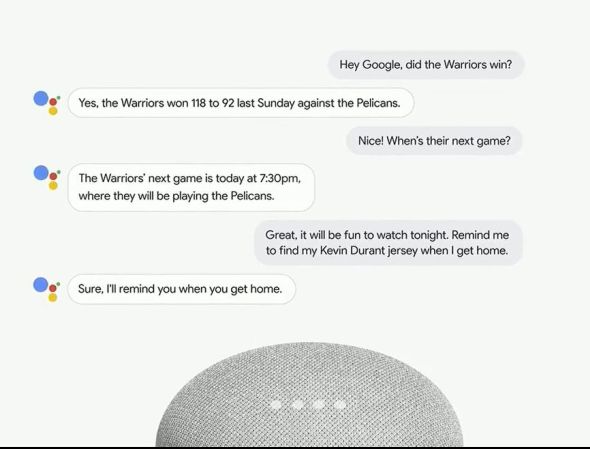

第2位 Google Assistantが、いちいち「Hey」などと呼びかけなくとも会話が続けられるようになる

Google Assistantが「人間臭く」進化し、会話が続けられるようになる。

Google AssistantやAmazon Alexaとのやり取りはまだまだ不自然だ。一番面倒なのは、ユーザーが何かを話し掛けるたびに、「Hey Google」「ねえ、グーグル」「アレクサ」といった言葉で呼びかけなければならないことだ。最近では同じトピックであれば、こうした呼びかけなしに次の質問ができるようになっているが、会話では同じトピックばかりを続けたいわけではない。

そこでGoogleが「今後数週間以内」に導入するのが「Continued Conversation」という機能。Googleは次のようなデモを見せた(下は日本語訳)。

ユーザー:Hey Google、(バスケットボールチームの)Warriorsは勝った?

Google Assistant:はい、この間の日曜日、WarriorsはPelicansに118対92で勝ちました。

ユーザー:よかった。次のゲームはいつ?

Google Assistant:Warriorsの次のゲームは今日の午後7時30分、Pelicansとの対戦です

ユーザー:そうか。今夜見たいなあ。家に帰ったらケヴィン・デュラン選手のジャージを見つけることを知らせて。

Google Assistant:はい、あなたが帰宅したときにお知らせします。

最後の部分は明らかにトピックがシフトしているが、Google Assistantはそれまでの会話との関連性を見出しながら対応している。つまり、個々の入力に対応した出力をすることから脱し、前の入力から(人間でいえば)文脈をバッファし、次の出力に生かしている。

また、この会話でユーザーが挟み込んでいる感想は、現在のパーソナルアシスタントでは無駄に反応してしまい、「よく聞き取れませんでした」「分かりません、もっと勉強します」といった返事によって会話が中断することが多い。このデモでは適切に無視している。

このように、複数の工夫で人間同士の会話の流れに近づけようとしている。日本語対応を含め、これが実際に機能するなら、大きな進化だ。機械を意識し、人間の側が気を使って話し掛けなければならない点は、おそらくパーソナルアシスタントについてユーザーが抱く最大の不満だからだ。

第1位 Google Assistantが、電話でアポ取りをしてくれるようになる

Google Assistantの新機能で最も印象的なのは、ユーザーに代わってレストランや美容室に電話をかけ、自然な会話で予約を取れるというものだ。

基調講演でGoogleは、次のようなデモを見せた。

ユーザー:火曜日の午前中、10時から12時の間に髪の毛を切る予約を取って。

Google Assistant:お安い御用です。すぐに予約を取ってお知らせします。

この後、Google Assistantは、ユーザーが行きつけの美容室に電話をかける。

店の人:もしもし、どんな御用でしょうか。

Google Assistant:クライアントの代理で、女性のヘアカットの予約をしたいので電話しました。5月3日のいつかを考えているのですが。

店の人:分かりました、ちょっとお待ちください。

Google Assistant:はぁい(英語では「Mm-hmm」と語尾を上げて表現、基調講演の会場では人間っぽさに笑いが起こった)

店の人:はい、何時頃をお考えですか?

Google Assistant:12時です。

店の人:12時は空きがありません。一番近い時間では1時15分が空いています。

Google Assistant:午前10〜12時の間ではどうですか?

店の人:サービスによります。どんなサービスをお望みでしょう?

Google Assistant:とりあえず女性のヘアカットだけです。

店の人:それでは10時が空いています。

Google Assistant:午前10時ならいいですよ。

店の人:その方のファーストネームは?

Google Assistant:ファーストネームはリサです。

店の人:はい、確かに承りました。リサさんが5月3日10時にご来店ですね。

Google Assistant:よかった。ありがとう。

店の人:はい。良い一日を。ありがとうございました。

このやり取りは、イントネーションが完璧であることも手伝って、「本当にGoogle Assistantでできるのか」と疑いたくなるほど人間らしい。「Mm-hmm」のような合いの手を入れるのは比較的やりやすいかもしれない。だが、ユーザーから午前10〜12時を指定されたにもかかわらず、最初は時間を言わずに話し掛けている点、「どんなサービスを望んでいるのか」と聞かれて「ヘアカットだけ」と答えている点など、予約の場面に特化して実際のやり取りのバリエーションをかなり学習させた結果と考えられる。

ピチャイ氏は、このやり取りに適用した技術を「Google Duplex」と呼んでいると説明。「当社が長年投資してきた自然言語理解、ディープラーニング、text-to-speechの技術をまとめ上げたものだ」としている。

Copyright © ITmedia, Inc. All Rights Reserved.