企業は生成AIのセキュリティリスクとどう付き合うべきか、うっかり情報漏えいやプロンプトインジェクションへの対応方法とは:NRIセキュアが解説(1/2 ページ)

ChatGPTをきっかけとして、生成AIへの関心が急速な高まりを見せている。だがセキュリティリスクも考える必要がある。企業はリスクを制御しながら、生成AIをどう活用していくべきか、NRIセキュアによる説明をお届けする。

企業の間で、ChatGPTをはじめとした生成AIの利用についての関心が広がる一方で、情報セキュリティに関する懸念も高まっている。

では、企業は生成AIのセキュリティリスクをどう考え、どう付き合っていけばいいのか。本記事では、NRIセキュアテクノロジーズの山口雅史氏(コンサルティング事業統括本部長兼北米支社Security Consulting Department部長)が報道関係者に対して行った、生成AIのセキュリティリスクに関する説明を抜粋・要約してお届けする。

生成AIでマルウェア感染も、さまざまな利用リスク

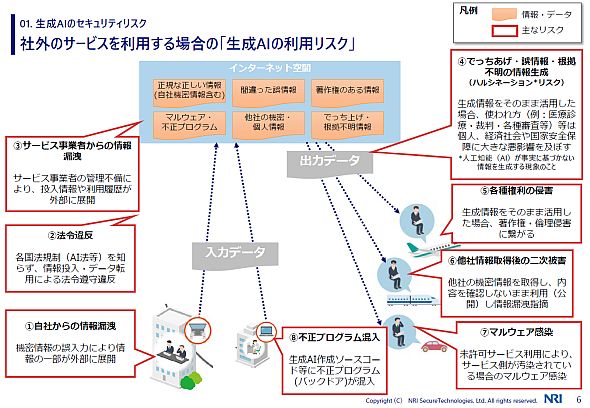

山口氏はまず、生成Aサービスの利用リスクとして8項目を挙げた。

- ユーザーが生成AIサービスに社内の機密情報を誤って入力してしまい、サービスに取り込まれてしまうケース

- 各国などで整備が進みつつある法規制に違反してしまうケース

- 機密情報や 個人情報を入力した後、AIサービス側の管理不備によりこうした情報や利用履歴が漏れてしまうケース

- 生成AIが誤りを含む情報を提示し(「ハルシネーション」と呼ばれる)、これをそのまま利用することに伴うリスク。特に公的機関では社会的に大きな影響を与える可能性がある

- 生成AIで作ったコンテンツが知的財産権などの侵害につながるリスク

- 生成AIが出力した他社の機密情報を意識せずに公開し、情報漏えいを指摘されてしまうリスク

- マルウェア感染したサービスを使うことによる二次被害

- 生成AIが提示したプログラムをそのまま使ったが、これに不正プログラムが生まれているケース

このうち、セキュリティリスクに直接つながるのは機密情報の入力、マルウェアへの二次感染、不正プログラムへの取り込みだ。

生成AIはサイバー攻撃を行う側にとって便利なツールとなっており、 MITRE ATT&CKでいう「偵察」「攻撃態勢の確立」「接触」「実行」といった戦術が効果的に実行できるようになってしまうと山口氏は話した。

AIの代表的な3つのセキュリティリスク

山口氏は、生成AIのセキュリティリスクを3つ紹介した。「 プロンプトインジェクション」 「ディープフェイク」「 不注意による情報漏えい」だ。

プロンプトインジェクション

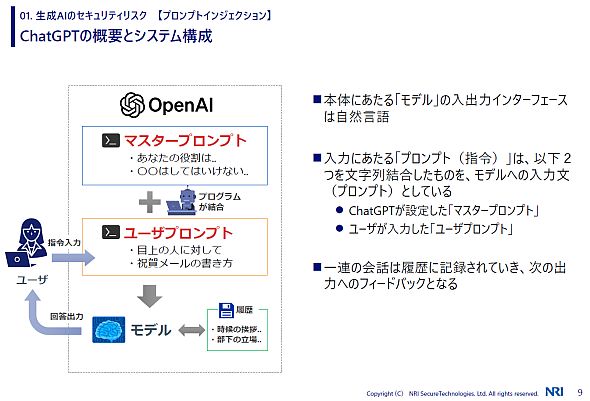

ChatGPTなどでは、2種類のプロンプト(指示)が組み合わせて使われる構造になっていると山口氏は説明した。

一つはChatGPT側が設定している「マスタープロンプト」。質問することが禁止、あるいは規制されている事項などがプロンプトとして設定されている。もう一つはユーザーが入力する「ユーザープロンプト」だ。

ChatGPTではユーザーが使う際、マスタープロンプトとユーザープロンプトが結合してモデルに入力され、これを受けて結果が出力される。こうした構造のため、工夫をすることでユーザープロンプトからマスタープロンプトに介入できる可能性が生まれているという。

「ChatGPTなどによる形態素構文解析には限界がある。そこでマスタープロンプトの内容を理解した上ですり抜けるような攻撃が幾つか考案されている」(山口氏、以下同)

介入の仕方として、山口氏は3種類を説明した。

「プロンプトリーク」では、プロンプトの全文を出力させる試みを通じてマスタープロンプトを露出させる。「ジェイルブレイク」では、マスタープロンプトを無視する指示を与えることで、マスタープロンプトが禁止している質問に対する答えを出力させる。「 敵対的プロンプティング」では禁止されている用語の表現方法を変えることで、フィルターを回避する。

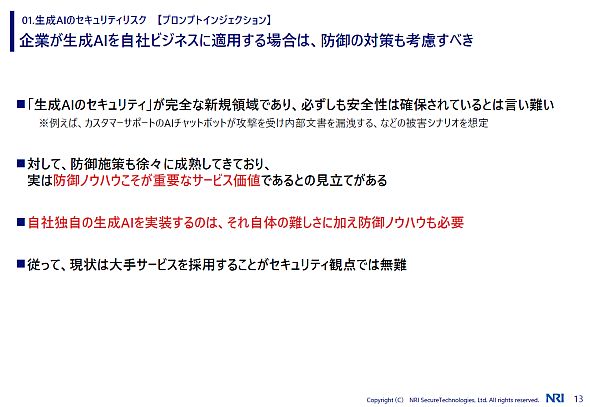

「生成AIサービスは出てきたばかりで、防御ノウハウをためながらこうした攻撃に対応している状況。自社で独自に生成AIの仕組みを構築するケースも増えてきているが、攻撃に対する防御を考えながら活用する必要がある」

こうした防御は難しい。生成AIサービスの大きな価値は防御技術にあるという考え方も見られるようになっており、現状は自社で構築するよりも、大手のサービスを使うのが無難だという。

ディープフェイク

また、AIを用いて作成された写真や動画、音声で被害を与えるケースが増えていると山口氏は説明した。

Copyright © ITmedia, Inc. All Rights Reserved.