34%の組織は生成AIリスク軽減のためのセキュリティツールを活用している Gartner調査:約4分の1の組織でプライバシー拡張技術も導入

Gartnerが発表した調査結果によると、34%の組織が生成AIに付随するリスクを軽減するために、人工知能(AI)アプリケーションセキュリティツールを既に使用しているか、導入しているという。リーダーやエグゼクティブを対象としたこの調査では、半数以上(56%)がそのようなソリューションを検討していると回答した。

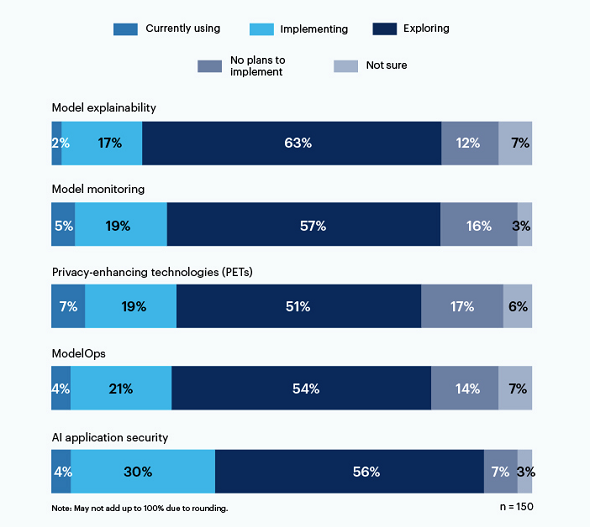

Gartnerが2023年9月13日(米国時間)に発表した調査結果によると、34%の組織が生成AI(人工知能)の付随するリスクを軽減するために、AIアプリケーションセキュリティツールを既に使用しているか、導入しているという。この調査では、半数以上(56%)がそのようなソリューションを検討していると回答した。

約4分の1の組織はプライバシー拡張技術なども導入済み

調査の対象となったのは、Gartnerのピアコミュニティーに所属する生成AIまたは基盤モデルを使用中、使用計画中、または検討中の組織のITおよび情報セキュリティリーダー150人。調査回答者の約4分の1がプライバシー拡張技術(PET)、ModelOps、モデルモニタリングを現在実装または使用していると回答している。

Gartnerのアナリストでディスティングイッシュト バイスプレジデントのアヴィヴァ・リタン氏は「ITおよびセキュリティリスク管理のリーダーは、セキュリティツールの導入に加えて、AI TRiSM(信頼、リスク、セキュリティ管理)の全社的な戦略の支援を検討しなければならない。AI TRiSMは、生成的なAI基盤モデルをホストするユーザーと企業間のデータとプロセスの流れを管理するものであり、組織を継続的に保護するためには、単発的な取り組みではなく、継続的な取り組みでなければならない」と述べている。

生成AIセキュリティの最終責任はIT部門にある

調査対象となったITおよびセキュリティ分野のリーダーの93%が、組織の生成AIセキュリティとリスク管理の取り組みに多少は関与していると回答しているが、この責任を負っていると回答したのはわずか24%だった。

一方、生成AIのセキュリティおよびリスク管理の責任を負っていない回答者のうち、セキュリティの最終的な責任はIT部門にあると回答したのは44%であった。また、回答者の20%は、組織のガバナンスやリスク、コンプライアンスを扱う部門が責任を負っていると回答している。

生成AIセキュリティの最重要リスク

生成AIに関連するリスクは重大かつ継続的であり、常に進化し続ける。アンケートの回答者は、望ましくない出力と安全でないコードが、生成AIを使用する際の最重要リスクであると述べた。

回答者のうち57%はAIが生成したコードから秘密が漏れることを不安視しており、58%は不正確な出力や偏った出力を懸念している。

リタン氏は「AIのリスクを管理しない組織は、モデルが意図した通りに動作せず、最悪の場合、人的・物的損害を引き起こす可能性がある。この結果、セキュリティの失敗や財政的、風評的損失、不正確で操作された、非倫理的で偏った結果による個人への被害が生じる。AIの不正出力は、組織がビジネス上の判断を誤る原因にもなりかねない」と語っている。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

2025年までにソフトウェア開発リーダーの半数以上が「生成AIの監督」を任される Gartner

2025年までにソフトウェア開発リーダーの半数以上が「生成AIの監督」を任される Gartner

Gartnerは、2025年にはソフトウェア開発リーダーの半数以上が、生成AIの監督を任されるとの予測を発表した。 優秀なCISOが取り組んでいる5つの行動とは? Gartnerが明らかに

優秀なCISOが取り組んでいる5つの行動とは? Gartnerが明らかに

高いパフォーマンスを発揮するCISOは、何に取り組んでいるのか。Gartnerが227人のCISOを対象に調査した結果を明らかにした。 生成AIは人間が思うほど賢くはないが、人間も同じだ

生成AIは人間が思うほど賢くはないが、人間も同じだ

生成AIのチャットエンジンから一見知的な返答があったと書くと、専門家から「単なる余興」「予測アルゴリズムの産物にすぎない」などとたしなめられる。だが、人間の知性は生成AIと比べてはるかに高いレベルにあるという、われわれの認識は正しいのだろうか。