Meta、テキストからの動画生成モデル「Emu Video」とマルチタスク画像編集モデル「Emu Edit」を発表:画像生成基盤モデル「Emu」がベース

Metaは、最近発表した画像生成のための基盤モデル「Emu」に基づく2つの研究成果を発表した。拡散モデルに基づいてテキストから動画を生成するモデル「Emu Video」と、マルチタスク画像編集モデル「Emu Edit」だ。

Metaは2023年11月16日(米国時間)、9月開催の「Meta Connectカンファレンス」で発表した画像生成のための基盤モデル「Emu」(Expressive Media Universe)に基づく2つの研究成果を発表した。拡散モデルに基づいてテキストから動画を生成するモデル「Emu Video」と、マルチタスク画像編集モデル「Emu Edit」だ。

Emu Video:2ステップでテキストから動画を生成

Emu Videoは、まずテキストプロンプトから画像を生成し、次にテキストと生成された画像から動画を生成する。この2段階アプローチにより、高品質の動画生成モデルを効率的にトレーニングできる。毎秒16フレームで512×512ピクセルの4秒間の動画を生成することが可能だ。

MetaはEmu Videoのデモページを開設し、単語を選択して動画を生成させたり、画像を選択してアニメーション化したり、AI生成動画を検索して閲覧したりできるようにしている。

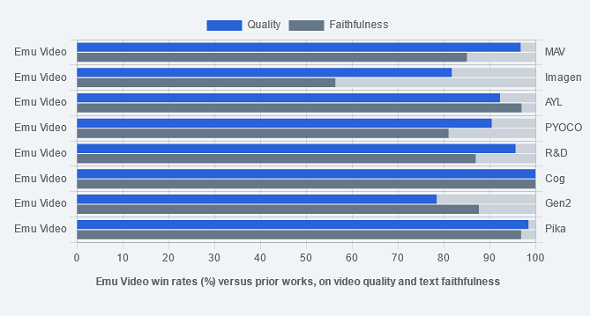

Metaによると、Emu Videoの生成動画と、先行モデルの「Make-a-Video」(MAV)、「Imagen-Video」(Imagen)、「Align Your Latents」(AYL)、「PYOCO」、「Reuse & Diffuse」(R&D)、「Cog Video」(Cog)、「Gen2」(Gen2)、「Pika Labs」(Pika)の生成動画の品質とテキストプロンプトへの忠実度について、比較調査したところ、Imagen以外はどちらについても、人間の回答者の70%以上が、Emu Videoの生成動画の方を好むと答えた。Emu VideoとImagenでは、品質については82%が、テキストプロンプトへの忠実さについては56%が、Emu Videoの生成動画の方を好むと答えた。

Emu Edit:認識タスクと生成タスクによる正確な画像編集

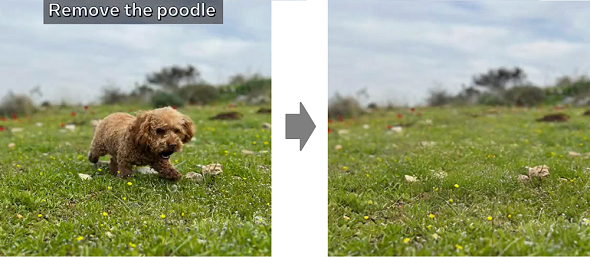

現時点では、テキストの指示に基づいて画像編集を行うモデルは、指示を正確に実行できない場合が多い。MetaはEmu Editで、さまざまな画像操作作業を効率化し、画像編集の精度を高めることを目指した。

そのために、ローカルおよびグローバル編集、背景の削除と追加、色とジオメトリの変換、検出とセグメンテーションのようなコンピュータビジョン(画像認識)タスクなど、指示による自由形式の広範な編集タスクをEmu Editに学習させた。これらは全て、生成タスクとして定式化されている。

MetaはこれらをEmu Editに学習させるために、1000万個の合成サンプルを含むデータセットを開発した。各サンプルには、入力画像、実行されるタスクの説明、目的の出力画像が含まれる。これは、こうしたデータセットとしては過去最大だとしている。

さらにMetaは、「コンピュータビジョンタスクを画像生成モデルへの指示に組み込むことで、画像生成および編集において前例のない制御が可能になる」と述べ、このことからEmu Editは、細かい編集指示を実行できる大きな可能性があると説明している。

またMetaは、Emu Editでは、幅広いタスクを効果的に処理するために、学習済みタスクの埋め込みという手法も導入し、生成プロセスを正しい生成タスクに導くために使用していると述べている。

数ショット(フューショット)学習により、画像のインペインティング、超解像、編集タスクの合成など、新しいタスクにEmu Editが迅速に適応できるようにしたことも紹介し、これはラベル付きサンプルが限られている場合や、計算予算が少ない場合に、大きな利点となるとしている。

Metaの評価では、Emu Editは現在のモデルよりも優れた性能を発揮し、さまざまな画像編集タスクの定性的および定量的評価で最先端の結果を示しているという。

Metaによると、Emu VideoとEmu Editは、基礎的な研究段階にあるが、技術的スキルがない人でも手軽に動画を作って利用したり、手持ちの写真や画像を編集したり、プロのクリエイターが作業に役立てたりといった潜在的なユースケースが考えられるという。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

生成AI入門:議事録を答えるチャットAI(RAGアプリ)を作ってみよう【プログラミング不要】

生成AI入門:議事録を答えるチャットAI(RAGアプリ)を作ってみよう【プログラミング不要】

生成系AIの導入が急速に広がる今、その有用性や活用法が気になる方へ。一例としてプログラミング不要で、“会議の議事録を基に質問に答えてくれる「独自のチャットAI」”の作成を試みます。社会人の目線で、実践的な生成系AIの雰囲気をつかみましょう! Stability AI、「LLaMA」ベースのオープンLLM「FreeWilly」を発表

Stability AI、「LLaMA」ベースのオープンLLM「FreeWilly」を発表

Stability AIと同社のCarperAIラボは、オープンにアクセスできる新しい大規模言語モデル(LLM)「FreeWilly1」とその後継の「FreeWilly2」を発表した。 OpenAI、画像生成AIの最新版「DALL-E 3」を発表

OpenAI、画像生成AIの最新版「DALL-E 3」を発表

OpenAIは、画像生成AIの最新版「DALL-E 3」を発表した。テキストに忠実な画像を生成する能力が飛躍的に向上している。