今日から始められる「生成AI」活用――Microsoft、Google、AWSの最新サービスを整理する:各社の担当者が紹介

システム運用をテーマにしたオンラインイベント「Ops Summit 2023」が開催された。大きな注目を集めた生成AIをテーマに、Microsoft、Google、AWSの担当者らが、どのような生成AIサービスを提供しているのか解説した。

フィックスポイントは、2023年11月29日に1日限定のオンラインイベント「Ops Summit 2023」を開催した。Ops Summitでは例年、システム運用に関連したテーマが取り扱われるが、2023年に大きな社会的関心を集めたAI(人工知能)を軸に「AIとシステム運用の未来」をテーマとしたさまざまなセッションが設けられた。

2023年はOpenAIの「ChatGPT」をはじめとする生成AIの急速な進化が話題となった。その力を、どうすれば既存業務の効率化や新たな価値創出につなげられるのか。生成AIがあらゆる業界、業種における関心事にもなる中、Microsoft、Google、AWS(Amazon Web Services)は、ユーザーが業務にAIを効果的に適用する方法を探る手助けとなるサービスを、いち早くリリースし始めている。

Ops Summit 2023では、Microsoft、Google、AWSの担当者が、自社が提供するAI関連サービスを紹介した。各社のセッション内容をお伝えする。

ChatGPTとの協業成果を全製品とサービスに適用するMicrosoft

日本マイクロソフトの土屋博之氏(デジタルカスタマーサクセス本部 本部長)は「Microsoftが提案するAIを活用したOpsの最新情報」と題して講演した。

Microsoftといえば、OpenAIとの中長期的な戦略的パートナーシップを思い浮かべる読者も多いだろう。ChatGPTのような大規模言語モデル(LLM)の進化により、コンピューティングの世界に引き起こされた変化のうち、特筆すべきものとして土屋氏は「自然言語によるユーザーインタフェース」と「かつてない規模と品質の推論モデル」を挙げる。

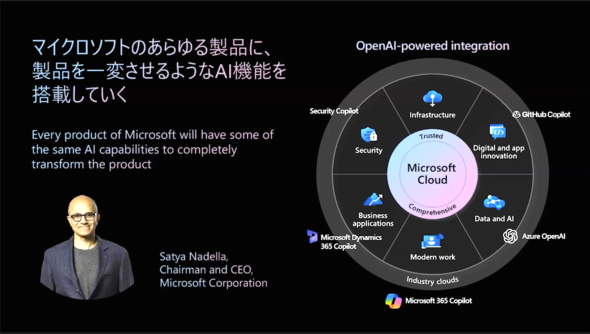

2023年初頭からMicrosoftは「あらゆる製品にAI機能を搭載していく」というメッセージを発信し、この1年間に「Copilot」ブランドのAI機能を、さまざまな領域の製品やサービスと統合することに取り組んできた。生産性アプリケーション群である「Microsoft 365」のサポート機能として発表された「Copilot for Microsoft 365」は既にリリースされており、希望する企業ユーザーに順次提供されている段階だ。

土屋氏は、OSとアプリケーション、そしてクラウド領域で幅広く事業を展開するMicrosoftが「重要な社会インフラを提供する企業としての社会的責任を負っている」とした。

「急速に進化を続けるAIという技術に対し、さまざまな議論が必要なことは理解した上で、リスクを取って“製品に組み入れていく”とアナウンスしている。だからこそ、安心安全なAI活用が進むよう、ルール作りにも丁寧に取り組んでいる」(土屋氏)

Microsoftでは、サービス提供に当たって「お客さまのデータはお客さまのもの」「お客さまのデータをAIモデルのトレーニングには利用しない」「データは高度なエンタープライズコンプライアンス、セキュリティ制御によって保護される」という原則を掲げている。また、著作権問題に関しては、2023年9月に「Copilot Copyright Commitment」を発表。その中で「Copilotサービスや、それが生成する出力結果を著作権に関するクレームを心配することなく使用できるか?」という質問に対し「使用できる。そして万が一著作権上の異議を申し立てられた場合は、Microsoftはその法的リスクに対して責任を負う」と明言している。土屋氏は「MicrosoftのAIサービスは、企業が懸念なくAI活用に踏み出せる形で提供されている」とした。

業務のあらゆるプロセスを革新するための相棒となる「Copilot」シリーズ

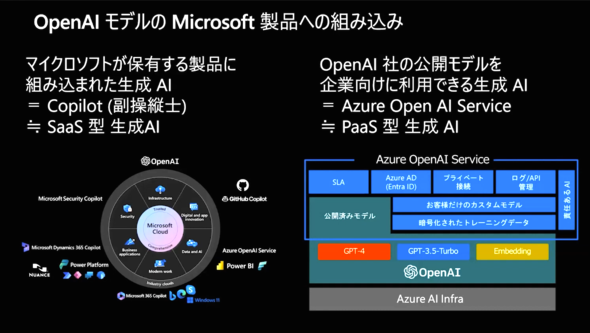

Microsoftが、OpenAIの研究成果であるAIモデルをユーザーに提供する方法として、大きく分けて2つのパターンがある。1つは、前出のCopilot for Microsoft 365のように、Microsoft製品の一部に組み込んで提供する形式だ。もう1つのパターンは、OpenAI製の公開モデルをAzure上で企業向けに提供する「Azure OpenAI Service」だ。前者は「SaaS型」、後者は「PaaS型」の提供形態であるとする。

「Copilot」は飛行機の「副操縦士」を意味する。このネーミングは「操縦士」はあくまでもユーザーであり、AIはその補佐として機能するというポリシーを表したものだ。Copilot for Microsoft 365の場合、ドキュメントの作成やデータ分析を行いたいユーザーの問い掛けに対して、Copilotが社内に存在するファイル内の情報やデータ群を参照して回答する形になる。

「AI時代におけるオフィスワーカーの生産性革命は、業務プロセスにおけるどこか特定のパートを“完全に自動化する”というよりも、個々のパートをAIで少しずつ効率化して、全体の生産性向上に寄与する形になると考えている」(土屋氏)

AIに対してユーザーが指示を出す形式は「プロンプト」と呼ばれるが、現状、AIがユーザーの求めている情報をうまく回答できるかどうかは、プロンプトの内容に依存する部分がある。土屋氏は「この数年で、欲しい回答を得るためのプロンプトの出し方もかなりノウハウが蓄積されてきている」とし、特にCopilot for Microsoft 365の利用時を想定した幾つかの類型を示した。

プロンプトは「アプリ特化コマンド系」「翻訳系」「分類系」「チェック系」など、幾つかの系統によって使い分け、それに加えて「AIに演じてほしい役割を指定する」「ゴール(求める成果物)を具体的に示す」「追加情報を正しく指示する」といった点を意識することで希望の出力が得やすくなるとした。

「もし、AIの出力が求めるものと違っていたら、前とは少し指示の仕方を変えて繰り返すことで、より良い結果が得られることも多い。実際に試しながら、自分にとって効果的な使い方を身に付けてほしい」(土屋氏)

土屋氏は活用例として、Entra ID(旧Azure AD)で管理される組織において「Excel」「Word」「PowerPoint」「Teams」「Outlook」「SharePoint」といった各アプリケーションをCopilotのサポートを通じて利用することにより、会議内容や参加者情報、共有情報などについての把握が容易になり、会議の招集、議事録の作成といったプロセスが大幅に効率化できることを示した。

セッションの最後には「PaaS型」である「Azure OpenAI Service」についても言及した。Azure OpenAI Serviceでは、ユーザーがOpenAIのモデルを自社サービスに組み込む形での利用を想定しているという。利用できるモデルとしてはLLMベースの生成AIである「GPT-3.5/4」、GitHub Copilotにも採用されているプログラムコード生成AI「Codex」、テキストから画像を生成する「DALL-E」などがある。

「ユーザーはOpenAI提供のモデルをそのまま使うこともできるが、Azure OpenAI Serviceを利用すると、Azureが用意している法人向けのセキュリティ機能、Entra ID認証、プライベートネットワーク接続機能、APIやログの管理機能を一緒に利用できる」(土屋氏)

土屋氏は最後に「Microsoftは、社会的インフラを提供する企業として、セキュリティ、コンプライアンス、プライバシー、そして責任あるAIの全てを満たせるように日々サービスを改善している。その実現を通じて、ユーザーのビジネスに貢献したいと考えている」と改めて強調し、セッションを終えた。

“検索の巨人”Googleによる最先端の成果をビジネスに取り入れる

「生成AI+ベクトル検索で大きく変わるIT基盤」と題して講演したのは、グーグル 佐藤一憲氏(デベロッパーアドボケイト)だ。

セッションの冒頭で佐藤氏は「グラウンディング(grounding)」「エンベディング(embedding)」「ベクトル検索(vector search)」という3つの語を示し、これらが「生成AIを企業のIT基盤に組み込む上で重要なキーワードになっている」とした。

生成AIを使ったことがある人の中には「確かに高度な受け答えができ賢く見えるが、実際に業務で利用できるレベルではない」と感じた人もいるのではないだろうか。「仕事には使えない」と感じる大きな理由としては、AIとのやりとりが「社会的な事実を知識として持っており、それをもとに回答している」わけではないこと、さらには「事実でないことをあたかも事実であるかのように回答する(ウソをつく)ケースがあること」が挙げられるかもしれない。特に後者は「ハルシネーション」と呼ばれ、生成AIを活用する場合に人間側が注意すべき問題の一つと指摘されている。

佐藤氏は「AIが持っている知識や能力を、現実にどう関連付けるかが重要な課題になる」とした。この関連付けのことを、AIの実社会への「接地」を図るという意味で「グラウンディング」と呼ぶ。

説明を進めるに当たり、佐藤氏はグラウンディングの分かりやすい例として、AI Demosを紹介した。

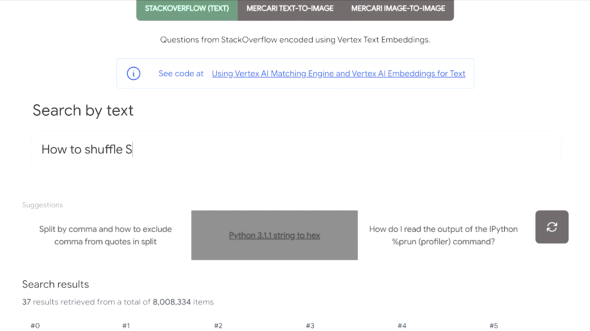

同サイトでは、AIを活用した「検索」を実際に試すことができる。講演では、エンジニア向けQAサイトである「Stack Overflow」から抽出した約800万件のサンプルコンテンツに対し自然文で質問し、その回答を提示するという操作を紹介した。

例えば「SQLによる検索結果をシャッフルするには?」と質問すると、その質問者の意図をくんで、よりふさわしい回答を上位から表示する。一見すると、一般的な検索サイト上での検索と変わらないようにも見えるが「AI Demos」では、LLMをベースとした「意味検索」を行っている点が特長になるという。入力された質問文の「意味」を判断し、その意味に類似した内容を扱っているコンテンツを抜き出しているというわけだ。そのため、質問文内にある「単語」と同じ単語が含まれていないコンテンツでも、意味的に近いと判断されれば上位の検索結果として表示される。

「意味検索という考え方は昔からあったものだが、LLMにより賢さのレベルは大幅に上がっており、現状では図書館司書レベルの知識をベースに文章の意味を理解できるようになっている。金融や医療といった特定業界向けの知識も、その業界での常識レベルなら理解が可能だ。このデモでは、生成AIが持つ“意味を理解する能力”のみを検索サービスに利用している。結果は実際のQAコンテンツに基づいているため、AIによるハルシネーションは入り込まず、出力も高速だ」(佐藤氏)

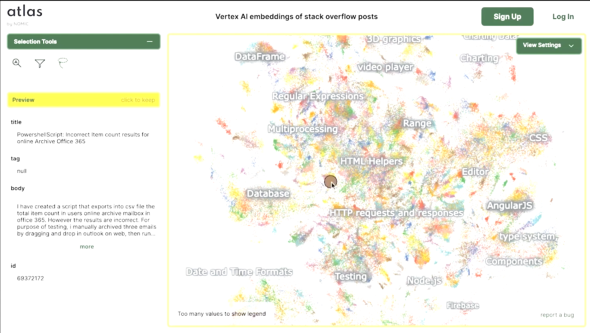

このデモにおける文章の意味理解とそれに基づく検索は、グーグルの機械学習プラットフォームである「Vertex AI」によって実現されている。Vertex AIでは、表形式を基本とする従来のデータベース構造ではなく、「意味」を軸に持つ多次元のベクトル空間上に各コンテンツを配置する。この「意味の地図を表す空間」上に、コンテンツを位置付ける仕組みが「エンベディング」と呼ばれる。この仕組みに基づけば「意味の近いコンテンツ」が空間上のより近い位置に配置されることになる。

意味に基づくコンテンツの座標と、各コンテンツの座標距離は計算で算出できるが、その時間を短縮するためにANN(Approximate Nearest Neighbor)と呼ばれる手法が使われる。Vertex AIでは「ScaNN」と呼ばれる、Google Researchが発表した類似ベクトル検索高速化の手法が利用されており、これは「世界トップレベルのベクトル検索技術」(佐藤氏)だという。

「ベクトル検索のための仕組みは『Vertex AI Vector Search』として、Google Cloud上で提供されており、ユーザーは自社サービスの一部にそれを組み入れることが既に可能だ。AI Demosは、フロントエンドからバックエンドまで、全てをGoogle Cloud上で提供している」(佐藤氏)

さまざまなサービス領域に適用可能な「マルチモーダルエンベディング」

AIによる意味理解の能力を検索へ応用する仕組みは、テキストコンテンツだけでなく、画像や動画などに対しても有効だ。前出の「AI Demos」では、フリーマーケットサービスである「メルカリ」から抽出した約600万件の商品画像を、自然文あるいは画像によるクエリで検索することができる。「cup with dancing people(踊っている人が描かれたカップ)」と入力して検索すると、その内容に合った商品画像がリストアップされる。

このデモでは、出品時に画像へ付与されたタグデータや商品説明文などは検索時に利用せず、シンプルに学習時にモデルが理解した「画像の意味」をベースに結果を出力しているという。こうした画像や動画などの多種類のメディアに対応したエンベディングを「マルチモーダルエンベディング」と呼ぶ。

異なる種類のメディアが共存できるエンベディング空間を用意することで、テキストによる説明文やタグを別途用意しなくても、画像さえあれば自動的にAIによるカテゴリー分けが実現する。マルチモーダルで画像や映像をLLMと組み合わせる仕組みは、eコマースやマーケットプレースだけでなく、セキュリティモニタリングや自動運転システム開発の領域などにも応用が可能という。

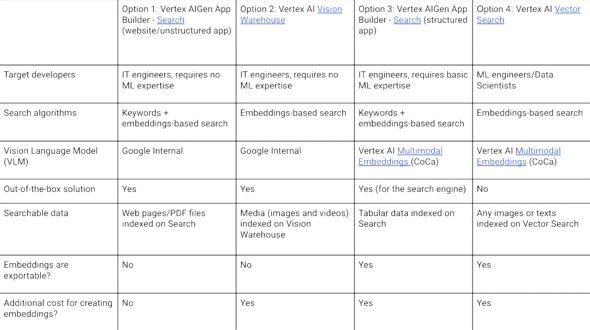

現在、Google Cloudではこうした「マルチモーダルサーチ」の仕組みを構築するためのプラットフォームを、幾つかのオプションとともに提供している。

中でも「Vertex AIGen App Builder -Search(website/unstructured app)」は、機械学習のエキスパートでなくても利用できるようなアウトオブザボックスソリューションとなっており、AI検索の仕組み作りへ着手するに当たって使いやすいソリューションだという。

「意味をAIに理解させ、ベクトル検索で高速に引き出す仕組みは、AIの能力を実際のビジネスに“グラウンディング”させる点で、非常に効果的なソリューションだと考えている。Google Cloudには、そのためのプラットフォームが用意されている。ぜひ検討してほしい」(佐藤氏)

生成AIモデルを選んで手軽に使えるAWSの「Amazon Bedrock」

AWSでは、2023年9月から生成AIのマネージドサービス「Amazon Bedrock」の一般提供を開始しており、10月3日からは東京リージョンでの利用も可能になった。AWSジャパンの鮫島正樹氏(AI/ML事業本部 ソリューションアーキテクト)は「Amazon Bedrockによる生成系AIアプリケーションの構築と運用」と題し、Amazon Bedrockの概要と生成系AIアプリケーションの構築例、運用例を紹介した。

生成AIのビジネス活用において重要な要素として、鮫島氏は「最も簡単な構築方法」「データによる差別化」「高性能、低コスト」「生産性向上」の4つを示した。これらの全てを実現できるようAWSが提供するのがAmazon Bedrockだという。Amazon Bedrockは、複数のAI企業が提供する基盤モデルを簡便なAPIを通じてユーザーが利用できるようにするフルマネージドサービスだ。

選択可能な基盤モデルとしては、現在6つが用意されている。

ユーザーはこれらの基盤モデルをAPI経由で利用し、必要に応じてセキュアなプライベート環境で自社データを利用してカスタマイズすることも可能だ。Amazon Bedrockに含まれないモデルを試用、カスタマイズ利用したいユーザーには「Amazon SageMaker JumpStart」というサービスも別途用意している。ユーザーのアカウントにリソースを確保した上で、80種以上の基盤モデルにアクセスでき、対応モデルはノーコードでのデプロイやチューニングも可能だ。

AWSでは、クラウド上で生成AIを利用したいニーズに対応するため、独自開発の「AWS Trainium」「AWS Inferentia2」といったアクセラレータも開発している。これらのアクセラレータをベースとしたインスタンスを利用することで、通常のAmazon EC2(Amazon Elastic Compute Cloud)インスタンスと比較して、Trainiumならトレーニングコスト50%削減、Inferentia2なら最大でコストパーフォーマンス40%向上を実現できるという。こうしたアクセラレーターインスタンスを活用することで「高性能かつ低コスト」な生成AI活用が可能になるとした。

「生産性向上」の観点では、鮫島氏はコーディングコンパニオンである「Amazon CodeWhisperer」とBIツールである「Amazon QuickSight Generative BI」を取り上げた。

Amazon CodeWhispererは、エンジニアがIDEなどに拡張機能として組み込んで利用できるコード生成ツールで、個人向け機能は無料で提供されている。ユーザーによって入力されるコードのコンテキストに応じて、次に入力するコードの提案をリアルタイムで生成する他、コード内に脆弱(ぜいじゃく)性などが含まれる場合はそれを指摘して修正案を提示する機能なども持つ。また、作成されたコードに特定のコードとの類似性がある場合に、その部分を指摘するといった機能もある。これは、OSS(オープンソースソフトウェア)ライセンスへの抵触をチェックする際などに活用できるという。企業向けの機能としては「CodeWhisperer customization capability」の提供も予定されている。これを利用すると社内に存在するコードベースに基づいて「推奨されるコード」を自動生成できるとしている。

一方の「Amazon QuickSight Generative BI」は、ビジネスアナリストなどを中心としたビジネスユーザーが自然言語で指示を出すと、それに合わせてデータの分析や可視化をする機能だ。同機能は現在QuickSight上でプレビュー版が利用できる。

マネージドサービスとしてAIアプリのデプロイや改善の効率化をサポート

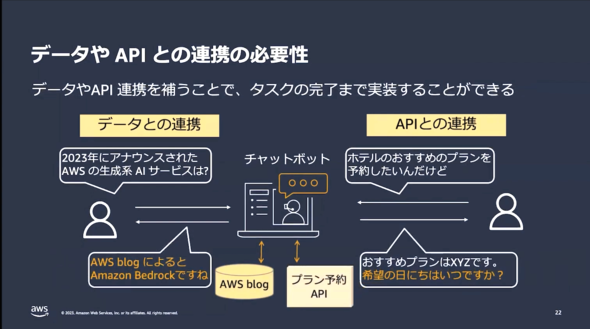

鮫島氏は、AWSが提供するサービスを利用して「生成AIアプリケーション」を構築する際に必要なプロセスについて、手順を追いながら説明した。具体的なプロセスとして「基盤モデルの選択」「データやAPIとの連携」「デプロイと管理」がある。

「基盤モデルの選択」に当たっては、実際のプロンプトを使ってモデルを試用した上で「精度」「レスポンス速度」「コスト」といった観点から、どのモデルを採用するかを決定する。これらが全て満たされる基盤モデルが存在すれば、それがベストな選択肢ということになるが、実際にはトレードオフの関係にあることが多いと鮫島氏は指摘する。その場合、「チャットbotで使いたい」「膨大なユーザーに幅広く提供したい」「重要度の高い業務における検索で利用する」といった、ユースケースに応じた優先順位付けがポイントになる。

こうして選択した基盤モデルは、単体ではユースケースごとのユーザーリクエストに十分に対応できないケースも多い。その場合は、外部のデータや他サービスと連携させて機能を補完することになる。こうした連携で実現できるサービス例としては「○○へ旅行するので、お勧めの宿泊プランを予約したい」といった入力に基づいて、最新の宿泊施設の情報をもとに実際の予約までを完了できるチャットbotシステムなどが挙げられる。

実際にアプリケーションとしてリリースした場合、生成AIアプリケーションも、他のアプリケーションと同様、安定的な稼働や継続的な改善が求められる。AWSでは「Agents for Amazon Bedrock」と呼ばれる機能を通じて生成系AIアプリケーションを構成する複雑なタスクの開発や改善をサポートする。具体的には、ユーザーが入力したクエリの内容を理解し、登録された情報をナレッジベースから検索したり、タスク完了に必要なアクションを自動実行したりするといった形で動作するという。

また、アプリケーションのユーザーが急激に増えることが想定される場合でも安定稼働を維持するために「Provisioned throughput」と呼ばれる機能が利用できる。これは、稼働時に多くのリソースが必要になる場合、モデルが毎分満たすべきリクエスト数などを予約しておくことで、必要に応じてAWS側で自動的にリソースを増減し求められるレスポンスレベルを確保できる機能だという。その他、Amazon Bedrockと「Amazon VPC」間のプライベート接続機能や暗号化機能、GDPR(一般データ保護規則)/HIPAA(医療保険の携行性と責任に関する法律)への準拠など「セキュリティやプライバシーが必要なアプリケーションの稼働にも必要な環境が用意されている」(鮫島氏)とする。

「豊富な基盤モデルの選択肢をはじめ、開発だけでなくデプロイや運用に役立つAgentsやナレッジベース、柔軟でセキュアなインフラ環境など、Amazon Bedrockにはフルマネージドサービスとして生成系AIアプリケーションの開発、運用に役立つ機能が多数用意されている。省力化できる部分はできるだけベンダーに任せたいというユーザーのニーズにマッチするサービスだと考えている」(鮫島氏)

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

今さら聞けない「生成AI」の仕組みや活用の注意点をこっそり学ぼう

今さら聞けない「生成AI」の仕組みや活用の注意点をこっそり学ぼう

IT用語の基礎の基礎を、初学者や非エンジニアにも分かりやすく解説する本連載、第13回は「生成AI」です。ITエンジニアの学習、エンジニアと協業する業務部門の仲間や経営層への解説にご活用ください。 大規模言語モデル(LLM:Large Language Model)とは?

大規模言語モデル(LLM:Large Language Model)とは?

用語「大規模言語モデル」について説明。大量のテキストデータを使ってトレーニングされた自然言語処理のモデルのことを指す。 LLMアプリケーションを構築するための5つのステップをGitHubが解説

LLMアプリケーションを構築するための5つのステップをGitHubが解説

GitHubは、LLMアプリケーションを構築するために知っておくべき5つのステップを公式ブログで紹介した。