サーバ間通信の有力な担い手

サーバ間通信の有力な担い手

InfiniBandで変わるデータセンター内通信(前編)

松本直人

仮想化インフラストラクチャ・オペレーターズグループ チェア

さくらインターネット研究所 上級研究員

2011/2/15

10年以上前から存在していた「InfiniBand」が、ここにきて、データセンターでのサーバ間通信を担う技術として急速に注目を集めるようになりました。その特徴と基本的な設定方法を紹介します。(編集部)

注目集めるInfiniBand

注目集めるInfiniBand

InfiniBandは「インフィニバンド」と発音し、2000年に業界団体であるInfiniBand Trade Associationによって策定された規格です。スーパーコンピューティングなどHPC(High Performance Computing)分野で使われているサーバ間データ通信技術の1つです。

イーサネットによるLAN間接続と同様に、InfiniBandも、数十メートル範囲での高速データ通信に使われていました。しかし通信ケーブルの光化により、通信範囲を数百メートル単位まで伸ばせるようになっています。また2011年には112Gbpsのデータ通信機器が控えているなど、現在も性能拡張が進んでいる規格です。

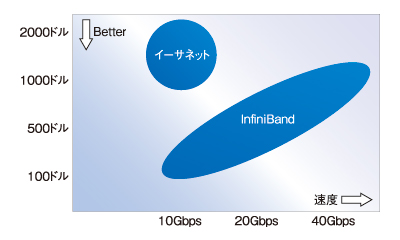

規格自体は2000年から存在していましたが、最近になって、InfiniBand製品の低価格化が劇的に進んできています。通信帯域と値段のコストパフォーマンスで比較すると、10Gbpsイーサネットをはるかに上回るほどです。

|

| 図1 InfiniBandとイーサネットの価格性能比較 |

このことから、海外および国内でのデータセンターやエンタープライズ用途でもInfiniBandに対する関心が非常に高くなってきました。2010年に、VIOPSが主催して国内で行った仮想化技術者の集まり「InfiniBand DAY」にも40名以上のエンジニアが集まりました。

そこでこの記事では、InfiniBandを用いたサーバ間データ通信に焦点を当てて紹介を行っていきます。

InfiniBandとイーサネットの違い

InfiniBandとイーサネットの違い

InfiniBandでネットワークを構成する場合、すべてがイーサネットと異なります。

InfiniBand接続を構成する要素は、サーバ側に実装するカードであるHCA(Host Channel Adapter)、スイッチングを行うInfiniBandスイッチ、スイッチとHCAを接続するInfiniBandケーブルです。写真のとおり、すべてイーサネットとは異なる形状ですので注意が必要です。

|

|

| HCAやInfiniBandスイッチ、ケーブル、すべてがイーサネットと異なる形状 | |

スイッチとHCAをつなぐケーブルは、基本的には銅(copper)ケーブルが用いられますが、100m以上を伝送可能とする光ファイバーケーブル形状のものも存在しています。この意味では、イーサネットのLANセグメント構築可能と適応範囲はまったく同じといってよいでしょう。

InfiniBandには、簡単に分類すると10Gbpsから40Gbpsまでのデータ転送タイプがあり、それぞれSDR(Single Data rate 10Gbps)、DDR(Double Data Rate 20Gbps)、QDR(Quad Data Rate 40Gbps)と呼ばれています。また特徴としてLAN内でのレスポンスタイムがInfiniBandは0.038ms程度など、極めて遅延が少ないネットワークが構成できます。

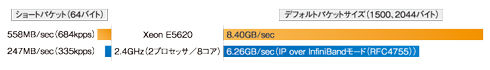

イーサネットと大きく異なる点として、InfiniBandではデータ通信符号化に8b/10b変換(8bitデータを10bitデータへ訂正)を行います。このため、理論値でのスループットは、それぞれSDR 8Gbps、DDR 16Gbps、QDR 32Gbpsとなります。TCP/IP通信をInfiniBand上で行うためにIPoIB(IP over InfiniBand/RFC4755)プロトコルを使うと、そのオーバーヘッドも掛かります。

とはいえ、筆者のラボ環境でSDR 10Gbps InfiniBandを用いたIPoIB環境では、6Gbps、QDR 40Gbps、素のInfiniBandでは27Gbpsという通信速度を確認しています。費用対効果を考えれば十分に優位性があるといえるでしょう。

|

|

| 図2 筆者のラボ環境での測定結果 |

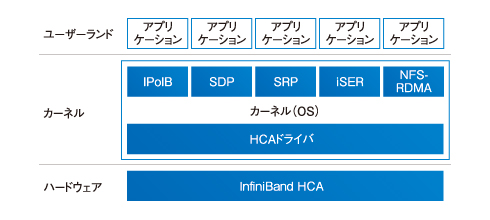

またInfiniBandには、ネットワークとストレージ、両方の機能を提供する仕組みが最初から備わっています。

データ通信向けに提供されるIPoIBのほか、TCP/IPスタックを経由せずに低遅延のInfiniBandを利用するSDP(Sockets Direct Protocol)、同じくメモリ空間を直接異なるシステム間で共有するRDMA(Remote Direct Memory Access)機構を使いストレージ向けに提供されるSRP(SCSI RDMA Protocol)、iSER(iSCSI Extentions for RDMA)、NFS-RDMA(NFS over RDMA)などがin-kernel状態で提供されています。これらのプロトコルによりInfiniBandでは、ネットワークとストレージの両方を1つのシステムとして一元管理できます。

またIPoIBを用いることで、通常のTCP/IPシステムと同じようにシステムを構築することも可能です。目的に合わせて最適なシステム構成を選択するとよいでしょう。

|

| 図3 InfiniBandを構成するプロトコルのスタック |

今回はそれらの中から、TCP/IPシステムに対して最も親和性の高いIPoIBについて紹介します。

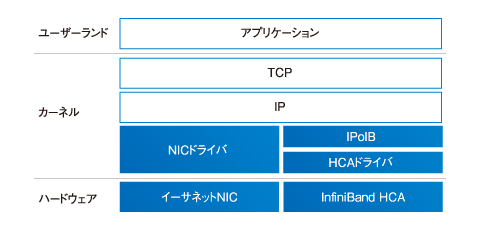

イーサネットとInfiniBandという異なるネットワークシステムでTCP/IPを利用する場合でも、IPoIBを使うことで、違いはOSが持つ標準のTCP/IPスタック以下に隠ぺいされます。このため、ユーザーが違いを意識することはありません。加えて、InfiniBandを利用することで広帯域・低遅延のデータ通信が可能となる点が大きなメリットです。OSから見る場合、ハードウェアの違いと各種ドライバ部分だけに限定され、いままで使っていたアプリケーションに手を入れる必要などはありません。

|

| 図4 IPoIBを使うことで、イーサネットとInfiniBandの違いを吸収する |

当然、イーサネットとInfiniBandという異なるメディアを混在させて動作させることも可能です。膨大なサーバ間でのデータ通信にはInfiniBandを使い、外部へのデータ通信や監視ネットワークとのやりとりはイーサネットを使うなど、用途に応じて使い分けるとよいでしょう。

補足すると、筆者のラボ環境では、1台でイーサネットとInfiniBandの両ネットワークに接続し、相互の橋渡しをするゲートウェイを用意し、内部ネットワークはInfiniBandだけで構成するというシステムを作っています。これにより、ネットワーク構成の簡素化などのメリットを享受しています。

| InfiniBandで変わるデータセンター内通信(前編) | |

| 注目集めるInfiniBand InfiniBandとイーサネットの違い |

|

| InfiniBandネットワークを構築しよう 動作確認と仮想マシンとの接続 広帯域化に向けたロードマップ |

|

| 「Master of IP Network総合インデックス」 |

- 完全HTTPS化のメリットと極意を大規模Webサービス――ピクシブ、クックパッド、ヤフーの事例から探る (2017/7/13)

2017年6月21日、ピクシブのオフィスで、同社主催の「大規模HTTPS導入Night」が開催された。大規模Webサービスで完全HTTPS化を行うに当たっての技術的、および非技術的な悩みや成果をテーマに、ヤフー、クックパッド、ピクシブの3社が、それぞれの事例について語り合った - ソラコムは、あなたの気が付かないうちに、少しずつ「次」へ進んでいる (2017/7/6)

ソラコムは、「トランスポート技術への非依存」度を高めている。当初はIoT用格安SIMというイメージもあったが、徐々に脱皮しようとしている。パブリッククラウドと同様、付加サービスでユーザーをつかんでいるからだ - Cisco SystemsのIntent-based Networkingは、どうネットワークエンジニアの仕事を変えるか (2017/7/4)

Cisco Systemsは2017年6月、同社イベントCisco Live 2017で、「THE NETWORK. INTUITIVE.」あるいは「Intent-based Networking」といった言葉を使い、ネットワークの構築・運用、そしてネットワークエンジニアの仕事を変えていくと説明した。これはどういうことなのだろうか - ifconfig 〜(IP)ネットワーク環境の確認/設定を行う (2017/7/3)

ifconfigは、LinuxやmacOSなど、主にUNIX系OSで用いるネットワーク環境の状態確認、設定のためのコマンドだ。IPアドレスやサブネットマスク、ブロードキャストアドレスなどの基本的な設定ができる他、イーサネットフレームの最大転送サイズ(MTU)の変更や、VLAN疑似デバイスの作成も可能だ。

|

|