Ceph/RADOSのインストール、環境構築と接続テストまで:Ceph/RADOS入門(3)(3/4 ページ)

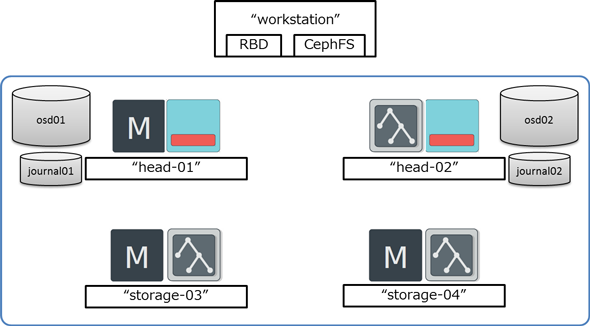

OpenStack環境で使える分散ストレージとして注目を集めるCeph/RADOS。今回は実際に5台のサーバーを使って分散ストレージ環境を構築、各インターフェースの動作確認までの手順を紹介します。

OSD構築

次に、OSDを構築してみましょう。

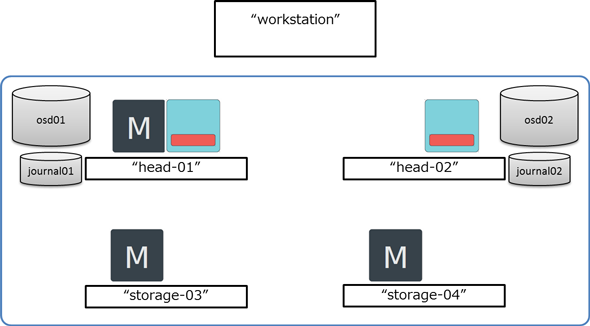

OSDの構成について

一つのOSDは、データ用のディスク1個で構成する方法と、データ用とジャーナル用の2個のディスクで構成する方法があります。前者の場合、ジャーナルはデータ用のディスクの内部にファイルとして割り当てられます。スループット性能を得るためには、データとジャーナルは別ドライブにすることが推奨されています。また、ジャーナル用ドライブがSSDなどのランダムWrite性能に優れるデバイスの場合、性能上は複数のOSDで一つのジャーナル用ドライブを共有することも可能です。しかし、その場合一つのジャーナル用ドライブの故障がそれを共有している全てのOSDをfailさせてしまいますので注意が必要です。

ここではジャーナル用ドライブは共有せず、一つのOSDを2個のディスクで構成する方法を選択します。各OSD用サーバーが使用するディスクは以下の通りです。

サーバー名 データ用ディスク ジャーナル用ディスク -------------------------------------------------------------------- head-01 /dev/vas/osd01 /dev/vas/journal01 head-02 /dev/vas/osd02 /dev/vas/journal02

(1)OSD用サーバーを構築する

ceph-deploy osd prepareに続いて、OSD用サーバーのホスト名:データ用ディスク:ジャーナル用ディスクを指定します。データ用のディスクはパス名から/dev/の部分を除いた文字列を指定します。

デフォルトではデータ用ディスクにXFSファイルシステムが構築されます。

(2)OSDのアクティベート

次にOSDをアクティベートします。ceph-deploy osd activateに続いてOSD用サーバーのホスト名:データ用ディスク:ジャーナル用ディスクを指定します。

これで、各サーバー上でOSDが起動します。なお、上記のceph-deploy osd prepareとceph-deploy osd activateの2回のコマンド実行をceph-deploy osd createの一回で済ますことも可能です。

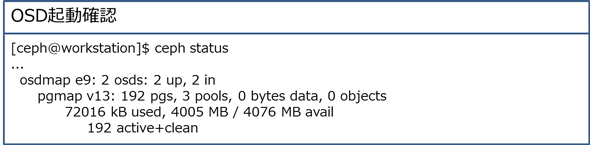

(3)OSDの動作確認

OSDが有効になったことを確認してみましょう。

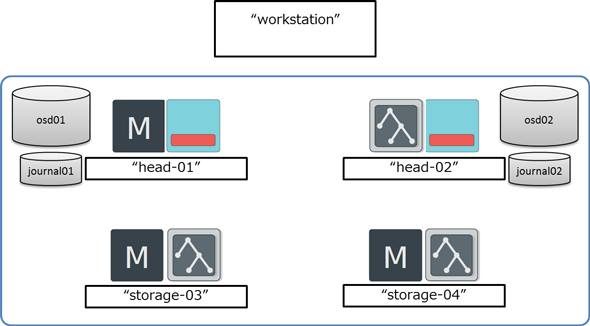

MDS構築

続いて、MDSを構築していきます。

(1)MDS用サーバーを構築する

ceph-deploy mds createに続いてMDS用サーバー3台のホスト名を列挙します。

各サーバー上でMDSが起動します。

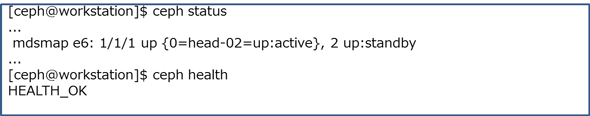

(2)MDSの動作確認

MDSが有効になったことを確認します。

「HEALTH_OK」ではなく「HEALTH_WARN」が表示される場合は、ceph health detailを実行するとその理由が表示されます。

これでCeph Storage Clusterの構築ができました。

(3)クライアントから接続確認

クライアントから接続できることを確認します。

ここではLinuxカーネルのドライバを使用する方法で確認します。確認に必要なドライバはLinuxカーネル3.6.6以降または3.4.20以降に含まれています。

CentOS 6.4(x86_64)のlinuxカーネルは上記バージョンに該当しないので、新しいバージョンのLinuxカーネルをインストールする必要があります。

Linuxカーネルのインストール方法については省略します。

なお、本稿の主旨であるOpenStack環境向けストレージ用途でのCeph/RADOSの使用においてはLinuxカーネルのドライバは使用しません。OpenStackのストレージでCeph/RADOSを使用する場合はLinuxカーネルを変更する必要はありません。

Copyright © ITmedia, Inc. All Rights Reserved.