Intel、Xeon上での「TensorFlow」使用時向けにDNNモデルコンパイラ「nGraph」の性能を強化:従来比で最大10倍のパフォーマンスを実現

Intelは、「Intel Xeonスケーラブルプロセッサー」上で「TensorFlow」を使用するデータサイエンティスト向けに、フレームワーク非依存のディープニューラルネットワークモデルコンパイラ「nGraph Compiler」のパフォーマンスを高めるブリッジコードを提供開始した。

Intelは2018年4月18日(米国時間)、「Intel Xeonスケーラブルプロセッサー」上でディープラーニングフレームワーク「TensorFlow」を使用するデータサイエンティスト向けに、フレームワーク非依存でオープンソースソフトウェア(OSS)のディープニューラルネットワーク(DNN)モデルコンパイラ「nGraph Compiler」のパフォーマンスを高めるブリッジコードを提供開始した。

このブリッジコードは、TensorFlowベースのプロジェクトを最適化済みのnGraph Compilerのバックエンドにリンクするために使用できる。このブリッジコードを実装することで、従来のTensorFlow統合時と比べて最大10倍のパフォーマンスを実現できるとしている。Intelは2018年3月にnGraph CompilerをOSS化したばかりだ。

IntelのAI(人工知能)ソフトウェア担当バイスプレジデントのアージュン・バンサル氏は、次のように説明している。

「AIソリューションのための適切な技術を見つけるのは、企業にとって非常に難しい。われわれはそれをできるだけ簡単にすることを目指している。データサイエンティストはnGraph CompilerでDNNモデルを作成でき、さまざまなフレームワークごとにモデルをどう調整すべきかを考える必要がない」

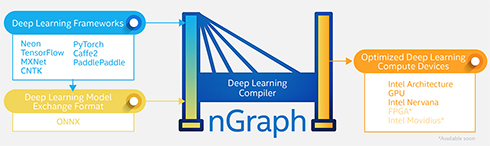

さらにIntelは、「nGraph Compilerでは、さまざまなディープラーニングフレームワークを利用でき、さまざまなハードウェアソリューション向けにモデルを最適化できる」と述べている。

Intelは、AIの理論を実現するために必要な各種の新技術を組み合わせたAIポートフォリオを構築しており、nGraph Compilerもこれに新しく加わった形だ。

Intelは、nGraph Compilerを使用するメリットをこう強調している。

「データサイエンティストは、フレームワークやハードウェアを自由に選択できる。また、フレームワークオーナーは、少ない労力で独自機能を追加できる。クラウドサービスプロバイダーも、市場の大きな需要に簡単に対応できる。企業は、フレームワークやバックエンドの違いにかかわらず、一貫した操作性を享受できる。どのような使用シナリオにおいても、パフォーマンスは損なわれない」

nGraph Compilerは現在、3つのディープラーニングコンピュートデバイスと6つのディープラーニングフレームワーク(TensorFlow、「MXNet」「neon」「PyTorch」「CNTK」「Caffe2」)をサポートしている。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

Intel、AIプロトタイプの市場投入を支援するプログラム「Intel AI: In Production」を発表

Intel、AIプロトタイプの市場投入を支援するプログラム「Intel AI: In Production」を発表

Intelは、デベロッパーによるAIプロトタイプの市場投入を支援する新プログラム「Intel AI: In Production」を立ち上げ、その最初のパートナーとしてAAEON Technologiesを選定した。 Intel、Deep Learning専用チップ「Nervana Neural Network Processor」を2017年内に出荷すると発表

Intel、Deep Learning専用チップ「Nervana Neural Network Processor」を2017年内に出荷すると発表

Intelは新世代のAI向けプロセッサとして、Deep Learning専用アーキテクチャを採用した「Intel Nervana Neural Network Processor」を2017年中に出荷する。 USBスティックでディープラーニングを実現 Intelが新製品「Movidius Neural Compute Stick」をリリース

USBスティックでディープラーニングを実現 Intelが新製品「Movidius Neural Compute Stick」をリリース

Intelは、スティック型のディープラーニング推論キット兼AIアクセラレータ「Movidius Neural Compute Stick」をリリース。USB接続でディープニューラルネットワーク処理機能を追加できる。