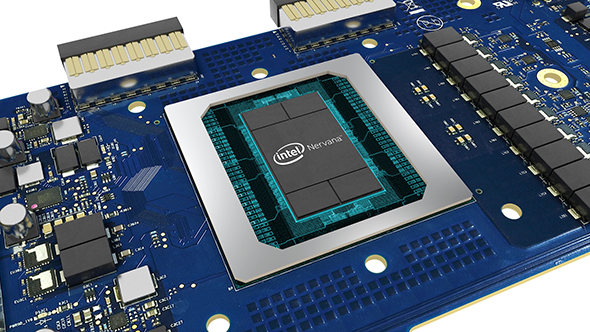

Intel、Deep Learning専用チップ「Nervana Neural Network Processor」を2017年内に出荷すると発表:Facebookと技術的洞察を共有

Intelは新世代のAI向けプロセッサとして、Deep Learning専用アーキテクチャを採用した「Intel Nervana Neural Network Processor」を2017年中に出荷する。

Intelは2017年10月17日(米国時間)、大きな成長市場と見込まれるAI(人工知能)分野をけん引する姿勢を表明するとともに、新世代のAI向けハードウェアとして「Intel Nervana Neural Network Processor」(Nervana NNP)を2017年中に出荷する計画を発表した。

Nervana NNPは、2016年に買収したDeep Learningの新興企業Nervana Systemsの技術を統合した最初のプラットフォーム製品となる。「Lake Crest」のコード名で呼ばれていた。市場に投入するに当たって、ソーシャルネットワーク大手のFacebookと技術的洞察を共有する緊密なコラボレーションを行うとしている。

機械学習とDeep Learningは現在、最も重要な計算ワークロード

Intelは、現在のAI革命は、実際は計算の進化だとし、機械学習とDeep Learningを「現在、最も重要な計算ワークロード」と位置付けている。そのため、こうしたワークロードで優れた実行性能を提供できるよう半導体製品ポートフォリオに変更を加えている。

現在のビジネス向けの汎用機械学習および推論ワークロードの大部分は、Intelの「Xeonスケーラブルプロセッサ」とデータセンターアクセラレータを使って実行されており、Intelはこれらの製品ラインについては、顧客の進化するデータ処理ニーズに対応できるよう最適化を継続していく。

一方、Deep Learningの計算ニーズは、AI計算のサポートに必要なハードウェアに関する新しい考え方を要求している。Intelはこうした流れに対応し、新しいDeep Learning用チップとしてNervana NNPを設計した。

設計のポイント

IntelはNervana NNPの設計に当たって、AI専用ではなかった既存ハードウェアが抱えていた制約の解消を目指した。そのポイントは以下の通りだ。

チップによる計算を最大限活用するための新しいメモリアーキテクチャ

Deep Learningで中心的な位置を占める行列乗算と畳み込み処理は、汎用的なワークロードとは異なり、演算内容と移動するデータが前もって大体分かっている。そのため、Nervana NNPは一般的なキャッシュ階層を持たず、オンチップメモリはソフトウェアによって直接管理される。こうしたメモリ管理の改良により、Nervana NNPは、各ダイ上における大量の計算を高度に活用できる。これは、Deep Learningモデルの訓練時間の短縮につながる。

AIモデルの新次元のスケーラビリティ

Nervana NNPは、高速なオンチップおよびオフチップのインターコネクトを採用した設計であり、大量の双方向データ転送が可能だ。Intelは、ニューラルネットワークパラメーターが複数チップに分散される「真のモデル並列性」の実現を目指した。これは、複数のチップを、大規模モデルに対応できる1つの大きな仮想チップとして動作させるものだ。データからより多くの洞察を引き出せるという。

高度な並列数値処理:Flexpoint

シングルチップ上のニューラルネットワーク計算は主に、処理能力とメモリ帯域幅に制限される。ニューラルネットワークワークロードで高度なスループットを実現するために、Intelは、前述したメモリ管理の改良を実現しただけではなく、「Flexpoint」という新しい数値形式も発明した。

Flexpointは、スカラ計算を固定小数点の乗算や加算として実装することを可能にし、共有指数を使った大規模ダイナミックレンジも可能にする。これにより、各回路が縮小し、ダイ上の並列性が大幅に向上するとともに、消費電力が減少するという。

「2020年までにDeep Learningの訓練性能を100倍に向上させる」

Intelは2016年に、「2020年までにDeep Learningの訓練性能を100倍に向上させる」という目標を表明したが、同社の製品展開は、この目標を前倒しで達成できるペースで進んでいるという。

Nervana NNPは複数世代の製品が用意される予定。Intelは、Nervana NNPで、さまざまな業界の新たな課題に応える新タイプのAIアプリケーションの開発に道を開く考えだ。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

インテル、大規模なAI戦略を発表 AIプラットフォーム「Intel Nervana」を投入

インテル、大規模なAI戦略を発表 AIプラットフォーム「Intel Nervana」を投入

インテルがAIの活用促進に向けた新しい製品、技術、投資計画を多数発表。AIの包括プラットフォーム「Intel Nervana」を中心に展開する。 Intel、「Intel Nervana DevCloud」を機械学習、Deep Learning向けに無料提供

Intel、「Intel Nervana DevCloud」を機械学習、Deep Learning向けに無料提供

Intelは2017年10月から、コンピュートクラウド「Intel Nervana DevCloud」において、Intel Nervana AI Academyの会員が機械学習やDeep Learningに必要なコンピューティングリソースを無料で利用できるようにし、AIソリューション開発を後押しする。