人間のように学習して物体を特定、UCLAが視覚システムを開発:汎用AIへの道

カリフォルニア大学ロサンゼルス校(UCLA)サミュエリ工学部とスタンフォード大学の研究者のチームが、視覚システムを開発した。見たものが実際には何なのか、人間が学習するのと同じ方法で学ぶという特徴がある。

米カリフォルニア大学ロサンゼルス校(UCLA)サミュエリ工学部は2018年12月18日(米国時間)、同学部とスタンフォード大学の研究者のチームが、見えたものが実際には何なのか、人間が学習するのと同じ方法で学習し、特定できるコンピュータシステムを開発したと発表した。

今回開発したシステムは、コンピュータが視覚画像を読み取り、特定する“コンピュータビジョン”と呼ばれる技術の進化形だ。

現在のAIは、性能や機能が年々向上しているものの、あくまで「特定のタスク」向けだ。つまり、能力の向上は、人間によるトレーニングとプログラミングに左右されており、工場や監視カメラなど何が見えるのかあらかじめ分かっている場合にしか役立たない。例えば、工場であればあらかじめ登録した正常な形状の部品、監視カメラなら登録済みの従業員の顔だ。

研究グループは、今回の成果が汎用AIシステムへの重要な一歩だと位置付けている。汎用AIシステムは現時点で利用が進むAIとは異なり、自ら学習し、直感的で、推論に基づいて判断し、人間らしい方法で人間とやりとりするコンピュータを指す。

開発した“コンピュータビジョン”システムは、さきほどのような写真の断片を「見て」、実際の物体を特定できる。写真はオートバイの一部を撮影したものだ。

現在のコンピュータビジョンが抱える深刻な課題とは

現在利用可能な最高のコンピュータビジョンシステムをもってしても、特定の部分だけを見て、物体の全体像を描くことはできない。さらに、従来のシステムは、物体が通常とは異なる文脈で提示されると、認識できない。

研究チームの目標はこうだ。イヌがいすの陰に隠れていて、脚としっぽだけが見えていても、イヌだと認識できるようにすることだ。人間は、このような場合でも、イヌの頭や体の他の部分がどこにあるかを、直感によって容易に指摘できるが、ほとんどのAIシステムにはそうした能力が備わっていない。この点も研究チームの課題となっている。

さらに、現在のコンピュータビジョンシステムは、自ら学習するように設計されていない。現在のシステムは、学習すべきもの自体を「見せて」トレーニングする必要があり、通常、特定すべき物体を学ぶために開発者がラベルを付けた画像を、数千点、入力するという方法を用いる。

もちろん、コンピュータは、画像内の物体が何であるかを判断する根拠を説明できない。AIシステムは人間とは違って、学習した物体の内的イメージや一般モデルを作ることができないからだ。

3段階でモノを見る

研究チームはこのような短所を克服し、見える物体を特定できる新しい手法を考案し、「Proceedings of the National Academy of Sciences」に論文を発表した。

新手法のアプローチは、3つのステップからなる。

- システムは画像を多数の小さな部分に分割する。研究チームはこれらの部分を“ビューレット”と呼んでいる

- これらのビューレットがどのようにまとまって物体を形成するかを学習する

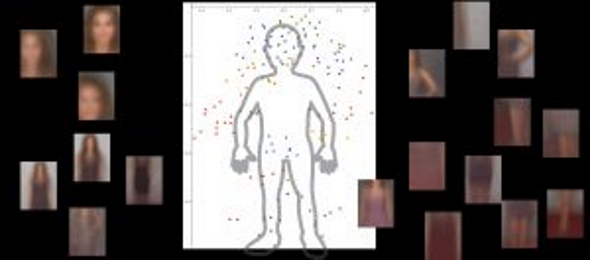

- 周囲にどのような物体があるかを見て、それらの物体に関する情報が、メインの物体を記述し、特定する際に関連するのかどうかを判断する

研究チームは、こうした新システムに人間のように学習させようとした。そこで人間を取り巻く環境の代わりにインターネットを用いて、新システムにインターネット上の膨大な画像を入力した。

UCLAで電気工学・コンピュータ工学の教授を務め、今回の研究を主導したVwani Roychowdhury氏は次のように説明している。

「脳にヒントを得たコンピュータビジョンシステムが、人間と同じように学習する際、インターネットは2つの点で役立つ。一つは、同じ種類の物体を捉えた豊富な画像や動画があること。もう一つは、こうした物体が多様な視点で(例えば、暗所で、高所から、アップで)示され、さまざまな環境に置かれていることだ」

研究チームは、認知心理学や神経科学の洞察も利用した。「われわれは幼いころから、数多くの文脈でさまざまな実例を目にすることにより、目にした物体が本当は何なのかを学ぶ。こうした文脈による学習が、われわれの脳の重要な特徴だ。これは、全てが機能的につながっているという統合された世界観の一部となる、強固なオブジェクトモデルの構築に役立つ」(Roychowdhury氏)

研究チームは新しいコンピュータビジョンシステムを、それぞれ人と他の物体を含む約9000の画像でテストした。システムは開発者によるガイダンスを受けることなく、ラベル付き画像もない状態で、人体の詳細モデルを構築できた。

研究チームは、オートバイや自動車、飛行機の画像を使って同様のテストを行った。どの場合も新システムの方が、長年トレーニングされた従来のコンピュータビジョンシステム以上のパフォーマンスを発揮したという。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

サティア・ナデラ氏が語る「あらゆるアプリにAIが組み込まれる時代」、そのときユーザーが得られる「機会」とベンダーが負うべき「責任」とは

サティア・ナデラ氏が語る「あらゆるアプリにAIが組み込まれる時代」、そのときユーザーが得られる「機会」とベンダーが負うべき「責任」とは

日本マイクロソフトは、2018年11月5〜7日に「Microsoft Tech Summit 2018」を開催した。Microsoft CEOのサティア・ナデラ氏が話す、ITが身近になる中でのビジネス方法とは何なのだろうか。 ブラウン大学の研究チーム、錯視を起こすニューラルモデルを構築

ブラウン大学の研究チーム、錯視を起こすニューラルモデルを構築

ブラウン大学の研究チームは視覚系の研究の一環として、人間のように錯視を起こすニューラルネットワークコンピュータモデルを構築している。一般的なディープラーニングのアルゴリズムに含まれていない要素を取り入れたことで成果を得た形だ。 目をだます方法――触覚と認知の広がりを考える

目をだます方法――触覚と認知の広がりを考える

ユーザー参加型の学会として発足し、毎回数万人規模の視聴者を集める。2013年12月21日ニコファーレで行われた「ニコニコ学会β」第5回シンポジウム。本稿では全体のハイライトとなった人間の感覚に注目したセッションを紹介する。