Meta、音楽生成AIモデル「MusicGen」とOSSライブラリ「Audiocraft」をGituHubでリリース:Googleの「MusicLM」と異なり、4つのコードブック全てを1つのパスで生成

Metaは、音楽生成AI「MusicGen」とOSSライブラリ「Audiocraft」をGituHubでリリースした。その概要とサンプルサイト、インストール方法、使用方法、APIを紹介する。

Metaは2023年6月、音楽生成AI「MusicGen」をリリースした。MusicGenは、50Hzでサンプリングされた4つのコードブックを備える32kHzの「EnCodec」トークナイザーでトレーニングされた単一の言語モデルだ。

従来の研究とは異なり、MusicGenは単一ステージの自動回帰トランスフォーマーモデルと効率的なトークンインターリーブパターンで構成されており、複数のモデルをカスケード接続する必要がないという。例えば、Googleの「MusicLM」のような既存のメソッドとは異なり、MusicGenは自己教師ありセマンティック表現を必要とせず、4つのコードブック全てを1つのパスで生成する。コードブック間に小さな遅延を導入することで、コードブックを並行して予測できることを示し、オーディオの自動回帰ステップは1秒当たり50ステップのみになる。

このアプローチに従ってMusicGenは、テキストの説明やメロディーの特徴に応じて高品質のサンプルを生成し、生成された出力をより適切に制御できるという。

MusicGenのトレーニングには、2万時間分のライセンスされた音楽が使用されている。具体的には、1万個の高品質音楽トラックの内部データセットと、「ShutterStock」「Pond5」の音楽データを利用している。

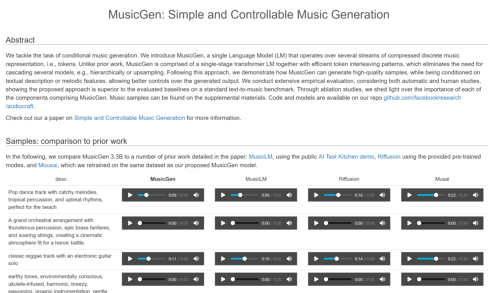

サンプルサイト

MusicGenは下記サンプルサイトで、公開されている「AI Test Kitchen」デモを使用したMusicLMや、提供済み事前トレーニングモードを使用した「Riffusion」、MusicGenと同じデータセットで再トレーニングした「Mousai」との違いを比較できる。

GiuHubリポジトリ

MusicGenのモデルと、それを含む「PyTorch」ベースのライブラリ「Audiocraft」のコードはGiuHubリポジトリで入手できる。

インストール方法

Audiocraftには、Python 3.9、PyTorch 2.0.0、少なくとも16GBのメモリを備えた GPU(中型モデルの場合)が必要だ。Audiocraftをインストールするには、次のコマンドを実行する。

# Best to make sure you have torch installed first, in particular before installing xformers. # Don't run this if you already have PyTorch installed. pip install 'torch>=2.0' # Then proceed to one of the following pip install -U audiocraft # stable release pip install -U git+https://git@github.com/facebookresearch/audiocraft#egg=audiocraft # bleeding edge pip install -e . # or if you cloned the repo locally

使用方法

MusicGenと対話するには次の方法がある。

- デモは「MusicGen - a Hugging Face Space by facebook」から入手することもできる

- 「Google Colab」の「MusicGen Demo.ipynb」で「Gradio」デモを実行できる。これを実行すると、Gradioデモをローカルで使用できる(python app.py)

- 16GB以上のメモリを備えたGPUがローカルにある場合、ローカルの「Jupyter Notebook」で「demo.ipynb」を実行することで、MusicGenで再生できる

Colabで使う場合については、「@camenduru」のColabページをチェックすることを推奨している。このページは、@camenduruとコミュニティーからの投稿で定期的に更新されている。

API

Metaは、APIと、下記4つの事前トレーニング済みモデルを提供している。

- small:300Mモデルで、テキストからの音楽生成のみ(詳細情報)

- medium:1.5Bモデルで、テキストからの音楽生成のみ(詳細情報)

- melody:1.5Bモデルで、テキストからの音楽生成とテキスト+メロディーからの音楽生成(詳細情報)

- large:3.3Bモデルで、テキストからの音楽生成のみ(詳細情報)

mediumまたはmelodyモデルの間には、品質と演算処理の最適なトレードオフが見られる。MusicGenをローカルで使用するのに必要な16GB以上のメモリを備えたGPUを推奨しているが、smallモデルでは、16GBより少ないメモリのGPUでも、短いシーケンスなら生成できるという。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

今度は「プロンプトから音楽を作るAI」が登場 Googleが「MusicLM」を提供開始

今度は「プロンプトから音楽を作るAI」が登場 Googleが「MusicLM」を提供開始

Googleは、テキストを音楽に変換できるAI(人工知能)ツール「MusicLM」の提供を開始した。楽曲生成支援を目的に開発したという。 Google Colaboratory(Jupyter Notebookのオンライン版)の使い方

Google Colaboratory(Jupyter Notebookのオンライン版)の使い方

機械学習やディープラーニングの作業環境の中でも初心者には「Jupyter Notebook」がお勧めだ。そのオンライン版「Google Colaboratory」の画面構成や基本的な使い方、お薦めのショートカットキー、オートコンプリートとヘルプドキュメントの表示機能などを説明する。 Stable Diffusion入門

Stable Diffusion入門

人気過去連載を電子書籍化して無料ダウンロード提供する@IT eBookシリーズ。第101弾は、画像生成系AIとして大きな話題を呼んだ「Stable Diffusion」を対象として、その動作原理や画像が生成される過程などを紹介します。