オンデバイスでLLMを実行できる「MediaPipe LLM Inference API」、Googleがリリース:数ステップでLLMをデバイスに導入可能

Googleは「MediaPipe」を通じてオンデバイスでLLMを実行できるLLMを実行できる「MediaPipe LLM Inference API」の実験的リリースを発表した。MediaPipe LLM Inference APIでは、LLMを使ったアプリケーションをスマートフォンなどのデバイス上で使用することができる。

Googleは2024年3月7日(米国時間)、同社が開発する機械学習ライブラリ「MediaPipe」を通じてオンデバイスでLLMを実行できる「MediaPipe LLM Inference API」の実験的リリースを発表した。

MediaPipe LLM Inference APIはWeb開発者がオンデバイスでLLMを実行できるように設計されており、Web、Android、iOSをサポートする。LLMではまず、オープンな「Gemma」「Phi2」「Falcon LLM」「Stable LM」をサポートしている。これにより、研究者や開発者は、一般に公開されているLLMモデルのプロトタイプを作成し、デバイス上でテストできる。

MediaPipe LLM Inference APIは、Android上では、実験、研究目的でのみ利用可としている。LLMを使用するプロダクションアプリケーションは、「Android AICore」を通じて、デバイス上で「Gemini API」または「Gemini Nano」を使用できる。

MediaPipe LLM Inference APIの導入

MediaPipe LLM Inference APIはWebデモまたはサンプルデモアプリで試すことができる。Web、Android、またはiOS SDKを通じて、それぞれのプロジェクトに統合できる。

MediaPipe LLM Inference APIを使用すると、数ステップでLLMをデバイスに導入できる。SDKとネイティブAPIはプラットフォームによって異なるが、これらのステップはWeb、iOS、Androidで適用できる。

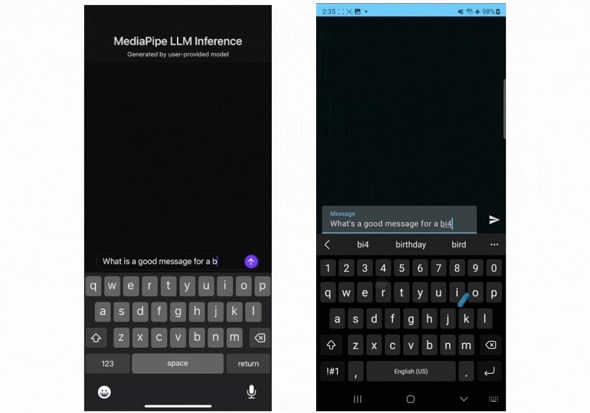

以下は、MediaPipe LLM Inference APIを介してGemma 2Bをリアルタイムで実行している様子だ。

MediaPipe LLM Inference APIが動作するモデル

2024年3月の初期リリースでは、以下の4つのモデルアーキテクチャをサポートしている。これらと互換性のあるモデルは、MediaPipe LLM Inference APIで動作する。ベースモデルの重みを使用したり、独自のデータを使用して重みを微調整したりできる。

| モデル | パラメーターサイズ |

|---|---|

| Falcon 1B | 13億 |

| Gemma 2B | 25億 |

| Phi 2 | 27億 |

| Stable LM 3B | 28億 |

モデルのパフォーマンス

LLMのレイテンシを測定する場合、考慮すべき用語と測定値が幾つかある。Googleによると、最初のトークンの取得時間(Time to First Token)とデコード速度は、応答を開始するまでの時間と、応答が開始されてから応答が生成されるまでの時間を測定するために重要なものだという。

| 用語 | 意味 | 測定方法 |

|---|---|---|

| トークン | LLMは、入力と出力に単語ではなくトークンを使用する。MediaPipe LLM Inference APIで使用される各モデルには、単語とトークンを変換するトークナイザーが組み込まれている | 100英単語≒130トークン。ただし、この変換は特定のLLMと言語に依存する |

| 最大トークン数 | LLMプロンプト+レスポンスの最大合計トークン数 | 実行時にLLM推論APIで設定される |

| 最初のトークンの取得時間(Time to First Token) | MediaPipe LLM Inference APIを呼び出してからレスポンスの最初のトークンを受け取るまでの時間 | 最大トークン数/プレフィル速度 |

| プレフィル速度(Prefill Speed) | プロンプトがLLMによって処理される速度 | モデルやデバイスによって異なるため、下記ベンチマーク数値を参照 |

| デコード速度 | LLMがレスポンスを生成する速度 | モデルおよびデバイス固有で、下記ベンチマーク数値を参照 |

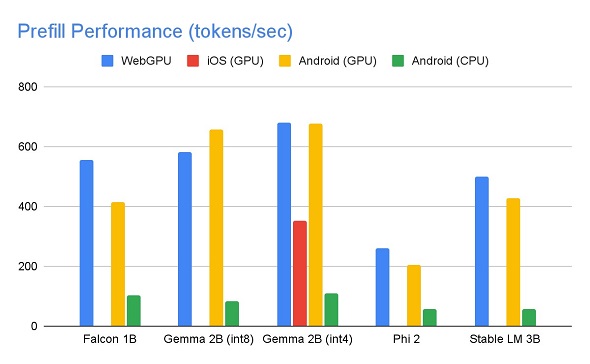

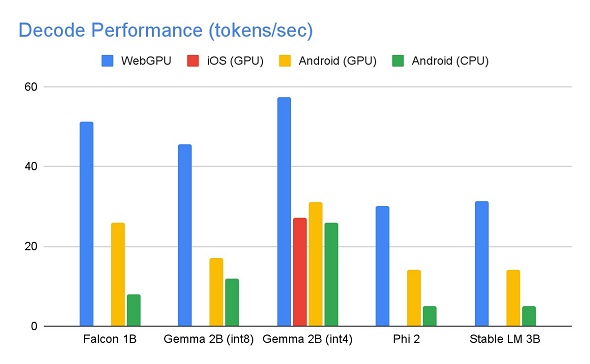

プレフィル速度とデコード速度は、モデル、ハードウェアおよび最大トークンに依存する。また、デバイスの負荷によっても変化する。

以下のスピードは、ハイエンドデバイスで、最大トークン数1280、入力プロンプト1024、int8ウェイト量子化を使用して計測されたものだ。KaggleにあるGemma 2B(int4)は例外で、4/8ビット混合のウェイト量子化を使用している。

GPU上では、Falcon 1BとPhi 2はfp32アクティベーションを使用し、GemmaとStableLM 3Bはfp16アクティベーションを使用している。Gemma 2B(int4)は、メモリ制約のためiOS上で実行できる唯一のモデルだ。GoogleはiOS上で他のモデルも実行できるよう取り組んでいるという。

今後のアップデート

2024年にかけて、より多くのプラットフォームとモデルに拡張し、より広範な変換ツール、無料のオンデバイスコンポーネント、高レベルのタスクなどに対応する予定だという。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

オープンソースのLLMをローカルで実行できる「Ollama」Windowsプレビュー版、公開

オープンソースのLLMをローカルで実行できる「Ollama」Windowsプレビュー版、公開

Ollama Projectは、オープンソースの大規模言語モデルをローカル環境で実行できる「Ollama」のWindowsプレビュー版を公開した。 LLM、AIツールの活用がAPIの需要増加要因に Gartner予測

LLM、AIツールの活用がAPIの需要増加要因に Gartner予測

Gartnerによると、2026年までにAPIの需要増加の30%以上は、大規模言語モデル(LLM)を使用するAIやツールからの需要が寄与するようになる見通しだ。 GoogleのLLM「Gemini 1.5 Pro」は最大100万トークンのロングコンテキストウィンドウに対応 どう役立つのか?

GoogleのLLM「Gemini 1.5 Pro」は最大100万トークンのロングコンテキストウィンドウに対応 どう役立つのか?

GoogleがリリースしたGemini 1.5の強みの一つに、ロングコンテキストウィンドウがある。Googleが実装したロングコンテキストウィンドウとは何か、そしてこの機能が開発者にどのように役立つのか。