「国産LLM」の構築を研究面から支援 NIIが大規模言語モデル研究開発センターを開設:2024年夏ごろをめどに1750億パラメーターのLLMを構築予定

NIIは、「大規模言語モデル研究開発センター」を開設した。まずは、NIIが主宰しているLLM勉強会の研究開発を発展させ、1750億パラメーターのLLMを構築するという。

情報・システム研究機構 国立情報学研究所(NII)は2024年4月1日、「大規模言語モデル(LLM)研究開発センター」を開設した。NIIは「AI(人工知能)研究者がLLMの研究開発にまい進できる体制を構築した」としている。

「有力な基盤モデルの学習用データは英語が中心で、日本語が弱い」

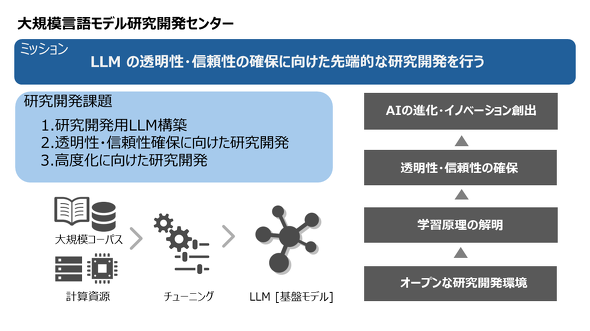

LLM研究開発センターは、文部科学省の「生成AIモデルの透明性・信頼性の確保に向けた研究開発拠点形成」事業を実施する拠点という位置付けだ。

NIIによると、LLMは全産業に波及しつつあり、基盤モデルとしてこれまでの産業基盤を抜本的に変革する可能性を秘めているとともに、幅広い科学技術研究に必須の知識基盤になると期待されているという。だが「現状は、強いモデルの学習コーパスデータは非公開で全体がブラックボックスとなっており、ハルシネーションやバイアスなどの課題がある。さらに、有力な基盤モデルの学習用データは英語が中心で、日本語の理解や生成能力は相対的に劣っている」と指摘。こうした現状を打破するのがLLM研究開発センターの目的だ。

同センターで実施する研究開発は主に3つ。1つ目は「研究開発用LLMの構築」。コーパス整備や計算環境整備、評価用ベンチマーク作成などを実施する。2つ目は「透明性や信頼性の確保に向けた研究開発」。生成AIの挙動原理を解明するだけでなく、データ改変やデータバイアスなどの影響を抑制する技術を開発する。3つ目は「LLMの高度化に向けた研究開発」。ドメイン適応やモデル自体の軽量化など、生成AIモデルの高度化に関連する研究開発をする。

当面の目標としては、NIIが主宰しているLLM勉強会(LLM-jp)の研究開発をさらに発展させ、1750億パラメーターのLLMを構築する。2024年夏ごろの完成を目指している、

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

生成AIツールで気になるセキュリティ GitHubはどう対処しているのか

生成AIツールで気になるセキュリティ GitHubはどう対処しているのか

TechTargetは、「NVIDIAとGitHubの新しいAIコーディングアシスタント」に関する記事を公開した。セキュリティ面の懸念は残るものの、ベンダー側もその懸念を解消するためにさまざまな対応を進めている。 オンデバイスでLLMを実行できる「MediaPipe LLM Inference API」、Googleがリリース

オンデバイスでLLMを実行できる「MediaPipe LLM Inference API」、Googleがリリース

Googleは「MediaPipe」を通じてオンデバイスでLLMを実行できるLLMを実行できる「MediaPipe LLM Inference API」の実験的リリースを発表した。MediaPipe LLM Inference APIでは、LLMを使ったアプリケーションをスマートフォンなどのデバイス上で使用することができる。 LLM、AIツールの活用がAPIの需要増加要因に Gartner予測

LLM、AIツールの活用がAPIの需要増加要因に Gartner予測

Gartnerによると、2026年までにAPIの需要増加の30%以上は、大規模言語モデル(LLM)を使用するAIやツールからの需要が寄与するようになる見通しだ。