写真やイラストのキャラクターを自然な3D動画に合成できる「MIMO」はどこがすごいのか?:Alibabaの研究所が発表した、制御可能なキャラクタービデオ合成モデル

Alibaba Groupのインテリジェントコンピューティング研究所は、キャラクタービデオ合成モデル「MIMO」を発表した。本物のようなシーンの中で、キャラクターのアニメーションが可能になる。

Alibaba Groupのインテリジェントコンピューティング研究所は2024年9月25日(中国時間)、キャラクタービデオ合成モデル「MIMO」(Mimic anyone anywhere in complex Motions with Object interactions)を発表した。キャラクタービデオ合成とは、実写映像にアニメーションキャラクターや3DCG(コンピューターグラフィックス)キャラクターを組み合わせる映像制作技術。MIMOを使うと、キャラクタービデオの柔軟性や制御性を大幅に向上できるという。

MIMOのどこがすごいのか?

基本的な課題として、3D作品は通常、ケースごとの学習のためにマルチビューキャプチャーを必要としている。このため、任意のキャラクターのモデリングを短時間で行うことができない。近年の2D手法は、事前に訓練された拡散モデルによってこの制限をクリアしているが、ポーズの一般性やシーンとの相互作用に苦戦している。

このため、当社はMIMOという新しい一般化可能なモデルを開発した。

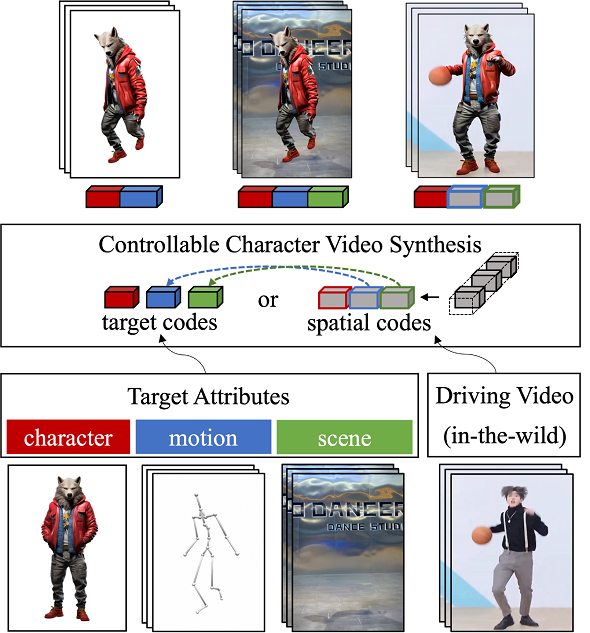

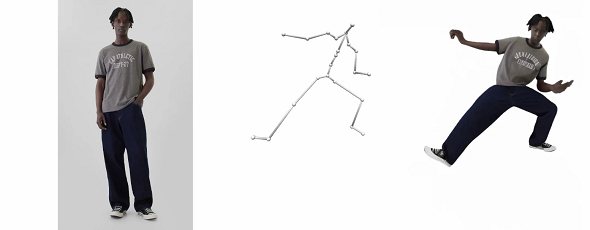

MIMOは、シンプルなユーザー入力によって属性(キャラクター、モーション、シーン)を制御可能なキャラクター動画を合成できる。それだけでなく、任意のキャラクターへの高度なスケーラビリティ、新しい3Dモーションへの一般性、そしてインタラクティブな実世界シーンへの適用性を、統一的なフレームワークに基づいて同時に達成できる。

核となるアイデア

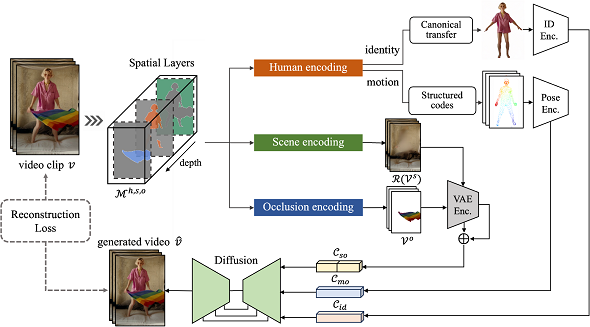

2Dビデオが本来持つ3D的性質を考慮し、コンパクトな空間コードに符号化することが、開発におけるアイデアのコアとなっている。具体的には、単眼深度推定器を用いて2Dフレームピクセルを3D化し、3D深度に基づいてビデオクリップを階層的に3つの空間構成要素(メインの人物、基礎シーン、浮遊オクルージョン)に分解する。

これらのコンポーネントは標準的なアイデンティティーコード、構造化されたモーションコード、完全なシーンコードにエンコードされ、合成プロセスの制御信号に利用される。この空間分解戦略により、柔軟なユーザー制御、空間的な動き表現およびシーンインタラクションのための3Dを考慮した合成が可能になる。実験結果は、提案手法の有効性と説得力を実証している。

ユーザーは、複数の入力(例えば、キャラクター用の単一画像、モーション用のポーズシーケンス、シーン用の単一ビデオ/画像)をそれぞれ入力するか、動作を制御する動画を直接入力して、目的の属性を提供できる。MIMOは、ターゲット属性を潜在空間に埋め込んでターゲット符号を構成し、走行映像を空間認識分解して空間符号として符号化することで、潜在符号を特定の順序で自由に統合し、合成による直感的な属性制御を可能にする。

フレームワークの概要

ビデオクリップには、3D深度に基づく階層的なレイヤーがあり、3つの空間コンポーネント(メインの人物、基礎シーン、浮遊オクルージョン)に分解される。人物コンポーネントは、標準化な外見転送と構造化されたボディーコードを介して、アイデンティティーとモーションの特性について分離され、アイデンティティーコード「Cid」とモーションコード「Cmo」に符号化される。シーン成分とオクルージョン成分は共有VAEエンコーダーで埋め込まれ、フルシーンコード「Cso」として再組織化される。これらの潜在符号は映像再構成の条件として拡散ベースのデコーダーに挿入される。

MIMOが出力できるもの

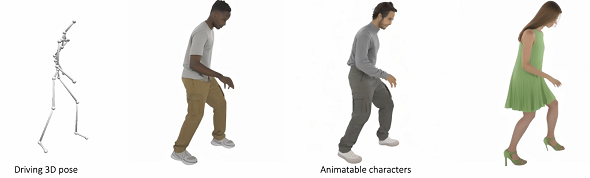

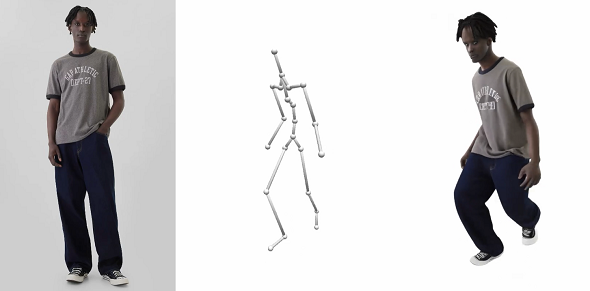

任意のキャラクター制御

1枚の画像から人間、漫画、擬人化されたものをアニメーション化できる。

新しい3Dモーションコントロール

実世界の動画から複雑な動きを再現できる。

- データベースからの空間3Dモーション

インタラクティブなシーン制御

遮蔽(しゃへい)のある物体相互作用を伴う複雑な実世界を表現したシーンを作成できる。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

Meta、テキストから動画生成、動画編集、音声生成ができる基盤モデル「Meta Movie Gen」を発表

Meta、テキストから動画生成、動画編集、音声生成ができる基盤モデル「Meta Movie Gen」を発表

Metaは、画像、動画、音声といったメディアを生成する基盤モデル「Meta Movie Gen」を発表した。 テキストから動画を生成できる動画生成AI「Gen-3 Alpha」を提供開始 Runway

テキストから動画を生成できる動画生成AI「Gen-3 Alpha」を提供開始 Runway

Runwayは同社の動画生成AIの最新モデルとなる「Gen-3 Alpha」の提供を開始した。前世代モデルよりも忠実度、一貫性、動きの表現が大きく改善されているという。 Microsoft、1枚の写真と音声から本当に話しているかのような動画を生成するAIモデル「VASA-1」を発表

Microsoft、1枚の写真と音声から本当に話しているかのような動画を生成するAIモデル「VASA-1」を発表

Microsoftは、1枚の顔の静止画像と音声クリップから、その顔の人物が本当に話しているかのような動画を生成できるAIモデル「VASA-1」を発表した。