構築からトラブルシューティングまで

構築からトラブルシューティングまで

InfiniBandで変わるデータセンター内通信(後編)

松本直人

仮想化インフラストラクチャ・オペレーターズグループ チェア

さくらインターネット研究所 上級研究員

2011/7/20

VMwareのインストールと設定

VMwareのインストールと設定

続いて、VMware vSphere ESXi 4.1に対応したInfiniBandドライバを、Mellanoxのサイトからダウンロードし、インストールを行います。インストール終了後には、ドライバが正常に導入できたかなどを確認しましょう。

|

|

| ESX41_MLNX-OFED-1.4.1-2.0.000.zipを用いたインストール手順 |

|

|

| ドライバインストール状況の確認方法 |

VMware上での仮想環境の設定

VMware上での仮想環境の設定

Scientific LinuxおよびVMwareのInfiniBandネットワーク設定が完了し、機器のインジケーターなどからも正常動作が確認できたら、さっそく仮想環境の構築に入りましょう。

|

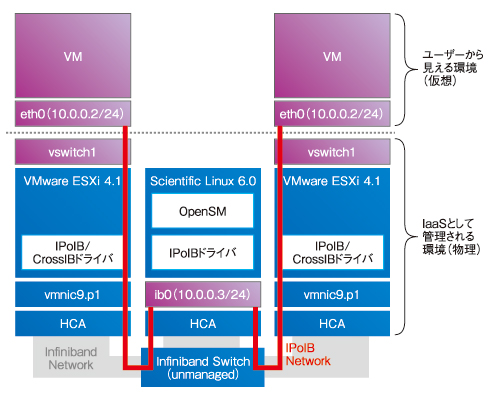

| 図3 仮想環境の設計プラン |

今回は、VMware ESXi上に作成されるVMに、InfiniBandネットワーク上に構築されたIPoIB(IP over InfiniBand)ネットワークを介して接続できるようにします。

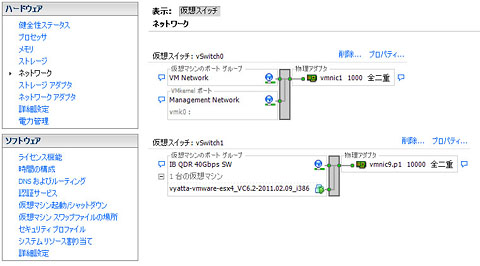

まず、VMware vSphere ClientからESXiの管理コンソールを開いて、InfiniBand HCAなどが正常に動作しているかを確認しましょう。ここでは接続されたHCAが「vmnic9.p1」として表示されています。

|

| 画面1 VMware ESXi上で動作するInfiniBand HCAカードの接続確認 |

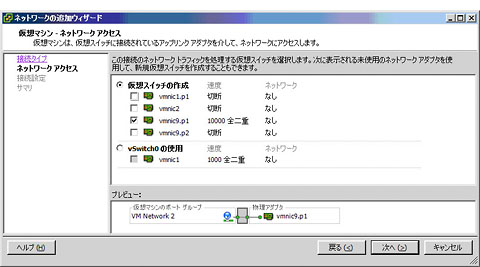

InfiniBand HCAの動作確認ができたら、その物理アダプタを用いて、仮想スイッチを追加してみましょう。ESXi上での仮想スイッチの追加は、通常のイーサネットNICを用いた場合とまったく同じです。

|

| 画面2 InfiniBandインターフェイスの動作を確認する |

|

| 画面3 InfiniBand HCAを使った物理アダプタを対象とした仮想スイッチの設定 |

| SL6# ping 10.0.0.1 ※Scientific Linux上からESXi上の仮想マシンへping確認 PING 10.0.0.1 (10.0.0.1) 56(84) bytes of data. 64 bytes from 10.0.0.1: icmp_seq=1 ttl=64 time=0.182 ms |

仮想マシンをESXi上にインストールしてIPアドレスを設定すれば、すべて完了です。上記のように、pingで疎通確認ができれば、QDR 40Gbps IP over InfiniBandネットワーク上で自由に仮想マシンを動作できます。

Scientific Linux 6.0でのトラブルシュートと動作確認

Scientific Linux 6.0でのトラブルシュートと動作確認

イーサネット環境と同じく、InfiniBand環境でも、動作確認にはいくつかのテクニックが必要になります。ここでは各種コマンドを見ていきましょう。

IPアドレスの設定状況を確認する場合には、ip addrコマンドが有効です。InfiniBandの場合、とても長いアドレスが付与される点や、MTUが初期値では2044に設定されている点などが確認できると思います。

|

|

| ip addrコマンドの実行例 |

InfiniBand HCAの設定状況を確認するには、ibstatコマンドが有効です。現在使われているカードのファームウェアのバージョンや物理アダプタの接続状況、リンクスピードなどが確認できます。

|

|

| ibstatコマンドの実行例 |

VMware ESXi 4.1でのトラブルシュートと動作確認

VMware ESXi 4.1でのトラブルシュートと動作確認

Scientific Linux同様に、VMware ESXi上でも、InfiniBandの動作確認用のコマンドがいつくか利用可能です。通常のESX管理用コマンドと併用することで、より的確に問題点を洗い出せるでしょう。

|

|

| VMware ESXi上でibstatコマンドを実行した例 |

|

|

| PCI デバイスを表示するlspciコマンドの実行例 |

|

|

| NICのリンク状態に関する情報を表示するesxcfg-nicsコマンドの実行例 |

その他、仮想マシンの動作確認などは、通常のVMware vSphere Clientに備わっているツールを通常と同じように使い、状況に応じたトラブルシュートを行うとよいでしょう。

|

| 画面4 仮想マシンの状況は、VMware vSphere Clientに備わるツールで確認できる |

| 「Master of IP Network総合インデックス」 |

- 完全HTTPS化のメリットと極意を大規模Webサービス――ピクシブ、クックパッド、ヤフーの事例から探る (2017/7/13)

2017年6月21日、ピクシブのオフィスで、同社主催の「大規模HTTPS導入Night」が開催された。大規模Webサービスで完全HTTPS化を行うに当たっての技術的、および非技術的な悩みや成果をテーマに、ヤフー、クックパッド、ピクシブの3社が、それぞれの事例について語り合った - ソラコムは、あなたの気が付かないうちに、少しずつ「次」へ進んでいる (2017/7/6)

ソラコムは、「トランスポート技術への非依存」度を高めている。当初はIoT用格安SIMというイメージもあったが、徐々に脱皮しようとしている。パブリッククラウドと同様、付加サービスでユーザーをつかんでいるからだ - Cisco SystemsのIntent-based Networkingは、どうネットワークエンジニアの仕事を変えるか (2017/7/4)

Cisco Systemsは2017年6月、同社イベントCisco Live 2017で、「THE NETWORK. INTUITIVE.」あるいは「Intent-based Networking」といった言葉を使い、ネットワークの構築・運用、そしてネットワークエンジニアの仕事を変えていくと説明した。これはどういうことなのだろうか - ifconfig 〜(IP)ネットワーク環境の確認/設定を行う (2017/7/3)

ifconfigは、LinuxやmacOSなど、主にUNIX系OSで用いるネットワーク環境の状態確認、設定のためのコマンドだ。IPアドレスやサブネットマスク、ブロードキャストアドレスなどの基本的な設定ができる他、イーサネットフレームの最大転送サイズ(MTU)の変更や、VLAN疑似デバイスの作成も可能だ。

|

|