ディスクI/Oの特性を理解し、最適化へ

ディスクI/Oの特性を理解し、最適化へ

クラウドを加速させるSSD技術(後編)

松本直人

仮想化インフラストラクチャ・オペレーターズグループ チェア

さくらインターネット研究所 上級研究員

2012/3/5

SSD Caching利用時の注意点

SSD Caching利用時の注意点

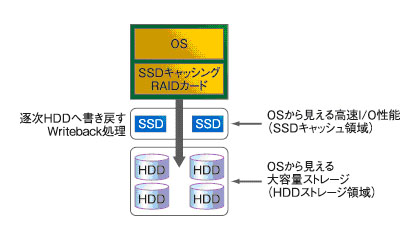

前編でも若干触れましたが、昨今のストレージ業界には、「SSD Caching」と呼ばれる最新技術を使った製品が登場し始めました。HDDとSSDを組み合わせ、「ストレージ容量はHDDと同じ、ディスク性能はSSDと同じ」という素晴らしい拡張性を持ったストレージシステムを構築することが可能になります。

今回の例では、LSIがリリースしている「CacheCade Pro 2.0」を使ったSSD Cachingの導入例を紹介します(図4)。具体的な設定例などは、LSIのWebサイトを参照してください。

|

| 図4 3TB HDDと100GB SSDを組み合わせたSSD Cachingの例(LSI CacheCade Pro 2.0の場合) |

# dmesg | grep sda

sd 0:2:1:0: [sda] 5859442688 512-byte logical blocks: (3.00 TB/2.72 TiB)

sd 0:2:1:0: [sda] Write Protect is off

sd 0:2:1:0: [sda] Mode Sense: 1f 00 10 08SSD Cachingの利用に当たって最も気を付けなればならない点は、「SSD Cacheはいつまで有効に保たれているか?」を理解することです。

SSD Cachingはその名の通り、あくまでもディスクのキャッシュとして、SSDが一時的に書き込みを受け付け、逐次、HDDへデータ書き込みを行うことで性能を保っています。SSD Cachingの環境によっては、HDDの性能が、一時的にキャッシュに書き込まれたデータをHDDに書き出すWriteback処理に追い付かなくなり、SSD Cache領域が枯渇して、性能がHDDと同等水準に落ち込む場合もあり得ます。

SSD Caching化されたストレージへの負荷、SSDやHDD本来が持つ書き込み/読み込み性能が最も安定した水準で使われてこそ、この技術が輝いてきます。SSD Caching環境を利用する場合は、くれぐれもストレージのサイジング、キャパシティ・プランニングに注意が必要です。

|

| 図5 SSD Cachingで実現された1Gbyte/secデータ書き込み環境(クリックすると拡大します) |

I/O制御の必然性

I/O制御の必然性

ディスク性能は有限な資源です。ここまで説明してきたように、SSDや10GbE NICなどの登場によって、データを取り巻く環境は高速化の一途をたどっています。しかし、ここに大きな落とし穴があることに注意が必要です。

以前であれば負荷は、HDDのディスク性能や1GbEの性能上限によって頭打ちとなっていました。そのタガが、SSDやInfiniBand、10GbE環境の登場によって、一気に外れてしまう可能性があります。

長い目で技術動向を見ていくと、ストレージ、ネットワーク、CPUという具合に、ボトルネック・ポイントは順番に移り変わっています。ある問題が解決したと思ったら別の限界にぶつかる、といった問題が存在することも、エンジニアとしては頭に置いておくとよいでしょう。

さて、SSDやInfiniBand、10GbE環境などの高速化された計算機環境では、野放図に計算機資源を共有するのではなく、I/O制御の必要性が生じます。

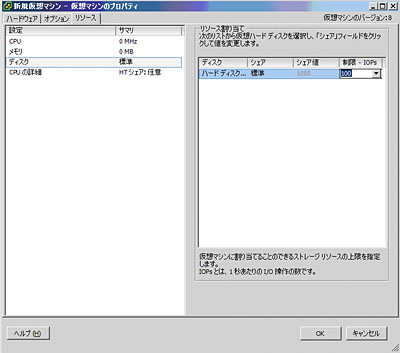

ネットワークであれば帯域制御技術がありますが、ディスクとなると、最近までは一般化されたI/O制御技術がありませんでした。こうした問題意識を踏まえ、最新技術として、VMware環境であれば「SIOC(Storage I/O Control)」が、Linux環境であれば「cgroups」などが整備されてきました。ぜひ、こういったI/O制御技術を活用していただきたいと思います。

|

| 画面2 VMware Storage I/O Controlの設定例(VMware ESXi 5.0.0の場合)(クリックすると拡大します) |

I/O制御の具体的な実験結果として、VMware ESXi 5.0.0のSIOCによる測定結果を図6に紹介します。このケースでは、動作中の仮想マシンのプロパティから、I/O制御の優先順位や具体的な性能値を簡単に投入/即時反映できます。率直な感想として、とても気持ちよく動作してくれます。

今後ますます、1台の物理サーバ環境上に膨大な数の仮想マシンが動作し、I/Oやネットワーク資源を取り合うという問題が苛烈になってくるでしょう。そこで、I/O制御技術の存在を理解した上で、システム全体の安定化のために事前に制御設定を行っておくことを強くオススメします。

|

| 図6 VMware ESXi 5.0.0 SIOCを用いたI/O制御グラフ |

InfiniBand 56Gbit/s FDR Networkという未来

InfiniBand 56Gbit/s FDR Networkという未来

SSDに代表されるストレージ環境の進化以上に、ネットワークの高速化はさらに進みつつあります。

|

| 写真2 InfiniBand 56Gbit/s FDR Network検証 |

私が現在研究しているInfiniBandの次世代規格、56Gbit/s FDR(Fourteen Data Rate)では、次世代バス環境である「PCI Express 3.0」による超高速化されたネットワーク構築が現実のものになってきました。CPUやストレージの高速化に先行する形でシステム全体を支える技術として、今後もInfiniBandをはじめとする広帯域ネットワーク技術の進歩には期待が集まっています。

| 関連記事: | |

| InfiniBandで変わるデータセンター内通信(前編) http://www.atmarkit.co.jp/fnetwork/tokusyuu/61ib02/01.html |

|

最後の砦、「ストレージ」の保全に寄せて

最後の砦、「ストレージ」の保全に寄せて

前編・後編と「クラウドを加速させるSSD技術」を紹介してきましたが、いかがでしたでしょうか。

システムにおけるストレージ環境は、データの保全と利用という意味で、逃げ場のない最後の砦となる技術です。今回紹介したさまざまな技術革新によって、いままで認識していなかった問題や対処法なども逐次出てくるいい時代になってきました。システムエンジニアの皆さんにはぜひ、これらの技術を活用して、管理下にあるシステムの保全に務めていただければと思います。

では、またの機会にお会いできれば幸いです。

| クラウドを加速させるSSD技術(後編) | |

| ディスクI/O性能の特性を理解する 「I/Oを目で見る」コマンド 10GbE SSD IP-SANを作ってみよう |

|

| SSD Caching利用時の注意点 I/O制御の必然性 InfiniBand 56Gbit/s FDR Networkという未来 最後の砦、「ストレージ」の保全に寄せて |

|

| 「Master of IP Network総合インデックス」 |

- 完全HTTPS化のメリットと極意を大規模Webサービス――ピクシブ、クックパッド、ヤフーの事例から探る (2017/7/13)

2017年6月21日、ピクシブのオフィスで、同社主催の「大規模HTTPS導入Night」が開催された。大規模Webサービスで完全HTTPS化を行うに当たっての技術的、および非技術的な悩みや成果をテーマに、ヤフー、クックパッド、ピクシブの3社が、それぞれの事例について語り合った - ソラコムは、あなたの気が付かないうちに、少しずつ「次」へ進んでいる (2017/7/6)

ソラコムは、「トランスポート技術への非依存」度を高めている。当初はIoT用格安SIMというイメージもあったが、徐々に脱皮しようとしている。パブリッククラウドと同様、付加サービスでユーザーをつかんでいるからだ - Cisco SystemsのIntent-based Networkingは、どうネットワークエンジニアの仕事を変えるか (2017/7/4)

Cisco Systemsは2017年6月、同社イベントCisco Live 2017で、「THE NETWORK. INTUITIVE.」あるいは「Intent-based Networking」といった言葉を使い、ネットワークの構築・運用、そしてネットワークエンジニアの仕事を変えていくと説明した。これはどういうことなのだろうか - ifconfig 〜(IP)ネットワーク環境の確認/設定を行う (2017/7/3)

ifconfigは、LinuxやmacOSなど、主にUNIX系OSで用いるネットワーク環境の状態確認、設定のためのコマンドだ。IPアドレスやサブネットマスク、ブロードキャストアドレスなどの基本的な設定ができる他、イーサネットフレームの最大転送サイズ(MTU)の変更や、VLAN疑似デバイスの作成も可能だ。

|

|