知らないと大損する、Apache Sparkの基礎知識と3つのメリット:特集:IoT時代のビジネス&IT戦略(3)(1/3 ページ)

社会一般から大きな注目を集めているIoT(Internet of Things)。だが、その具体像はまだ浸透しているとはいえない。今回は、IoTやビッグデータのキーテクノロジとして注目されている「Apache Spark」について、Sparkを製品に取り込んでいる日本IBMの土屋敦氏と、数多くの企業のデータ分析を担うブレインパッドの下田倫大氏に話をうかがった。

大規模データ処理のテクノロジとしてApache Hadoop(以下、Hadoop)に続き、Apache Spark(以下、Spark)が注目されている。Sparkは、IoT(Internet of Things)やビッグデータのキーテクノロジとして注目されているが、エンタープライズ領域ではどのように活用できるのだろうか。Sparkを製品に取り込んでいる日本IBMの土屋敦氏と、数多くの企業のデータ分析を担うブレインパッドの下田倫大氏に、Sparkの現状について話をうかがった。

IoTに取り組み始めた業界と導入の課題

―――IoTが注目されている中で、どのような企業がデータ活用を行い、どのような効果が生まれているのでしょうか。

土屋氏 企業は、実際にIoTがどんなもので、そこからどのような利益を得ることができるかに悩んでいる状況だと思います。しかし、これは、以前「ユビキタス」と呼ばれていたころと同じで、「蓄積したデータをどのように有効活用してサービスにつなげるか」という課題は、昔と変わっていません。IoTでは、通信やテクノロジが進化して、データをさらに蓄積しやすい環境になっていますが、企業は同じ課題に取り組んでおり、悩んでいるのだと思います。

下田氏 私も、同感ですね。技術者の中には、「IoTはユビキタスの焼き直しのトレンドだ」と言う方もいるくらいで、IoTの文脈はユビキタスと非常によく似ていると思います。これまでと違うのは、大規模なデータの分析と大規模な通信が行える環境が整い、Deep Learningや機械学習、人工知能などによって分析を深堀りできるようになり、「集めたデータを活用していこう」というトレンドが生まれていることです。

土屋氏 IBMのお客さまの場合は、例えば製造業で製造ラインからのログを収集して活用するといった分野が先行している状況ですね。

下田氏 当社の場合は、例えば、「データを分析してロジスティクスを最適化したい」「機械の故障予測を行いたい」といった相談が非常に増えてきています。自社で行うのではなく、われわれのような外部の会社に任せる、つまり「データ分析を外で試してみよう」という流れを感じていますし、今後、ますますその流れが加速するものと見ています。

ただし、例えばロジスティクスを最適化した結果を社内に取り込んでシステム化する段階になると、さまざまな課題があり、改革を実現したい企業はそれらを克服する必要があると感じています。

―――企業がデータ分析をアクションにつなげるまでに、どのような課題を克服する必要があるのでしょうか。

下田氏 例えば、情報システム部門と事業部門の分断が課題だと思います。事業部門と相談して「分析をどう行うか」を決めても、ビジネスやオペレーションに落とし込む際に必ず情報システム部門との連携が必要となります。業界内で先行事例となるような取り組みをされている当社のお客さまの多くは、事業部門と情報システム部門がうまく連携した協力関係を築いていらっしゃいます。

海外では、例えばマーケティングの責任者であるCMO(Chief Marketing Officer)が技術的なことも理解していなければならないということで、「CTMO(Chief Technology Marketing Officer)」という概念も生まれています。データや基幹システムを扱う部門とビジネスの部門が縦割りだと、今後のIoTやデータ活用が大きな流れになりにくいと感じています。

土屋氏 われわれも、お客さまの課題を同じように感じています。プロジェクトとして分析を行う場合に、明確なROIが求められることがありますが、結果が最初から分かっているのなら分析を行う必要はありません。経営側から投資対効果を求められる一方で、「実際に分析してみるまで結果が分からない」という点でジレンマを感じているケースは多いのではないでしょうか。IT部門と事業部門が横断的で、経営層ともつながっているような組織体制でなければ、難しいと思います。

Sparkが注目される3つの理由と企業側のメリット

―――そのような状況の中で、なぜSparkは注目されているのでしょうか。

土屋氏 Spark自体は、2010年からオープンソースのプロジェクトが始まっており、ここ1〜2年で生まれたテクノロジではありません。そのため、急にSparkが注目されていることを不思議に思っている技術者も多いと思います。

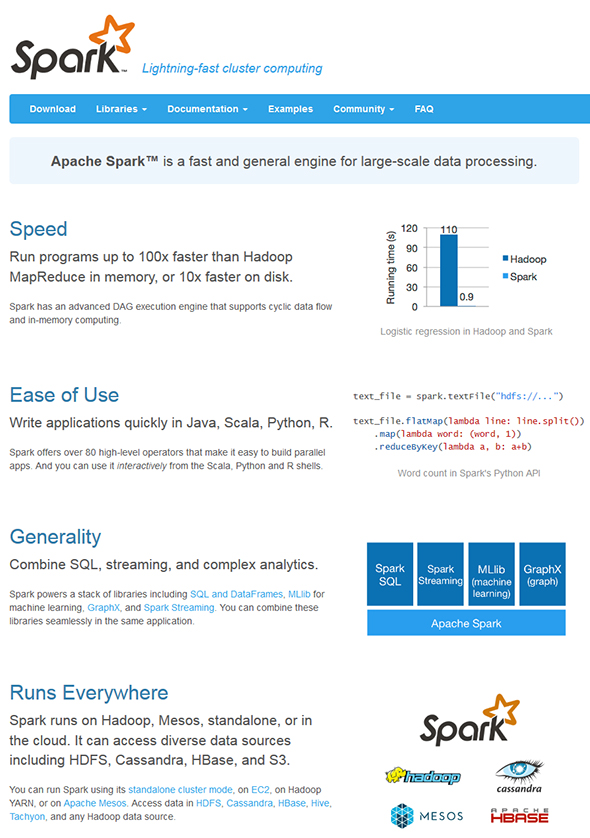

注目されている一つの理由としては、Hadoopがある程度落ち着いて事例も出てきている中で、メリットを出せたケースと課題が残ったケースが明確になってきたことがあります。Hadoopは使い方によってはバッチ処理性能が遅いケースがあるため、より処理性能が高いSparkを使って課題を解決することに注目が集まっているのではないでしょうか。

【1】技術者でなくても使いやすい

下田氏 大規模データ分析でHadoopが注目された延長線上にあると思います。Hadoopの活用が進むにつれ、利用する人が「足りない」と思った部分がSparkの設計思想に埋め込まれていることで、Sparkが注目されていると思います。

Hadoopでは技術者でなければ分析を行えませんでしたが、SparkではPythonのAPIが提供されていたり、R言語を利用できる「SparkR(R on Spark)」が提供されているため、「より分析者向けになったビッグデータのテクノロジ」といえます。大規模データを扱いたいユーザーの裾野を広げて、技術者と分析者の垣根を下げるプロジェクトとして注目されていますね。

【2】すぐにデータ分析が始められる

土屋氏 ビッグデータやIoT、インダストリー4.0というキーワードが出てきて、データ分析で何かしなければならないという流れがあると思います。実際にデータ分析をうまく活用している事例が増え、「どのように分析すればよいのか」「分析した結果、何が分かるのか」が見えてきた中で、データ分析に取り組むきっかけの一つとしてSparkが注目されているのではないでしょうか。

下田氏 ダイレクトに「Sparkを使いたい」という依頼があるケースはほとんどありません。ですが、「早く結果が欲しい」「多角的にさまざまな分析を行いたい」というケースはどんどん増えてきています。Hadoopは、大規模なデータの全てを集計して結果を見るということには適していますが、もう一歩踏み込んで、機械学習やデータマイニングを行いたいというニーズに対しては限界もあります。大規模データをインタラクティブかつ多角的に分析してみたいというニーズが増えたことも、Sparkが必要とされる理由だと思います。

―――エンタープライズ領域で、Sparkはどのようなメリットを生むと考えていますか。

土屋氏 エンタープライズでのSparkのメリットは、前述のようにデータ分析者とインフラを扱う技術者の垣根を下げて、両者が扱えるようになることです。また、IoTで大量のデータを収集できるようになってきている中で、「データを効率的に、できるだけ短い期間で分析したい」というニーズを満たせることもメリットになると思います。

【3】さまざまなデータソースに対応できる

下田氏 Sparkは、HDFS、Amazon S3、Google Cloud Storageなどのさまざまなデータソースに対応しており、企業がすでに持っているデータソースから出し入れしやすいという点もメリットです。AWSやグーグルなどのパブリッククラウドの大手は、すでにSparkをサポートしているので、「まず始めてみよう」というハードルを業界全体で下げていることもポイントで、分析環境を作りやすくなっています。

土屋氏 OpenStackのSwiftからデータを取り込めれば、大量のセンサーから集めてきたデータをSparkで処理できます。処理した結果も、HadoopのエコシステムであるhBaseやデータベースなどのさまざまなシステムに書き込めるなど、非常に自由度が高いですね。また、Sparkを利用している半数以上のお客さまが、クラウド上にシステム構築しています。インフラの導入設定、運用保守に時間やコストを掛けずに、「as a Service」で短時間で使うというケースが圧倒的に多いと思います。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

IoTの循環プロセスを形成する4つのステップとは

IoTの循環プロセスを形成する4つのステップとは

世の中全体に大きなインパクトをもたらすとして、社会一般から大きな注目を集めているIoT(Internet of Things)。だが、その具体像はまだ浸透しているとはいえない。そこで本特集ではIoTがもたらすインパクトから、実践に必要なインフラ、ノウハウまで、順を追って掘り下げていく。今回は、IoTの研究開発に余念がない現場の技術者に4ステップに分かれるIoTのプロセスと、各ステップに必要な技術要素や課題などについて聞いた。 IoTとは何か?企業、社会をどう変えるのか?

IoTとは何か?企業、社会をどう変えるのか?

世の中全体に大きなインパクトをもたらすとして、社会一般から大きな注目を集めているIoT(Internet of Things)。だが、その具体像はまだ浸透しているとはいえない。そこで本特集ではIoTがもたらすインパクトから、実践に必要なインフラ、ノウハウまで、順を追って掘り下げていく。 Hadoop→Redshift→その先は?――IoT/ハイブリッド時代の最新トレンドを整理する

Hadoop→Redshift→その先は?――IoT/ハイブリッド時代の最新トレンドを整理する

人間や機械の活動をデータとして取り込むIoTの出現で、クラウド上の「データベースサービス」をエンタープライズでも利用する場面が増えてきた。データベースとクラウドの関係、データ活用のリアルを、ITジャーナリスト 谷川耕一氏の視点でひも解く。 Apache Sparkに注力するIBM、目指すは「データ分析のOS」

Apache Sparkに注力するIBM、目指すは「データ分析のOS」

北米トヨタ販売子会社での採用事例の発表などもあり、日本国内でも注目を集めつつある「Apache Spark」。具体的にはどんな特徴があって、何ができるのだろうか。Sparkへの大規模投資を発表したIBM(日本IBM)を取材した。 Hadoopは「難しい・遅い・使えない」? 越えられない壁がある理由と打開策を整理する

Hadoopは「難しい・遅い・使えない」? 越えられない壁がある理由と打開策を整理する

ブームだったHadoop。でも実際にはアーリーアダプター以外には、扱いにくくて普及が進まないのが現状だ。その課題に幾つかの解決策が出てきた。転換期を迎えるHadoopをめぐる状況を整理しよう。