軽量動作も可能なオープンソースの大規模言語モデル「Falcon」が登場:一般的なPCでも推論やファインチューニングが可能に

UAEのTechnology Innovation Instituteは、Apache-2.0ライセンスの下でリリースした言語モデル「Falcon」について公式ブログで紹介した。

UAE(アラブ首長国連邦)のTechnology Innovation Institute(以下、TII)は2023年6月5日(現地時間)、Apache 2.0ライセンスの下でリリースした言語モデル「Falcon」について公式ブログで紹介した。

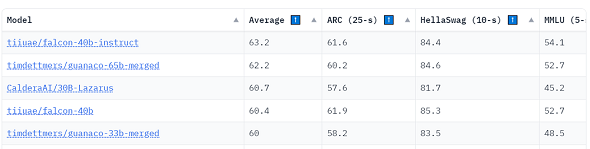

Falconは、「Falcon-40B」と「Falcon-7B」の2つのベースモデルで構成されている。40Bモデルは2023年6月時点で、オープンソースLLMのベンチマーク比較「Open LLM Leaderboard」で公開されているランキングのトップに位置している。7Bモデルは同規模のモデルの中で最も高い性能を示したという。

Falcon-40Bは、約90GBのGPUメモリを必要とする。これは、性能が優れているLLaMA-65Bよりも少ない数値だ。一方、Falcon-7BはGPUメモリを約15GBしか必要とせず、推論やファインチューニングを一般的なコンピュータでも利用できるという。

TIIは、モデルのinstructバージョンである「Falcon-7B-Instruct」と「Falcon-40B-Instruct」も提供している。これらは、命令と会話データにファインチューニングされており、より一般的なアシスタントタスクに適している。モデルを素早く試したい場合は、これらのバージョンが適しているという。また、コミュニティーによって作成されたさまざまなデータセットを基に、独自のinstructバージョンを作成することも可能だ。

訓練データの詳細

Falcon-7BとFalcon-40Bは推論を最適化するために、それぞれ1.5兆トークンと1兆トークンのデータで訓練された。Falconの高品質を支える主要な要素は、訓練データにあるという。これらのデータは、主にCommonCrawlに基づく新しい大規模Webデータセットである「RefinedWeb」を使用している(80%以上)。

TIIは、分散し選定されたソースを収集する代わりに、Webデータの拡大と品質向上に重点を置いており、大規模な重複削除と厳格なフィルタリングを活用して、他のコーパスと同じ品質を実現している。Falconの訓練には「Reddit」などの会話データなどのソースが含まれているが、その割合は「GPT-3」や「PaLM」などの最先端のLLMに比べて少ないという。

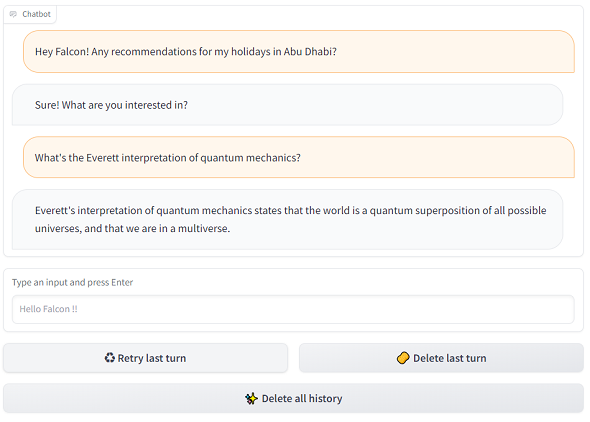

デモ

公式ブログに埋め込まれたプレイグラウンドで、Falcon-40Bを試すことができる。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

「Google Colab」でAIコーディング機能が利用可能に コード補完、自然言語によるコード生成など

「Google Colab」でAIコーディング機能が利用可能に コード補完、自然言語によるコード生成など

Googleは、「Google Colab」に間もなく、AIコーディング機能(コード補完、自然言語によるコード生成、コーディング支援チャットbotなど)を追加すると発表した。 OpenAI、LLMの「GPT-4」および「GPT-3.5」ファミリーの最新モデルをリリース 関数呼び出しなど可能に

OpenAI、LLMの「GPT-4」および「GPT-3.5」ファミリーの最新モデルをリリース 関数呼び出しなど可能に

OpenAIは、大規模言語モデル(LLM)の「GPT-4」および「GPT-3.5」ファミリーの最新モデルをリリースし、「Chat Completions API」への関数呼び出し機能の追加などのアップデートを紹介した。 Google、リアルタイムのコード提案などをする開発者向けAI機能「Duet AI for Google Cloud」を発表

Google、リアルタイムのコード提案などをする開発者向けAI機能「Duet AI for Google Cloud」を発表

GoogleはGoogle Cloudの開発者向けにAIを活用した開発支援の機能「Duet AI for Google Cloud」を発表した。Duet AIは開発者に対してリアルタイムのコード提案やチャット支援などに役立つという。