新型DPU「NVIDIA BlueField-4」搭載、エージェント型AIの推論を高速化するストレージ:AIエージェント時代に求められるインフラ

NVIDIAは、DPUの新型モデル「NVIDIA BlueField-4」を搭載した次世代AI向けのストレージインフラ「NVIDIA Inference Context Memory Storage Platform」を発表した。

NVIDIAは2026年1月5日(米国時間)、同社のDPU(データ処理ユニット)の最新モデルである「NVIDIA BlueField-4」が、次世代AI(人工知能)技術を支える新たなストレージインフラ「NVIDIA Inference Context Memory Storage Platform」に搭載されることを発表した。

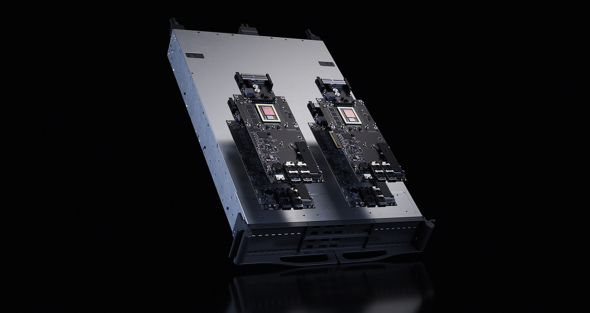

AI向けストレージインフラ「NVIDIA Inference Context Memory Storage Platform」にDPU「NVIDIA BlueField-4」搭載(提供:NVIDIA)

同社はAI向けストレージインフラを提供する背景として、AIモデルのパラメーター数が数兆規模に達し、推論処理も複数の対話や工程を含む「マルチターン推論」(多段階推論)へと高度化する中で、精度やユーザー体験、対話の継続性を維持するために必要な「キーバリュー(KV)キャッシュ」のデータ量が急増している点を挙げている。

BlueField-4搭載――ストレージの性能を最大5倍高速・高効率に

KVキャッシュをGPU(グラフィックス処理ユニット)上に長期間保持することは、複数のAIエージェントが協調して処理を行う「マルチエージェントシステム」のリアルタイム推論では、性能上のボトルネックを引き起こす可能性がある。こうした背景から、AIネイティブアプリケーションには、KVキャッシュを効率的に保存・共有できるスケーラブルなストレージインフラが必要とされているという。

NVIDIA Inference Context Memory Storage Platformは、GPUのメモリ容量を拡張し、複数のノード間でコンテキスト情報を高速に共有できるようにする。従来型ストレージと比較して、1秒当たりのトークン数を最大5倍に増強し、電力効率も最大5倍に高める。AIに最適化された新しいコンテキストメモリのインフラを提供する。

NVIDIAのCEOであるジェンスン・フアン氏は、「AIはコンピューティングスタック全体を変革し、今度はストレージにも革命をもたらす」と述べる。

「AIは単発のチャットbotではなく、物理世界を理解し、長期的な視点で推論を行い、事実に基づいて行動し、ツールを使用して実際の作業をこなす知的なパートナーへと進化している」とフアン氏は指摘。NVIDIA BlueField-4を活用し、ソフトウェアおよびハードウェアのパートナー企業と共に、次世代AIに向けたストレージスタックを再構築する意向を示している。

BlueField-4搭載プラットフォームの主な機能

1:クラスタレベルのKVキャッシュ容量

次世代のAIスーパーコンピュータプラットフォーム「NVIDIA Rubin」のクラスタレベルのKVキャッシュ容量により、長いコンテキストやマルチターンのエージェント型推論に必要なスケールと効率を実現する。

2:優れた電力効率

従来のストレージと比較して、最大5倍の電力効率を達成している。

3:スマートな高速共有

データセンターインフラの開発を支援するフレームワーク「NVIDIA DOCA」(Data Center Infrastructure-on-a-Chip Architecture)を基盤としており、推論データの転送を最適化するライブラリ「NVIDIA NIXL」(NVIDIA Inference Transfer Library)や、分散推論を可能にするソフトウェア「NVIDIA Dynamo」と緊密に統合。複数のAIノード間でKVキャッシュを高速に共有し、1秒当たりのトークン処理数を最大化するとともに、最初のトークン生成までの時間を短縮して、マルチターン対話における応答性を大幅に向上させる。

4:ハードウェアアクセラレーション対応の配置

NVIDIA BlueField-4が管理する、ハードウェアアクセラレーションに対応したKVキャッシュの配置により、メタデータに伴うオーバーヘッド(処理負荷)を排除し、不要なデータ移動を抑制できる。これにより、GPUからの安全かつ分離されたアクセスが可能になり、システム全体の効率とセキュリティが向上する。

5:高性能ネットワークファブリック

AI向けに最適化されたイーサネットネットワーク「NVIDIA Spectrum-X Ethernet」は、効率的なデータ共有と高速検索を可能にする。AIネイティブなKVキャッシュに対して、RDMA(リモートダイレクトメモリアクセス)ベースのアクセスをサポートし、高性能なネットワークファブリックとして機能する。

NVIDIA BlueField-4を搭載した次世代のAI向けストレージインフラの構築には、複数のストレージ技術ベンダーやイノベーターが参画している。NVIDIA BlueField-4は、2026年後半に提供開始予定となっている。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

推論コストを10分の1に? NVIDIAが次世代AIプラットフォーム「Rubin」発表

推論コストを10分の1に? NVIDIAが次世代AIプラットフォーム「Rubin」発表

NVIDIAは、次世代AIコンピューティングプラットフォーム「Rubin」を発表した。前世代のBlackwellと比較して推論トークンの生成コストを最大10分の1に削減し、大規模モデルのトレーニングに必要なGPU数を4分の1に抑えるという。 NVIDIA、オープン世界基盤モデルやマルチモーダルRAGなどを発表

NVIDIA、オープン世界基盤モデルやマルチモーダルRAGなどを発表

NVIDIAは、AI活用を促進するための新たなオープンモデルや機能追加を発表した。オープン世界基盤モデルやフィジカルAI、自動運転車開発、ヘルスケア・ライフサイエンス向けの発表内容をまとめる。 Microsoft、新AIチップ「Maia 200」発表 推論性能3倍でNVIDIA依存から脱却へ

Microsoft、新AIチップ「Maia 200」発表 推論性能3倍でNVIDIA依存から脱却へ

Microsoftは、新型AIアクセラレータ「Maia 200」を発表した。FP4で10ペタFLOPSを上回り、Amazon Trainiumの約3倍の性能を実現するという。既にOpenAIのGPT-5.2など主要サービスに採用され、推論コスト削減とNVIDIA依存脱却を進める戦略的チップとして注目されている。