「軽量12Bが27B超えのパフォーマンス」その要因は? Google、Gemma 3ベースの翻訳モデル公開:モバイルやローカルでも動かせるTranslateGemma

Googleは、Gemma 3をベースとした新翻訳モデル「TranslateGemma」を発表した。4B、12B、27Bのパラメーターサイズで提供される。

Googleは2026年1月15日(米国時間)、軽量大規模言語モデル「Gemma 3」をベースに構築された新しいオープン翻訳モデル群「TranslateGemma」を発表した。55言語をサポートし、4B(40億)、12B(120億)、27B(270億)の3つのパラメーターサイズで利用可能。

12Bモデルが27Bベースラインを上回るパフォーマンス

ベンチマークデータセット「WMT24++」を用いた評価指標「MetricX」による測定で、TranslateGemmaの12Bモデルは、Gemma 3の27Bベースラインのパフォーマンスを上回った。ベースモデルの半分以下のパラメーターで高い翻訳品質を確保できるため、精度を犠牲にすることなく、スループットの向上とレイテンシの低減を可能にするという。

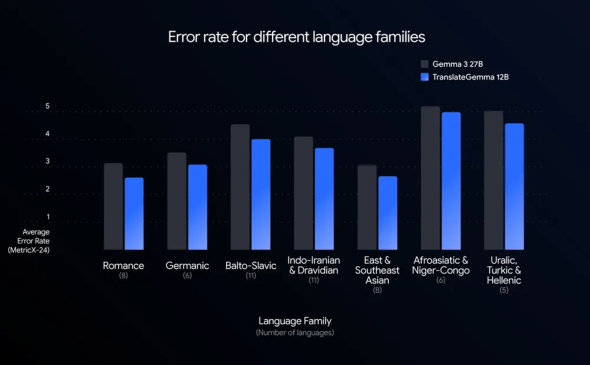

なお55言語を含むWMT24++を用いてTranslateGemmaをテストした結果、全ての言語においてベースになったGemmaモデルと比較してエラー率を大幅に低減し、効率性を高めつつ、同時に品質を向上させたという。

2段階のファインチューニングプロセスでGeminiの知識を蒸留

Googleでは今回、TranslateGemmaの各モデルを開発するに当たり、「Gemini」の知識を蒸留するためのファインチューニングを2段階で実施している。

第1段階は教師ありファインチューニングで、基本となるGemma 3モデルに対して多様な並列データセットを用いた。このデータセットには、人間が翻訳したテキストと、最先端のGeminiモデルによって生成された高品質な合成翻訳が豊富に含まれているという。

第2段階では、翻訳品質をさらに洗練させるために、新しく強化学習フェーズが実装された。ここでは「MetricX-QE」「AutoMQM」といった高度な指標を含む報酬モデルの組み合わせを採用することで、モデルが、より文脈に即した自然な翻訳を生成するようにしている。

55言語のサポートとマルチモーダル機能の維持

TranslateGemmaは、スペイン語、フランス語、中国語、ヒンディー語などの主要言語に加え、リソースの少ない多様な言語を含む55言語の組み合わせでトレーニングと評価が行われ、信頼性と品質を向上させているという。これらの中核言語以外にも、約500の追加言語ペアでのトレーニングによってさらに能力を拡張している。

TranslateGemmaモデルは、Gemma 3のマルチモーダル機能を引き継いでいる。Vistraの画像翻訳ベンチマークを使ったテストによると、TranslateGemmaの学習プロセスではマルチモーダルに特化したファインチューニングをしていないにもかかわらず、テキスト翻訳能力の向上が画像内テキストの翻訳能力にもプラスの影響を与えていることが確認できたという。

デバイス環境に合わせた3つのサイズ展開

なおTranslateGemmaは、ユーザーの多様なニーズに応えるために以下の3つのモデルサイズが用意されている。

- 4Bモデル:モバイルおよびエッジ向け

- 12Bモデル:ローカル開発環境向け。ノートPCでもスムーズに動作可能

- 27Bモデル:最も高い精度を求める用途向け。クラウド上の単一の「NVIDIA H100」GPUまたはTPU(Tensor Processing Unit)での実行が可能

現在TranslateGemmaのテクニカルレポートが公開されている他、「Kaggle」「Hugging Face」でのダウンロード、「Gemma Cookbook」を通じた調査・学習、「Vertex AI」でのデプロイが可能になっている。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

NVIDIA、オープン世界基盤モデルやマルチモーダルRAGなどを発表

NVIDIA、オープン世界基盤モデルやマルチモーダルRAGなどを発表

NVIDIAは、AI活用を促進するための新たなオープンモデルや機能追加を発表した。オープン世界基盤モデルやフィジカルAI、自動運転車開発、ヘルスケア・ライフサイエンス向けの発表内容をまとめる。 Google Meetが音声同時通訳に対応 話者の声に似た音声でほぼリアルタイム翻訳が可能に

Google Meetが音声同時通訳に対応 話者の声に似た音声でほぼリアルタイム翻訳が可能に

Googleは、「Google Meet」にリアルタイム音声翻訳機能を追加した。まずはイタリア語、ポルトガル語、ドイツ語、フランス語に対応する。 ローカルLLMって何? メリット、デメリット、活用例を分かりやすく解説

ローカルLLMって何? メリット、デメリット、活用例を分かりやすく解説

ローカルLLMは、クラウドサービスではなく、社内サーバやクライアント端末上でLLMを利用できる技術だ。本記事では、GPUコストや運用面に不安を抱えるIT部門、情報システム担当者、経営層向けに、ローカルLLMの概要と導入のポイントを分かりやすく解説する。