Google、モバイルアプリ開発で視覚処理などの機械学習を利用しやすい「ML Kit」をリリース:Pose Detection API β版も機能強化

Googleは機械学習に対応したモバイルSDK「ML Kit」の一般提供を開始した。合わせてSelfie Segmentation API β版のML Kitへの追加と、ML Kitに含まれるPose Detection API β版の機能強化も発表した。モバイルアプリケーション開発者が視覚処理と自然言語処理に関する機械学習を利用しやすくなる。

Googleは2021年3月9日(米国時間)、Googleのオンデバイス機械学習機能を利用したAndroidアプリケーションやiOSアプリケーションを開発するためのモバイルSDK「ML Kit」の一般提供を開始した。合わせて、Selfie Segmentation(自撮り写真分割)APIのβ版をML Kitへ追加し、ML Kitに含まれるPose Detection(姿勢検知)APIのβ版の機能強化を発表した。

ML Kitの一般提供開始

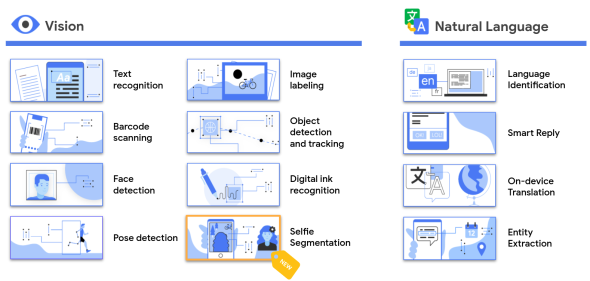

ML Kitは、AndroidやiOSを対象とする開発者がアプリケーションで機械学習を簡単に利用できるようにすることを目指しており、2018年5月にGoogleがβ版を発表した。ML Kitには視覚と自然言語処理をベースにしたユースケースに役立つAPIセットが含まれており、Googleはこれらを急ピッチで拡充してきた。今回、Selfie Segmentation API、Pose Detection API、Entity Extraction(エンティティー抽出)APIを除く、ML Kitの全APIの一般提供を開始した。

Selfie Segmentation APIの追加

Selfie Segmentation APIは画像内のユーザーと背景を簡単に分離し、重要なものにフォーカスする際に役立つ。

これまで、自撮り写真にクールな効果を加えたり、被写体を面白い背景に置いたりすることは、簡単ではなかった。

Selfie Segmentation APIは静止画と動画、全身と半身の画像に対応する。

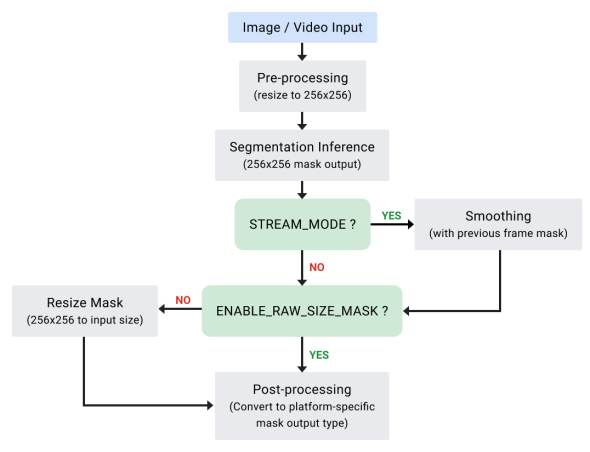

Selfie Segmentation APIは、入力画像から出力マスクを生成する。マスクの各ピクセルには、0.0〜1.0の範囲にある浮動小数点数が割り当てられる。その数が1.0に近いほど、ピクセルが人を表す信頼度が高くなる。

動画を入力した場合、前のフレームの出力を利用して、スムーズな分割結果を返す。さらに同APIは、1人または複数の被写体のサポートや、リアルタイム処理、RAWサイズマスクといった機能も提供する。

Pose Detection APIの機能強化

Pose Detection APIはアプリケーション開発者が動画や静止画からリアルタイムで被写体の姿勢を検知するための多様な機能を提供する軽量ソリューションだ。

Googleは2021年2月に、Pose Detection APIをアップデートしている。アップデート内容の概要は次の通り。

- より多くの姿勢を検知

フィットネスやヨガといったユースケース向けに、より多くの姿勢やポーズを認識できるようになった。 - 50%のサイズ削減

ベースとなる姿勢モデルのサイズを大幅に縮小した。この変更はモデルの品質に影響しない。 - 深度分析のためのZ座標

深度を示すZ座標を出力するようになった。この機能は、ユーザーの体のさまざまな部分がユーザーの臀部(でんぶ)の前後どちらにあるのかを判断するのに役立つ。

GoogleによればZ座標は実験的な機能であり、顔を除く全ての点を対象に計算される。Z座標を推定する際には、Googleが開発した人体モデル(GHUMモデル)を用いている。

Z座標はX座標やY座標と同様に画像ピクセルで表される。Z軸はカメラに垂直な方向で、対象の臀部を通る。Z軸の原点は、臀部のほぼ中心点だ。Z値がマイナスの場合はカメラに近く、プラスの場合はカメラから遠い。Z座標には上限値や下限値は設定されていない。

姿勢分類も可能に

Pose Detection APIのリリース後、開発者からGoogleに寄せられた要望は複数ある。中でもアプリケーション内で特定のポーズの分類を望む要望が多かったという。

そこで今回、ポーズ分類のチュートリアルとインタラクティブな「Google Colab」ページを公開した。分類チュートリアルでは、ML Kitを用いてAndroidサンプルアプリケーション内でカスタムポーズ分類器を構築して実行する方法を紹介した。腕立て伏せとスクワットの動画を対象にレップカウンターを実現したデモもある。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

2021年の「AI/機械学習」はこうなる! 5大予測

2021年の「AI/機械学習」はこうなる! 5大予測

2020年は、自然言語処理(NLP)のTransformer技術に基づくBERT/GPT-3や、画像生成のディープフェイクが大注目となる一方で、倫理に関する問題がさまざまな方面でくすぶり続けた。2021年の「AI/機械学習」界わいはどう変わっていくのか? 幾つかの情報源を参考に、5個の予測を行う。 画像認識の機械学習を、無料で誰でも簡単に作れる「Microsoft Lobe」

画像認識の機械学習を、無料で誰でも簡単に作れる「Microsoft Lobe」

画像分類を行う機械学習モデルを「無料」で作成できるLobe。その機能と特徴を作業手順の流れで一通り解説。知識ゼロでもGUI操作で簡単に機械学習できるLobeを体感してみよう。 ImageNet:大規模なカラー写真の画像データベース

ImageNet:大規模なカラー写真の画像データベース

データセット「ImageNet」について説明。1400万枚以上のカラー写真(教師ラベルは2万カテゴリー)の画像データ(のURLなど)が無料でダウンロードでき、画像認識などに利用できる。主に研究/教育目的で用いられてきた歴史的に有名なデータセットであるが、現在では多くの問題も指摘されている。