AIは「無制限に開発・構築してはならない」、Microsoftが「責任あるAI基準」公開 一部機能は中止へ:顔認識サービスで「感情や年齢などを推論する機能」の提供を中止

Microsoftは同社のAIシステムの構築方法を導くフレームワーク「Microsoft Responsible AI Standard v2」(責任あるAIの基準第2版)を公開した。さまざまな社会的な課題について、AIでどのように扱うのか、Microsoftの考えを示した。同時に社会的に悪影響を与えると考えられる同社のAIサービスの提供を中止した。

Microsoftは2022年6月21日(米国時間)、同社のAIシステムの構築方法を導くフレームワーク「Microsoft Responsible AI Standard v2」(責任あるAIの基準第2版)を公開した。より優れた、より信頼できるAIの開発を目指す同社の取り組みにおける重要なステップだとしている。

Microsoftは2019年秋に、Responsible AI Standardの初版を社内向けにリリースした。これまでの責任あるAIの取り組みに加え、最新の研究や、製品での経験から学んだ重要な教訓に基づく。

今回、多分野にまたがる研究者やエンジニア、政策専門家のグループが第2版を作成した。これまで学んできたことを共有し、他の人々からのフィードバックを求め、AIに関するより良い規範と実践の構築に向けた議論に貢献するため、第2版を公開したと述べている。

製品開発の指針

MicrosoftはResponsible AI Standardについて、さまざまな社会的な課題についてのMicrosoftの考えを示したものだと説明している。

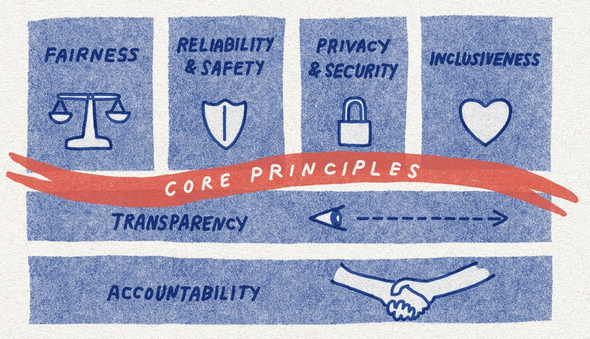

「『公平性』『信頼性と安全性』『プライバシーとセキュリティ』『包括性』『透明性』『アカウンタビリティー』(説明責任)といった永続的な価値を守り、社会からの信頼を得るには、AIシステムをどのように構築するのが最善か」という課題に向き合った「6つの基本価値」だ。

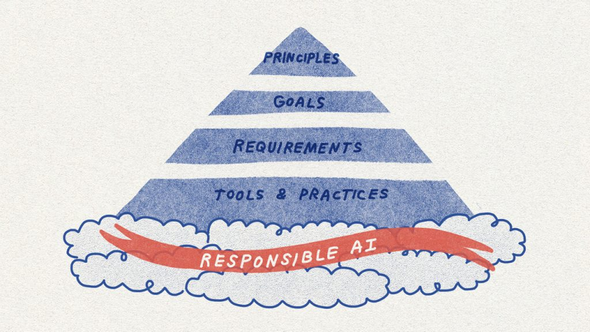

今回の基準はこれまで、AIを取り巻く状況の中で掲げられてきた抽象的な原則を超えて、具体的で実用的なガイダンスを社内チームに提供するものだとしている。

Responsible AI Standard v2の構成

Microsoftは6つの価値を、責任あるAIの基本原則と位置付けている。それぞれの価値は次のような意味を持つ。

・公平性

AIシステムは全ての人を公平に扱う必要がある

・信頼性と安全性

AIシステムは信頼でき、安全に動作する必要がある

・プライバシーとセキュリティ

AIシステムは安全でなければならず、プライバシーを尊重する必要がある

・包括性

AIシステムはあらゆる人に力を与え、人々を結び付ける必要がある

・透明性

AIシステムは理解しやすい必要がある

・アカウンタビリテイー

AIシステムにはアカウンタビリティーが必要だ

Responsible AI Standard v2では、この6つの基本原則が大目標として設定されている。アカウンタビリティー目標、透明性目標、公平性目標、信頼性と安全性目標、プライバシーとセキュリティ目標、包括性目標という6つの柱の下で、これらの大目標がそれぞれ複数の目標に分解され、これらの目標ごとに、一連の詳細な要件と、要件を満たすためのツールとプラクティスが記述されている。

例えば、アカウンタビリティー目標は、「影響評価」「重大な悪影響の監視」「開発目的への適合」「データガバナンスと管理」「人間による監視と管理」という目標に分解され、これらの目標ごとに詳細要件、ツールとプラクティスが挙げられている。

これらの要件は、AIシステムがシステムライフサイクルを通じて個々の目標を達成するために、チームが取るべき手順を示している。ツールとプラクティスは、これらの要件を実装するチームに、成功に役立つリソースを提示している。

カスタムニューラル音声と顔認識の適切な使用を管理

Microsoftの「Azure AI」のカスタムニューラル音声は、元の音源とほぼ同じ音になるよう合成音声を作成できる技術だ。Microsoftは、「責任ある AIプログラム」(Responsible AI Standardで要求されるレビュープロセスを含む)を通じてこの技術をレビューし、多層管理フレームワークを導入した。こうした管理体制により、この技術の有益な利用を維持しながら、なりすましや詐欺などへの悪用を防ぐことができた。

Microsoftはこの経験を踏まえ、顔認識サービスにも同様の管理を適用する方針を示した。既存顧客のための移行期間を経て、Microsoftの管理を受ける顧客とパートナーのみが、顔認識サービスにアクセスできるようにする。ユースケースを、事前に定義された許容可能なものに絞り込む他、技術的管理を顔認識サービスに組み込んで利用するという。

目的への適合とAzure Faceの機能

Microsoftは「AIシステムが信頼できるものであるためには、設計時に想定された問題に対する適切なソリューションでなければならない」との認識を示し、Microsoft Azureの「Face API」サービスがResponsible AI Standardの要件を満たすようにする一環として、感情の状態やアイデンティティー属性(性別、年齢、笑顔、顔の毛、髪形、化粧など)を推論する機能の提供を打ち切ることを明らかにした。

例えば、人の顔をスキャンして表情や動きから感情状態を推測する技術へ、無制限のAPIアクセスを提供しないことを決めた。また、顔解析などのAI技術を使用しているかどうかにかかわらず、人の感情状態を推測するとうたう全てのAIシステムを、慎重に分析する必要があると判断したと述べている。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

2019年中に顔認識技術を法律で規制すべきだ――Microsoftが見解を発表

2019年中に顔認識技術を法律で規制すべきだ――Microsoftが見解を発表

Microsoftは、顔認識技術に関する見解を発表した。顔認証技術が急速に高度化し、成功事例が積み重なるものの、同技術が持つ潜在的な危険性に対応する必要があるとした。政府に法整備を促す一方で、6つの行動規範を制定し、2019年の第1四半期までに社内に導入する。 責任あるAI(Responsible AI)とは?

責任あるAI(Responsible AI)とは?

用語「責任あるAI」について説明。倫理的な問題やプライバシー、セキュリティーなどの潜在的なリスクに企業や組織が責任を持って取り組み、作成したAIが安全で信頼できバイアスがないことを保証すること、またはそのための指針として掲げる基本原則やプラクティスのことを指す。 AIを利用した推薦システムを悪用し、意図的な偽情報が拡散可能 F-Secure

AIを利用した推薦システムを悪用し、意図的な偽情報が拡散可能 F-Secure

F-Secureは、AIを利用した推薦システムの危険性について警告を発した。「AIによる推薦」に関する実験の結果、意図的な偽情報や陰謀論の拡散が可能だった。