Microsoft、「ChatGPT」がセキュリティ担当者を支援する「Microsoft Security Copilot」を発表:脅威分析や関連資料の自動作成を支援

Microsoftは、「ChatGPT」を活用してセキュリティ担当者を支援する「Microsoft Security Copilot」を発表した。

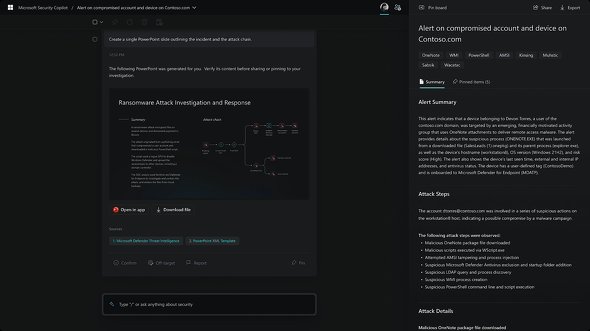

Microsoftは2023年3月28日(米国時間)、「Microsoft Security Copilot」(以後、Security Copilot)を発表した。OpenAIが開発、提供する「ChatGPT」のGPT-4モデルを活用したAI(人工知能)アシスタントとして、セキュリティ担当者の意思決定を支援する。

Microsoftは、相次ぐサイバー攻撃に対して、セキュリティ業界はそれに追い付くだけのサイバーリスク専門家を雇用できていないと指摘する。Security Copilotにより、脅威インテリジェンスを要約して理解しやすくすることで、複雑性を軽減し、セキュリティチームの能力を強化し、悪意のある活動の特定に役立つという。

Microsoft Security コーポレートバイスプレジデントのバス・ジャッカル(Vasu Jakkal)氏は次のように述べている。

「今日のサイバーセキュリティの専門家には常に大きな負担がかかっている。執拗(しつよう)で巧妙な攻撃者との不利な戦いを強いられることが多くなっているためだ。Security Copilotにより、Microsoftは戦いのパワーバランスをセキュリティ担当者に有利な方向へシフトさせる。Security Copilotは、セキュリティ担当者をAIのスピードと規模で支援する生成系AIセキュリティ製品だ」

攻撃者の次の行動を予測する、Security Copilotの特徴

Microsoftは、Security Copilotの特徴として以下を挙げている。

- 攻撃関連データをリアルタイムに相関分析して要約し、インシデントの優先順位を付ける。さまざまな脅威を迅速に修復するための最適な行動を推奨することで、見逃しがちな情報をセキュリティチームが発見できるよう支援する

- OpenAIが提供する最新AIモデルへの継続的アクセスを提供する。セキュリティチームに攻撃者、その戦術、手法、手順に関する最新の知識を提供できるよう、継続的な学習と改善を行い、骨の折れるセキュリティ作業を支援する

- 企業が持つセキュリティデータとMicrosoftの膨大な脅威分析リソースの両方で脅威を可視化する

Security Copilotは、知識のギャップを埋め、チーム全体を横断して、ワークフロー、脅威アクターのプロファイル、インシデントレポートを強化することで、サイバーセキュリティにおけるスキル不足の解消を支援する。Security Copilotにより、あらゆる規模のセキュリティチームが、はるかに大きな組織のスキルや能力を得られるとMicrosoftは説明している。

Microsoft Security エグゼクティブバイスプレジデントのチャーリー・ベル(Charlie Bell)氏は次のように述べている。

「セキュリティの進化には、人とテクノロジーの両面が必要だ。人間の創意工夫と、人間の専門知識を高速かつ大規模に適用するための最先端のツールの組み合わせだ。MicrosoftはSecurity Copilotで、全てのセキュリティ担当者が世界をより安全な場所にするために必要なツールやテクノロジーを利用できるようになる未来を築いている」

Microsoftによると、Security Copilotに共有するデータについて、AIモデルの訓練や強化に使用することはないという。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

新発表のMicrosoft 365 CopilotはChatGPTを付けただけじゃない、パワポ自動作成などの活用例をMicrosoftが紹介

新発表のMicrosoft 365 CopilotはChatGPTを付けただけじゃない、パワポ自動作成などの活用例をMicrosoftが紹介

Microsoftが、Microsoft 365にChatGPTのようなインタフェースを統合した「Microsoft 365 Copilot」を発表した。発表イベントでMicrosoftが説明した新製品のさまざまな使い方を紹介する。 思考の連鎖(Chain of Thought)でChatGPTからよりよい応答を引き出そう

思考の連鎖(Chain of Thought)でChatGPTからよりよい応答を引き出そう

ChatGPTやInstructGPTが間違った答えを出すときには、解決の手順となる「思考の連鎖」と呼ばれる情報をプロンプトに含めることで、よりよい解答を得られることがあります。これを実際に試してみましょう。 ハルシネーション(Hallucination)とは?

ハルシネーション(Hallucination)とは?

ハルシネーションとは、チャットAIなどが、もっともらしい誤情報(=事実とは異なる内容や、文脈と無関係な内容)を生成することを指す。AIから返答を受け取った人間が「本当かどうか」の判断に困るという問題がある。この問題を回避する方法として、独自の情報源を付与するRAGや、Webアクセスを含める機能などがある。