Google、「Gemma 3」の量子化認識トレーニング(QAT)モデルを公開:高品質を維持しながらメモリ要件を抑え、量子化のネックを緩和

Googleは、同社のオープンAIモデルファミリー「Gemma 3」の量子化認識トレーニング(QAT)モデルを発表した。

Googleは2025年4月18日(米国時間)、同社のオープンAI(人工知能)モデルファミリー「Gemma 3」の量子化認識トレーニング(QAT:Quantization-Aware Training)モデルを発表した。

2025年3月に発表されたGemma 3は、Googleの「Gemini 2.0」モデルと同じ研究および技術に基づいて構築された、軽量で高性能なオープンウェイトモデルファミリーだ。1B、4B、12B、27B(10億、40億、120億、270億)の4つのパラメーターサイズで提供されている。「NVIDIA H100」のようなハイエンドGPU上でネイティブのBFloat16(BF16)精度で動作する主要モデルとしての地位を確立している。

Gemma 3のQATモデルは、高品質を維持しながら、メモリ要件が大幅に抑えられている。QATにより、Gemma 3 27Bのような高性能モデルが、ローカル環境で「NVIDIA GeForce RTX 3090」のような消費者向けGPU上で実行可能になるという。

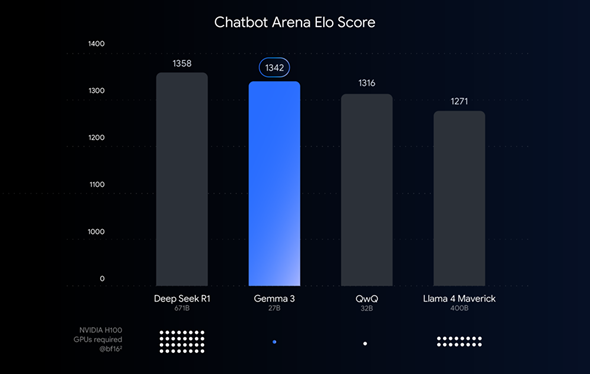

棒グラフは、Gemma 3のQATモデルと他のAIモデルを使用したチャットbotのパフォーマンススコア(Chatbot Arena Eloスコア)を示している。数値が大きいほどユーザーの評価が高い。棒グラフの下には各モデルのパラメーターサイズが記載されており、一番下のドット数は、各モデルをBF16データ型で実行するために必要なNVIDIA H100 GPUの推計数を示す(提供:Google)

QATモデルを投入した背景

上のパフォーマンス比較では、BF16を使用しているが、大規模なモデルをデプロイ(展開)する場合、ハードウェア要件(GPU数など)を大幅に削減するために、パフォーマンスを犠牲にして、FP8(8bit)などの低精度フォーマットを使用することも多い。Gemma 3についても、手持ちのハードウェアで活用したいとの要望が多い。

そこで量子化の出番となる。AIモデルでは量子化により、モデルが保存し、応答を計算するために使用する数値(モデルのパラメーター)の精度が低下する。これは、使用する色数を減らして画像を圧縮するのと似ている。16bit(BF16)でパラメーターを表現する代わりに、より少ない8bit(INT8)や4bit(INT4)などで表現することが可能だ。

ただし、量子化は、パフォーマンスの低下を招くことが多い。そこでGoogleは品質を維持するために、QATを利用している。QATでは、モデルを完全にトレーニングした後に量子化するのではなく、量子化プロセスをトレーニングに組み込んでいる。QATは、トレーニング中に低精度演算をシミュレートすることで、トレーニング後のパフォーマンス低下を抑えた量子化により、精度を維持しながら、より小さく高速なモデルを実現する。

VRAMの大幅な節約

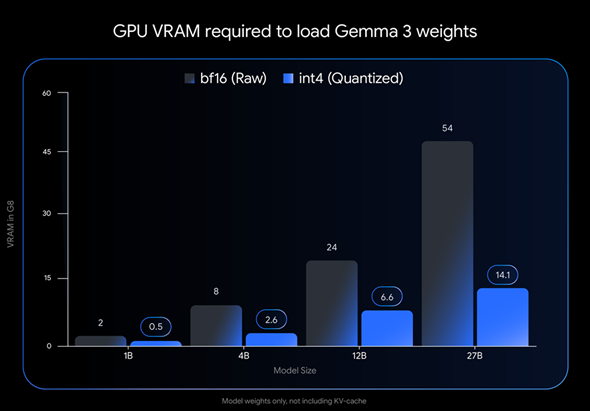

Googleは、INT4量子化により、モデルの読み込みに必要なVRAM(GPUメモリ)が、BF16を使用する場合と比べて以下のように減少するとしている。

- Gemma 3 27B:54GB(BF16)から14.1GB(INT4)に

- Gemma 3 12B:24GB(BF16)から6.6GB(INT4)に

- Gemma 3 4B:8GB(BF16)から2.6GB(INT4)に

- Gemma 3 1B:2GB(BF16)から0.5GB(INT4)に

Gemma 3モデルがさまざまなデバイスで実行可能に

Googleによると、QATにより、Gemma 3の強力なモデルが幅広い消費者向けハードウェアで実行できるようになった。

- Gemma 3 27B(INT4 QAT):NVIDIA GeForce RTX 3090(24GB VRAM)搭載デスクトップまたは同等のカードでGemma 3の最大モデルを快適に読み込み、ローカルで実行可能

- Gemma 3 12B (INT4 QAT):NVIDIA GeForce RTX 4060 Laptop GPU(8GB VRAM)などのノートPC GPUで効率的に実行でき、ポータブルマシンで強力なAI機能を利用できる

- 小型モデル(4B、1B):リソースが限られたシステム(スマートフォンなど)でも利用しやすくなった

人気ツールとの容易な統合

Googleは、開発者がこれらの新しいQATモデルを使い慣れたワークフローで利用できるようにした。Gemma 3のINT4 QATモデルとQ4_0(4bit)QATモデルは、Hugging FaceとKaggleで公開されている。以下のような人気の開発者ツールでシームレスに試せるようになっている。

- Ollama:シンプルなコマンドでGemma 3 QATモデルを実行できる

- LM Studio:直感的で使いやすいGUI(グラフィカルユーザーインタフェース)で、で、Gemma 3 QATモデルをデスクトップに簡単にダウンロードし、実行できる

- MLX:Appleシリコン搭載のMac上で、Gemma 3 QATモデルの最適化された効率的な推論を利用できる

- Gemma.cpp:Googleの専用C++実装。CPU上で直接、非常に効率的な推論を実行できる

- llama.cpp:GGUF形式のGemma 3 QATモデルをネイティブにサポートしており、既存のワークフローに簡単に統合できる

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

Google、ノートPCなどさまざまなデバイスで実行可能なオープンモデル「Gemma 3」を発表 何が特徴なのか

Google、ノートPCなどさまざまなデバイスで実行可能なオープンモデル「Gemma 3」を発表 何が特徴なのか

Googleは、同社の「Gemini 2.0」モデルと同じ研究および技術に基づいて構築された軽量なオープンモデルのコレクション「Gemma 3」を発表した。 Google、「最もインテリジェントなAIモデル」をうたう「Gemini 2.5」を発表 試験運用版モデルを提供開始

Google、「最もインテリジェントなAIモデル」をうたう「Gemini 2.5」を発表 試験運用版モデルを提供開始

Googleは、複雑な問題に取り組むためのリーズニングモデル「Gemini 2.5」を発表した。最初のリリースとなる「Gemini 2.5 Pro Experimental」は、一般的なさまざまなベンチマークで最先端の性能を示しており、特にリーズニング能力とコーディング能力に優れているという。 Google、「Gemini 1.5 Pro」「Gemini 1.5 Flash」の新機能とオープンモデル「Gemma 2」を提供開始

Google、「Gemini 1.5 Pro」「Gemini 1.5 Flash」の新機能とオープンモデル「Gemma 2」を提供開始

Googleは、大規模言語モデル「Gemini 1.5 Pro」とGeminiファミリーの軽量モデル「Gemini 1.5 Flash」それぞれの新機能と最新オープンモデル「Gemma 2」を提供開始したと発表した。