プライバシーフリーク、就活サイト「内定辞退予測」で揺れる“個人スコア社会”到来の法的問題に斬り込む!――プライバシーフリーク・カフェ(PFC)後編 #イベントレポート #完全版:混ぜるな危険(3/4 ページ)

求人企業は自分たちの問題とは思っていないのではないか――リクナビ事件の論点は、業務委託とコントローラーの視点へ。鈴木正朝、高木浩光、板倉陽一郎、山本一郎の咆哮を聞け! ※本稿は、2019年9月9日時点の情報です

AIの信頼性と限界

山本 最後に、人工知能の信頼性についてお話をしてもらいたいです。

高木 今回の事案で明らかになったもう一つの側面は、AIの信頼性と限界の話かと思います。

まず「正確性」。まっとうな例を一つ紹介すると、ソフトバンクが、自社の採用に際して、人力でエントリーシートを読み込んで足切りの作業をしていたのを、IBMの人工知能「Watson」を使って自動化したという話。

彼らは2、3年かけて繰り返し試して、人力でやるのと同じ結果が出るまで確認して調整していたそうです。しかも、ほとんど同じ結果が出るようになってもなお、落とされた人を人手でチェックしているとのことです。これはちょうど、GDPRの22条に規定されている、「人手を介さずに自動的に大事な決定をしてはいけない」というルールを守っていることになりますね。

逆に言えば、もともとWatsonでできるような作業しか人力でもやっていなかったという例かもしれません。このような人工知能を適切に使える用途はありますが、辞退可能性みたいなものになると、単純にはいかない。統計的には全体的に当たっているとしても、全員が当たっているとは限らないという問題も出てくると思います。

「公平性」という、別の観点も重要す。例えば「人を選別するのに性別や人種で判断してはいけない」というルールがある場合、性別と人種のデータを用いないようにしていても、データ分析で判断したところ、女性に特有の何らかの性質、例えば化粧品の購入履歴とかが中間変数となって、それを元に学習してしまい、結局、性別を用いるのと同じ判断をしてしまったとか。そういう事態を排除して行うデータ分析の手法が「公平配慮型データマイニング、機械学習」と呼ばれて、ここ2、3年で急速に研究が活発になっているようです。

そして、正確かつ公平なAIが実現できたとしても残るのが、「コンピュータ処理をするとどうしても寡占化する」が引き起こす問題です。

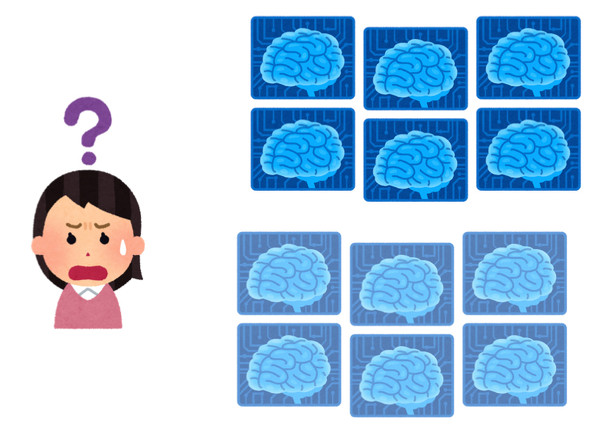

上の6個、下の6個、2つの大手事業者があって、それぞれの利用者が同じコピーの学習モデルを使うとします。これによって選別される人の立場になってみると、ほとんどの人は正しく判断してもらっているかもしれない、それは人力より公平で正確かもしれない。

けれど、たまたま外れになった人はどこに行っても落とされるという、逃げ場がないことになってしまう、という問題が避けられない。人力による選別は正確性に欠けても多様性をもたらしていた。それがなくなるということ、つまりは画一的なコンピュータの判断になってしまうという問題。

これはどうやって解決するのでしょうね。ノイズでも入れるんですかね、わざといいかげんに判断させるんですかね。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

プライバシーフリーク、就活サイト「内定辞退予測」で揺れる“個人スコア社会”到来の法的問題に斬り込む!――プライバシーフリーク・カフェ(PFC)前編

プライバシーフリーク、就活サイト「内定辞退予測」で揺れる“個人スコア社会”到来の法的問題に斬り込む!――プライバシーフリーク・カフェ(PFC)前編

プライバシーフリーク、就活サイト「内定辞退予測」で揺れる“個人スコア社会”到来の法的問題に斬り込む!――プライバシーフリーク・カフェ(PFC)中編

プライバシーフリーク、就活サイト「内定辞退予測」で揺れる“個人スコア社会”到来の法的問題に斬り込む!――プライバシーフリーク・カフェ(PFC)中編

リクナビだけじゃない――不正利用元年に理解すべき個人情報の概念と倫理

リクナビだけじゃない――不正利用元年に理解すべき個人情報の概念と倫理

就活サイト「リクナビ」が就活生の「内定辞退率」を企業に販売し、影響を受けた(と思われる)学生の就職活動の妨げとなった。問題の根源は何か、リクナビが反省すれば問題は解決するのか――HR業界の闇を明らかにするために、あのフリークたちが集結した!