Cloudflare、AI推論のデプロイプラットフォーム「Workers AI」の正式リリースなどを発表:AIモデルを「Hugging Face」からワンクリックでデプロイ可能に

Cloudflareは、AI推論を大規模にデプロイするためのプラットフォームである「Workers AI」の一般提供開始や、Hugging Faceとの提携拡大によって、ワンクリックでAIモデルを「Hugging Face」プラットフォームからグローバルにデプロイできるようになったことなどを発表した。

CDN(Content Delivery Network)やインターネットセキュリティサービスなどを手掛けるCloudflareは2024年4月2日(米国時間)、AI(人工知能)推論を大規模にデプロイするためのプラットフォームである「Workers AI」の一般提供開始や、Hugging Faceとの提携拡大によって、ワンクリックでAIモデルを「Hugging Face」プラットフォームからグローバルにデプロイできるようになったことなど、AIに関する一連の取り組みの成果を発表した。

発表内容の概要は以下の通り。

- Workers AIの一般提供開始

- AIモデルがワンクリックでHugging Faceからグローバルにデプロイ可能に

- 世界150以上の都市のデータセンターにGPUを展開

- 「BYO LoRA」でファインチューニングしたモデルがWorkers AIで実行可能に

- Pythonで「Cloudflare Workers」が記述可能に

- 「AI Gateway」が「Anthropic」「Microsoft Azure」「Amazon Bedrock」「Vertex AI」「Perplexity AI」をサポート

- ベクトルデータベースの「Vectorize」を2024年6月に正式リリース

Cloudflareは、これらの取り組みによってCloudflareの開発者向けプラットフォームは、より包括的なAI構築プラットフォームに進化していると述べている。

「最近の生成AIブームを背景に、企業はAIに膨大な時間と資金を投資している。だが、AIに関しては、簡単にデモを行うことができる一方で、本番環境への投入が極めて難しいという課題がある。Cloudflareは、AIアプリケーション構築のコストと複雑さを軽減することで、この課題の解決を目指す。『Workers AI』は、AIによる推論を実行するための最も手ごろで利用しやすいソリューションの一つだ。さらに、Hugging FaceとCloudflareは、シンプルな方法と手ごろなコストでAIを提供可能にするために緊密に連携している。AIモデルを選択し、AIアプリケーションを一からグローバルに瞬時にスケールできる自由とスピードを、開発者に提供していく」(Cloudflareの共同創設者兼最高経営責任者《CEO》、マシュー・プリンス氏)

Workers AIの一般提供開始

Workers AIは、Cloudflareのグローバルネットワーク上で動作するサーバレスGPU駆動の推論プラットフォームだ。サーバレス機能をエンドユーザーのできるだけ近くで実行できるようにするプラットフォームである「Cloudflare Workers」とシームレスに連携する。既製AIモデルのカタログを提供しており、開発者はこれらのモデルを利用して、強力でスケーラブルなAIアプリケーションを数分で構築できる。

CloudflareはWorkers AIの一般提供開始と併せて、以下の発表も行った。

パフォーマンスと信頼性の向上

Workers AIを支えるロードバランシング機能をアップグレードし、リクエストをより多くの都市のより多くのGPUにルーティングできるようにした。

人気AIモデルのコスト引き下げ

CloudflareはWorkers AIを、AI推論を実行するための最も手ごろでアクセスしやすいソリューションの一つにすることを目指しており、コスト低減を目的に、Workers AIで提供するモデルに幾つかの最適化を施した。これにより、2024年3月初頭に比べて、例えば「Llama 2」は7分の1以下、「Mistral 7B」は14分の1のコストで実行できるようになった。

なお、Workers AIは2024年4月1日から課金が開始されたが、βモデルは引き続き無料で無制限に利用できる。

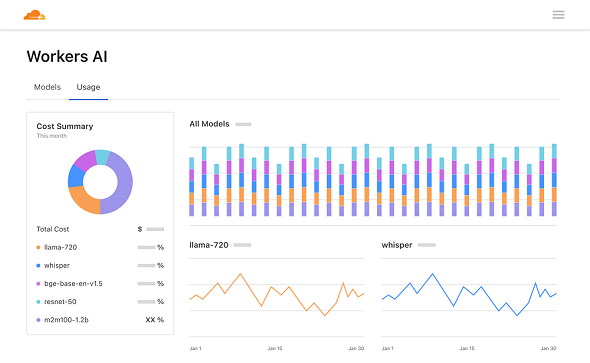

新しいダッシュボードとプレイグラウンド

CloudflareダッシュボードのWorkers AIページでは、モデル全体の使用状況の分析が表示されるようになり、利用料金をより的確に予測できるようになった。AIプレイグラウンドでは、さまざまなモデルを素早くテストして比較し、プロンプトやパラメーターを設定できるようになった。

AIモデルがワンクリックでHugging Faceからグローバルにデプロイ可能に

Hugging Faceは、AI開発者向けのオープンなコラボレーションプラットフォームであるHugging Faceを運営している。CloudflareとHugging Faceは提携を拡大し、Workers AIの一般提供開始に伴い、開発者がAIモデルをHugging Faceから、ワンクリックで直接デプロイできるようにした。これにより、CloudflareのGPUのグローバルネットワーク上のさまざまなAIモデルにアクセスし、推論リクエストを最速の方法で実行できるようにしたとしている。

開発者は人気のオープンソースモデルを選び、「Deploy to Cloudflare Workers AI」(Cloudflare Workers AIにデプロイ)をクリックするだけで、すぐにAIモデルをデプロイできるという。現在、Workers AIプラットフォーム向けに最適化したHugging Faceモデルが14あり、テキスト生成、埋め込み、類似文章検索の3つのタスクカテゴリーに対応している。

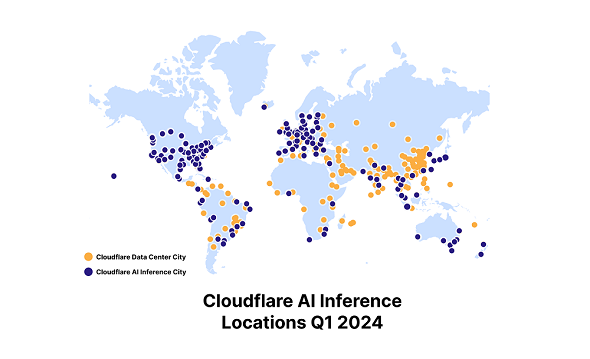

世界150以上の都市のデータセンターにGPUを展開

Cloudflareは現在、世界150以上の都市のデータセンターにGPUをデプロイしており、直近ではアフリカ初の拠点としてケープタウン、ダーバン、ヨハネスブルグ、ラゴスで展開を開始した他、アンマン、ブエノスアイレス、メキシコシティ、ムンバイ、ニューデリー、ソウルなど、世界中で低レイテンシのAI推論を提供している。またWorkers AIは、AIモデルの重みをファインチューニングできるように対応を拡大しており、企業や組織が、より専門的で特定分野向けのアプリケーションを構築、デプロイできるように支援している。

さらにCloudflareは、GPUを搭載し、従来よりも性能、電力効率、信頼性が高い次世代コンピュートサーバを、2024年第2四半期に導入する計画だ。次のステップは、より大規模な機械学習(ML)モデルをサポートし、Cloudflareプラットフォーム上でファインチューニングを提供することだとしている。

BYO LoRAでファインチューニングしたモデルがWorkers AIで実行可能に

LoRA(Low-Rank Adaptation、ローラ)手法を使うことで、モデルを完全にファインチューニングする場合のように全てのモデルパラメーターを書き換えることなく、一部のモデルパラメーターを目的のタスクに適応させる方法が、研究者によって発見されている。これは、モデルを完全にファインチューニングするための計算コストをかけずに、ファインチューニングされたモデル出力を得られることを意味する。

Cloudflareは、事前にトレーニングしたLoRAがWorkers AIで使用できるようになったと発表した。実行時にこのLoRAアダプターをベースモデルに適用することで、完全にファインチューニングされたモデルの数分の1のコスト、サイズ、スピードで、ファインチューニングされたモデルから推論が得られるようになったと説明している。

Cloudflareが「Bring Your Own(BYO)LoRA」と呼ぶこの機能は、オープンβ段階にある。将来的に自社プラットフォームで直接、ファインチューニングジョブと完全にファインチューニングされたモデルをサポートすることを目指すという。

PythonでCloudflare Workersが記述可能に

サーバレス機能をエンドユーザーのできるだけ近くで実行できるようにするためのプラットフォームであるCloudflare Workersのコードはこれまで、Service Workers APIに対してJavaScriptで記述され、Googleの「Chrome V8」エンジンで実行されてきた。Service Workersは、ユーザー向けにカスタマイズされた体験を作成するために、ブラウザがダウンロードして実行するスクリプトを指す。JavaScriptで記述されている。

2024年4月2日から、AIアプリケーション構築に広く使われているPythonでCloudflare Workersコードを作成できるようになった。この機能はオープンβ段階にあり、Python WorkersはCloudflare上のリソース(Vectorize、D1、KV、R2など)への全てのバインディングをサポートする。

AI GatewayがAnthropic、Microsoft Azure、Amazon Bedrock、Vertex AI、Perplexity AIをサポート

CloudflareのAI Gatewayは、AIアプリケーションのコントロールプレーンを提供し、分析、キャッシング、レート制限などの機能により、AIアプリケーションの制御と観測を支援する。開発者はリクエストを動的に評価し、各種モデルとプロバイダーにルーティングできる。

AI Gatewayは、2023年12月からAzureとAmazon Bedrockをサポートしており、新たにAnthropic、Vertex AI、Perplexity AIがサポート対象に加わった。これにより、Workers AIとともに、人気のあるプロバイダーがAI Gatewayでサポートされるようになった。

さらに、Cloudflareは2024年第2四半期に、以下の機能を導入する計画だ。

- 永続ログ:プロンプトとレスポンスを含むログをオブジェクトストレージにプッシュできる

- カスタムメタデータ:リクエストにユーザーIDなどの識別子でタグ付けできる

- シークレット管理:アプリケーションのAPIキーを安全に管理できる

Cloudflareは永続ログ機能により、開発者がワンクリックでログデータを用いてモデルをファインチューニングできるようにし、最終的にはWorkers AIプラットフォームで、ファインチューニングジョブとファインチューニングされたモデルを直接実行できるようにすることを目指している。

ベクトルデータベースのVectorizeを2024年6月に正式リリース

Vectorizeは、Cloudflareのグローバルネットワーク上でフルスタックのAIアプリケーションを構築できるように設計された、Cloudflareの新しいベクトルデータベースだ。2023年9月からオープンβ版として提供されており、Cloudflare Workersを使用する開発者は誰でも利用できる。

Vectorize with Workers AIを使用すれば、Cloudflare Workersを使用したセマンティック検索、分類、推奨、異常検出のユースケースの直接強化、LLM(大規模言語モデル)からの回答の精度やコンテキストの向上、OpenAIやCohereなどの一般的なプラットフォームからの独自の埋め込みを取り込むことが可能だ。

Cloudflareは、2024年6月にVectorizeの一般提供を開始し、数百万のベクトルインデックスをサポートする計画を明らかにした。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

非同期マルチスレッドフレームワーク「Pingora」をオープンソース化 Cloudflare

非同期マルチスレッドフレームワーク「Pingora」をオープンソース化 Cloudflare

Cloudflareは、RustフレームワークPingoraのオープンソース化を発表した。Pingoraは、Cloudflareが開発したHTTPプロキシサービスの構築を支援するRustの非同期マルチスレッドフレームワークだ。 Cloudflare、エッジ環境で分散データベースを構築可能な「D1」のオープンβ版を公開

Cloudflare、エッジ環境で分散データベースを構築可能な「D1」のオープンβ版を公開

Cloudflareは、ネイティブサーバレスデータベース「D1」のオープンβ版を公開した。 Metaは生成AIの研究開発を支えるAIインフラ環境をどのように構築しているのか

Metaは生成AIの研究開発を支えるAIインフラ環境をどのように構築しているのか

AGIの構築をビジョンとして掲げるMetaは、生成AIインフラをどう構築しているのか。公式エンジニアリングブログで最新の取り組みを紹介した。