Metaは生成AIの研究開発を支えるAIインフラ環境をどのように構築しているのか:2万4576個のGPUを搭載したクラスタを構築

AGIの構築をビジョンとして掲げるMetaは、生成AIインフラをどう構築しているのか。公式エンジニアリングブログで最新の取り組みを紹介した。

AGI(汎用〈はんよう〉人工知能)の構築をビジョンとし、大規模言語モデル(LLM)の「Llama 2」などAI/ML(機械学習)の分野で成果を生み出しているMetaは、生成AIインフラをどう構築しているのか。

Metaは2024年3月12日(米国時間)、生成AIインフラをどのように構築しているのか、取り組みの詳細を公式エンジニアリングブログで紹介した。

2万4576個のGPUを搭載したAIクラスタを構築

Metaは2022年に、1万6000個のNVIDIA A100 GPUを搭載したAIスーパーコンピュータとして「AI Research SuperCluster(RSC)」を構築し、その詳細を明かしている。RSCは、LlamaおよびLalama 2の開発だけでなく、コンピュータビジョン、NLP(自然言語処理)、音声認識、画像生成、コーディングに至るまでさまざまなMetaのAI開発において重要な役割を果たしてきた。

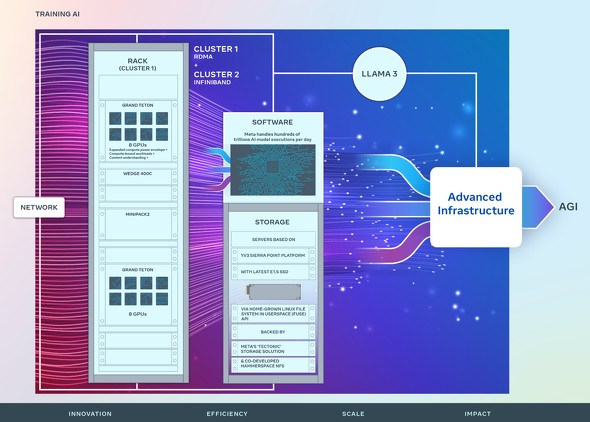

MetaはRSCで培った成功と教訓に基づいて新たな2つのAIクラスタを設計、構築した。2万4576個のNVIDIA Tensor Core H100 GPU(NVIDIA H100)を搭載したAIクラスタだ。研究者や開発者の経験と生産性に重点を置き、エンドツーエンドのAIシステムとして構築されている。

「クラスタ内の高性能ネットワークファブリックの効率性、主要なストレージおよび各クラスタに搭載されたGPUの組み合わせは、RSCよりも複雑なモデルをサポートでき、生成AI製品開発とAI研究がより進歩するだろう」とMetaは述べている。

Metaは、新しいAIクラスタで使われている技術を次のように解説している。

新しいAIクラスタで使われている技術

ネットワーク

Metaでは、1日当たり数百兆回のAIモデル実行を処理している。こうした大規模なサービスを提供するには、高度で柔軟なインフラが必要だ。

2つのAIクラスタのうち1つは、Arista 7800をベースに「RDMA over Converged Ethernet」(RoCE:Remote Direct Memory Access over Converged Ethernet)ネットワークファブリックを構成しており、もう1つは、NVIDIA Quantum2によるInfiniBandファブリックを特徴としている。いずれも400Gbpsでエンドポイントを相互接続できる。

これにより、異なるネットワークにおける相互接続のスケーラビリティを評価でき、より多くの洞察を得られた。また、ネットワーク、ソフトウェア、モデルアーキテクチャを入念に連携した設計により、RoCEクラスタとInfiniBandクラスタの両方を、大規模な生成AIワークロードに、ネットワークのボトルネックなしに使用することに成功した。

オープンコンピュート

どちらのクラスタも、Open Compute Project(OCP)に貢献した自社設計のオープンGPUハードウェアプラットフォーム「Grand Teton」を使用して構築されている。

Grand Tetonは、電源、制御、コンピュート、ファブリックインタフェースを1つのシャーシに統合し、全体的なパフォーマンス、シグナルインテグリティ、熱性能を向上させる複数世代のAIシステムから得た知見に基づいて構築されている。シンプルな設計で迅速な拡張性と柔軟性を提供するため、データセンターフリートへの迅速な導入が可能で、保守や拡張も容易だ。

MetaのOpen Rackやラックアーキテクチャのような他のイノベーションと組み合わせることで、現在および将来のアプリケーションに特化した方法で新しいクラスタを構築できる。

ストレージ

ストレージはAIトレーニングにおいて重要な役割を果たすが、あまり話題にならない側面の一つだ。しかし、大量のデータを消費するようになると、データストレージの必要性が急速に高まる。

Metaのストレージは、自作のLinux Filesystem in Userspace(FUSE)APIを介して、AIクラスタのデータとチェックポイントのニーズに対応している。ストレージはフラッシュメディア用に最適化されたMetaの分散ストレージソリューション「Tectonic」に支えられている。Tectonicにより、何千ものGPUがチェックポイントを同期して保存、ロードすることが可能になり、同時にデータロードに必要な柔軟で高スループットのエクサバイト規模のストレージを提供できる。

Metaは、スタートアップのHammerspaceと提携して並列ネットワークファイルシステム(NFS)を共同開発した。Hammerspaceは、コードの変更が環境内の全てのノードに即座にアクセスできるため、エンジニアが何千ものGPUを使用してインタラクティブにジョブをデバッグできる。TectonicとHammerspaceを組み合わせることで、スケールに妥協することなく、高速な反復速度を実現している。

MetaのAIインフラの未来

これら2つのAIクラスタは、MetaのAI戦略に向けたロードマップの一部だ。Metaは2024年末までに、35万個のNVIDIA H100を含むAIインフラの構築を目指している。これは約60万個のNVIDIA H100に匹敵する計算能力を特徴とするAIインフラになる予定だ。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

Meta、生成AIモデルを使った責任ある開発を支援する「Purple Llama」プロジェクトを発表

Meta、生成AIモデルを使った責任ある開発を支援する「Purple Llama」プロジェクトを発表

Metaは、オープンな生成AIモデルを使った責任ある開発を支援する包括的プロジェクト「Purple Llama」を立ち上げた。 Meta、テキストからの動画生成モデル「Emu Video」とマルチタスク画像編集モデル「Emu Edit」を発表

Meta、テキストからの動画生成モデル「Emu Video」とマルチタスク画像編集モデル「Emu Edit」を発表

Metaは、最近発表した画像生成のための基盤モデル「Emu」に基づく2つの研究成果を発表した。拡散モデルに基づいてテキストから動画を生成するモデル「Emu Video」と、マルチタスク画像編集モデル「Emu Edit」だ。 頭で考えたことがそのまま画像に? Metaが脳活動から画像をリアルタイム解読するAIシステムの開発進捗を公開

頭で考えたことがそのまま画像に? Metaが脳活動から画像をリアルタイム解読するAIシステムの開発進捗を公開

Metaは脳の活動を基に脳が認識している画像をリアルタイムで再構成するAIシステムの開発進捗を同社の公式ブログで紹介した。システムは、非侵襲的神経画像技術である脳磁図法(MEG)を使用して、脳内の視覚表現の展開を解読できるという。