AIチャットを全社活用している竹中工務店は生成AIの「ブレーキにはならない」インシデント対策を何からどう進めたのか:AIリスク対策は「2階建て」?

業務の効率化や自動化を目的に生成AIの活用の模索が進んでいる。一方で、企業で生成AIを活用する場合はそのリスクとも向き合う必要がある。竹中工務店の鈴木真徳氏が、現在の生成AIリスクをコントロールしながらAI活用を推進する同社の取り組みを紹介した。

生成AI(人工知能)に対する期待は高まるばかりだ。多くの企業で業務の効率化や自動化を目指して取り組みが始まっている。だが、海外を中心にAIにまつわるインシデントも発生しているのが実情だ。

奈良先端科学技術大学院大学 サイバーレジリエンス構成学研究室教授の門林雄基氏がチェアを務めたInterop Tokyo Conference 2024の「AIインシデントへの具体策〜ヒヤリハットと大事故を踏まえた対策〜」では、そんなAIインシデントの事例を踏まえた上で、どのようにAIリスクをコントロールしながらAI活用を推進していくかのヒントが、竹中工務店での取り組みを例に紹介された。

インフラなどの1階とAIモデルなどの2階、両にらみでAIリスクへの対応を

今や「実証実験を開始しました」といったニュースだけでは目新しさを感じないほど、連日のようにAIが話題になっている。だが一方で「日本では報道されていない大事故も含め、ヒヤリハットも多いのも事実です」と門林氏は指摘した。

AIがはらむリスクが顕在化しつつあることを受け、EU(欧州連合)のAI規制やG7(先進7カ国)のAI原則をはじめ、さまざまな法規制、ガイドラインの整備も進んでいる。これらに共通する方針が「リスクベースのアプローチを採用すべき」ということだ。

門林氏はこのように概況を説明した上で、具体的にどのような「リスク」――AIにまつわる事故が発生しているかを紹介した。

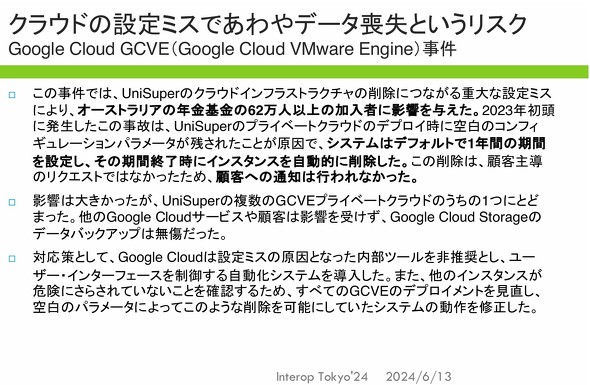

まず注意が必要なのは、AIのリスクは「2階建て」であることだ。たいていの場合、AI活用はクラウド環境を前提としている。だがそのクラウドでは、インフラそのものやデータ、利用する際のアイデンティティーという3つの領域全てにおいて、ヒヤリハットや重大事故が起きている。「インフラなどAIを使う以前のリスクと、AIモデルのようなAIならではのリスクの2階建てになっており、両方について対応する必要があります」(門林氏)

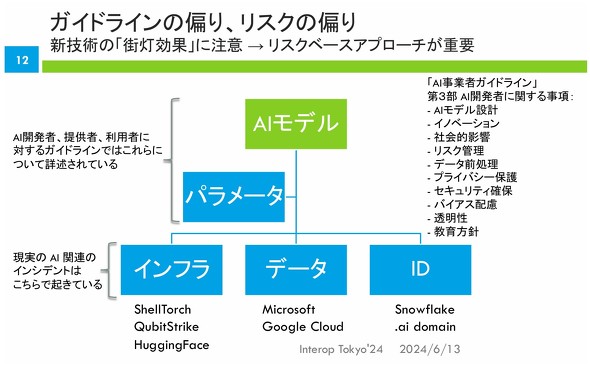

1階側のリスクの一例がデータ喪失だ。2024年4月にはGoogle Cloudの設定ミスで、オーストラリア年金基金の50万人以上のデータが誤削除されるというインシデントが発生した(Google Cloud GCVE incident)。バックアップによって最悪の事態は避けられたが、「クラウドはAIの基盤になっています。AIでビジネスを行う上で、そのテナントのデータが飛ばされることが現実のリスクになっています」と門林氏は指摘した。

また、MicrosoftのAI研究者が不適切なアクセス権限の設定された認証トークン(SASトークン)を誤って公開してしまい、社内の機密データへのアクセスを許してしまったというインシデントも報告されている。「AI研究者がアルゴリズムのことしか気にせず、認証トークンを公開リポジトリに共有してしまった事例で、38TB分の個人情報が流出しました。海外では大きく報道されました」(門林氏)

さらに、AI開発に特化したプラットフォーム「Hugging Face」上で、バックドアなどが組み込まれた悪意あるモデルが公開されているという調査結果も報告されている。仮にこうした悪意あるモデルを使ってしまうと、データサイエンティストのPCが攻撃者の踏み台と化す恐れがある。「Jupyter Notebook」でも同様にマルウェア入りのNotebookの存在が報告されているという。

「データサイエンティストが狙われる理由は、彼らが研究所でバイオサイエンスや素材、医療など、特定の国が欲しがる機密情報を扱っているためです。そうしたデータを詐取するには、クラウドやAI開発支援ツールを狙うのが手っ取り早い手段です」(門林氏)。最新のツールや新たな環境を使いたがる研究者の性質もあって、機微情報の獲得手段として狙われ始めているという。

加えて、Snowflakeでの情報流出のようにクラウド基盤自体が不正アクセスを受けるケースもあれば、スタートアップ系AIサービスが利用する「.ai」ドメインが侵害され、フィッシングサイトに誘導されてしまうといったリスクもある。

門林氏はこうしたさまざまなインシデントを紹介した上で、「リスクベース、つまり実際に起こっている事故ベースで分析すると、AIモデルやパラメーターといった2階部分よりも、インフラなど1階部分で実際のインシデントが起きています」とまとめた。

そして、人間には暗いところで落とし物をしたときに、つい街灯の下の明るいところばかり探してしまいがちな性質があるが、明かりの当たらない部分にも注意を払う必要があるとした。「AIという新技術が登場すると、スポットライトが当たっているところだけで問題を探す傾向にあります。しかし実は、スポットライトが当たらず、われわれが意識すらしないインフラやデータ、アイデンティティーといった部分にも巨大なリスクが横たわっています」と門林氏は述べ、1階と2階の両方をにらんで対策すべきと呼び掛けた。

自分なりにリスクを整理し、モデル化した上で対策を適用している竹中工務店

続けて竹中工務店のデジタル室主任、鈴木真徳氏が、同社におけるAI活用とリスク対策のアプローチを紹介した。

日本でも最大手のゼネコンとして、あべのハルカスや東京ミッドタウン八重洲などのプロジェクトに携わっている竹中工務店だが、建築業全体が直面する「労働生産性の低さ」「技能労働者の減少」といった課題と無縁ではいられないのが実情だ。「こうした状況の中、お客さまに満足していただき、ビジネスが成長するためには、デジタル活用による生産性向上が必要だと考えています」(鈴木氏)

こうした考え方に基づき同社は、「建設デジタルプラットフォーム」を構築し、建設に関する一連のプロセスのデジタル化に取り組んできた。BIM(Building Information Model)データの共有やAIによる設計サポート、IoT(Internet of Things)も組み合わせた異常検知、予測、そして施工管理の自動化などを通して生産性を向上させる「Building 4.0」を推進している。

この取り組みの中で大きな役割を果たしているのがAIだ。

具体的には、過去の設計関連データを基に設計業務の時間を大幅削減し、お客様への迅速な提案を支援する「構造設計AI」、工事に必要なマンパワーを高い精度で予測し、プロジェクトのスムーズな受注につなげる「人員予測AI」の他、社内標準やルール、組織の経験値を学習させ、若手社員の教育やノウハウ継承に活用する「知見継承AI」などの開発、試行を進めている。

例えば、「夏場にコンクリートを打設する際の留意点」を、参考ドキュメントとともに具体的に示すといった形で活用でき、業務の効率化、デジタル化を加速させている。

ただ、AIにはさまざまなリスクが伴う。そこで竹中工務店では、「TAKENAKA-SIRT」を中心とした一連のセキュリティ対策の取り組みの中で、AIリスクにも向き合っている。

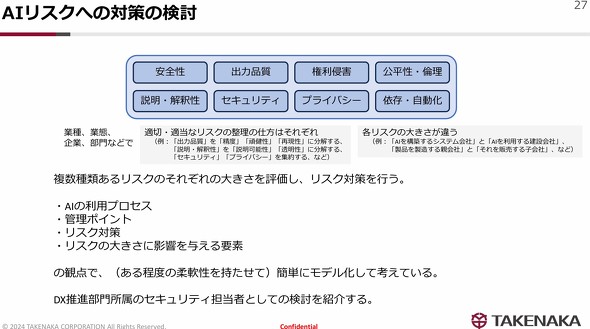

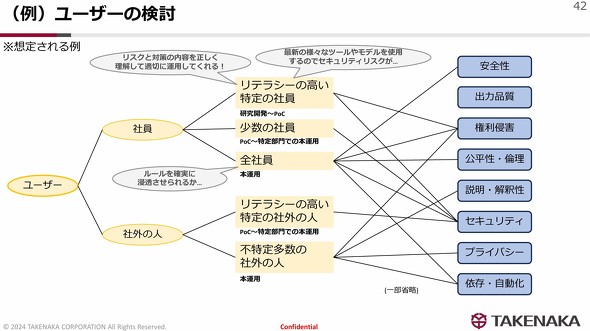

そもそもAIの性質上、AIリスクは多様で、必ずしもセキュリティリスクだけとは限らない。鈴木氏は、さまざまなAI規制、ガイドラインを読み込み、また門林教授が紹介したようなAIインシデント事例を収集した上で、AIリスクを「安全性」「出力品質」「権利侵害」「公平性」「倫理」「説明解釈性」「セキュリティ、プライバシー」「依存自動化」の8つに自分なりに分解していると述べた。

ただ、この分類が唯一の解ではない。企業や業界、あるいは立場によって、もっと細かく整理、逆にひとまとめに考えられる項目もある。「業界や立場次第で主なリスクが異なる点が、AIリスクの捉えにくいポイントなのかと思います」と鈴木氏はコメントした。

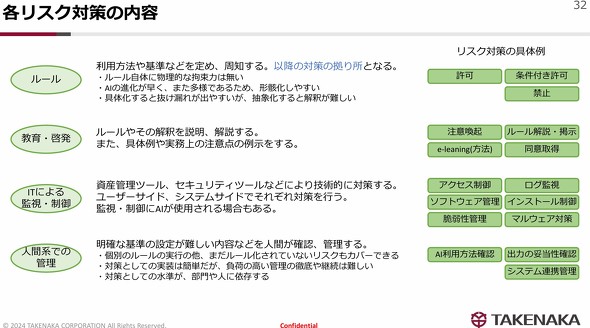

さらに鈴木氏は、これら複数のリスクを「AIの利用プロセス」「管理ポイント」「リスク対策」「リスクの大きさ」という4つの要素を用いてモデル化、整理した上で、「ルール」「教育/啓発」「ITによる監視制御」「人間系での管理」という対策を適宜適用していくアプローチで対策を進めている。

このうちルールは、多くの企業がすでに策定に取り組んでいるだろう。ただ「ルール自体に物理的な拘束力はなく、またAIの進化が早く多様であるため、形骸化しやすい状況もあると思います」と鈴木氏は述べた。加えて、具体化すればするほど抜け漏れが生まれやすく、逆に抽象的にすれば解釈が難しくなるという具合で、適切なルール策定には難しさがつきまとうという。

また最後の人間系による管理は、ルールや教育/啓発、ITによる対策では拾いきれなかったリスクに人間が対応するというものだ。ルール化されていないリスクもカバーできるといった利点はあるが、「負荷が高く、継続が難しいことに加え、対策の水準が人に依存してしまうのも事実です」(鈴木氏)という。

このように整理した上で、AI利用に当たって自組織に影響を与える「影響要素」をリストアップし、「リスクの大きさ」を加味しながら、各管理ポイントに対して対策を取っていく、というのが、同氏が進めているアプローチだ。

ただ、全てを網羅して厳密にやろうとすると、負荷も非常に大きくなる。「効率よくリスクを減らせる、扱いやすい切り口をうまく見つけられるかが重要になってくると思います」と鈴木氏は自らの経験を踏まえてアドバイスした。

この過程で組織ごとの特徴が反映される要素が、リスクの大きさだ。これは「利用方法」「ユーザー」「入力/学習データ」「AI環境」という4つの要素によって定義できると鈴木氏は説明した。

「ユーザー」について掘り下げてみると、社員と社外の人に大別できる上に、社員もさらに研究開発部門などに所属するリテラシーの高い社員から、PoC(概念実証)で利用する特定の社員、一般社員までさまざまに分けられる。

「リテラシーの高い社員ならば、きちんとリスクを説明すれば理解し、適切に対応してくれます。一方で研究開発部門の人たちは、さまざまなところから最新のツールやモデルをダウンロードして試す人たちでもあるので、リスクが高いとも言えます」と鈴木氏は述べ、このようにイメージしながら具体的な対策を検討することを推奨した。門林氏も「コンピテンシー」に応じたアプローチが重要であるとコメントしている。

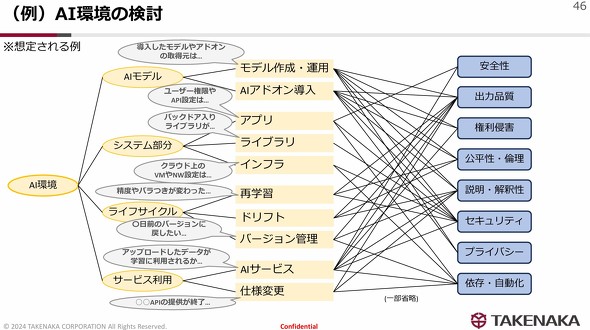

そしてAI環境についても、まさに門林氏が指摘した「1階建て」と「2階建て」の通り、システム部分とAIモデルとに分けた上で、どのような形態で、どのようなライフサイクルで運用していくかをイメージすると整理しやすくなるとした。その際には、NIST(米国国立標準技術研究所)のガイドラインやMITREのフレームワーク、あるいはDevSecOpsに関するベストプラクティスなども参考になるという。

ケース・バイ・ケースで適切な対策を実施、「AIリスク台帳」の作成も視野に

こうした原則的な考え方に基づき、竹中工務店では幾つかのケースでAIリスク対策に取り組み始めているという。

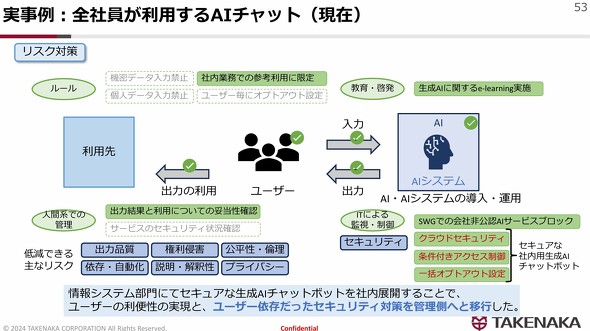

1つ目のケースは、全社員を対象にした「AIチャット」だ。同社は業務の生産性向上や品質確保という目的で、自社でセキュアなAIチャットを用意できるまでの間、OpenAIの「ChatGPT」を全社員に使わせることにした。その際には「機密情報の漏えい」に加え、ハルシネーションをはじめとする「出力変質」、そして「権利侵害」といったリスクが考えられる。

そこで、まず「機密データ/個人データの入力は禁止し、利用は社内業務に限定し、オプトアウト設定を入れる。出力結果は人間系の管理で妥当性を確認する」というルールを設け、これとセットで生成AIに関するeラーニングを実施した。加えて、それ以外の類似サービスは利用しないよう、セキュアWebゲートウェイでブロックするというITによる制御も行っているという。

デジタル室では、2023年9月に、クラウドセキュリティの導入や認証/認可、一括オプトアウト設定を管理側で講じた、セキュアな生成AIチャットに移行した。より厳密なコントロールを実施したことで「機密情報は入力しないといったルールを一部緩和し、ユーザーの利便性とセキュリティの向上を実現できています」と鈴木氏は述べた。

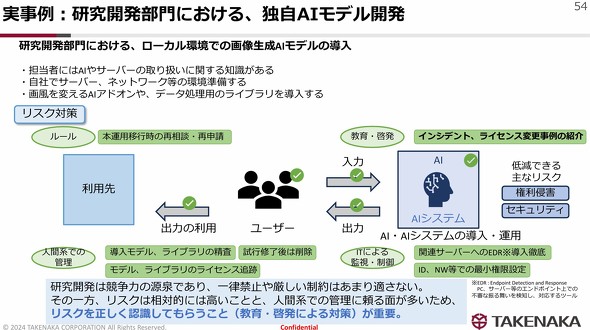

2つ目は、研究開発部門における生成AIモデル開発だ。AIやITに関する一定水準以上の知識を持ったユーザーが対象であり、しかも競争力の源泉でもある研究開発が目的となる。「全社員に強いる『一律禁止』的なルールは向かないため、ルールは最小限にとどめ、代わりに人間系での管理をしっかりやってもらうことにしました」(鈴木氏)。利用に当たってはモデルやライブラリのレピュテーションを精査し、加えてEDR(Endpoint Detection and Response)導入などIT面での対策を組み合わせることでリスクを制御している。

一方で、研究開発部門としては、なるべく自由度高くAIを活用したいという思いもあり、「リスク対策が開発や革新のブレーキになるのではないか」と警戒されることもある。鈴木氏は、対策に納得感を持ってもらうために、自社と共通する要素のあるものを中心にAIインシデント事例を収集し、説得材料として伝えることで理解を求めていったと説明した。

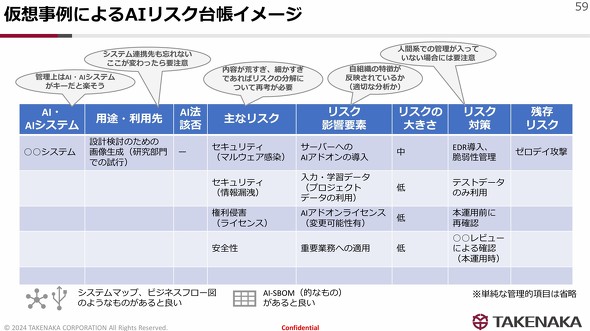

おそらくこの先もAI活用は広がり、さらに多様なAIリスクも生じてくるだろう。竹中工務店ではそうした状況を見据え、IT資産管理台帳のように、AIの用途や利用先、影響を受ける法令や主なリスク、対策などを一覧化した「AIリスク台帳」の作成を始めている。台帳として一元管理することで、対処が難しい「残存リスク」の把握も容易になる。ただこれも、完璧を期すものという位置付けではない。

「AIに関する状況の変化は速いため、ある程度洗い粒度でさまざまなステークホルダーと認識を共有できればいいのかなと思っています」(鈴木氏)

今後も、ロボットやIoTデバイスとの連携などをはじめ、AIの適用範囲や、AIリスクは変化し続けていくだろう。鈴木氏はこうした台帳なども活用しながら、「何らかの変更が加わったタイミングで記録を残し、リスクを洗い直すといった運用ができればと考えています」と言う。

門林氏は「サイロ化した組織だと取り組みはうまくいきません。ITを適切に用いて横串になるツールを作り、コラボレーションしていくことも重要でしょう」と講演を締めくくった。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

「置換」ではなく「要約」 住友ゴムが実践したレガシーコードマイグレーションの新しいカタチ

「置換」ではなく「要約」 住友ゴムが実践したレガシーコードマイグレーションの新しいカタチ

Google Cloudが2024年3月7日に開催した「Generative AI Summit Tokyo '24」で、住友ゴム工業の角田昌也氏は、デジタル設計の工程に不可欠な「コンピュータシミュレーション」に関連したプログラムの生成やマイグレーションにおける生成AIの活用事例を紹介した。 生成AIの実践的導入に役立つ「7つの基準」「6つの展開パターン」を解説 PwC

生成AIの実践的導入に役立つ「7つの基準」「6つの展開パターン」を解説 PwC

PwCは、企業が生成AIによって生産性を向上させる方法について知見を発表した。「フライホイール」方式を生かすことで、生成AIアプリケーションの規模を素早く効果的に拡張できるとしている。 AIにより2027年までにITエンジニアの80%がスキルアップを強いられる、具体的な3つの影響とは? Gartner予測

AIにより2027年までにITエンジニアの80%がスキルアップを強いられる、具体的な3つの影響とは? Gartner予測

Gartnerが発表した予測によると、2027年までに生成AIによってソフトウェアエンジニアリングやオペレーションに新しい役割が生まれ、エンジニアリング部門の従業員の80%がスキルアップを強いられるという。