第219回 謎の会社「Mellanox」が好調の理由:頭脳放談

HPC向けスイッチなどを扱う「Mellanox」を取り上げる。この会社、対前年比で3割近い売り上げの伸びを記録し、絶好調だと聞く。なぜ、今、絶好調なのかその秘密を調べてみた。

筆者は、世間と半導体業界の常識のギャップに戸惑うことがよくある。最近では、ソフトバンクによるARMの買収や、AIの文脈でNVIDIAが出てきたときなどだ。業界的にはARMもNVIDIAも「大手」といって差し支えない会社だと思っていたのだが、世間の反応は「謎の会社」というものだった。

ARMやNVIDIAをして「謎」であれば、多分、テレビコマーシャルで知名度のあるはずのIntelとSamsung以外は、みんな「謎」に違いない。その理由は簡単だ。一般消費者向けに商売をしている会社ではない、ということに尽きる。

謎の会社「Mellanox」って?

今回は、そんな謎の会社群の中でも「渋すぎる」会社を取り上げたいと思う。なぜなら、そんな「渋い」会社が対前年比で3割近い売り上げの伸びを記録し、絶好調だという話を聞いたからだ。プロ中のプロだけを相手にしてきた、言ったら悪いが、ニッチなところをガッチリ固めた会社なのに、なぜこんなに成長しているのか。何か秘密があるのではないかと感じたからだ。

取り上げさせていただくのは、「Mellanox Technologies(メラノックステクノロジーズ)」という、イスラエル+アメリカのファブレス半導体メーカーである。2018年前半の売上高が570億円くらい、多分通年で「1ビリオンUSダラー」を超えるほどの規模である。

結構な売上高を持つが、この会社を知っている人は業界内でもかなり限定されるかもしれない。主戦場はHPC(High-Performance Computing)、日本式にいうと「スパコン」分野だったからだ。

しかし、スパコンメーカーとしてMellanox Technologiesなんて名前は聞いたことがない、というのも当然である。スパコンの内部で使われるスイッチやネットワークアダプター(NIC)のメーカーだからだ。スイッチは、家庭やオフィスでもし有線のイーサネットハブなどというものを使っていたら、あれの高級機種という想像をしてもらっても間違ってはいない。NICは、CPUボードに差さるネットワークインタフェースカードだ。ただ、スパコンの場合その規模感と速度が半端ない。

スパコンとなると1枚の基板上に複数個のCPUチップを搭載し、それぞれのチップ上には数個から数百といったCPUコアが搭載される。そのような基板はより大きなメイン基板に取り付けられた後、今度は基板間のネットワークを使って全体として数十万個といった規模のCPUが連動するシステムに組み上げられる。このようなシステム内部のネットワークを構成するためにNICやスイッチを使って接続するのだ。

たかがスイッチというなかれ。ポピュラーなネットワーク構造にファットツリー(Fat Tree)構造などと呼ばれるものがある。これは、末端のCPU基板とスイッチ間を接続するだけでなく、下位階層のスイッチはより上位階層のスイッチともツリー状に接続していく。そのとき、末端のCPU側に接続する本数と同じ本数を上位側にも接続するような形になる。例えば、48ポートある場合、末端側に24ポート割り当てたら、上位方向にも24ポート使う。

また、末端側との接続も1本ということはない。例えば1枚の基板と4ポート使って接続するのであれば、24ポートあっても実際に接続できる枚数は6枚にしかならない。そしてシステム全体が接続できるだけのツリー階層の深さをもってスイッチがスイッチに接続されていく。必要とされるスイッチやNICの数たるや膨大な数になることが分かるだろう。また、それぞれのポートの伝送速度といえば、今日の最速製品では200Gb/secに達するのだ。

そんなスパコン用スイッチの分野、その中でも「InfiniBand(インフィニバンド)」と呼ばれる高速インタフェース規格の市場の最大手としてMellanox Technologiesは牙城を築いてきた。InfiniBandはスパコンでも「高級機」での採用が多いインタフェース規格である。

しかし、スパコン市場は急に伸びるような市場のはずがない。買い手の多くは研究機関、政府機関、大学などのはずだからだ。こうした組織は予算に縛られている。毎年少しずつ規模は拡大してはいると想像するが、年率30%で伸びる要素はまずない。

ニッチな市場で急成長の秘密

見ればMellanox Technologiesの業績で急拡大していたのはイーサネットであった。実はスパコンといっても、イーサネットは外部のネットワークや種々の装置と接続するために必須だ。前述のInfiniBandは、MPI(Message Passing Interface: HPCクラスタにおける並列プログラミングで一般的に利用される通信ライブラリ)などのソフトウェアライブラリを使って並列処理プログラムを走らせるためのCPU間のネットワークとして使用される。そちら側は計算のためであって、入出力はイーサネットを併用することが多い。

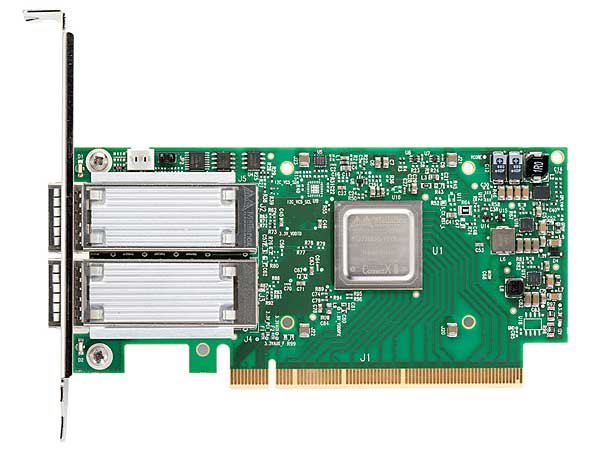

Mellanox TechnologiesのNIC「ConnectX-6 EN」

Mellanox TechnologiesのNIC「ConnectX-6 EN」デュアルポートをサポートする200Gbイーサネットカード。(Mellanox Technologiesの製品ページより)

また、スパコンといっても下位機種では、CPU間の計算のためにInfiniBandのような専用ネットワークを設けるとコストが上がるという問題があるため、より安価なイーサネットだけで済ませてしまうものもあるようだ。そのためか、大分前からMellanox Technologiesもイーサネット製品も扱ってきた。

大ざっぱに言うと、規格は違うが工学的なバックグラウンドは、イーサネットもInfiniBandも似ているから無理のない多角化である。ただ、イーサネットといっても、もともとスパコンを主戦場に戦ってきた会社である。その辺にありそうな10ギガビットイーサネット(GbE)品では済まない。過去にMellanox Technologiesは40G品(10GbE×4本相当)を中心にラインアップしていたようだが、最近では、25/50/100G品のラインアップにシフトしているようだ。

これがどうも「うけた」ようなのだ、スパコン以外の市場に。データセンターなどと書くとあまりにも漠然としているが、端的に言えば動画像、4K、8Kといった「太い」コンテンツ向けにだ。スパコンで高速であることに集中してきたMellanox Technologiesには高速規格の対応に一日の長があるように見える。

Mellanox Technologiesがうけていると思われる理由の1つが、何となれば、ボード側に差すNIC、接続のためのスイッチだけでなく、接続ケーブルから管理ツールに至るまで自社で完結して供給できることだろう。言ったら悪いが、スパコンというベンダーも市場も限られている「離れ小島」で使われているInfiniBandでは、ワンストップショップでなければ商売がうまくいかなかったに違いない。

しかし、イーサネットのようなベンダーの多い規格でも、まだこなれていない高速規格では、あれもこれも1社で供給できるというのがアドバンテージになる。実際、イーサネットの接続ケーブルなどは、その辺で買ってくればいい、と思うかもしれない。低速(といっても10G以下)かつ伝送距離が数メートルというくらいなら、電気的な接続も可能だが、今問題にしているような高速の信号を広い床面積のセンターの中、数十、数百メートルといった距離を伝送するとなると「光」になる。

その場合、光ファイバーの両端に電気と光を相互変換するトランシーバーが組み込まれたケーブルを利用する。一度値段表を見てみると良いが、その辺に転がっている一般オフィス向けのイーサネットケーブルに比べたら一桁も二桁も高価なものだ。そしてそれらを接続していかなければならない。スパコンのネットワーク階層構造とは異なるが、やはり階層を持った多数のスイッチとケーブルの束が必要になる。

意図的にMellanox Technologiesが仕掛けたのか、ニッチなところにいたMellanoxにたまたま世間が追い付いてきただけなのかは知らない。しかし、今のところ、風はMellanox Technologiesに吹いているように見える。年率3割近い高度成長を何年間か続けられるようなら、ニッチトップから、業界大手になる可能性も大いにある。ただ、ここにおいしいビジネスがあることは、皆にも明らかになってしまった。InfiniBandと違って高速イーサネット分野では競合になりそうな会社はあまたある。競争激しくなる中で勝ち抜けるのかどうか。まぁ、勝ち抜けたとしても、世間一般には「謎の会社」のままだろうが……。

筆者紹介

Massa POP Izumida

日本では数少ないx86プロセッサのアーキテクト。某米国半導体メーカーで8bitと16bitの、日本のベンチャー企業でx86互換プロセッサの設計に従事する。その後、出版社の半導体事業部などを経て、現在は某半導体メーカーでヘテロジニアス マルチコアプロセッサを中心とした開発を行っている。

「頭脳放談」

Copyright© Digital Advantage Corp. All Rights Reserved.